Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

O GPT-5 alcança 94,6% de precisão no AIME 2025, sugerindo um raciocínio matemático quase humano.

No entanto, ao pedir que ele consulte seu banco de dados, as taxas de sucesso despencam para os adolescentes.

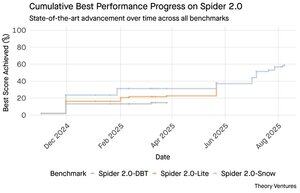

Os benchmarks Spider 2.0 revelam uma lacuna enorme nas capacidades da IA. O Spider 2.0 é um benchmark abrangente de texto para SQL que testa a capacidade dos modelos de IA de gerar consultas SQL precisas a partir de perguntas em linguagem natural em bancos de dados do mundo real.

Enquanto os grandes modelos de linguagem conquistaram o trabalho de conhecimento em matemática, programação e raciocínio, o texto para SQL continua teimosamente difícil.

Os três benchmarks Spider 2.0 testam consultas de banco de dados do mundo real em diferentes ambientes. O Spider 2.0-Snow utiliza bancos de dados Snowflake com 547 exemplos de teste, atingindo um pico de 59,05% de precisão.

O Spider 2.0-Lite abrange BigQuery, Snowflake e SQLite com mais 547 exemplos, alcançando apenas 37,84%. O Spider 2.0-DBT testa a geração de código contra DuckDB com 68 exemplos, atingindo um máximo de 39,71%.

Essa lacuna de desempenho não é por falta de tentativas. Desde novembro de 2024, 56 submissões de 12 famílias de modelos competiram nesses benchmarks.

Claude, OpenAI, DeepSeek e outros todos empurraram seus modelos contra esses testes. O progresso tem sido constante, de aproximadamente 2% para cerca de 60%, nos últimos nove meses.

O enigma se aprofunda quando você considera as limitações do SQL. O SQL tem um vocabulário limitado em comparação com o inglês, que tem 600.000 palavras, ou linguagens de programação que têm sintaxes e bibliotecas muito mais amplas para conhecer. Além disso, há muito SQL disponível para treinar.

Seja como for, isso deveria ser mais fácil do que as tarefas de raciocínio abertas onde os modelos agora se destacam.

No entanto, mesmo a geração perfeita de SQL não resolveria o verdadeiro desafio empresarial. Cada empresa define "receita" de maneira diferente.

O marketing mede o custo de aquisição de clientes pelo gasto em campanhas, as vendas calculam usando os custos dos executivos de contas, e as finanças incluem despesas totalmente carregadas dos funcionários. Essas diferenças semânticas criam confusão que a precisão técnica não pode resolver.

Os resultados do Spider 2.0 apontam para uma verdade fundamental sobre o trabalho com dados. A proficiência técnica na sintaxe SQL é apenas o ponto de entrada.

O verdadeiro desafio reside no contexto empresarial. Compreender o que os dados significam, como diferentes equipes definem métricas e quando os casos extremos importam. Como escrevi em Cultivadores Semânticos, a ponte entre dados brutos e significado empresarial requer julgamento humano que a IA atual não pode replicar.

8,8K

O GPT-5 alcança 94,6% de precisão no AIME 2025, sugerindo um raciocínio matemático quase humano.

No entanto, peça-lhe para consultar o seu banco de dados, e as taxas de sucesso despencam para os adolescentes.

Os benchmarks Spider 2.0 revelam um abismo nas capacidades da IA. O Spider 2.0 é um benchmark abrangente de texto para SQL que testa a capacidade dos modelos de IA de gerar consultas SQL precisas a partir de perguntas em linguagem natural em bancos de dados do mundo real.

Enquanto os grandes modelos de linguagem conquistaram o trabalho de conhecimento em matemática, programação e raciocínio, o texto para SQL continua teimosamente difícil.

Os três benchmarks Spider 2.0 testam consultas de banco de dados do mundo real em diferentes ambientes. O Spider 2.0-Snow utiliza bancos de dados Snowflake com 547 exemplos de teste, atingindo um pico de 59,05% de precisão.

O Spider 2.0-Lite abrange BigQuery, Snowflake e SQLite com mais 547 exemplos, alcançando apenas 37,84%. O Spider 2.0-DBT testa a geração de código contra DuckDB com 68 exemplos, atingindo um máximo de 39,71%.

Essa lacuna de desempenho não é por falta de tentativas. Desde novembro de 2024, 56 submissões de 12 famílias de modelos competiram nesses benchmarks.

Claude, OpenAI, DeepSeek e outros todos pressionaram seus modelos contra esses testes. O progresso tem sido constante, de aproximadamente 2% para cerca de 60%, nos últimos nove meses.

O enigma se aprofunda quando você considera as limitações do SQL. O SQL tem um vocabulário limitado em comparação com o inglês, que tem 600.000 palavras, ou linguagens de programação que têm sintaxes e bibliotecas muito mais amplas para conhecer. Além disso, há muito SQL disponível para treinar.

Seja como for, isso deveria ser mais fácil do que as tarefas de raciocínio abertas onde os modelos agora se destacam.

No entanto, mesmo a geração perfeita de SQL não resolveria o verdadeiro desafio empresarial. Cada empresa define "receita" de maneira diferente.

O marketing mede o custo de aquisição de clientes pelo gasto em campanhas, as vendas calculam usando os custos dos executivos de contas, e as finanças incluem despesas totalmente carregadas dos funcionários. Essas diferenças semânticas criam confusão que a precisão técnica não pode resolver.

Os resultados do Spider 2.0 apontam para uma verdade fundamental sobre o trabalho com dados. A proficiência técnica na sintaxe SQL é apenas o ponto de entrada.

O verdadeiro desafio reside no contexto empresarial. Compreender o que os dados significam, como diferentes equipes definem métricas e quando os casos extremos importam. Como escrevi em Cultivadores Semânticos, a ponte entre dados brutos e significado empresarial requer julgamento humano que a IA atual não consegue replicar.

3,94K

A Perplexity AI acaba de fazer uma oferta não solicitada de $34,5 bilhões pelo navegador Chrome do Google, tentando capitalizar sobre a iminente decisão antitruste que pode forçar o Google a desinvestir seu negócio de navegadores.

Comparar a economia do Chrome com o acordo existente do Google com a Apple revela por que $34,5 bilhões subestima o navegador.

O Google paga à Apple entre $18 e $20 bilhões anualmente para permanecer como o mecanismo de busca padrão do Safari¹, atendendo aproximadamente 850 milhões de usuários². Isso se traduz em $21 por usuário por ano.

A oferta da Perplexity valoriza o Chrome em $32 bilhões, o que equivale a $9 por usuário por ano para seus 3,5 bilhões de usuários³.

Se os usuários do Chrome tivessem os mesmos termos que o acordo Google/Apple do Safari, o potencial de receita anual do navegador superaria $73 bilhões.

Esses dados são baseados em estimativas públicas, mas são uma aproximação.

Isso assume que o Google pagaria a um novo proprietário do Chrome uma taxa escalonada semelhante pela colocação de busca padrão. Dado um múltiplo de capitalização de mercado para receita de 5x a 6x, o Chrome vale entre $172 bilhões e $630 bilhões, muito longe da oferta de $34,5 bilhões.

O Chrome domina o mercado com 65% de participação⁴, em comparação com os 18% do Safari. Um desinvestimento lançaria o mercado de anúncios de busca em um tumulto. O valor de manter os orçamentos dos anunciantes é difícil de exagerar para a capitalização de mercado e a posição do Google no ecossistema de anúncios.

Se for forçado a vender o Chrome, o Google enfrentaria uma escolha existencial. Pagar o que for necessário para permanecer como o mecanismo de busca padrão ou assistir os concorrentes transformarem seu canal de distribuição mais valioso em um bastão contra ele.

Quanto isso vale? Um prêmio significativo em relação a um simples múltiplo de receita.

¹ Bloomberg: Os pagamentos do Google à Apple atingiram $20 bilhões em 2022 (

² ZipDo: Estatísticas essenciais do Apple Safari em 2024 (

³ Backlinko: Participação de mercado de navegadores da web em 2025 (

⁴ Statcounter: Participação de mercado de navegadores em todo o mundo (

7,97K

Em 1999, as empresas de tecnologia eram avaliadas com base no tráfego. As métricas de IPO giravam em torno de visualizações.

Então, o Google lançou o AdWords, um modelo de anúncios baseado em cliques, e construiu um negócio de $273 bilhões em 2024.

Mas isso pode estar prestes a mudar: o estudo de julho de 2025 do Pew Research revela que os usuários clicam apenas em 8% dos resultados de busca com resumos de IA, contra 15% sem - uma redução de 47%. Apenas 1% clica a partir de resumos de IA.

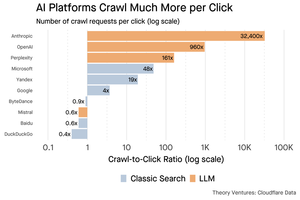

Dados da Cloudflare mostram que as plataformas de IA rastreiam conteúdo muito mais do que referem tráfego de volta: a Anthropic rastreia 32.400 páginas para cada 1 referência, enquanto os motores de busca tradicionais escaneiam o conteúdo apenas algumas vezes por visitante enviado.

O custo de servir conteúdo para os rastreadores de IA pode não ser enorme se for principalmente texto.

O ponto mais importante é que os sistemas de IA desintermediam a relação entre o usuário e o editor. Os usuários preferem respostas agregadas de IA a clicar em sites para encontrar suas respostas.

É lógico que a maioria dos sites deve esperar menos tráfego. Como o seu site e o seu negócio lidarão com isso?

Fontes:

- Pew Research Center - Athena Chapekis, 22 de julho de 2025 (

- Cloudflare: O rastreamento antes da queda das referências (

- Cloudflare Radar: Insights de IA - Relação de Rastrear para Referir (

- Podcast: O Valor em Mudança do Conteúdo na Era da IA (

9,68K

O GPT-5 foi lançado ontem. 94,6% no AIME 2025. 74,9% no SWE-bench.

À medida que nos aproximamos dos limites superiores desses benchmarks, eles desaparecem.

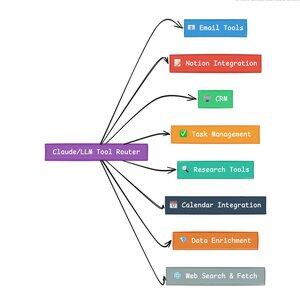

O que torna o GPT-5 e a próxima geração de modelos revolucionários não é o seu conhecimento. É saber como agir. Para o GPT-5, isso acontece em dois níveis. Primeiro, decidir qual modelo usar. Mas segundo, e mais importante, através da chamada de ferramentas.

Temos vivido numa era em que os LLMs dominaram a recuperação e reassemblagem de conhecimento. A pesquisa de consumidores e a codificação, as aplicações iniciais matadoras, são fundamentalmente desafios de recuperação de conhecimento. Ambos organizam informações existentes de novas maneiras.

Subimos essas colinas e, como resultado, a concorrência é mais intensa do que nunca. Os modelos da Anthropic, OpenAI e Google estão convergindo para capacidades semelhantes. Modelos chineses e alternativas de código aberto continuam a se aproximar cada vez mais do estado da arte. Todos podem recuperar informações. Todos podem gerar texto.

O novo eixo de competição? Chamada de ferramentas.

A chamada de ferramentas transforma os LLMs de conselheiros em atores. Compensa duas fraquezas críticas dos modelos que modelos de linguagem puros não conseguem superar.

Primeiro, orquestração de fluxo de trabalho. Os modelos se destacam em respostas de uma única vez, mas lutam com processos multi-etapas e com estado. As ferramentas permitem que eles gerenciem longos fluxos de trabalho, rastreando o progresso, lidando com erros, mantendo o contexto em dezenas de operações.

Segundo, integração de sistemas. Os LLMs vivem em um mundo apenas de texto. As ferramentas permitem que eles interajam de forma previsível com sistemas externos, como bancos de dados, APIs e software empresarial, transformando linguagem natural em ações executáveis.

No último mês, construí 58 ferramentas de IA diferentes.

Processadores de e-mail. Integradores de CRM. Atualizadores do Notion. Assistentes de pesquisa. Cada ferramenta estende as capacidades do modelo para um novo domínio.

A capacidade mais importante para a IA é selecionar a ferramenta certa de forma rápida e correta. Cada passo mal direcionado mata todo o fluxo de trabalho.

Quando digo “leia este e-mail da Y Combinator e encontre todas as startups que não estão no CRM”, os LLMs modernos executam uma sequência complexa.

Um comando em inglês substitui um fluxo de trabalho inteiro. E isso é apenas um simples.

Ainda melhor, o modelo, devidamente configurado com as ferramentas certas, pode verificar seu próprio trabalho, garantindo que as tarefas foram concluídas a tempo. Este ciclo de auto-verificação cria confiabilidade em fluxos de trabalho que é difícil de alcançar de outra forma.

Multiplique isso por centenas de funcionários. Milhares de fluxos de trabalho. Os ganhos de produtividade se acumulam exponencialmente.

Os vencedores no futuro mundo da IA serão aqueles que forem mais sofisticados na orquestração de ferramentas e no roteamento das consultas certas. Todas as vezes. Uma vez que esses fluxos de trabalho se tornem previsíveis, é quando todos nós nos tornaremos gerentes de agentes.

3,16K

2025 é o ano dos agentes, e a principal capacidade dos agentes é chamar ferramentas.

Ao usar o Claude Code, posso dizer à IA para vasculhar um boletim informativo, encontrar todos os links para startups, verificar se existem no nosso CRM, com um único comando. Isso pode envolver duas ou três ferramentas diferentes sendo chamadas.

Mas aqui está o problema: usar um grande modelo de fundação para isso é caro, muitas vezes limitado por taxa, e excessivo para uma tarefa de seleção.

Qual é a melhor maneira de construir um sistema agente com chamada de ferramentas?

A resposta está em pequenos modelos de ação. A NVIDIA lançou um artigo convincente argumentando que “Modelos de linguagem pequenos (SLMs) são suficientemente poderosos, inerentemente mais adequados e necessariamente mais econômicos para muitas invocações em sistemas agentes.”

Estive testando diferentes modelos locais para validar um exercício de redução de custos. Comecei com um modelo de 30 bilhões de parâmetros Qwen3:30b, que funciona, mas pode ser bastante lento porque é um modelo tão grande, mesmo que apenas 3 bilhões desses 30 bilhões de parâmetros estejam ativos a qualquer momento.

O artigo da NVIDIA recomenda o modelo Salesforce xLAM – uma arquitetura diferente chamada modelo de ação grande especificamente projetada para seleção de ferramentas.

Então, fiz um teste por conta própria, cada modelo chamando uma ferramenta para listar minhas tarefas do Asana.

Os resultados foram impressionantes: xLAM completou as tarefas em 2,61 segundos com 100% de sucesso, enquanto Qwen levou 9,82 segundos com 92% de sucesso – quase quatro vezes mais.

Este experimento mostra o ganho de velocidade, mas há um trade-off: quanta inteligência deve residir no modelo versus nas próprias ferramentas. Isso é limitado.

Com modelos maiores como o Qwen, as ferramentas podem ser mais simples porque o modelo tem melhor tolerância a erros e pode contornar interfaces mal projetadas. O modelo compensará as limitações da ferramenta através de raciocínio de força bruta.

Com modelos menores, o modelo tem menos capacidade de se recuperar de erros, então as ferramentas devem ser mais robustas e a lógica de seleção mais precisa. Isso pode parecer uma limitação, mas na verdade é uma característica.

Essa restrição elimina a taxa de erro acumulada de ferramentas encadeadas de LLM. Quando grandes modelos fazem chamadas sequenciais de ferramentas, os erros se acumulam exponencialmente.

Modelos de ação pequenos forçam um melhor design de sistema, mantendo o melhor dos LLMs e combinando-o com modelos especializados.

Essa arquitetura é mais eficiente, mais rápida e mais previsível.

5,3K

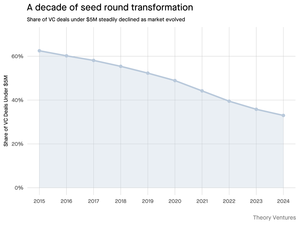

Por que é que a ronda de seed abaixo de 5 milhões de dólares está a encolher?

Há uma década, estas rondas menores formavam a espinha dorsal do financiamento de startups, representando mais de 70% de todos os negócios de seed. Hoje, os dados da PitchBook revelam que essa cifra caiu para menos de metade.

Os números contam uma história clara. Os negócios abaixo de 5 milhões de dólares diminuíram de 62,5% em 2015 para 37,5% em 2024. Esta queda de 29,5 pontos percentuais remodelou fundamentalmente a forma como as startups angariam o seu primeiro capital institucional.

Três forças impulsionaram esta transformação. Podemos decompor a queda para entender o que reduziu a pequena ronda de seed e por que isso é importante para os fundadores hoje.

4,7K

Isto foi tão divertido, Mario. Obrigado por me receber no programa para falar sobre tudo o que está a acontecer no mercado!

Mario Gabriele 🦊22/07/2025

O nosso último episódio com Tomasz Tunguz está no ar!

A Década dos Dados

@ttunguz passou quase duas décadas a transformar dados em insights de investimento. Depois de apoiar Looker, Expensify e Monte Carlo na Redpoint Ventures, lançou a @Theoryvc em 2022 com uma visão ousada: construir uma "corporação de investimento" onde investigadores, engenheiros e operadores trabalham lado a lado com investidores, criando mapas de mercado em tempo real e ferramentas de IA internas. O seu fundo de estreia fechou em 238 milhões de dólares, seguido apenas 19 meses depois por um segundo fundo de 450 milhões de dólares. Centrada em dados, IA e infraestrutura cripto, a Theory opera no coração das mudanças tecnológicas mais consequentes de hoje. Exploramos como os dados estão a remodelar o capital de risco, por que os modelos de investimento tradicionais estão a ser perturbados e o que é necessário para construir uma empresa que não apenas prevê o futuro, mas que ajuda ativamente a criá-lo.

Ouça agora:

• YouTube:

• Spotify:

• Apple:

Um grande agradecimento aos incríveis patrocinadores que tornam o podcast possível:

✨ Brex — A solução bancária para startups:

✨ Generalist+ — Inteligência essencial para investidores e tecnólogos modernos:

Exploramos:

→ Como funciona o modelo de "corporação de investimento" da Theory

→ Por que as exchanges de cripto podem criar um caminho viável para os mercados públicos para empresas de software de pequena capitalização

→ A iminente crise de energia — por que os centros de dados podem consumir 15% da eletricidade dos EUA dentro de cinco anos

→ A rápida ascensão das stablecoins à medida que grandes bancos canalizam 5‑10% dos dólares dos EUA através delas

→ Por que o Ethereum enfrenta um desafio existencial semelhante ao da AWS perdendo terreno para a Azure na era da IA

→ Por que Tomasz acredita que o punhado de agentes de hoje se tornará 100+ co-trabalhadores digitais até o final do ano

→ Por que a Meta está a apostar bilhões em óculos de AR para mudar a forma como interagimos com as máquinas

→ Como a Theory Ventures usa IA para acelerar a pesquisa de mercado, análise de negócios e decisões de investimento

…E muito mais!

8K

A OpenAI recebe em média 1 consulta por americano por dia.

O Google recebe cerca de 4 consultas por americano por dia.

Desde então, 50% das consultas de pesquisa do Google têm Visões Gerais de IA, o que significa que pelo menos 60% das pesquisas nos EUA agora são de IA.

Demorou um pouco mais do que eu esperava para que isso acontecesse. Em 2024, eu previ que 50% das pesquisas de consumidores seriam habilitadas por IA. (

Mas a IA chegou à pesquisa.

Se os padrões de pesquisa do Google são um indicativo, há uma lei de potência no comportamento de pesquisa. A análise da SparkToro sobre o comportamento de pesquisa do Google mostra que o terço superior dos americanos que pesquisam executa mais de 80% de todas as pesquisas - o que significa que o uso de IA provavelmente não está distribuído de forma uniforme - como o futuro.

Os sites e negócios estão começando a sentir os impactos disso. O artigo da Economist "A IA está matando a web. Pode algo salvá-la?" captura o zeitgeist em um título. (

Uma supermaioria dos americanos agora pesquisa com IA. Os efeitos de segunda ordem das mudanças nos padrões de pesquisa estão chegando na segunda metade deste ano e mais pessoas estarão perguntando: "O que aconteceu com meu tráfego?" (

A IA é um novo canal de distribuição e aqueles que a aproveitarem ganharão participação de mercado.

- William Gibson viu muito mais longe no futuro!

- Isso é baseado em uma análise de ponto médio do gráfico da SparkToro, é uma análise muito simples e tem algum erro como resultado.

8,87K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável