Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 atteint 94,6 % de précision sur l'AIME 2025, suggérant un raisonnement mathématique proche de celui des humains.

Pourtant, demandez-lui d'interroger votre base de données, et les taux de réussite chutent dans les teens.

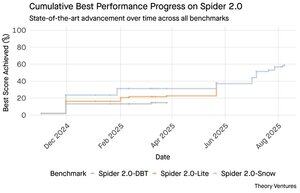

Les benchmarks Spider 2.0 révèlent un écart béant dans les capacités de l'IA. Spider 2.0 est un benchmark complet de texte à SQL qui teste la capacité des modèles d'IA à générer des requêtes SQL précises à partir de questions en langage naturel à travers des bases de données du monde réel.

Alors que les grands modèles de langage ont conquis le travail de connaissance en mathématiques, en codage et en raisonnement, le texte à SQL reste obstinément difficile.

Les trois benchmarks Spider 2.0 testent l'interrogation de bases de données du monde réel dans différents environnements. Spider 2.0-Snow utilise des bases de données Snowflake avec 547 exemples de test, atteignant un pic de 59,05 % de précision.

Spider 2.0-Lite couvre BigQuery, Snowflake et SQLite avec 547 autres exemples, n'atteignant que 37,84 %. Spider 2.0-DBT teste la génération de code contre DuckDB avec 68 exemples, culminant à 39,71 %.

Cet écart de performance n'est pas dû à un manque d'efforts. Depuis novembre 2024, 56 soumissions de 12 familles de modèles ont concouru sur ces benchmarks.

Claude, OpenAI, DeepSeek et d'autres ont tous poussé leurs modèles contre ces tests. Les progrès ont été constants, passant d'environ 2 % à environ 60 % au cours des neuf derniers mois.

L'énigme se complique lorsque l'on considère les contraintes de SQL. SQL a un vocabulaire limité par rapport à l'anglais, qui compte 600 000 mots, ou aux langages de programmation qui ont des syntaxes et des bibliothèques beaucoup plus larges à connaître. De plus, il y a beaucoup de SQL à disposition pour s'entraîner.

Si quelque chose, cela devrait être plus facile que les tâches de raisonnement ouvertes où les modèles excellent désormais.

Pourtant, même une génération SQL parfaite ne résoudrait pas le véritable défi commercial. Chaque entreprise définit "revenu" différemment.

Le marketing mesure le coût d'acquisition client par les dépenses de campagne, les ventes le calculent en utilisant les coûts des responsables de comptes, et la finance inclut les dépenses des employés entièrement chargées. Ces différences sémantiques créent une confusion que l'exactitude technique ne peut résoudre.

Les résultats de Spider 2.0 pointent vers une vérité fondamentale sur le travail des données. La compétence technique en syntaxe SQL n'est que le point d'entrée.

Le véritable défi réside dans le contexte commercial. Comprendre ce que signifie les données, comment différentes équipes définissent les métriques, et quand les cas particuliers sont importants. Comme je l'ai écrit dans Semantic Cultivators, le pont entre les données brutes et la signification commerciale nécessite un jugement humain que l'IA actuelle ne peut pas reproduire.

8,79K

GPT-5 atteint une précision de 94,6 % sur l'AIME 2025, suggérant un raisonnement mathématique proche de celui des humains.

Pourtant, demandez-lui d'interroger votre base de données, et les taux de réussite chutent dans les teens.

Les benchmarks Spider 2.0 révèlent un écart béant dans les capacités de l'IA. Spider 2.0 est un benchmark complet de texte à SQL qui teste la capacité des modèles d'IA à générer des requêtes SQL précises à partir de questions en langage naturel à travers des bases de données du monde réel.

Alors que les grands modèles de langage ont conquis le travail de connaissance en mathématiques, en codage et en raisonnement, le texte à SQL reste obstinément difficile.

Les trois benchmarks Spider 2.0 testent l'interrogation de bases de données du monde réel dans différents environnements. Spider 2.0-Snow utilise des bases de données Snowflake avec 547 exemples de test, atteignant un pic de 59,05 % de précision.

Spider 2.0-Lite couvre BigQuery, Snowflake et SQLite avec 547 autres exemples, n'atteignant que 37,84 %. Spider 2.0-DBT teste la génération de code contre DuckDB avec 68 exemples, culminant à 39,71 %.

Cet écart de performance n'est pas dû à un manque d'efforts. Depuis novembre 2024, 56 soumissions de 12 familles de modèles ont concouru sur ces benchmarks.

Claude, OpenAI, DeepSeek et d'autres ont tous poussé leurs modèles contre ces tests. Les progrès ont été constants, passant d'environ 2 % à environ 60 % au cours des neuf derniers mois.

L'énigme se complique lorsque l'on considère les contraintes de SQL. SQL a un vocabulaire limité par rapport à l'anglais, qui compte 600 000 mots, ou aux langages de programmation qui ont des syntaxes et des bibliothèques beaucoup plus larges à connaître. De plus, il y a beaucoup de SQL disponible pour s'entraîner.

Si quelque chose, cela devrait être plus facile que les tâches de raisonnement ouvertes où les modèles excellent maintenant.

Pourtant, même une génération SQL parfaite ne résoudrait pas le véritable défi commercial. Chaque entreprise définit "revenu" différemment.

Le marketing mesure le coût d'acquisition client par les dépenses de campagne, les ventes le calculent en utilisant les coûts des responsables de comptes, et la finance inclut les dépenses des employés entièrement chargées. Ces différences sémantiques créent une confusion que l'exactitude technique ne peut résoudre.

Les résultats de Spider 2.0 pointent vers une vérité fondamentale sur le travail des données. La compétence technique en syntaxe SQL n'est que le point d'entrée.

Le véritable défi réside dans le contexte commercial. Comprendre ce que signifie les données, comment différentes équipes définissent les métriques, et quand les cas limites sont importants. Comme je l'ai écrit dans Semantic Cultivators, le pont entre les données brutes et la signification commerciale nécessite un jugement humain que l'IA actuelle ne peut pas reproduire.

3,93K

Perplexity AI vient de faire une offre non sollicitée de 34,5 milliards de dollars pour le navigateur Chrome de Google, tentant de tirer parti de la décision antitrust imminente qui pourrait contraindre Google à céder son activité de navigateur.

Comparer l'économie de Chrome à l'accord existant de Google avec Safari révèle pourquoi 34,5 milliards de dollars sous-estiment le navigateur.

Google paie à Apple entre 18 et 20 milliards de dollars par an pour rester le moteur de recherche par défaut de Safari¹, servant environ 850 millions d'utilisateurs². Cela se traduit par 21 dollars par utilisateur et par an.

L'offre de Perplexity valorise Chrome à 32 milliards de dollars, soit 9 dollars par utilisateur et par an pour ses 3,5 milliards d'utilisateurs³.

Si les utilisateurs de Chrome bénéficiaient des mêmes conditions que l'accord Google/Apple pour Safari, le potentiel de revenus annuel du navigateur dépasserait 73 milliards de dollars.

Ces données sont basées sur des estimations publiques mais sont une approximation.

Cela suppose que Google paierait à un nouveau propriétaire de Chrome des frais similaires pour le placement de recherche par défaut. Étant donné un multiple de capitalisation boursière à revenus de 5x à 6x, Chrome vaut entre 172 milliards et 630 milliards de dollars, un écart considérable par rapport à l'offre de 34,5 milliards de dollars.

Chrome domine le marché avec une part de 65%⁴, contre 18% pour Safari. Une cession bouleverserait le marché des annonces de recherche. La valeur de la conservation des budgets publicitaires est difficile à surestimer pour la capitalisation boursière de Google et sa position dans l'écosystème publicitaire.

Si Google était contraint de vendre Chrome, il ferait face à un choix existentiel. Payer ce qu'il faut pour rester le moteur de recherche par défaut, ou regarder les concurrents transformer son canal de distribution le plus précieux en un outil contre lui.

Combien cela vaut-il ? Une prime significative par rapport à un simple multiple de revenus.

¹ Bloomberg : Les paiements de Google à Apple ont atteint 20 milliards de dollars en 2022 (

² ZipDo : Statistiques essentielles sur Apple Safari en 2024 (

³ Backlinko : Part de marché des navigateurs Web en 2025 (

⁴ Statcounter : Part de marché des navigateurs dans le monde (.

7,96K

En 1999, les dotcoms étaient valorisées en fonction du trafic. Les métriques des IPO tournaient autour des yeux des utilisateurs.

Puis Google a lancé AdWords, un modèle publicitaire basé sur les clics, et a construit une entreprise de 273 milliards de dollars en 2024.

Mais tout cela pourrait être sur le point de changer : l'étude de Pew Research de juillet 2025 révèle que les utilisateurs cliquent sur seulement 8 % des résultats de recherche avec des résumés AI, contre 15 % sans - une réduction de 47 %. Seulement 1 % cliquent à partir des résumés AI.

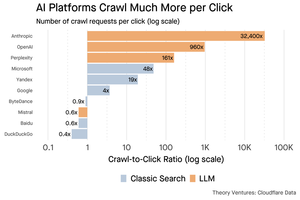

Les données de Cloudflare montrent que les plateformes AI explorent le contenu beaucoup plus qu'elles ne renvoient de trafic : Anthropic explore 32 400 pages pour chaque 1 référence, tandis que les moteurs de recherche traditionnels analysent le contenu seulement quelques fois par visiteur envoyé.

Le coût de la fourniture de contenu aux crawlers AI peut ne pas être énorme s'il s'agit principalement de texte.

Le point plus important est que les systèmes AI désintermédient la relation entre l'utilisateur et l'éditeur. Les utilisateurs préfèrent des réponses agrégées par AI plutôt que de cliquer sur des sites web pour trouver leurs réponses.

Il est logique que la plupart des sites web s'attendent à moins de trafic. Comment votre site web et votre entreprise vont-ils gérer cela ?

Sources :

- Pew Research Center - Athena Chapekis, 22 juillet 2025 (

- Cloudflare : Le crawl avant la chute des références (

- Cloudflare Radar : Insights AI - Ratio Crawl à Référence (

- Podcast : La valeur changeante du contenu à l'ère de l'AI (

9,67K

GPT-5 a été lancé hier. 94,6 % sur AIME 2025. 74,9 % sur SWE-bench.

À mesure que nous approchons des limites supérieures de ces benchmarks, ils s'éteignent.

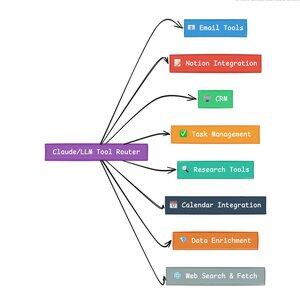

Ce qui rend GPT-5 et la prochaine génération de modèles révolutionnaires, ce n'est pas leur connaissance. C'est savoir comment agir. Pour GPT-5, cela se produit à deux niveaux. D'abord, décider quel modèle utiliser. Mais ensuite, et plus important encore, à travers l'appel d'outils.

Nous avons vécu dans une ère où les LLM ont maîtrisé la récupération et le réassemblage des connaissances. La recherche pour les consommateurs et le codage, les premières applications phares, sont fondamentalement des défis de récupération de connaissances. Les deux organisent les informations existantes de nouvelles manières.

Nous avons gravi ces collines et, en conséquence, la concurrence est plus intense que jamais. Les modèles d'Anthropic, OpenAI et Google convergent vers des capacités similaires. Les modèles chinois et les alternatives open source continuent de se rapprocher de l'état de l'art. Tout le monde peut récupérer des informations. Tout le monde peut générer du texte.

Le nouvel axe de la concurrence ? L'appel d'outils.

L'appel d'outils transforme les LLM d'advisors en acteurs. Il compense deux faiblesses critiques des modèles purs de langage que les modèles de langage ne peuvent pas surmonter.

D'abord, l'orchestration des flux de travail. Les modèles excellent dans les réponses uniques mais ont du mal avec les processus multi-étapes et à état. Les outils leur permettent de gérer de longs flux de travail, de suivre les progrès, de gérer les erreurs, de maintenir le contexte à travers des dizaines d'opérations.

Deuxièmement, l'intégration des systèmes. Les LLM vivent dans un monde uniquement textuel. Les outils leur permettent d'interfacer de manière prévisible avec des systèmes externes comme des bases de données, des API et des logiciels d'entreprise, transformant le langage naturel en actions exécutables.

Au cours du dernier mois, j'ai construit 58 outils d'IA différents.

Des processeurs d'e-mails. Des intégrateurs de CRM. Des mises à jour de Notion. Des assistants de recherche. Chaque outil étend les capacités du modèle dans un nouveau domaine.

La capacité la plus importante pour l'IA est de sélectionner l'outil approprié rapidement et correctement. Chaque étape mal orientée tue l'ensemble du flux de travail.

Quand je dis "lisez cet e-mail de Y Combinator et trouvez toutes les startups qui ne sont pas dans le CRM", les LLM modernes exécutent une séquence complexe.

Une commande en anglais remplace un flux de travail entier. Et c'est juste un simple exemple.

Encore mieux, le modèle, correctement configuré avec les bons outils, peut vérifier son propre travail pour s'assurer que les tâches ont été complétées à temps. Cette boucle de vérification automatique crée une fiabilité dans les flux de travail qui est difficile à atteindre autrement.

Multipliez cela par des centaines d'employés. Des milliers de flux de travail. Les gains de productivité se cumulent de manière exponentielle.

Les gagnants dans le futur monde de l'IA seront ceux qui seront les plus sophistiqués dans l'orchestration des outils et le routage des bonnes requêtes. Chaque fois. Une fois que ces flux de travail sont prévisibles, c'est à ce moment-là que nous deviendrons tous des gestionnaires d'agents.

3,16K

2025 est l'année des agents, et la capacité clé des agents est d'appeler des outils.

Lorsque j'utilise Claude Code, je peux dire à l'IA de parcourir une newsletter, de trouver tous les liens vers des startups, de vérifier qu'ils existent dans notre CRM, avec une seule commande. Cela peut impliquer l'appel de deux ou trois outils différents.

Mais voici le problème : utiliser un grand modèle de fondation pour cela est coûteux, souvent limité en taux, et trop puissant pour une tâche de sélection.

Quelle est la meilleure façon de construire un système agentique avec appel d'outils ?

La réponse réside dans les petits modèles d'action. NVIDIA a publié un article convaincant soutenant que "les petits modèles de langage (SLMs) sont suffisamment puissants, intrinsèquement plus adaptés, et nécessairement plus économiques pour de nombreuses invocations dans les systèmes agentiques."

J'ai testé différents modèles locaux pour valider un exercice de réduction des coûts. J'ai commencé avec un modèle de 30 milliards de paramètres Qwen3:30b, qui fonctionne mais peut être assez lent car c'est un modèle si grand, même si seulement 3 milliards de ces 30 milliards de paramètres sont actifs à un moment donné.

L'article de NVIDIA recommande le modèle Salesforce xLAM – une architecture différente appelée un grand modèle d'action spécifiquement conçu pour la sélection d'outils.

J'ai donc réalisé un test de mon propre, chaque modèle appelant un outil pour lister mes tâches Asana.

Les résultats étaient frappants : xLAM a complété les tâches en 2,61 secondes avec un taux de réussite de 100 %, tandis que Qwen a pris 9,82 secondes avec un taux de réussite de 92 % – presque quatre fois plus longtemps.

Cet expérience montre le gain de vitesse, mais il y a un compromis : combien d'intelligence devrait résider dans le modèle par rapport aux outils eux-mêmes. Cela limite

Avec des modèles plus grands comme Qwen, les outils peuvent être plus simples car le modèle a une meilleure tolérance aux erreurs et peut contourner des interfaces mal conçues. Le modèle compense les limitations des outils par un raisonnement par force brute.

Avec des modèles plus petits, le modèle a moins de capacité à se remettre des erreurs, donc les outils doivent être plus robustes et la logique de sélection plus précise. Cela peut sembler une limitation, mais c'est en réalité une caractéristique.

Cette contrainte élimine le taux d'erreur cumulatif des outils enchaînés LLM. Lorsque de grands modèles effectuent des appels d'outils séquentiels, les erreurs s'accumulent de manière exponentielle.

Les petits modèles d'action forcent une meilleure conception du système, gardant le meilleur des LLM et le combinant avec des modèles spécialisés.

Cette architecture est plus efficace, plus rapide et plus prévisible.

5,29K

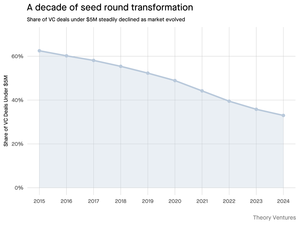

Pourquoi le tour de financement de démarrage de moins de 5 millions de dollars se réduit-il ?

Il y a une décennie, ces petits tours constituaient l'épine dorsale du financement des startups, représentant plus de 70 % de tous les accords de financement de démarrage. Aujourd'hui, les données de PitchBook révèlent que ce chiffre a chuté à moins de la moitié.

Les chiffres racontent une histoire frappante. Les accords de moins de 5 millions de dollars ont diminué de 62,5 % en 2015 à 37,5 % en 2024. Cette chute de 29,5 points de pourcentage a fondamentalement remodelé la manière dont les startups lèvent leur premier capital institutionnel.

Trois forces ont conduit cette transformation. Nous pouvons décomposer la baisse pour comprendre ce qui a réduit le petit tour de financement et pourquoi cela importe pour les fondateurs aujourd'hui.

4,69K

C'était tellement amusant, Mario. Merci de m'avoir invité dans l'émission pour parler de tout ce qui se passe sur le marché !

Mario Gabriele 🦊22 juil. 2025

Notre dernier épisode avec Tomasz Tunguz est en ligne !

La Décennie des Données

@ttunguz a passé presque deux décennies à transformer les données en insights d'investissement. Après avoir soutenu Looker, Expensify et Monte Carlo chez Redpoint Ventures, il a lancé @Theoryvc en 2022 avec une vision audacieuse : construire une "société d'investissement" où chercheurs, ingénieurs et opérateurs siègent aux côtés des investisseurs, créant des cartes de marché en temps réel et des outils d'IA internes. Son fonds inaugural a été clôturé à 238 millions de dollars, suivi seulement 19 mois plus tard par un deuxième fonds de 450 millions de dollars. Centrée sur les données, l'IA et l'infrastructure crypto, Theory opère au cœur des changements technologiques les plus conséquents d'aujourd'hui. Nous explorons comment les données redéfinissent le capital-risque, pourquoi les modèles d'investissement traditionnels sont perturbés, et ce qu'il faut pour construire une entreprise qui ne se contente pas de prédire l'avenir mais aide activement à le créer.

Écoutez maintenant :

• YouTube :

• Spotify :

• Apple :

Un grand merci aux incroyables sponsors qui rendent le podcast possible :

✨ Brex — La solution bancaire pour les startups :

✨ Generalist+ — Intelligence essentielle pour les investisseurs et technologists modernes :

Nous explorons :

→ Comment fonctionne le modèle de "société d'investissement" de Theory

→ Pourquoi les échanges de crypto pourraient créer un chemin viable vers les marchés publics pour les entreprises de logiciels à petite capitalisation

→ La crise énergétique imminente — pourquoi les centres de données pourraient consommer 15 % de l'électricité des États-Unis dans cinq ans

→ L'ascension rapide des stablecoins alors que les grandes banques acheminent 5 à 10 % des dollars américains à travers eux

→ Pourquoi Ethereum fait face à un défi existentiel similaire à celui d'AWS perdant du terrain face à Azure à l'ère de l'IA

→ Pourquoi Tomasz croit que la poignée d'agents d'aujourd'hui deviendra plus de 100 co‑travailleurs numériques d'ici la fin de l'année

→ Pourquoi Meta parie des milliards sur des lunettes AR pour changer notre interaction avec les machines

→ Comment Theory Ventures utilise l'IA pour accélérer la recherche de marché, l'analyse des transactions et les décisions d'investissement

…Et bien plus encore !

7,99K

OpenAI reçoit en moyenne 1 requête par Américain par jour.

Google reçoit environ 4 requêtes par Américain par jour.

Depuis lors, 50 % des requêtes de recherche Google ont des aperçus AI, ce qui signifie qu'au moins 60 % des recherches aux États-Unis sont désormais alimentées par l'IA.

Cela a pris un peu plus de temps que je ne l'avais prévu pour que cela se produise. En 2024, j'avais prédit que 50 % des recherches des consommateurs seraient activées par l'IA. (

Mais l'IA est arrivée dans la recherche.

Si les modèles de recherche Google sont un quelconque indice, il existe une loi de puissance dans le comportement de recherche. L'analyse de SparkToro sur le comportement de recherche Google montre que le tiers supérieur des Américains qui recherchent effectue plus de 80 % de toutes les recherches - ce qui signifie que l'utilisation de l'IA n'est probablement pas répartie de manière uniforme - comme l'avenir.

Les sites Web et les entreprises commencent à ressentir les impacts de cela. L'article de The Economist "L'IA tue le web. Quelque chose peut-elle le sauver ?" capture l'air du temps dans un titre. (

Une supermajorité d'Américains recherche désormais avec l'IA. Les effets de second ordre des changements de modèles de recherche arriveront dans la seconde moitié de cette année et beaucoup se demanderont : "Que s'est-il passé avec mon trafic ?" (

L'IA est un nouveau canal de distribution et ceux qui s'en emparent gagneront des parts de marché.

- William Gibson a vu beaucoup plus loin dans le futur !

- Ceci est basé sur une analyse intermédiaire du graphique SparkToro, c'est une analyse très simple, et comporte donc quelques erreurs.

8,87K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables