Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 đạt 94,6% độ chính xác trên AIME 2025, cho thấy khả năng suy luận toán học gần như con người.

Tuy nhiên, khi yêu cầu nó truy vấn cơ sở dữ liệu của bạn, tỷ lệ thành công giảm xuống chỉ còn vài phần trăm.

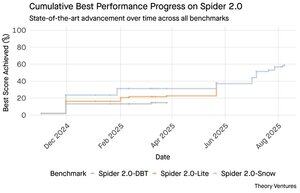

Các tiêu chuẩn Spider 2.0 tiết lộ một khoảng cách lớn trong khả năng của AI. Spider 2.0 là một tiêu chuẩn toàn diện về văn bản thành SQL, kiểm tra khả năng của các mô hình AI trong việc tạo ra các truy vấn SQL chính xác từ các câu hỏi bằng ngôn ngữ tự nhiên trên các cơ sở dữ liệu thực tế.

Trong khi các mô hình ngôn ngữ lớn đã chinh phục công việc tri thức trong toán học, lập trình và suy luận, việc chuyển đổi văn bản thành SQL vẫn còn khó khăn.

Ba tiêu chuẩn Spider 2.0 kiểm tra việc truy vấn cơ sở dữ liệu thực tế trong các môi trường khác nhau. Spider 2.0-Snow sử dụng cơ sở dữ liệu Snowflake với 547 ví dụ thử nghiệm, đạt đỉnh 59,05% độ chính xác.

Spider 2.0-Lite trải dài trên BigQuery, Snowflake và SQLite với 547 ví dụ khác, chỉ đạt 37,84%. Spider 2.0-DBT kiểm tra việc tạo mã với DuckDB với 68 ví dụ, đạt tối đa 39,71%.

Khoảng cách hiệu suất này không phải do thiếu nỗ lực. Kể từ tháng 11 năm 2024, 56 bài nộp từ 12 gia đình mô hình đã cạnh tranh trên các tiêu chuẩn này.

Claude, OpenAI, DeepSeek và những người khác đều đã đưa các mô hình của họ vào các bài kiểm tra này. Tiến bộ đã diễn ra đều đặn, từ khoảng 2% đến khoảng 60%, trong chín tháng qua.

Câu đố trở nên phức tạp hơn khi bạn xem xét các hạn chế của SQL. SQL có một từ vựng hạn chế so với tiếng Anh, vốn có 600.000 từ, hoặc các ngôn ngữ lập trình có cú pháp và thư viện rộng hơn nhiều. Hơn nữa, có rất nhiều SQL để đào tạo.

Nếu có gì đó, điều này nên dễ hơn so với các nhiệm vụ suy luận mở mà các mô hình hiện nay xuất sắc.

Tuy nhiên, ngay cả việc tạo SQL hoàn hảo cũng không giải quyết được thách thức thực sự trong kinh doanh. Mỗi công ty định nghĩa "doanh thu" theo cách khác nhau.

Marketing đo lường chi phí thu hút khách hàng theo chi phí chiến dịch, bán hàng tính toán nó bằng cách sử dụng chi phí của nhân viên quản lý tài khoản, và tài chính bao gồm chi phí nhân viên đã được tính toán đầy đủ. Những khác biệt ngữ nghĩa này tạo ra sự nhầm lẫn mà độ chính xác kỹ thuật không thể giải quyết.

Kết quả Spider 2.0 chỉ ra một sự thật cơ bản về công việc dữ liệu. Sự thành thạo kỹ thuật trong cú pháp SQL chỉ là điểm khởi đầu.

Thách thức thực sự nằm ở bối cảnh kinh doanh. Hiểu dữ liệu có nghĩa là gì, cách các đội khác nhau định nghĩa các chỉ số, và khi nào các trường hợp ngoại lệ quan trọng. Như tôi đã viết trong Semantic Cultivators, cầu nối giữa dữ liệu thô và ý nghĩa kinh doanh cần có sự phán đoán của con người mà AI hiện tại không thể tái tạo.

8,79K

GPT-5 đạt 94,6% độ chính xác trên AIME 2025, cho thấy khả năng suy luận toán học gần giống con người.

Tuy nhiên, khi yêu cầu nó truy vấn cơ sở dữ liệu của bạn, tỷ lệ thành công giảm xuống chỉ còn vài phần trăm.

Các tiêu chuẩn Spider 2.0 tiết lộ một khoảng cách lớn trong khả năng của AI. Spider 2.0 là một tiêu chuẩn toàn diện về văn bản thành SQL, kiểm tra khả năng của các mô hình AI trong việc tạo ra các truy vấn SQL chính xác từ các câu hỏi bằng ngôn ngữ tự nhiên trên các cơ sở dữ liệu thực tế.

Trong khi các mô hình ngôn ngữ lớn đã chinh phục công việc tri thức trong toán học, lập trình và suy luận, việc chuyển đổi văn bản thành SQL vẫn gặp khó khăn.

Ba tiêu chuẩn Spider 2.0 kiểm tra việc truy vấn cơ sở dữ liệu thực tế trong các môi trường khác nhau. Spider 2.0-Snow sử dụng cơ sở dữ liệu Snowflake với 547 ví dụ thử nghiệm, đạt đỉnh 59,05% độ chính xác.

Spider 2.0-Lite trải dài trên BigQuery, Snowflake và SQLite với 547 ví dụ khác, chỉ đạt 37,84%. Spider 2.0-DBT kiểm tra việc tạo mã với DuckDB với 68 ví dụ, đạt tối đa 39,71%.

Khoảng cách hiệu suất này không phải do thiếu nỗ lực. Kể từ tháng 11 năm 2024, 56 bài nộp từ 12 gia đình mô hình đã cạnh tranh trên các tiêu chuẩn này.

Claude, OpenAI, DeepSeek và những người khác đều đã đưa mô hình của họ vào các bài kiểm tra này. Tiến bộ đã diễn ra đều đặn, từ khoảng 2% đến khoảng 60% trong chín tháng qua.

Câu đố trở nên phức tạp hơn khi bạn xem xét các hạn chế của SQL. SQL có một từ vựng hạn chế so với tiếng Anh, vốn có 600.000 từ, hoặc các ngôn ngữ lập trình có cú pháp và thư viện rộng hơn nhiều. Hơn nữa, có rất nhiều SQL để đào tạo.

Nếu có gì đó, điều này nên dễ hơn so với các nhiệm vụ suy luận mở mà các mô hình hiện nay xuất sắc.

Tuy nhiên, ngay cả việc tạo ra SQL hoàn hảo cũng không giải quyết được thách thức thực sự trong kinh doanh. Mỗi công ty định nghĩa "doanh thu" theo cách khác nhau.

Marketing đo lường chi phí thu hút khách hàng theo chi phí chiến dịch, bán hàng tính toán nó bằng cách sử dụng chi phí của nhân viên bán hàng, và tài chính bao gồm cả chi phí nhân viên đã được tính toán đầy đủ. Những khác biệt ngữ nghĩa này tạo ra sự nhầm lẫn mà độ chính xác kỹ thuật không thể giải quyết.

Kết quả Spider 2.0 chỉ ra một sự thật cơ bản về công việc dữ liệu. Sự thành thạo kỹ thuật trong cú pháp SQL chỉ là điểm khởi đầu.

Thách thức thực sự nằm ở bối cảnh kinh doanh. Hiểu dữ liệu có nghĩa là gì, cách các đội khác nhau định nghĩa các chỉ số, và khi nào các trường hợp ngoại lệ quan trọng. Như tôi đã viết trong Semantic Cultivators, cầu nối giữa dữ liệu thô và ý nghĩa kinh doanh cần có sự phán đoán của con người mà AI hiện tại không thể tái tạo.

3,94K

Perplexity AI vừa đưa ra một đề nghị không yêu cầu trị giá 34,5 tỷ USD cho trình duyệt Chrome của Google, cố gắng tận dụng phán quyết chống độc quyền sắp tới có thể buộc Google phải thoái vốn khỏi lĩnh vực trình duyệt.

So sánh kinh tế của Chrome với thỏa thuận Safari hiện tại của Google cho thấy tại sao 34,5 tỷ USD là giá trị thấp cho trình duyệt này.

Google trả cho Apple từ 18-20 tỷ USD hàng năm để giữ vị trí công cụ tìm kiếm mặc định của Safari¹, phục vụ khoảng 850 triệu người dùng². Điều này tương đương với 21 USD mỗi người dùng mỗi năm.

Đề nghị của Perplexity định giá Chrome ở mức 32 tỷ USD, tức là 9 USD mỗi người dùng mỗi năm cho 3,5 tỷ người dùng³.

Nếu người dùng Chrome được hưởng các điều khoản tương tự như thỏa thuận Google/Apple Safari, tiềm năng doanh thu hàng năm của trình duyệt sẽ vượt quá 73 tỷ USD.

Dữ liệu này dựa trên các ước tính công khai nhưng chỉ là một ước lượng.

Điều này giả định rằng Google sẽ trả cho một chủ sở hữu mới của Chrome một khoản phí tương tự cho vị trí tìm kiếm mặc định. Với tỷ lệ vốn hóa thị trường trên doanh thu từ 5x đến 6x, Chrome có giá trị nằm trong khoảng từ 172 tỷ USD đến 630 tỷ USD, một con số rất xa so với đề nghị 34,5 tỷ USD.

Chrome chiếm ưu thế trên thị trường với 65% thị phần⁴, so với 18% của Safari. Việc thoái vốn sẽ khiến thị trường quảng cáo tìm kiếm rơi vào hỗn loạn. Giá trị của việc giữ ngân sách quảng cáo là rất khó để đánh giá thấp đối với vốn hóa thị trường và vị thế của Google trong hệ sinh thái quảng cáo.

Nếu bị buộc phải bán Chrome, Google sẽ phải đối mặt với một lựa chọn sống còn. Trả bất cứ giá nào để giữ vị trí công cụ tìm kiếm mặc định, hoặc chứng kiến các đối thủ biến kênh phân phối quý giá nhất của mình thành một công cụ chống lại nó.

Giá trị đó là bao nhiêu? Một khoản phí cao hơn so với một tỷ lệ doanh thu đơn giản.

¹ Bloomberg: Các khoản thanh toán của Google cho Apple đã đạt 20 tỷ USD vào năm 2022 (

² ZipDo: Thống kê Safari của Apple cần thiết vào năm 2024 (

³ Backlinko: Thị phần trình duyệt web vào năm 2025 (

⁴ Statcounter: Thị phần trình duyệt trên toàn cầu (

7,97K

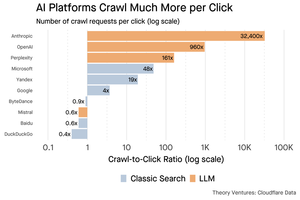

Vào năm 1999, các công ty dotcom được định giá dựa trên lưu lượng truy cập. Các chỉ số IPO xoay quanh số lượng người xem.

Sau đó, Google ra mắt AdWords, một mô hình quảng cáo dựa trên số lần nhấp chuột, và xây dựng một doanh nghiệp trị giá 273 tỷ USD vào năm 2024.

Nhưng mọi thứ có thể sắp thay đổi: Nghiên cứu của Pew Research vào tháng 7 năm 2025 cho thấy người dùng chỉ nhấp vào 8% kết quả tìm kiếm có tóm tắt AI, so với 15% không có - giảm 47%. Chỉ có 1% nhấp vào từ các tóm tắt AI.

Dữ liệu từ Cloudflare cho thấy các nền tảng AI thu thập nội dung nhiều hơn rất nhiều so với việc họ giới thiệu lưu lượng truy cập trở lại: Anthropic thu thập 32.400 trang cho mỗi 1 lượt giới thiệu, trong khi các công cụ tìm kiếm truyền thống quét nội dung chỉ vài lần cho mỗi khách truy cập được gửi.

Chi phí phục vụ nội dung cho các trình thu thập AI có thể không lớn nếu chủ yếu là văn bản.

Điểm lớn hơn là các hệ thống AI làm gián đoạn mối quan hệ giữa người dùng và nhà xuất bản. Người dùng thích các câu trả lời tổng hợp từ AI hơn là nhấp vào các trang web để tìm câu trả lời của họ.

Thật hợp lý khi hầu hết các trang web nên mong đợi ít lưu lượng truy cập hơn. Trang web và doanh nghiệp của bạn sẽ xử lý điều này như thế nào?

Nguồn:

- Pew Research Center - Athena Chapekis, ngày 22 tháng 7 năm 2025 (

- Cloudflare: Cuộc thu thập trước khi giảm lưu lượng giới thiệu (

- Cloudflare Radar: AI Insights - Tỷ lệ thu thập so với giới thiệu (

- Podcast: Giá trị thay đổi của nội dung trong thời đại AI (

9,68K

GPT-5 đã ra mắt hôm qua. 94,6% trên AIME 2025. 74,9% trên SWE-bench.

Khi chúng ta tiến gần đến giới hạn cao nhất của những tiêu chuẩn này, chúng sẽ chết.

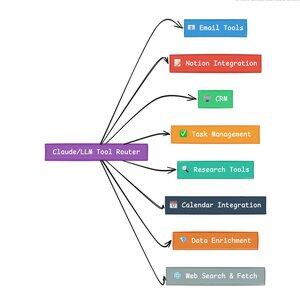

Điều làm cho GPT-5 và thế hệ mô hình tiếp theo trở nên cách mạng không phải là kiến thức của chúng. Mà là biết cách hành động. Đối với GPT-5, điều này xảy ra ở hai cấp độ. Đầu tiên, quyết định mô hình nào để sử dụng. Nhưng thứ hai, và quan trọng hơn, thông qua việc gọi công cụ.

Chúng ta đã sống trong một kỷ nguyên mà LLM đã thành thạo việc truy xuất và tái cấu trúc kiến thức. Tìm kiếm người tiêu dùng và lập trình, những ứng dụng giết người ban đầu, về cơ bản là những thách thức trong việc truy xuất kiến thức. Cả hai đều tổ chức thông tin hiện có theo những cách mới.

Chúng ta đã leo lên những ngọn đồi đó và kết quả là sự cạnh tranh trở nên khốc liệt hơn bao giờ hết. Các mô hình của Anthropic, OpenAI và Google đang hội tụ vào những khả năng tương tự. Các mô hình Trung Quốc và các lựa chọn mã nguồn mở đang tiếp tục tiến gần hơn đến công nghệ tiên tiến nhất. Mọi người đều có thể truy xuất thông tin. Mọi người đều có thể tạo ra văn bản.

Trục cạnh tranh mới? Gọi công cụ.

Gọi công cụ biến LLM từ những người tư vấn thành những người hành động. Nó bù đắp cho hai điểm yếu quan trọng của mô hình mà các mô hình ngôn ngữ thuần túy không thể vượt qua.

Đầu tiên, điều phối quy trình làm việc. Các mô hình xuất sắc trong việc phản hồi một lần nhưng gặp khó khăn với các quy trình nhiều bước, có trạng thái. Các công cụ cho phép chúng quản lý các quy trình dài, theo dõi tiến độ, xử lý lỗi, duy trì ngữ cảnh qua hàng chục hoạt động.

Thứ hai, tích hợp hệ thống. LLM sống trong một thế giới chỉ có văn bản. Các công cụ cho phép chúng giao tiếp một cách dự đoán với các hệ thống bên ngoài như cơ sở dữ liệu, API và phần mềm doanh nghiệp, biến ngôn ngữ tự nhiên thành các hành động có thể thực thi.

Trong tháng qua, tôi đã xây dựng 58 công cụ AI khác nhau.

Các bộ xử lý email. Các tích hợp CRM. Các cập nhật Notion. Các trợ lý nghiên cứu. Mỗi công cụ mở rộng khả năng của mô hình vào một lĩnh vực mới.

Khả năng quan trọng nhất đối với AI là chọn công cụ đúng một cách nhanh chóng và chính xác. Mỗi bước đi sai hướng đều giết chết toàn bộ quy trình làm việc.

Khi tôi nói "đọc email này từ Y Combinator & tìm tất cả các công ty khởi nghiệp không có trong CRM," các LLM hiện đại thực hiện một chuỗi phức tạp.

Một lệnh bằng tiếng Anh thay thế cho toàn bộ quy trình làm việc. Và đây chỉ là một ví dụ đơn giản.

Còn tốt hơn, mô hình, được thiết lập đúng cách với các công cụ phù hợp, có thể xác minh công việc của chính nó rằng các nhiệm vụ đã được hoàn thành đúng hạn. Vòng lặp tự xác minh này tạo ra độ tin cậy trong các quy trình làm việc mà khó đạt được theo cách khác.

Nhân điều này lên hàng trăm nhân viên. Hàng ngàn quy trình làm việc. Lợi ích về năng suất tăng theo cấp số nhân.

Những người chiến thắng trong thế giới AI tương lai sẽ là những người tinh vi nhất trong việc điều phối các công cụ và định tuyến các truy vấn đúng. Mỗi lần. Khi những quy trình làm việc đó trở nên dự đoán được, đó là lúc tất cả chúng ta sẽ trở thành những người quản lý đại lý.

3,16K

Năm 2025 là năm của các tác nhân, và khả năng chính của các tác nhân là gọi công cụ.

Khi sử dụng Claude Code, tôi có thể yêu cầu AI lọc qua một bản tin, tìm tất cả các liên kết đến các công ty khởi nghiệp, xác minh chúng tồn tại trong CRM của chúng tôi, chỉ với một lệnh duy nhất. Điều này có thể liên quan đến việc gọi hai hoặc ba công cụ khác nhau.

Nhưng đây là vấn đề: việc sử dụng một mô hình nền tảng lớn cho việc này là tốn kém, thường bị giới hạn về tốc độ, và quá mạnh cho một nhiệm vụ lựa chọn.

Cách tốt nhất để xây dựng một hệ thống tác nhân với việc gọi công cụ là gì?

Câu trả lời nằm ở các mô hình hành động nhỏ. NVIDIA đã phát hành một tài liệu thuyết phục lập luận rằng "Các mô hình ngôn ngữ nhỏ (SLMs) đủ mạnh, tự nhiên phù hợp hơn, và cần thiết hơn về mặt kinh tế cho nhiều lần gọi trong các hệ thống tác nhân."

Tôi đã thử nghiệm các mô hình địa phương khác nhau để xác thực một bài tập giảm chi phí. Tôi bắt đầu với mô hình Qwen3:30b, hoạt động nhưng có thể khá chậm vì nó là một mô hình lớn, mặc dù chỉ có 3 tỷ trong số 30 tỷ tham số đó hoạt động tại bất kỳ thời điểm nào.

Tài liệu của NVIDIA khuyến nghị mô hình Salesforce xLAM – một kiến trúc khác được gọi là mô hình hành động lớn được thiết kế đặc biệt cho việc lựa chọn công cụ.

Vì vậy, tôi đã thực hiện một bài kiểm tra của riêng mình, mỗi mô hình gọi một công cụ để liệt kê các nhiệm vụ Asana của tôi.

Kết quả thật ấn tượng: xLAM hoàn thành nhiệm vụ trong 2.61 giây với tỷ lệ thành công 100%, trong khi Qwen mất 9.82 giây với tỷ lệ thành công 92% – gần gấp bốn lần thời gian.

Thí nghiệm này cho thấy sự gia tăng tốc độ, nhưng có một sự đánh đổi: bao nhiêu trí tuệ nên nằm trong mô hình so với trong chính các công cụ. Điều này bị giới hạn.

Với các mô hình lớn hơn như Qwen, các công cụ có thể đơn giản hơn vì mô hình có khả năng chịu lỗi tốt hơn và có thể làm việc xung quanh các giao diện được thiết kế kém. Mô hình bù đắp cho các hạn chế của công cụ thông qua lý luận brute-force.

Với các mô hình nhỏ hơn, mô hình có ít khả năng phục hồi từ sai lầm, vì vậy các công cụ phải mạnh mẽ hơn và logic lựa chọn phải chính xác hơn. Điều này có thể có vẻ như một hạn chế, nhưng thực sự là một tính năng.

Ràng buộc này loại bỏ tỷ lệ lỗi tích lũy của các công cụ chuỗi LLM. Khi các mô hình lớn thực hiện các cuộc gọi công cụ tuần tự, lỗi tích lũy theo cấp số nhân.

Các mô hình hành động nhỏ buộc thiết kế hệ thống tốt hơn, giữ lại những gì tốt nhất của LLM và kết hợp nó với các mô hình chuyên biệt.

Kiến trúc này hiệu quả hơn, nhanh hơn và dễ dự đoán hơn.

5,29K

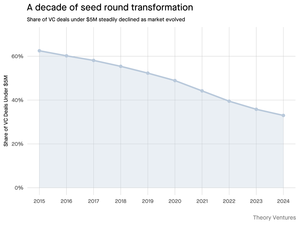

Tại sao vòng gọi vốn hạt giống dưới 5 triệu đô la lại thu hẹp lại?

Mười năm trước, những vòng gọi vốn nhỏ này là nền tảng của tài chính khởi nghiệp, chiếm hơn 70% tất cả các giao dịch hạt giống. Ngày nay, dữ liệu từ PitchBook cho thấy con số này đã giảm xuống dưới một nửa.

Các con số kể một câu chuyện rõ ràng. Các giao dịch dưới 5 triệu đô la đã giảm từ 62,5% vào năm 2015 xuống còn 37,5% vào năm 2024. Sự sụt giảm 29,5 điểm phần trăm này đã định hình lại cách các công ty khởi nghiệp huy động vốn đầu tư thể chế đầu tiên của họ.

Ba lực lượng đã thúc đẩy sự chuyển biến này. Chúng ta có thể phân tích sự suy giảm để hiểu điều gì đã làm giảm vòng gọi vốn hạt giống nhỏ và tại sao điều đó lại quan trọng đối với các nhà sáng lập ngày nay.

4,69K

Điều này thật vui, Mario. Cảm ơn vì đã mời tôi tham gia chương trình để nói về mọi thứ đang diễn ra trên thị trường!

Mario Gabriele 🦊22 thg 7, 2025

Tập mới nhất của chúng tôi với Tomasz Tunguz đã lên sóng!

Thập kỷ của Dữ liệu

@ttunguz đã dành gần hai thập kỷ để biến dữ liệu thành những hiểu biết đầu tư. Sau khi hỗ trợ Looker, Expensify và Monte Carlo tại Redpoint Ventures, ông đã ra mắt @Theoryvc vào năm 2022 với một tầm nhìn táo bạo: xây dựng một "tập đoàn đầu tư" nơi các nhà nghiên cứu, kỹ sư và nhà điều hành ngồi bên cạnh các nhà đầu tư, tạo ra các bản đồ thị trường theo thời gian thực và công cụ AI nội bộ. Quỹ ra mắt của ông đã đóng cửa với 238 triệu đô la, chỉ 19 tháng sau đó là quỹ thứ hai trị giá 450 triệu đô la. Tập trung vào dữ liệu, AI và cơ sở hạ tầng crypto, Theory hoạt động tại trung tâm của những chuyển biến công nghệ quan trọng nhất hiện nay. Chúng tôi khám phá cách dữ liệu đang định hình lại vốn đầu tư mạo hiểm, tại sao các mô hình đầu tư truyền thống đang bị gián đoạn, và điều gì cần thiết để xây dựng một công ty không chỉ dự đoán tương lai mà còn tích cực giúp tạo ra nó.

Nghe ngay:

• YouTube:

• Spotify:

• Apple:

Một lời cảm ơn lớn đến những nhà tài trợ tuyệt vời đã làm cho podcast này trở nên khả thi:

✨ Brex — Giải pháp ngân hàng cho các startup:

✨ Generalist+ — Thông tin thiết yếu cho các nhà đầu tư và công nghệ hiện đại:

Chúng tôi khám phá:

→ Cách thức hoạt động của mô hình "tập đoàn đầu tư" của Theory

→ Tại sao các sàn giao dịch crypto có thể tạo ra một con đường khả thi đến thị trường công cho các công ty phần mềm vốn hóa nhỏ

→ Sự khủng hoảng năng lượng sắp tới—tại sao các trung tâm dữ liệu có thể tiêu thụ 15% điện năng của Mỹ trong vòng năm năm tới

→ Sự gia tăng nhanh chóng của stablecoin khi các ngân hàng lớn chuyển 5-10% đô la Mỹ qua chúng

→ Tại sao Ethereum đang đối mặt với một thách thức tồn tại tương tự như AWS mất đất vào Azure trong kỷ nguyên AI

→ Tại sao Tomasz tin rằng một số ít đại lý hiện nay sẽ trở thành 100+ đồng nghiệp kỹ thuật số vào cuối năm

→ Tại sao Meta đang đặt cược hàng tỷ vào kính AR để thay đổi cách chúng ta tương tác với máy móc

→ Cách Theory Ventures sử dụng AI để tăng tốc nghiên cứu thị trường, phân tích giao dịch và quyết định đầu tư

…Và còn nhiều hơn thế nữa!

8K

OpenAI nhận trung bình 1 truy vấn mỗi người Mỹ mỗi ngày.

Google nhận khoảng 4 truy vấn mỗi người Mỹ mỗi ngày.

Kể từ đó, 50% các truy vấn tìm kiếm của Google có AI Overviews, điều này có nghĩa là ít nhất 60% các tìm kiếm ở Mỹ hiện nay là AI.

Nó đã mất một chút thời gian hơn tôi mong đợi để điều này xảy ra. Vào năm 2024, tôi dự đoán rằng 50% tìm kiếm của người tiêu dùng sẽ được hỗ trợ bởi AI. (

Nhưng AI đã xuất hiện trong tìm kiếm.

Nếu các mẫu tìm kiếm của Google là bất kỳ chỉ dẫn nào, có một quy luật sức mạnh trong hành vi tìm kiếm. Phân tích của SparkToro về hành vi tìm kiếm của Google cho thấy một phần ba hàng đầu của người Mỹ tìm kiếm thực hiện hơn 80% tất cả các tìm kiếm - điều này có nghĩa là việc sử dụng AI có thể không được phân phối đều - giống như tương lai.

Các trang web & doanh nghiệp đang bắt đầu cảm nhận được tác động của điều này. Bài viết của The Economist "AI đang giết chết web. Có điều gì có thể cứu nó không?" nắm bắt được tinh thần thời đại trong một tiêu đề. (

Một số lượng lớn người Mỹ hiện nay tìm kiếm bằng AI. Các tác động thứ cấp từ việc thay đổi mẫu tìm kiếm sẽ đến trong nửa sau của năm nay & nhiều người sẽ hỏi, "Điều gì đã xảy ra với lưu lượng truy cập của tôi?" (

AI là một kênh phân phối mới & những ai nắm bắt được nó sẽ giành được thị phần.

- William Gibson đã nhìn xa hơn nhiều vào tương lai!

- Điều này dựa trên một phân tích điểm giữa của biểu đồ SparkToro, là một phân tích rất đơn giản, & có một số sai số do đó.

8,87K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất