Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 достигает 94,6% точности на AIME 2025, что предполагает почти человеческое математическое мышление.

Но если попросить его выполнить запрос к вашей базе данных, уровень успеха падает до подростковых значений.

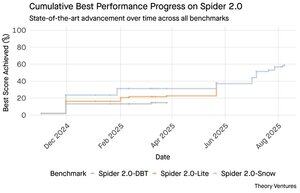

Бенчмарки Spider 2.0 выявляют огромный разрыв в возможностях ИИ. Spider 2.0 — это комплексный бенчмарк text-to-SQL, который тестирует способность ИИ-моделей генерировать точные SQL-запросы из вопросов на естественном языке по реальным базам данных.

Хотя большие языковые модели завоевали знания в математике, программировании и логическом мышлении, text-to-SQL остается упрямо сложным.

Три бенчмарка Spider 2.0 тестируют запросы к реальным базам данных в различных средах. Spider 2.0-Snow использует базы данных Snowflake с 547 тестовыми примерами, достигая максимальной точности 59,05%.

Spider 2.0-Lite охватывает BigQuery, Snowflake и SQLite с еще 547 примерами, достигая лишь 37,84%. Spider 2.0-DBT тестирует генерацию кода против DuckDB с 68 примерами, достигая 39,71%.

Этот разрыв в производительности не из-за недостатка усилий. С ноября 2024 года 56 заявок от 12 семейств моделей соревновались на этих бенчмарках.

Claude, OpenAI, DeepSeek и другие все протестировали свои модели на этих тестах. Прогресс был стабильным, от примерно 2% до около 60% за последние девять месяцев.

Загадка углубляется, когда вы учитываете ограничения SQL. У SQL ограниченный словарный запас по сравнению с английским, который имеет 600 000 слов, или языками программирования, которые имеют гораздо более широкие синтаксисы и библиотеки для изучения. Плюс, существует множество SQL, на котором можно обучаться.

Если что-то, это должно быть проще, чем открытые задачи на рассуждение, в которых модели сейчас преуспевают.

Тем не менее, даже идеальная генерация SQL не решит настоящую бизнес-проблему. Каждая компания по-разному определяет "доход".

Маркетинг измеряет стоимость привлечения клиентов по расходам на кампанию, продажи рассчитывают это, используя затраты на менеджеров по продажам, а финансы включают полностью загруженные расходы сотрудников. Эти семантические различия создают путаницу, которую техническая точность не может разрешить.

Результаты Spider 2.0 указывают на основную истину о работе с данными. Техническая компетентность в синтаксисе SQL — это лишь отправная точка.

Настоящая проблема заключается в бизнес-контексте. Понимание того, что означают данные, как разные команды определяют метрики и когда важны крайние случаи. Как я писал в "Семантических культиваторах", мост между сырыми данными и бизнес-смыслом требует человеческого суждения, которое текущий ИИ не может воспроизвести.

8,8K

GPT-5 достигает 94,6% точности на AIME 2025, что предполагает почти человеческое математическое мышление.

Но если попросить его выполнить запрос к вашей базе данных, уровень успеха падает до подростковых значений.

Бенчмарки Spider 2.0 выявляют огромный разрыв в возможностях ИИ. Spider 2.0 — это комплексный бенчмарк text-to-SQL, который тестирует способность ИИ-моделей генерировать точные SQL-запросы из вопросов на естественном языке на реальных базах данных.

Хотя большие языковые модели завоевали знания в математике, программировании и логическом мышлении, text-to-SQL остается упрямо сложным.

Три бенчмарка Spider 2.0 тестируют запросы к реальным базам данных в различных средах. Spider 2.0-Snow использует базы данных Snowflake с 547 тестовыми примерами, достигая максимума в 59,05% точности.

Spider 2.0-Lite охватывает BigQuery, Snowflake и SQLite с еще 547 примерами, достигая лишь 37,84%. Spider 2.0-DBT тестирует генерацию кода против DuckDB с 68 примерами, достигая максимума в 39,71%.

Этот разрыв в производительности не из-за отсутствия попыток. С ноября 2024 года 56 заявок от 12 семейств моделей соревновались на этих бенчмарках.

Claude, OpenAI, DeepSeek и другие все пытались протестировать свои модели на этих тестах. Прогресс был стабильным, от примерно 2% до около 60% за последние девять месяцев.

Загадка углубляется, когда вы учитываете ограничения SQL. У SQL ограниченный словарный запас по сравнению с английским, который имеет 600 000 слов, или языками программирования, которые имеют гораздо более широкие синтаксисы и библиотеки для изучения. Плюс, существует множество SQL, на котором можно обучаться.

Если что-то, это должно быть проще, чем открытые задачи на рассуждение, в которых модели сейчас преуспевают.

Тем не менее, даже идеальная генерация SQL не решит настоящую бизнес-проблему. Каждая компания по-разному определяет "доход".

Маркетинг измеряет стоимость привлечения клиентов по расходам на кампанию, продажи рассчитывают это, используя затраты на менеджеров по продажам, а финансы включают полностью загруженные расходы сотрудников. Эти семантические различия создают путаницу, которую техническая точность не может разрешить.

Результаты Spider 2.0 указывают на фундаментальную истину о работе с данными. Техническая компетентность в синтаксисе SQL — это лишь отправная точка.

Настоящая проблема заключается в бизнес-контексте. Понимание того, что означают данные, как разные команды определяют метрики и когда важны крайние случаи. Как я писал в "Семантических культиваторах", мост между сырыми данными и бизнес-смыслом требует человеческого суждения, которое текущий ИИ не может воспроизвести.

3,95K

Perplexity AI только что сделала непрошеное предложение в размере 34,5 миллиарда долларов за браузер Google Chrome, пытаясь воспользоваться ожидаемым антимонопольным решением, которое может заставить Google продать свой бизнес браузера.

Сравнение экономики Chrome с существующей сделкой Google с Safari показывает, почему 34,5 миллиарда долларов недооценивают браузер.

Google платит Apple от 18 до 20 миллиардов долларов ежегодно, чтобы оставаться поисковой системой по умолчанию для Safari¹, обслуживая примерно 850 миллионов пользователей². Это составляет 21 доллар на пользователя в год.

Предложение Perplexity оценивает Chrome в 32 миллиарда долларов, что составляет 9 долларов на пользователя в год для его 3,5 миллиарда пользователей³.

Если пользователи Chrome получат такие же условия, как сделка Google/Apple с Safari, годовой доход браузера превысит 73 миллиарда долларов.

Эти данные основаны на публичных оценках, но являются приблизительными.

Это предполагает, что Google будет платить новому владельцу Chrome аналогичную масштабируемую плату за размещение по умолчанию. Учитывая мультипликатор рыночной капитализации к доходу от 5 до 6, Chrome стоит где-то между 172 миллиарда и 630 миллиарда долларов, что далеко от предложения в 34,5 миллиарда долларов.

Chrome доминирует на рынке с долей 65%⁴, по сравнению с 18% у Safari. Продажа вызовет смятение на рынке поисковой рекламы. Ценность сохранения рекламных бюджетов трудно переоценить для рыночной капитализации и позиции Google в экосистеме рекламы.

Если Google будет вынужден продать Chrome, ему придется сделать экзистенциальный выбор. Платить все, что нужно, чтобы оставаться поисковой системой по умолчанию, или наблюдать, как конкуренты превращают его самый ценный канал распространения в оружие против него.

Сколько это стоит? Значительная премия к простому мультипликатору дохода.

¹ Bloomberg: Платежи Google Apple достигли 20 миллиардов долларов в 2022 году (

² ZipDo: Основные статистические данные о Apple Safari в 2024 году (

³ Backlinko: Доля рынка веб-браузеров в 2025 году (

⁴ Statcounter: Доля рынка браузеров в мире (

7,97K

В 1999 году компании dotcom оценивались по трафику. Метрики IPO вращались вокруг количества просмотров.

Затем Google запустил AdWords, рекламную модель, основанную на кликах, и построил бизнес стоимостью 273 миллиарда долларов в 2024 году.

Но все это может измениться: исследование Pew Research за июль 2025 года показывает, что пользователи кликают всего на 8% результатов поиска с AI-сводками, по сравнению с 15% без них - снижение на 47%. Только 1% кликает по ссылкам из AI-сводок.

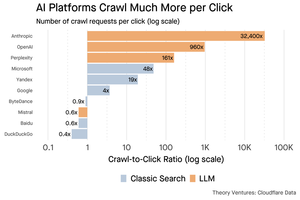

Данные Cloudflare показывают, что AI-платформы сканируют контент гораздо больше, чем перенаправляют трафик: Anthropic сканирует 32,400 страниц на каждую 1 ссылку, в то время как традиционные поисковые системы просматривают контент всего несколько раз на посетителя.

Расходы на предоставление контента AI-сканерам могут быть незначительными, если это в основном текст.

Главная мысль заключается в том, что AI-системы устраняют посредничество между пользователем и издателем. Пользователи предпочитают агрегированные AI-ответы, а не переходы на веб-сайты для поиска своих ответов.

Логично, что большинство веб-сайтов должны ожидать меньший трафик. Как ваш веб-сайт и ваш бизнес справятся с этим?

Источники:

- Pew Research Center - Афина Чапекис, 22 июля 2025 года (

- Cloudflare: Сканирование перед падением ссылок (

- Cloudflare Radar: AI Insights - Соотношение сканирования к перенаправлению (

- Подкаст: Изменяющаяся ценность контента в эпоху AI (

9,68K

GPT-5 был запущен вчера. 94,6% на AIME 2025. 74,9% на SWE-bench.

По мере того как мы приближаемся к верхним границам этих эталонов, они умирают.

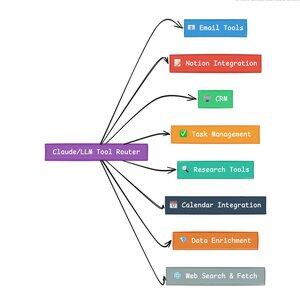

Что делает GPT-5 и следующее поколение моделей революционными, так это не их знания. Это умение действовать. Для GPT-5 это происходит на двух уровнях. Во-первых, решение, какую модель использовать. Но во-вторых, и что более важно, через вызов инструментов.

Мы живем в эпоху, когда LLM освоили извлечение и переупаковку знаний. Потребительский поиск и кодирование, первоначальные «убийственные» приложения, по сути, являются задачами извлечения знаний. Оба организуют существующую информацию новыми способами.

Мы преодолели эти холмы, и в результате конкуренция стала более интенсивной, чем когда-либо. Модели Anthropic, OpenAI и Google сходятся на схожих возможностях. Китайские модели и альтернативы с открытым исходным кодом продолжают приближаться к передовым технологиям. Каждый может извлекать информацию. Каждый может генерировать текст.

Новая ось конкуренции? Вызов инструментов.

Вызов инструментов трансформирует LLM из советников в исполнителей. Это компенсирует две критические слабости моделей, которые чисто языковые модели не могут преодолеть.

Во-первых, оркестрация рабочих процессов. Модели отлично справляются с одноразовыми ответами, но испытывают трудности с многошаговыми, состоящими из нескольких этапов процессами. Инструменты позволяют им управлять длинными рабочими процессами, отслеживая прогресс, обрабатывая ошибки, поддерживая контекст на протяжении десятков операций.

Во-вторых, интеграция систем. LLM живут в текстовом мире. Инструменты позволяют им предсказуемо взаимодействовать с внешними системами, такими как базы данных, API и корпоративное программное обеспечение, превращая естественный язык в исполняемые действия.

За последний месяц я создал 58 различных инструментов ИИ.

Обработчики электронной почты. Интеграторы CRM. Обновления Notion. Ассистенты по исследованиям. Каждый инструмент расширяет возможности модели в новую область.

Самая важная способность для ИИ — быстро и правильно выбирать нужный инструмент. Каждое неверное направление убивает весь рабочий процесс.

Когда я говорю "прочитай это письмо от Y Combinator и найди все стартапы, которые не находятся в CRM", современные LLM выполняют сложную последовательность.

Одна команда на английском языке заменяет целый рабочий процесс. И это всего лишь простой пример.

Еще лучше, модель, правильно настроенная с нужными инструментами, может проверить свою собственную работу, что задачи были выполнены вовремя. Этот цикл самопроверки создает надежность в рабочих процессах, которую трудно достичь иначе.

Умножьте это на сотни сотрудников. Тысячи рабочих процессов. Увеличение производительности складывается экспоненциально.

Победители в будущем мире ИИ будут теми, кто наиболее искусно управляет инструментами и направляет правильные запросы. Каждый раз. Как только эти рабочие процессы станут предсказуемыми, именно тогда мы все станем менеджерами агентов.

3,17K

2025 год — это год агентов, и ключевая способность агентов — это вызов инструментов.

Используя Claude Code, я могу сказать ИИ просмотреть информационный бюллетень, найти все ссылки на стартапы, проверить, существуют ли они в нашей CRM, с помощью одной команды. Это может потребовать вызова двух или трех различных инструментов.

Но вот в чем проблема: использование большой модели на основе фундамента для этого дорого, часто ограничено по скорости и чрезмерно мощно для задачи выбора.

Каков лучший способ построить агентскую систему с вызовом инструментов?

Ответ заключается в малых моделях действий. NVIDIA выпустила убедительную статью, утверждающую, что "Малые языковые модели (SLMs) достаточно мощны, по своей природе более подходящи и обязательно более экономичны для многих вызовов в агентских системах."

Я тестировал различные локальные модели, чтобы подтвердить упражнение по снижению затрат. Я начал с модели Qwen3:30b параметров, которая работает, но может быть довольно медленной, потому что это такая большая модель, даже если только 3 миллиарда из этих 30 миллиардов параметров активны в любой момент времени.

Статья NVIDIA рекомендует модель Salesforce xLAM — другую архитектуру, называемую большой моделью действий, специально разработанную для выбора инструментов.

Итак, я провел собственный тест, каждая модель вызывала инструмент для перечисления моих задач в Asana.

Результаты были поразительными: xLAM завершила задачи за 2,61 секунды с 100% успехом, в то время как Qwen заняла 9,82 секунды с 92% успехом — почти в четыре раза дольше.

Этот эксперимент показывает прирост скорости, но есть компромисс: сколько интеллекта должно находиться в модели по сравнению с самими инструментами. Это ограничено.

С более крупными моделями, такими как Qwen, инструменты могут быть проще, потому что модель имеет лучшую толерантность к ошибкам и может обойти плохо спроектированные интерфейсы. Модель компенсирует ограничения инструментов с помощью грубой силы рассуждений.

С меньшими моделями у модели меньше возможностей восстанавливаться от ошибок, поэтому инструменты должны быть более надежными, а логика выбора более точной. Это может показаться ограничением, но на самом деле это особенность.

Это ограничение устраняет нарастающую ошибку цепочки инструментов LLM. Когда большие модели делают последовательные вызовы инструментов, ошибки накапливаются экспоненциально.

Малые модели действий заставляют лучше проектировать систему, сохраняя лучшее из LLM и комбинируя это со специализированными моделями.

Эта архитектура более эффективна, быстрее и предсказуема.

5,3K

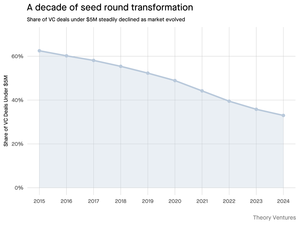

Почему сокращается количество посевных раундов менее 5 миллионов долларов?

Десять лет назад эти небольшие раунды составляли основу финансирования стартапов, составляя более 70% всех сделок на посевном этапе. Сегодня данные PitchBook показывают, что эта цифра упала до менее чем половины.

Цифры рассказывают яркую историю. Сделки менее 5 миллионов долларов сократились с 62,5% в 2015 году до 37,5% в 2024 году. Это падение на 29,5 процентных пункта коренным образом изменило способ, которым стартапы привлекают свой первый институциональный капитал.

Три силы стали движущими факторами этой трансформации. Мы можем разобрать это снижение, чтобы понять, что уменьшило малые посевные раунды и почему это важно для основателей сегодня.

4,7K

Это было так весело, Марио. Спасибо, что пригласил меня на шоу, чтобы поговорить обо всем, что происходит на рынке!

Mario Gabriele 🦊22 июл. 2025 г.

Наш последний эпизод с Томашем Тунгужем в эфире!

Десятилетие данных

@ttunguz провел почти два десятилетия, превращая данные в инвестиционные идеи. После поддержки Looker, Expensify и Monte Carlo в Redpoint Ventures, он запустил @Theoryvc в 2022 году с смелым видением: создать "инвестиционную корпорацию", где исследователи, инженеры и операторы работают бок о бок с инвесторами, создавая карты рынка в реальном времени и внутренние инструменты ИИ. Его дебютный фонд закрылся на уровне 238 миллионов долларов, а всего через 19 месяцев был запущен второй фонд на 450 миллионов долларов. Сосредоточенный на данных, ИИ и криптоинфраструктуре, Theory работает в центре самых значительных технологических изменений сегодняшнего дня. Мы исследуем, как данные меняют венчурный капитал, почему традиционные инвестиционные модели подвергаются разрушению и что нужно, чтобы построить компанию, которая не просто предсказывает будущее, но активно помогает его создавать.

Слушайте сейчас:

• YouTube:

• Spotify:

• Apple:

Большое спасибо невероятным спонсорам, которые делают подкаст возможным:

✨ Brex — банковское решение для стартапов:

✨ Generalist+ — необходимая информация для современных инвесторов и технологов:

Мы исследуем:

→ Как работает модель "инвестиционной корпорации" Theory

→ Почему криптобиржи могут создать жизнеспособный путь к публичным рынкам для малокапитализированных программных компаний

→ Надвигающийся кризис мощности — почему дата-центры могут потреблять 15% электроэнергии США в течение пяти лет

→ Быстрый рост стейблкоинов, поскольку крупные банки направляют 5-10% долларов США через них

→ Почему Ethereum сталкивается с экзистенциальной проблемой, аналогичной тому, как AWS теряет позиции перед Azure в эпоху ИИ

→ Почему Томаш считает, что сегодняшняя горстка агентов станет 100+ цифровыми сотрудниками к концу года

→ Почему Meta ставит миллиарды на AR-очки, чтобы изменить наше взаимодействие с машинами

→ Как Theory Ventures использует ИИ для ускорения рыночных исследований, анализа сделок и инвестиционных решений

…И многое другое!

8,01K

OpenAI получает в среднем 1 запрос на американца в день.

Google получает около 4 запросов на американца в день.

С тех пор 50% запросов в Google имеют AI-обзоры, это означает, что как минимум 60% поисков в США теперь связаны с ИИ.

Это заняло немного больше времени, чем я ожидал, чтобы это произошло. В 2024 году я предсказал, что 50% потребительских поисков будут поддерживаться ИИ. (

Но ИИ уже пришел в поиск.

Если паттерны поиска в Google являются каким-либо индикатором, то в поведении поиска существует закон силы. Анализ поведения поиска в Google от SparkToro показывает, что верхняя треть американцев, которые ищут, выполняет более 80% всех запросов - что означает, что использование ИИ, вероятно, не распределено равномерно - как и будущее.

Вебсайты и бизнесы начинают ощущать последствия этого. Статья The Economist "ИИ убивает веб. Может ли что-то его спасти?" отражает дух времени в заголовке. (

Супербольшинство американцев теперь ищет с помощью ИИ. Вторичные эффекты от изменения паттернов поиска начнут проявляться во второй половине этого года, и больше людей будут спрашивать: "Что случилось с моим трафиком?" (

ИИ - это новый канал распределения, и те, кто его захватит, получат долю рынка.

- Уильям Гибсон заглянул гораздо дальше в будущее!

- Это основано на промежуточном анализе графика SparkToro, это очень простой анализ и имеет некоторые ошибки в результате.

8,88K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные