Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 alcanza una precisión del 94.6% en AIME 2025, lo que sugiere un razonamiento matemático casi humano.

Sin embargo, pídale que consulte su base de datos y las tasas de éxito caen a los adolescentes.

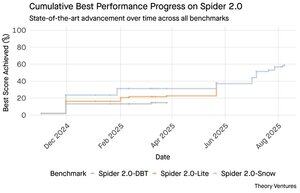

Los benchmarks de Spider 2.0 revelan una brecha abismal en las capacidades de la IA. Spider 2.0 es un benchmark integral de texto a SQL que evalúa la capacidad de los modelos de IA para generar consultas SQL precisas a partir de preguntas en lenguaje natural en bases de datos del mundo real.

Mientras que los grandes modelos de lenguaje han conquistado el trabajo del conocimiento en matemáticas, codificación y razonamiento, el texto a SQL sigue siendo obstinadamente difícil.

Los tres benchmarks de Spider 2.0 prueban la consulta de bases de datos del mundo real en diferentes entornos. Spider 2.0-Snow utiliza bases de datos de Snowflake con 547 ejemplos de prueba, alcanzando un pico del 59.05% de precisión.

Spider 2.0-Lite abarca BigQuery, Snowflake y SQLite con otros 547 ejemplos, alcanzando solo el 37.84%. Spider 2.0-DBT prueba la generación de código contra DuckDB con 68 ejemplos, alcanzando un máximo del 39.71%.

Esta brecha de rendimiento no es por falta de esfuerzo. Desde noviembre de 2024, 56 presentaciones de 12 familias de modelos han competido en estos benchmarks.

Claude, OpenAI, DeepSeek y otros han empujado sus modelos contra estas pruebas. El progreso ha sido constante, de aproximadamente el 2% a alrededor del 60%, en los últimos nueve meses.

El rompecabezas se profundiza cuando se consideran las limitaciones de SQL. SQL tiene un vocabulario limitado en comparación con el inglés, que tiene 600,000 palabras, o los lenguajes de programación que tienen sintaxis y bibliotecas mucho más amplias. Además, hay mucha SQL disponible para entrenar.

Si acaso, esto debería ser más fácil que las tareas de razonamiento abiertas donde los modelos ahora sobresalen.

Sin embargo, incluso una generación perfecta de SQL no resolvería el verdadero desafío empresarial. Cada empresa define "ingresos" de manera diferente.

El marketing mide el costo de adquisición de clientes por el gasto en campañas, las ventas lo calculan utilizando los costos de los ejecutivos de cuentas, y las finanzas incluyen los gastos de empleados totalmente cargados. Estas diferencias semánticas crean confusión que la precisión técnica no puede resolver.

Los resultados de Spider 2.0 apuntan a una verdad fundamental sobre el trabajo de datos. La competencia técnica en la sintaxis de SQL es solo el punto de entrada.

El verdadero desafío radica en el contexto empresarial. Comprender lo que significa los datos, cómo diferentes equipos definen métricas y cuándo importan los casos extremos. Como escribí en Cultivadores Semánticos, el puente entre los datos en bruto y el significado empresarial requiere un juicio humano que la IA actual no puede replicar.

8,8K

GPT-5 alcanza una precisión del 94.6% en AIME 2025, lo que sugiere un razonamiento matemático casi humano.

Sin embargo, pídale que consulte su base de datos y las tasas de éxito caen a los adolescentes.

Los benchmarks de Spider 2.0 revelan una brecha abismal en las capacidades de la IA. Spider 2.0 es un benchmark integral de texto a SQL que evalúa la capacidad de los modelos de IA para generar consultas SQL precisas a partir de preguntas en lenguaje natural en bases de datos del mundo real.

Mientras que los grandes modelos de lenguaje han conquistado el trabajo del conocimiento en matemáticas, codificación y razonamiento, el texto a SQL sigue siendo obstinadamente difícil.

Los tres benchmarks de Spider 2.0 prueban la consulta de bases de datos del mundo real en diferentes entornos. Spider 2.0-Snow utiliza bases de datos de Snowflake con 547 ejemplos de prueba, alcanzando un pico del 59.05% de precisión.

Spider 2.0-Lite abarca BigQuery, Snowflake y SQLite con otros 547 ejemplos, alcanzando solo el 37.84%. Spider 2.0-DBT prueba la generación de código contra DuckDB con 68 ejemplos, alcanzando un máximo del 39.71%.

Esta brecha de rendimiento no es por falta de esfuerzo. Desde noviembre de 2024, 56 envíos de 12 familias de modelos han competido en estos benchmarks.

Claude, OpenAI, DeepSeek y otros han empujado sus modelos contra estas pruebas. El progreso ha sido constante, de aproximadamente el 2% a alrededor del 60%, en los últimos nueve meses.

El rompecabezas se profundiza cuando se consideran las limitaciones de SQL. SQL tiene un vocabulario limitado en comparación con el inglés, que tiene 600,000 palabras, o los lenguajes de programación que tienen sintaxis y bibliotecas mucho más amplias. Además, hay mucha SQL disponible para entrenar.

Si acaso, esto debería ser más fácil que las tareas de razonamiento abiertas donde los modelos ahora sobresalen.

Sin embargo, incluso una generación perfecta de SQL no resolvería el verdadero desafío empresarial. Cada empresa define "ingresos" de manera diferente.

El marketing mide el costo de adquisición de clientes por el gasto en campañas, las ventas lo calculan utilizando los costos de los ejecutivos de cuentas, y las finanzas incluyen los gastos de empleados totalmente cargados. Estas diferencias semánticas crean confusión que la precisión técnica no puede resolver.

Los resultados de Spider 2.0 apuntan a una verdad fundamental sobre el trabajo de datos. La competencia técnica en la sintaxis de SQL es solo el punto de entrada.

El verdadero desafío radica en el contexto empresarial. Entender lo que significa los datos, cómo diferentes equipos definen métricas y cuándo importan los casos extremos. Como escribí en Cultivadores Semánticos, el puente entre los datos en bruto y el significado empresarial requiere un juicio humano que la IA actual no puede replicar.

3,95K

Perplexity AI acaba de hacer una oferta no solicitada de 34.5 mil millones de dólares por el navegador Chrome de Google, intentando capitalizar la inminente decisión antimonopolio que podría obligar a Google a desinvertir su negocio de navegadores.

Comparar la economía de Chrome con el acuerdo existente de Google con Safari revela por qué 34.5 mil millones de dólares subestiman el navegador.

Google paga a Apple entre 18 y 20 mil millones de dólares anuales para seguir siendo el motor de búsqueda predeterminado de Safari¹, sirviendo aproximadamente a 850 millones de usuarios². Esto se traduce en 21 dólares por usuario al año.

La oferta de Perplexity valora a Chrome en 32 mil millones de dólares, lo que equivale a 9 dólares por usuario al año para sus 3.5 mil millones de usuarios³.

Si los usuarios de Chrome exigieran los mismos términos que el acuerdo Google/Apple de Safari, el potencial de ingresos anuales del navegador superaría los 73 mil millones de dólares.

Estos datos se basan en estimaciones públicas, pero son una aproximación.

Esto asume que Google pagaría a un nuevo propietario de Chrome una tarifa escalonada similar por la colocación de búsqueda predeterminada. Dado un múltiplo de capitalización de mercado a ingresos de 5x a 6x, Chrome vale entre 172 mil millones y 630 mil millones de dólares, muy lejos de la oferta de 34.5 mil millones.

Chrome domina el mercado con un 65% de participación⁴, en comparación con el 18% de Safari. Una desinversión sacudiría el mercado de anuncios de búsqueda. El valor de mantener los presupuestos publicitarios es difícil de sobrestimar para la capitalización de mercado y la posición de Google en el ecosistema publicitario.

Si se viera obligado a vender Chrome, Google enfrentaría una elección existencial. Pagar lo que sea necesario para seguir siendo el motor de búsqueda predeterminado, o ver cómo los competidores convierten su canal de distribución más valioso en un arma en su contra.

¿Cuánto vale eso? Un premio significativo a un simple múltiplo de ingresos.

¹ Bloomberg: Los pagos de Google a Apple alcanzaron los 20 mil millones de dólares en 2022 (

² ZipDo: Estadísticas esenciales de Apple Safari en 2024 (

³ Backlinko: Participación de mercado de navegadores web en 2025 (

⁴ Statcounter: Participación de mercado de navegadores en todo el mundo (

7,97K

En 1999, las empresas de internet se valoraban en función del tráfico. Las métricas de las OPI giraban en torno a las visitas.

Luego, Google lanzó AdWords, un modelo publicitario basado en clics, y construyó un negocio de 273 mil millones de dólares en 2024.

Pero todo eso podría estar a punto de cambiar: el estudio de Pew Research de julio de 2025 revela que los usuarios hacen clic en solo el 8% de los resultados de búsqueda con resúmenes de IA, frente al 15% sin ellos, lo que representa una reducción del 47%. Solo el 1% hace clic desde dentro de los resúmenes de IA.

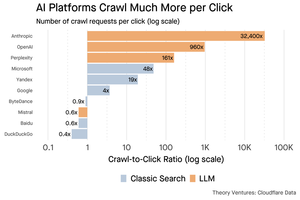

Los datos de Cloudflare muestran que las plataformas de IA rastrean contenido mucho más de lo que refieren tráfico: Anthropic rastrea 32,400 páginas por cada 1 referencia, mientras que los motores de búsqueda tradicionales escanean contenido solo un par de veces por visitante enviado.

El costo de servir contenido a los rastreadores de IA puede no ser enorme si se trata principalmente de texto.

El punto más importante es que los sistemas de IA desintermedian la relación entre el usuario y el editor. Los usuarios prefieren respuestas agregadas de IA en lugar de hacer clic en sitios web para encontrar sus respuestas.

Es lógico que la mayoría de los sitios web deberían esperar menos tráfico. ¿Cómo manejará su sitio web y su negocio esta situación?

Fuentes:

- Pew Research Center - Athena Chapekis, 22 de julio de 2025 (

- Cloudflare: El rastreo antes de la caída de las referencias (

- Cloudflare Radar: Perspectivas de IA - Relación de rastreo a referencia (

- Podcast: El valor cambiante del contenido en la era de la IA (

9,69K

GPT-5 se lanzó ayer. 94.6% en AIME 2025. 74.9% en SWE-bench.

A medida que nos acercamos a los límites superiores de estos benchmarks, mueren.

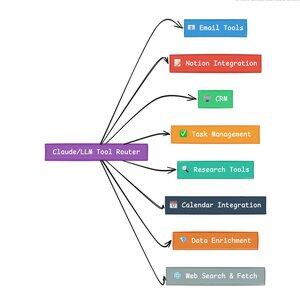

Lo que hace que GPT-5 y la próxima generación de modelos sean revolucionarios no es su conocimiento. Es saber cómo actuar. Para GPT-5, esto ocurre en dos niveles. Primero, decidir qué modelo usar. Pero segundo, y más importante, a través de la llamada a herramientas.

Hemos estado viviendo en una era donde los LLMs dominaron la recuperación y reensamblaje de conocimiento. La búsqueda de consumidores y la codificación, las aplicaciones iniciales más impactantes, son fundamentalmente desafíos de recuperación de conocimiento. Ambos organizan la información existente de nuevas maneras.

Hemos escalado esas colinas y, como resultado, la competencia es más intensa que nunca. Los modelos de Anthropic, OpenAI y Google están convergiendo en capacidades similares. Los modelos chinos y las alternativas de código abierto continúan acercándose cada vez más al estado del arte. Todos pueden recuperar información. Todos pueden generar texto.

¿El nuevo eje de competencia? La llamada a herramientas.

La llamada a herramientas transforma los LLMs de asesores a actores. Compensa dos debilidades críticas del modelo que los modelos de lenguaje puro no pueden superar.

Primero, la orquestación del flujo de trabajo. Los modelos sobresalen en respuestas de un solo intento, pero luchan con procesos multi-paso y con estado. Las herramientas les permiten gestionar flujos de trabajo largos, rastrear el progreso, manejar errores y mantener el contexto a través de docenas de operaciones.

Segundo, la integración del sistema. Los LLMs viven en un mundo solo de texto. Las herramientas les permiten interactuar de manera predecible con sistemas externos como bases de datos, APIs y software empresarial, convirtiendo el lenguaje natural en acciones ejecutables.

En el último mes he construido 58 herramientas de IA diferentes.

Procesadores de correo electrónico. Integradores de CRM. Actualizadores de Notion. Asistentes de investigación. Cada herramienta extiende las capacidades del modelo a un nuevo dominio.

La capacidad más importante para la IA es seleccionar la herramienta adecuada de manera rápida y correcta. Cada paso mal dirigido mata todo el flujo de trabajo.

Cuando digo “lee este correo electrónico de Y Combinator y encuentra todas las startups que no están en el CRM”, los LLMs modernos ejecutan una secuencia compleja.

Un comando en inglés reemplaza un flujo de trabajo completo. Y este es solo uno simple.

Aún mejor, el modelo, correctamente configurado con las herramientas adecuadas, puede verificar su propio trabajo de que las tareas se completaron a tiempo. Este bucle de auto-verificación crea fiabilidad en los flujos de trabajo que es difícil de lograr de otra manera.

Multiplica esto a través de cientos de empleados. Miles de flujos de trabajo. Las ganancias de productividad se acumulan exponencialmente.

Los ganadores en el futuro mundo de la IA serán aquellos que sean más sofisticados en orquestar herramientas y dirigir las consultas correctas. Cada vez. Una vez que esos flujos de trabajo sean predecibles, es cuando todos nos convertiremos en gestores de agentes.

3,17K

2025 es el año de los agentes, y la capacidad clave de los agentes es llamar herramientas.

Al usar Claude Code, puedo decirle a la IA que revise un boletín, encuentre todos los enlaces a startups, verifique que existan en nuestro CRM, con un solo comando. Esto puede implicar que se llamen dos o tres herramientas diferentes.

Pero aquí está el problema: usar un modelo de base grande para esto es costoso, a menudo tiene limitaciones de tasa y está sobredimensionado para una tarea de selección.

¿Cuál es la mejor manera de construir un sistema agente con llamadas a herramientas?

La respuesta radica en modelos de acción pequeños. NVIDIA publicó un artículo convincente argumentando que “Los modelos de lenguaje pequeños (SLMs) son suficientemente poderosos, inherentemente más adecuados y necesariamente más económicos para muchas invocaciones en sistemas agentes.”

He estado probando diferentes modelos locales para validar un ejercicio de reducción de costos. Comencé con un modelo de 30b parámetros Qwen3:30b, que funciona pero puede ser bastante lento porque es un modelo tan grande, aunque solo 3 mil millones de esos 30 mil millones de parámetros están activos en un momento dado.

El artículo de NVIDIA recomienda el modelo Salesforce xLAM: una arquitectura diferente llamada modelo de acción grande diseñado específicamente para la selección de herramientas.

Así que realicé una prueba propia, cada modelo llamando a una herramienta para listar mis tareas de Asana.

Los resultados fueron sorprendentes: xLAM completó las tareas en 2.61 segundos con un 100% de éxito, mientras que Qwen tardó 9.82 segundos con un 92% de éxito, casi cuatro veces más.

Este experimento muestra la ganancia de velocidad, pero hay un compromiso: cuánta inteligencia debe residir en el modelo frente a las herramientas mismas. Esto es limitado.

Con modelos más grandes como Qwen, las herramientas pueden ser más simples porque el modelo tiene mejor tolerancia a errores y puede trabajar alrededor de interfaces mal diseñadas. El modelo compensa las limitaciones de las herramientas mediante razonamiento de fuerza bruta.

Con modelos más pequeños, el modelo tiene menos capacidad para recuperarse de errores, por lo que las herramientas deben ser más robustas y la lógica de selección más precisa. Esto puede parecer una limitación, pero en realidad es una característica.

Esta restricción elimina la tasa de error acumulativa de las herramientas encadenadas de LLM. Cuando los modelos grandes hacen llamadas secuenciales a herramientas, los errores se acumulan exponencialmente.

Los modelos de acción pequeños obligan a un mejor diseño del sistema, manteniendo lo mejor de los LLM y combinándolo con modelos especializados.

Esta arquitectura es más eficiente, más rápida y más predecible.

5,3K

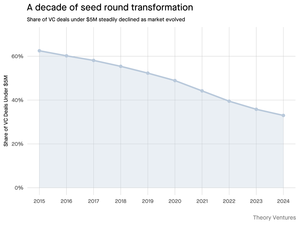

¿Por qué está disminuyendo la ronda de financiación semilla de menos de 5 millones de dólares?

Hace una década, estas rondas más pequeñas formaban la columna vertebral de la financiación de startups, representando más del 70% de todos los acuerdos semilla. Hoy, los datos de PitchBook revelan que esa cifra ha caído a menos de la mitad.

Los números cuentan una historia contundente. Los acuerdos de menos de 5 millones de dólares disminuyeron del 62.5% en 2015 al 37.5% en 2024. Esta caída de 29.5 puntos porcentuales ha transformado fundamentalmente la forma en que las startups recaudan su primer capital institucional.

Tres fuerzas impulsaron esta transformación. Podemos descomponer la disminución para entender qué redujo la pequeña ronda semilla y por qué es importante para los fundadores hoy.

4,7K

¡Esto fue muy divertido, Mario! Gracias por invitarme al programa para hablar sobre todo lo que está sucediendo en el mercado.

Mario Gabriele 🦊22 jul 2025

¡Nuestro último episodio con Tomasz Tunguz ya está disponible!

La Década de los Datos

@ttunguz ha pasado casi dos décadas convirtiendo datos en ideas de inversión. Después de respaldar a Looker, Expensify y Monte Carlo en Redpoint Ventures, lanzó @Theoryvc en 2022 con una visión audaz: construir una "corporación de inversión" donde investigadores, ingenieros y operadores se sientan junto a inversores, creando mapas de mercado en tiempo real y herramientas de IA internas. Su fondo debut cerró en 238 millones de dólares, seguido solo 19 meses después por un segundo fondo de 450 millones de dólares. Centrado en datos, IA e infraestructura cripto, Theory opera en el corazón de los cambios tecnológicos más significativos de hoy. Exploramos cómo los datos están remodelando el capital de riesgo, por qué los modelos de inversión tradicionales están siendo interrumpidos y qué se necesita para construir una firma que no solo prediga el futuro, sino que también ayude a crearlo activamente.

Escucha ahora:

• YouTube:

• Spotify:

• Apple:

Un gran agradecimiento a los increíbles patrocinadores que hacen posible el podcast:

✨ Brex — La solución bancaria para startups:

✨ Generalist+ — Inteligencia esencial para inversores y tecnólogos modernos:

Exploramos:

→ Cómo funciona el modelo de "corporación de inversión" de Theory

→ Por qué los intercambios de cripto podrían crear un camino viable hacia los mercados públicos para empresas de software de pequeña capitalización

→ La inminente crisis de energía: por qué los centros de datos podrían consumir el 15% de la electricidad de EE. UU. en cinco años

→ El rápido ascenso de las stablecoins a medida que los grandes bancos canalizan el 5-10% de los dólares estadounidenses a través de ellas

→ Por qué Ethereum enfrenta un desafío existencial similar a AWS perdiendo terreno frente a Azure en la era de la IA

→ Por qué Tomasz cree que el puñado de agentes de hoy se convertirá en más de 100 co-trabajadores digitales para fin de año

→ Por qué Meta está apostando miles de millones en gafas de AR para cambiar cómo interactuamos con las máquinas

→ Cómo Theory Ventures utiliza IA para acelerar la investigación de mercado, el análisis de acuerdos y las decisiones de inversión

…¡Y mucho más!

8,01K

OpenAI recibe, en promedio, 1 consulta por estadounidense al día.

Google recibe alrededor de 4 consultas por estadounidense al día.

Desde entonces, el 50% de las consultas de búsqueda de Google tienen Resúmenes de IA, lo que significa que al menos el 60% de las búsquedas en EE. UU. son ahora de IA.

Ha tardado un poco más de lo que esperaba que esto sucediera. En 2024, predije que el 50% de las búsquedas de los consumidores estarían habilitadas por IA. (

Pero la IA ha llegado a la búsqueda.

Si los patrones de búsqueda de Google son un indicativo, hay una ley de potencia en el comportamiento de búsqueda. El análisis de SparkToro sobre el comportamiento de búsqueda en Google muestra que el tercio superior de los estadounidenses que buscan ejecutan más del 80% de todas las búsquedas, lo que significa que el uso de IA no es probablemente uniforme, como el futuro.

Los sitios web y las empresas están comenzando a sentir los impactos de esto. El artículo de The Economist "La IA está matando la web. ¿Puede salvarse algo?" captura el zeitgeist en un titular. (

Una supermayoría de estadounidenses ahora busca con IA. Los efectos de segundo orden de los patrones de búsqueda cambiantes llegarán en la segunda mitad de este año y más personas preguntarán, "¿Qué pasó con mi tráfico?" (

La IA es un nuevo canal de distribución y aquellos que lo aprovechen ganarán cuota de mercado.

- ¡William Gibson vio mucho más lejos en el futuro!

- Esto se basa en un análisis de punto medio del gráfico de SparkToro, es un análisis muy simple y tiene algún error como resultado.

8,88K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado