Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 mencapai akurasi 94,6% pada AIME 2025, menunjukkan penalaran matematis yang mendekati manusia.

Namun minta untuk menanyakan database Anda, dan tingkat keberhasilan anjlok ke remaja.

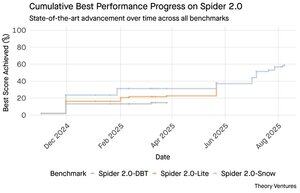

Tolok ukur Spider 2.0 mengungkapkan kesenjangan yang menguap dalam kemampuan AI. Spider 2.0 adalah tolok ukur teks-ke-SQL komprehensif yang menguji kemampuan model AI untuk menghasilkan kueri SQL yang akurat dari pertanyaan bahasa alami di seluruh database dunia nyata.

Sementara model bahasa besar telah menaklukkan pekerjaan pengetahuan dalam matematika, pengkodean, dan penalaran, text-to-SQL tetap sulit secara keras kepala.

Tiga tolok ukur Spider 2.0 menguji kueri database dunia nyata di berbagai lingkungan. Spider 2.0-Snow menggunakan database Snowflake dengan 547 contoh pengujian, memuncak pada akurasi 59,05%.

Spider 2.0-Lite mencakup BigQuery, Snowflake, dan SQLite dengan 547 contoh lainnya, hanya mencapai 37,84%. Spider 2.0-DBT menguji pembuatan kode terhadap DuckDB dengan 68 contoh, mencapai 39,71%.

Kesenjangan kinerja ini bukan karena kurang mencoba. Sejak November 2024, 56 pengajuan dari 12 keluarga model telah bersaing dalam tolok ukur ini.

Claude, OpenAI, DeepSeek, dan lainnya semuanya telah mendorong model mereka melawan pengujian ini. Kemajuan telah stabil, dari sekitar 2% menjadi sekitar 60%, dalam sembilan bulan terakhir.

Teka-teki semakin dalam ketika Anda mempertimbangkan batasan SQL. SQL memiliki kosakata yang terbatas dibandingkan dengan bahasa Inggris, yang memiliki 600.000 kata, atau bahasa pemrograman yang memiliki sintaks dan pustaka yang jauh lebih luas untuk diketahui. Ditambah lagi, ada banyak SQL di luar sana untuk dilatih.

Jika ada, ini seharusnya lebih mudah daripada tugas penalaran terbuka di mana model sekarang unggul.

Namun bahkan generasi SQL yang sempurna tidak akan menyelesaikan tantangan bisnis yang sebenarnya. Setiap perusahaan mendefinisikan "pendapatan" secara berbeda.

Pemasaran mengukur biaya akuisisi pelanggan berdasarkan pengeluaran kampanye, penjualan menghitungnya menggunakan biaya eksekutif akun, dan keuangan mencakup pengeluaran karyawan yang termuat penuh. Perbedaan semantik ini menciptakan kebingungan yang tidak dapat diselesaikan oleh akurasi teknis.

Hasil Spider 2.0 menunjukkan kebenaran mendasar tentang pekerjaan data. Kemahiran teknis dalam sintaks SQL hanyalah titik masuk.

Tantangan sebenarnya terletak pada konteks bisnis. Memahami arti data, bagaimana tim yang berbeda mendefinisikan metrik, dan kapan kasus edge penting. Seperti yang saya tulis di Semantic Cultivators, jembatan antara data mentah dan makna bisnis membutuhkan penilaian manusia yang tidak dapat ditiru oleh AI saat ini.

8,78K

GPT-5 mencapai akurasi 94,6% pada AIME 2025, menunjukkan penalaran matematis yang mendekati manusia.

Namun minta untuk menanyakan database Anda, dan tingkat keberhasilan anjlok ke remaja.

Tolok ukur Spider 2.0 mengungkapkan kesenjangan yang menguap dalam kemampuan AI. Spider 2.0 adalah tolok ukur teks-ke-SQL komprehensif yang menguji kemampuan model AI untuk menghasilkan kueri SQL yang akurat dari pertanyaan bahasa alami di seluruh database dunia nyata.

Sementara model bahasa besar telah menaklukkan pekerjaan pengetahuan dalam matematika, pengkodean, dan penalaran, text-to-SQL tetap sulit secara keras kepala.

Tiga tolok ukur Spider 2.0 menguji kueri database dunia nyata di berbagai lingkungan. Spider 2.0-Snow menggunakan database Snowflake dengan 547 contoh pengujian, memuncak pada akurasi 59,05%.

Spider 2.0-Lite mencakup BigQuery, Snowflake, dan SQLite dengan 547 contoh lainnya, hanya mencapai 37,84%. Spider 2.0-DBT menguji pembuatan kode terhadap DuckDB dengan 68 contoh, mencapai 39,71%.

Kesenjangan kinerja ini bukan karena kurang mencoba. Sejak November 2024, 56 pengajuan dari 12 keluarga model telah bersaing dalam tolok ukur ini.

Claude, OpenAI, DeepSeek, dan lainnya semuanya telah mendorong model mereka melawan pengujian ini. Kemajuan telah stabil, dari sekitar 2% menjadi sekitar 60%, dalam sembilan bulan terakhir.

Teka-teki semakin dalam ketika Anda mempertimbangkan batasan SQL. SQL memiliki kosakata yang terbatas dibandingkan dengan bahasa Inggris, yang memiliki 600.000 kata, atau bahasa pemrograman yang memiliki sintaks dan pustaka yang jauh lebih luas untuk diketahui. Ditambah lagi, ada banyak SQL di luar sana untuk dilatih.

Jika ada, ini seharusnya lebih mudah daripada tugas penalaran terbuka di mana model sekarang unggul.

Namun bahkan generasi SQL yang sempurna tidak akan menyelesaikan tantangan bisnis yang sebenarnya. Setiap perusahaan mendefinisikan "pendapatan" secara berbeda.

Pemasaran mengukur biaya akuisisi pelanggan berdasarkan pengeluaran kampanye, penjualan menghitungnya menggunakan biaya eksekutif akun, dan keuangan mencakup pengeluaran karyawan yang termuat penuh. Perbedaan semantik ini menciptakan kebingungan yang tidak dapat diselesaikan oleh akurasi teknis.

Hasil Spider 2.0 menunjukkan kebenaran mendasar tentang pekerjaan data. Kemahiran teknis dalam sintaks SQL hanyalah titik masuk.

Tantangan sebenarnya terletak pada konteks bisnis. Memahami arti data, bagaimana tim yang berbeda mendefinisikan metrik, dan kapan kasus edge penting. Seperti yang saya tulis di Semantic Cultivators, jembatan antara data mentah dan makna bisnis membutuhkan penilaian manusia yang tidak dapat ditiru oleh AI saat ini.

3,93K

Perplexity AI baru saja membuat penawaran tak diminta senilai $34,5 miliar untuk browser Google Chrome, mencoba memanfaatkan putusan antimonopoli yang tertunda yang dapat memaksa Google untuk mendivestasi bisnis browsernya.

Membandingkan ekonomi Chrome dengan kesepakatan Safari Google yang ada mengungkapkan mengapa $ 34,5 miliar meremehkan browser.

Google membayar Apple $18-20 miliar per tahun untuk tetap menjadi mesin pencari default Safari¹, melayani sekitar 850 juta pengguna². Ini berarti $21 per pengguna per tahun.

Penawaran Perplexity menghargai Chrome sebesar $32 miliar, yaitu $9 per pengguna per tahun untuk 3,5 miliar penggunanya³.

Jika pengguna Chrome memerintahkan persyaratan yang sama dengan kesepakatan Google/Apple Safari, potensi pendapatan tahunan browser akan melebihi $73 miliar.

Data ini didasarkan pada perkiraan publik tetapi merupakan perkiraan.

Ini mengasumsikan bahwa Google akan membayar pemilik baru Chrome dengan biaya skala yang sama untuk penempatan penelusuran default. Mengingat kelipatan kapitalisasi pasar hingga pendapatan 5x hingga 6x, Chrome bernilai antara $172 miliar dan $630 miliar, jauh dari penawaran $34,5 miliar.

Chrome mendominasi pasar dengan pangsa 65%, dibandingkan dengan Safari 18%. Divestasi akan membuat pasar iklan pencarian menjadi gelisah. Nilai menjaga anggaran pengiklan sulit untuk dilebih-lebihkan untuk kapitalisasi pasar Google & posisi dalam ekosistem iklan.

Jika dipaksa untuk menjual Chrome, Google akan menghadapi pilihan eksistensial. Bayar apa pun yang diperlukan untuk tetap menjadi mesin pencari default, atau saksikan pesaing mengubah saluran distribusinya yang paling berharga menjadi pencungkil melawannya.

Berapa nilainya? Premi yang signifikan untuk kelipatan pendapatan sederhana.

¹ Bloomberg: Pembayaran Google ke Apple mencapai $20 miliar pada tahun 2022 (

² ZipDo: Statistik Apple Safari Penting Pada Tahun 2024 (

³ Backlinko: Pangsa Pasar Browser Web Pada Tahun 2025 (

⁴ Statcounter: Pangsa Pasar Browser di Seluruh Dunia (

7,95K

Pada tahun 1999, dotcom dihargai pada lalu lintas. Metrik IPO berkisar pada bola mata.

Kemudian Google meluncurkan AdWords, model iklan yang didasarkan pada klik, & membangun bisnis $273 miliar pada tahun 2024.

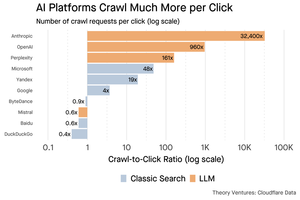

Tapi itu semua mungkin akan berubah : Studi Pew Research Juli 2025 mengungkapkan pengguna hanya mengklik 8% hasil pencarian dengan ringkasan AI, versus 15% tanpa - pengurangan 47%. Hanya 1% mengklik dari dalam ringkasan AI.

Data Cloudflare menunjukkan platform AI merangkak konten jauh lebih banyak daripada mereka merujuk lalu lintas kembali: Anthropic merayapi 32.400 halaman untuk setiap 1 rujukan, sementara mesin pencari tradisional memindai konten hanya beberapa kali per pengunjung yang dikirim.

Biaya penyajian konten ke perayap AI mungkin tidak besar jika sebagian besar teks.

Poin yang lebih besar adalah sistem AI memisahkan hubungan pengguna & penerbit. Pengguna lebih memilih jawaban AI agregat daripada mengklik situs web untuk menemukan jawaban mereka.

Masuk akal bahwa sebagian besar situs web harus mengharapkan lalu lintas yang lebih sedikit. Bagaimana situs web Anda & bisnis Anda akan menanganinya?

Sumber:

- Pusat Penelitian Pew - Athena Chapekis, 22 Juli 2025 (

- Cloudflare: Perayapan sebelum jatuhnya rujukan (

- Cloudflare Radar: AI Insights - Rasio Crawl to Refer (

- Podcast: Pergeseran Nilai Konten di Era AI (

9,67K

GPT-5 diluncurkan kemarin. 94.6% pada AIME 2025. 74,9% di bangku SWE.

Saat kita mendekati batas atas tolok ukur ini, mereka mati.

Apa yang membuat GPT-5 dan model generasi berikutnya revolusioner bukanlah pengetahuan mereka. Itu mengetahui bagaimana bertindak. Untuk GPT-5 ini terjadi pada dua tingkatan. Pertama, memutuskan model mana yang akan digunakan. Tapi kedua, dan yang lebih penting, melalui panggilan alat.

Kita telah hidup di era di mana LLM menguasai pengambilan pengetahuan & perakitan kembali. Pencarian & pengkodean konsumen, aplikasi pembunuh awal, pada dasarnya adalah tantangan pengambilan pengetahuan. Keduanya mengatur informasi yang ada dengan cara baru.

Kami telah mendaki bukit-bukit itu dan sebagai hasilnya persaingan lebih ketat dari sebelumnya. Model Anthropic, OpenAI, dan Google menyatu pada kemampuan serupa. Model Tiongkok dan alternatif open source terus mendorong semakin dekat ke canggih. Semua orang dapat mengambil informasi. Semua orang dapat membuat teks.

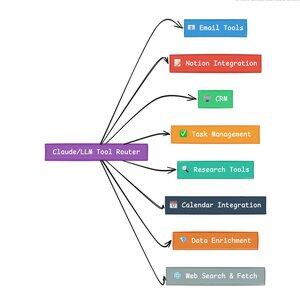

Poros persaingan baru? Pemanggilan alat.

Pemanggilan alat mengubah LLM dari penasihat menjadi aktor. Ini mengkompensasi dua kelemahan model kritis yang tidak dapat diatasi oleh model bahasa murni.

Pertama, orkestrasi alur kerja. Model unggul dalam respons satu bidikan tetapi berjuang dengan proses multi-langkah dan stateful. Alat memungkinkan mereka untuk mengelola alur kerja yang panjang, melacak kemajuan, menangani kesalahan, mempertahankan konteks di lusinan operasi.

Kedua, integrasi sistem. LLM hidup di dunia hanya teks. Alat memungkinkan mereka berinteraksi secara prediksi dengan sistem eksternal seperti database, API, dan perangkat lunak perusahaan, mengubah bahasa alami menjadi tindakan yang dapat dieksekusi.

Dalam sebulan terakhir saya telah membangun 58 alat AI yang berbeda.

Prosesor email. Integrator CRM. Pembaruan gagasan. Asisten peneliti. Setiap alat memperluas kemampuan model ke domain baru.

Kemampuan terpenting untuk AI adalah memilih alat yang tepat dengan cepat dan benar. Setiap langkah yang salah rute membunuh seluruh alur kerja.

Ketika saya mengatakan "baca email ini dari Y Combinator & temukan semua startup yang tidak ada di CRM," LLM modern mengeksekusi urutan yang kompleks.

Satu perintah dalam bahasa Inggris menggantikan seluruh alur kerja. Dan ini hanya yang sederhana.

Lebih baik lagi, model, diatur dengan benar dengan alat yang tepat, dapat memverifikasi pekerjaannya sendiri bahwa tugas diselesaikan tepat waktu. Perulangan verifikasi mandiri ini menciptakan keandalan dalam alur kerja yang sulit dicapai sebaliknya.

Kalikan ini di ratusan karyawan. Ribuan alur kerja. Peningkatan produktivitas bertambah secara eksponensial.

Pemenang di dunia AI masa depan adalah orang-orang yang paling canggih dalam mengatur alat dan merutekan kueri yang tepat. Setiap saat. Setelah alur kerja tersebut dapat diprediksi, saat itulah kita semua akan menjadi manajer agen.

3,15K

2025 adalah tahun agen, & kemampuan utama agen adalah alat panggilan.

Saat menggunakan Claude Code, saya dapat memberi tahu AI untuk menyaring buletin, menemukan semua tautan ke startup, memverifikasi keberadaannya di CRM kami, dengan satu perintah. Ini mungkin melibatkan dua atau tiga alat berbeda yang dipanggil.

Tapi inilah masalahnya: menggunakan model fondasi besar untuk ini mahal, seringkali tarif terbatas, & terlalu kuat untuk tugas seleksi.

Apa cara terbaik untuk membangun sistem agen dengan panggilan alat?

Jawabannya terletak pada model aksi kecil. NVIDIA merilis makalah yang menarik yang berpendapat bahwa "Model bahasa kecil (SLM) cukup kuat, secara inheren lebih cocok, dan tentu saja lebih ekonomis untuk banyak pemanggilan dalam sistem agen."

Saya telah menguji model lokal yang berbeda untuk memvalidasi latihan pengurangan biaya. Saya mulai dengan model parameter Qwen3:30b, yang berfungsi tetapi bisa sangat lambat karena ini adalah model yang sangat besar, meskipun hanya 3 miliar dari 30 miliar parameter tersebut yang aktif pada satu waktu.

Makalah NVIDIA merekomendasikan model Salesforce xLAM – arsitektur berbeda yang disebut model aksi besar yang dirancang khusus untuk pemilihan alat.

Jadi, saya menjalankan pengujian saya sendiri, setiap model memanggil alat untuk mencantumkan tugas Asana saya.

Hasilnya sangat mengejutkan: xLAM menyelesaikan tugas dalam 2,61 detik dengan keberhasilan 100%, sementara Qwen membutuhkan 9,82 detik dengan keberhasilan 92% – hampir empat kali lebih lama.

Eksperimen ini menunjukkan perolehan kecepatan, tetapi ada trade-off: berapa banyak kecerdasan yang harus hidup dalam model versus dalam alat itu sendiri. Ini terbatas

Dengan model yang lebih besar seperti Qwen, alat bisa lebih sederhana karena model memiliki toleransi kesalahan yang lebih baik & dapat bekerja di sekitar antarmuka yang dirancang dengan buruk. Model ini mengkompensasi keterbatasan alat melalui penalaran brute-force.

Dengan model yang lebih kecil, model memiliki kapasitas yang lebih kecil untuk pulih dari kesalahan, sehingga alat harus lebih kuat & logika pemilihan lebih tepat. Ini mungkin tampak seperti batasan, tetapi sebenarnya ini adalah fitur.

Kendala ini menghilangkan tingkat kesalahan peracikan alat berantai LLM. Ketika model besar melakukan panggilan alat berurutan, kesalahan terakumulasi secara eksponensial.

Model aksi kecil memaksa desain sistem yang lebih baik, menjaga yang terbaik dari LLM dan menggabungkannya dengan model khusus.

Arsitektur ini lebih efisien, lebih cepat, dan lebih dapat diprediksi.

5,28K

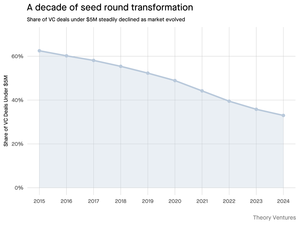

Mengapa putaran unggulan di bawah $5 juta menyusut?

Satu dekade yang lalu, putaran yang lebih kecil ini membentuk tulang punggung pembiayaan startup, yang terdiri dari lebih dari 70% dari semua kesepakatan awal. Hari ini, data PitchBook mengungkapkan angka itu telah anjlok menjadi kurang dari setengahnya.

Angka-angka itu menceritakan kisah yang mencolok. Kesepakatan di bawah $5 juta turun dari 62,5% pada 2015 menjadi 37,5% pada 2024. Penurunan 29,5 poin persentase ini secara fundamental membentuk kembali cara startup meningkatkan modal institusional pertama mereka.

Tiga kekuatan mendorong transformasi ini. Kita dapat menguraikan penurunan untuk memahami apa yang mengurangi putaran benih kecil & mengapa itu penting bagi para pendiri saat ini.

4,68K

Ini sangat menyenangkan, Mario. Terima kasih telah menghadirkan saya di acara ini untuk berbicara tentang semua yang terjadi di pasar!

Mario Gabriele 🦊22 Jul 2025

Episode terbaru kami dengan Tomasz Tunguz sudah tayang!

Dekade Data

@ttunguz telah menghabiskan hampir dua dekade mengubah data menjadi wawasan investasi. Setelah mendukung Looker, Expensify, dan Monte Carlo di Redpoint Ventures, ia meluncurkan @Theoryvc pada tahun 2022 dengan visi yang berani: membangun "perusahaan investasi" di mana peneliti, insinyur, dan operator duduk bersama investor, membuat peta pasar real-time dan perkakas AI internal. Dana debutnya ditutup pada $ 238 juta, diikuti hanya 19 bulan kemudian oleh dana kedua $ 450 juta. Berpusat pada data, AI, dan infrastruktur kripto, Theory beroperasi di jantung pergeseran teknologi yang paling konsekuensial saat ini. Kami mengeksplorasi bagaimana data membentuk kembali modal ventura, mengapa model investasi tradisional terganggu, dan apa yang diperlukan untuk membangun perusahaan yang tidak hanya memprediksi masa depan tetapi secara aktif membantu menciptakannya.

Dengarkan sekarang:

• YouTube:

• Spotify:

•Apel:

Terima kasih banyak kepada sponsor luar biasa yang memungkinkan podcast:

✨ Brex — Solusi perbankan untuk startup:

✨ Generalist+ — Intelijen penting untuk investor dan teknolog modern:

Kami mengeksplorasi:

→ Cara kerja model "perusahaan investasi" Theory

→ Mengapa pertukaran kripto dapat menciptakan jalur yang layak ke pasar publik untuk perusahaan perangkat lunak berkapitalisasi kecil

→ Krisis listrik yang membayangi—mengapa pusat data dapat mengkonsumsi 15% listrik AS dalam waktu lima tahun

→ Kenaikan pesat Stablecoin karena bank-bank besar mengarahkan 5-10% dolar AS melalui mereka

→ Mengapa Ethereum menghadapi tantangan eksistensial yang mirip dengan AWS yang kehilangan pijakan dari Azure di era AI

→ Mengapa Tomasz percaya segelintir agen saat ini akan menjadi 100+ rekan kerja digital pada akhir tahun

→ Mengapa Meta bertaruh miliaran pada kacamata AR untuk mengubah cara kita berinteraksi dengan mesin

→ Bagaimana Theory Ventures menggunakan AI untuk mempercepat riset pasar, analisis kesepakatan, dan keputusan investasi

… Dan banyak lagi!

7,99K

OpenAI menerima rata-rata 1 kueri per orang Amerika per hari.

Google menerima sekitar 4 kueri per orang Amerika per hari.

Sejak itu 50% kueri pencarian Google memiliki Ikhtisar AI, ini berarti setidaknya 60% pencarian AS sekarang adalah AI.

Butuh waktu sedikit lebih lama dari yang saya harapkan untuk ini terjadi. Pada tahun 2024, saya memperkirakan bahwa 50% pencarian konsumen akan diaktifkan AI. (

Tapi AI telah tiba dalam pencarian.

Jika pola penelusuran Google adalah indikasi, ada undang-undang kekuasaan dalam perilaku penelusuran. Analisis SparkToro tentang perilaku pencarian Google menunjukkan sepertiga teratas orang Amerika yang mencari melakukan lebih dari 80% dari semua pencarian - yang berarti penggunaan AI kemungkinan tidak terdistribusi secara merata - seperti masa depan.

Situs web & bisnis mulai merasakan dampak dari hal ini. Artikel The Economist "AI membunuh web. Ada yang bisa menyelamatkannya?" menangkap zeitgeist dalam sebuah tajuk utama. (

Mayoritas orang Amerika sekarang mencari dengan AI. Efek tingkat kedua dari perubahan pola pencarian akan datang pada paruh kedua tahun ini dan lebih banyak lagi yang akan bertanya, "Apa yang Terjadi dengan Lalu Lintas Saya?" (

AI adalah saluran distribusi baru & mereka yang mengambilnya akan mendapatkan pangsa pasar.

- William Gibson melihat lebih jauh ke masa depan!

- Ini didasarkan pada analisis titik tengah grafik SparkToro, adalah analisis yang sangat sederhana, & memiliki beberapa kesalahan sebagai hasilnya.

8,86K

Teratas

Peringkat

Favorit

Trending onchain

Trending di X

Pendanaan teratas terbaru

Paling terkenal