热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Tomasz Tunguz

GPT-5 在 AIME 2025 上达到了 94.6% 的准确率,表明其数学推理接近人类水平。

然而,当要求它查询你的数据库时,成功率骤降至十几%。

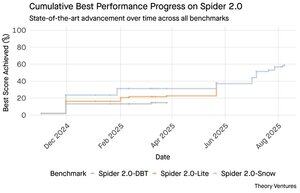

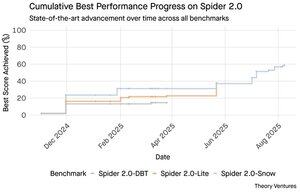

Spider 2.0 基准测试揭示了 AI 能力之间的巨大差距。Spider 2.0 是一个全面的文本到 SQL 基准,测试 AI 模型从自然语言问题生成准确 SQL 查询的能力,涵盖真实世界的数据库。

虽然大型语言模型在数学、编码和推理的知识工作中取得了成功,但文本到 SQL 仍然顽固地困难。

三个 Spider 2.0 基准测试在不同环境中测试真实世界的数据库查询。Spider 2.0-Snow 使用 Snowflake 数据库,包含 547 个测试示例,准确率最高达到 59.05%。

Spider 2.0-Lite 涉及 BigQuery、Snowflake 和 SQLite,另有 547 个示例,仅达到 37.84%。Spider 2.0-DBT 针对 DuckDB 测试代码生成,包含 68 个示例,最高达到 39.71%。

这种性能差距并不是因为缺乏尝试。自 2024 年 11 月以来,来自 12 个模型家族的 56 次提交在这些基准测试中竞争。

Claude、OpenAI、DeepSeek 等都在这些测试中推动了他们的模型。过去九个月的进展稳步上升,从大约 2% 提升到约 60%。

当你考虑到 SQL 的限制时,问题变得更加复杂。与拥有 600,000 个单词的英语相比,SQL 的词汇量有限,而编程语言则有更广泛的语法和库可供了解。此外,还有大量的 SQL 数据可供训练。

如果说有什么不同,这应该比模型现在擅长的开放式推理任务更容易。

然而,即使完美的 SQL 生成也无法解决真正的商业挑战。每家公司对“收入”的定义都不同。

市场营销通过活动支出来衡量客户获取成本,销售通过客户经理成本来计算,而财务则包括全额员工费用。这些语义差异造成的混淆是技术准确性无法解决的。

Spider 2.0 的结果指向了数据工作的一个基本真理。SQL 语法的技术熟练程度只是入门。

真正的挑战在于商业背景。理解数据的含义、不同团队如何定义指标以及何时边缘案例重要。正如我在《语义耕耘者》中所写,从原始数据到商业意义的桥梁需要人类的判断,而当前的 AI 无法复制。

8.79K

GPT-5 在 AIME 2025 上达到了 94.6% 的准确率,表明其数学推理接近人类水平。

然而,当要求它查询你的数据库时,成功率骤降至十几%。

Spider 2.0 基准测试揭示了 AI 能力之间的巨大差距。Spider 2.0 是一个全面的文本到 SQL 基准,测试 AI 模型从自然语言问题生成准确 SQL 查询的能力,涵盖真实世界的数据库。

虽然大型语言模型在数学、编码和推理的知识工作中取得了成功,但文本到 SQL 仍然顽固地困难。

三个 Spider 2.0 基准测试在不同环境中测试真实世界的数据库查询。Spider 2.0-Snow 使用 Snowflake 数据库,包含 547 个测试示例,准确率最高达到 59.05%。

Spider 2.0-Lite 涉及 BigQuery、Snowflake 和 SQLite,另有 547 个示例,准确率仅为 37.84%。Spider 2.0-DBT 针对 DuckDB 测试代码生成,包含 68 个示例,最高达到 39.71%。

这种性能差距并不是因为缺乏尝试。自 2024 年 11 月以来,来自 12 个模型家族的 56 次提交在这些基准测试中竞争。

Claude、OpenAI、DeepSeek 等都在这些测试中推动了他们的模型。过去九个月的进展稳步上升,从大约 2% 提升到约 60%。

当你考虑到 SQL 的限制时,问题变得更加复杂。与拥有 600,000 个单词的英语相比,SQL 的词汇量有限,而编程语言的语法和库要广泛得多。此外,还有大量的 SQL 数据可供训练。

如果说有什么不同,这应该比模型现在擅长的开放式推理任务更容易。

然而,即使完美的 SQL 生成也无法解决真正的商业挑战。每家公司对“收入”的定义都不同。

市场营销通过活动支出来衡量客户获取成本,销售通过客户经理成本来计算,而财务则包括全额员工费用。这些语义差异造成的混淆是技术准确性无法解决的。

Spider 2.0 的结果指向了数据工作的一个基本真理。SQL 语法的技术熟练程度只是入门。

真正的挑战在于商业背景。理解数据的含义、不同团队如何定义指标以及何时边缘案例重要。正如我在《语义耕耘者》中所写,从原始数据到商业意义的桥梁需要人类的判断,而当前的 AI 无法复制。

3.94K

Perplexity AI刚刚以345亿美元的未请求报价收购谷歌的Chrome浏览器,试图利用即将到来的反垄断裁决,该裁决可能迫使谷歌剥离其浏览器业务。

将Chrome的经济状况与谷歌现有的Safari协议进行比较,揭示了为什么345亿美元低估了该浏览器。

谷歌每年向苹果支付180亿到200亿美元,以保持Safari的默认搜索引擎¹,服务大约8.5亿用户²。这相当于每个用户每年21美元。

Perplexity的报价将Chrome的估值定为320亿美元,这对于其35亿用户³来说,相当于每个用户每年9美元。

如果Chrome用户享有与谷歌/苹果Safari协议相同的条款,该浏览器的年收入潜力将超过730亿美元。

这些数据基于公开估计,但只是一个近似值。

这假设谷歌会向Chrome的新所有者支付类似的规模费用以获得默认搜索位置。考虑到5到6倍的市值与收入倍数,Chrome的价值在1720亿美元到6300亿美元之间,远远高于345亿美元的报价。

Chrome在市场上占据65%的份额⁴,而Safari仅占18%。剥离将使搜索广告市场陷入动荡。保持广告预算的价值对于谷歌的市值和广告生态系统中的地位来说是难以夸大的。

如果被迫出售Chrome,谷歌将面临生死攸关的选择。无论付出多少代价保持默认搜索引擎,还是看着竞争对手将其最有价值的分发渠道变成对抗自己的武器。

这值多少钱?相对于简单的收入倍数来说,显然是一个显著的溢价。

¹ 彭博社:谷歌对苹果的支付在2022年达到了200亿美元(

² ZipDo:2024年苹果Safari的基本统计数据(

³ Backlinko:2025年网络浏览器市场份额(

⁴ Statcounter:全球浏览器市场份额(

7.96K

1999年,互联网公司根据流量进行估值。首次公开募股的指标围绕着浏览量。

然后谷歌推出了AdWords,这是一种基于点击的广告模式,并在2024年建立了一个价值2730亿美元的业务。

但这一切可能即将改变:皮尤研究中心2025年7月的研究显示,用户在有AI摘要的搜索结果中仅点击8%,而在没有AI摘要的情况下点击率为15%——减少了47%。只有1%的用户会从AI摘要中点击链接。

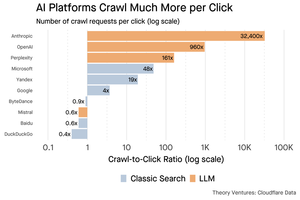

Cloudflare的数据表明,AI平台爬取内容的频率远高于它们所带来的流量:Anthropic每推荐1个链接就爬取32,400个页面,而传统搜索引擎每发送一个访客仅扫描几次内容。

如果内容主要是文本,向AI爬虫提供内容的成本可能并不高。

更重要的是,AI系统使用户与出版商之间的关系被去中介化。用户更喜欢聚合的AI答案,而不是点击网站寻找答案。

大多数网站应该合理预期流量会减少。你的网页和业务将如何应对?

来源:

- 皮尤研究中心 - Athena Chapekis,2025年7月22日(

- Cloudflare:爬取在推荐流量崩溃前的爬取(

- Cloudflare雷达:AI洞察 - 爬取与推荐比率(

- 播客:AI时代内容价值的转变(

9.67K

GPT-5 昨天发布。AIME 2025 的得分为 94.6%。SWE-bench 的得分为 74.9%。

随着我们接近这些基准的上限,它们逐渐失效。

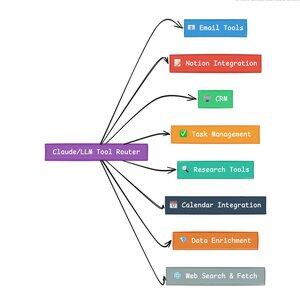

使 GPT-5 和下一代模型革命性的不是它们的知识,而是知道如何行动。对于 GPT-5,这在两个层面上发生。首先,决定使用哪个模型。但第二,更重要的是,通过工具调用。

我们生活在一个 LLM(大型语言模型)掌握知识检索和重组的时代。消费者搜索和编码,最初的杀手级应用,根本上是知识检索的挑战。两者以新的方式组织现有信息。

我们已经攀登了这些高峰,因此竞争比以往任何时候都更加激烈。Anthropic、OpenAI 和 Google 的模型正在趋向于相似的能力。中国模型和开源替代品正在不断接近最先进的水平。每个人都可以检索信息。每个人都可以生成文本。

新的竞争轴心?工具调用。

工具调用将 LLM 从顾问转变为行动者。它弥补了纯语言模型无法克服的两个关键模型弱点。

首先,工作流编排。模型在单次响应方面表现出色,但在多步骤、有状态的过程中却挣扎。工具使它们能够管理长工作流,跟踪进度,处理错误,在数十个操作中保持上下文。

其次,系统集成。LLM 生活在一个仅限文本的世界。工具使它们能够与外部系统(如数据库、API 和企业软件)进行可预测的接口,将自然语言转化为可执行的操作。

在过去一个月里,我构建了 58 种不同的 AI 工具。

电子邮件处理器。CRM 集成器。Notion 更新器。研究助手。每个工具都将模型的能力扩展到一个新领域。

AI 最重要的能力是快速且正确地选择合适的工具。每一步错误的路线都会毁掉整个工作流。

当我说“阅读这封来自 Y Combinator 的电子邮件并找到所有不在 CRM 中的初创公司”时,现代 LLM 执行一个复杂的序列。

一个英语命令替代了整个工作流。这只是一个简单的例子。

更好的是,模型在正确工具的适当设置下,可以验证自己的工作,确保任务按时完成。这种自我验证循环在工作流中创造了可靠性,而这在其他情况下很难实现。

将这一点乘以数百名员工。数千个工作流。生产力的提升呈指数级增长。

未来 AI 世界的赢家将是那些在编排工具和路由正确查询方面最为复杂的人。每一次。当这些工作流变得可预测时,我们所有人都将成为代理管理者。

3.16K

2025年是代理人的时代,而代理人的关键能力是调用工具。

使用Claude Code时,我可以告诉AI筛选一份通讯,找到所有初创公司的链接,验证它们在我们的CRM中存在,只需一个命令。这可能涉及调用两个或三个不同的工具。

但问题在于:使用大型基础模型来做这个是昂贵的,通常受到速率限制,并且对于选择任务来说过于强大。

构建一个具有工具调用的代理系统的最佳方法是什么?

答案在于小型行动模型。NVIDIA发布了一篇引人注目的论文,认为“小型语言模型(SLMs)足够强大,天生更适合,并且在代理系统中的许多调用中必然更经济。”

我一直在测试不同的本地模型,以验证成本降低的效果。我从一个Qwen3:30b参数模型开始,它可以工作,但由于它是一个如此大的模型,可能会相当慢,尽管在任何时候只有30亿个参数中的3亿个是活跃的。

NVIDIA的论文推荐了Salesforce xLAM模型——一种专门为工具选择设计的大型行动模型的不同架构。

因此,我进行了自己的测试,每个模型调用一个工具来列出我的Asana任务。

结果令人震惊:xLAM在2.61秒内完成任务,成功率为100%,而Qwen则花费了9.82秒,成功率为92%——几乎慢了四倍。

这个实验显示了速度的提升,但也有一个权衡:模型中应该有多少智能,工具本身又应该有多少智能。这是有限的。

对于像Qwen这样的大型模型,工具可以更简单,因为模型具有更好的错误容忍度,并且可以绕过设计不良的接口。模型通过强力推理来弥补工具的局限性。

对于较小的模型,模型恢复错误的能力较差,因此工具必须更强大,选择逻辑必须更精确。这看起来可能是一个限制,但实际上是一个特性。

这种限制消除了LLM链式工具的累积错误率。当大型模型进行顺序工具调用时,错误会呈指数级累积。

小型行动模型迫使更好的系统设计,保留LLM的优点,并将其与专业模型结合。

这种架构更高效、更快且更可预测。

5.29K

这真是太有趣了,马里奥。感谢你让我参加节目,谈论市场上发生的一切!

Mario Gabriele 🦊2025年7月22日

Our latest episode with Tomasz Tunguz is live!

The Decade of Data

@ttunguz has spent almost two decades turning data into investment insights. After backing Looker, Expensify, and Monte Carlo at Redpoint Ventures, he launched @Theoryvc in 2022 with a bold vision: build an "investing corporation" where researchers, engineers, and operators sit alongside investors, creating real-time market maps and in-house AI tooling. His debut fund closed at $238 million, followed just 19 months later by a $450 million second fund. Centered on data, AI, and crypto infrastructure, Theory operates at the heart of today's most consequential technological shifts. We explore how data is reshaping venture capital, why traditional investment models are being disrupted, and what it takes to build a firm that doesn't just predict the future but actively helps create it.

Listen now:

• YouTube:

• Spotify:

• Apple:

A big thank you to the incredible sponsors that make the podcast possible:

✨ Brex — The banking solution for startups:

✨ Generalist+ — Essential intelligence for modern investors and technologists:

We explore:

→ How Theory’s “investing corporation” model works

→ Why crypto exchanges could create a viable path to public markets for small-cap software companies

→ The looming power crunch—why data centers could consume 15% of U.S. electricity within five years

→ Stablecoins’ rapid ascent as major banks route 5‑10% of U.S. dollars through them

→ Why Ethereum faces an existential challenge similar to AWS losing ground to Azure in the AI era

→ Why Tomasz believes today’s handful of agents will become 100+ digital co‑workers by year‑end

→ Why Meta is betting billions on AR glasses to change how we interact with machines

→ How Theory Ventures uses AI to accelerate market research, deal analysis, and investment decisions

…And much more!

8K

OpenAI 平均每个美国人每天收到 1 个查询。

谷歌每天会收到大约 4 个查询。

从那时起,50% 的谷歌搜索查询都有 AI Overviews,这意味着现在至少有 60% 的美国搜索是 AI。

这比我预期的要长一些。到 2024 年,我预测 50% 的消费者搜索将支持人工智能。(

但人工智能已经进入搜索领域。

如果谷歌搜索模式有任何迹象的话,那么搜索行为中存在幂律。SparkToro 对谷歌搜索行为的分析显示,前三分之一的美国人执行了超过 80% 的搜索——这意味着人工智能的使用不太可能均匀分布——就像未来一样。

网站和企业开始感受到其影响。《经济学人》的文章“人工智能正在扼杀网络。有什么能拯救它吗?(

绝大多数美国人现在使用人工智能进行搜索。搜索模式变化带来的二阶影响将在今年下半年出现,更多人会问:“我的流量发生了什么?(

人工智能是一种新的分销渠道,抓住它的人将获得市场份额。

- 威廉·吉布森 (William Gibson) 看到了更远的未来!

- 这是基于 SparkToro 图表的中点分析,是一个非常简单的分析,因此存在一些误差。

8.87K

热门

排行

收藏

链上热点

X 热门榜

近期融资

最受认可