Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 behaalt 94,6% nauwkeurigheid op AIME 2025, wat wijst op bijna menselijke wiskundige redenering.

Maar vraag het om je database te doorzoeken, en de slagingspercentages kelderen naar de tien procent.

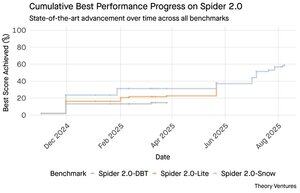

De Spider 2.0 benchmarks onthullen een enorme kloof in AI-capaciteiten. Spider 2.0 is een uitgebreide text-to-SQL benchmark die de mogelijkheid van AI-modellen test om nauwkeurige SQL-query's te genereren vanuit natuurlijke taalvragen over echte databases.

Hoewel grote taalmodellen kenniswerk in wiskunde, codering en redenering hebben veroverd, blijft text-to-SQL hardnekkig moeilijk.

De drie Spider 2.0 benchmarks testen het doorzoeken van echte databases in verschillende omgevingen. Spider 2.0-Snow gebruikt Snowflake-databases met 547 testvoorbeelden, met een piek van 59,05% nauwkeurigheid.

Spider 2.0-Lite beslaat BigQuery, Snowflake en SQLite met nog eens 547 voorbeelden, en bereikt slechts 37,84%. Spider 2.0-DBT test codegeneratie tegen DuckDB met 68 voorbeelden, met een maximum van 39,71%.

Deze prestatiekloof is niet te wijten aan een gebrek aan inspanning. Sinds november 2024 hebben 56 inzendingen van 12 modelfamilies op deze benchmarks gestreden.

Claude, OpenAI, DeepSeek en anderen hebben allemaal hun modellen tegen deze tests getest. De vooruitgang is gestaag geweest, van ongeveer 2% naar ongeveer 60% in de afgelopen negen maanden.

De puzzel verdiept zich als je de beperkingen van SQL in overweging neemt. SQL heeft een beperkte woordenschat vergeleken met het Engels, dat 600.000 woorden heeft, of programmeertalen die veel bredere syntaxes en bibliotheken hebben om te kennen. Bovendien is er genoeg SQL beschikbaar om op te trainen.

Als er iets is, zou dit gemakkelijker moeten zijn dan de open-eind redeneringstaken waar modellen nu in uitblinken.

Toch zou zelfs perfecte SQL-generatie de echte zakelijke uitdaging niet oplossen. Elk bedrijf definieert "omzet" anders.

Marketing meet de kosten van klantacquisitie op basis van campagne-uitgaven, sales berekent het met de kosten van account executives, en financiën omvatten volledig geladen personeelskosten. Deze semantische verschillen creëren verwarring die technische nauwkeurigheid niet kan oplossen.

De Spider 2.0-resultaten wijzen op een fundamentele waarheid over dataverwerking. Technische bekwaamheid in SQL-syntax is slechts het toegangspunt.

De echte uitdaging ligt in de zakelijke context. Begrijpen wat de data betekent, hoe verschillende teams metrics definiëren, en wanneer randgevallen belangrijk zijn. Zoals ik schreef in Semantic Cultivators, vereist de brug tussen ruwe data en zakelijke betekenis menselijke beoordeling die de huidige AI niet kan repliceren.

8,8K

GPT-5 behaalt 94,6% nauwkeurigheid op AIME 2025, wat wijst op bijna menselijke wiskundige redenering.

Maar vraag het om je database te doorzoeken, en de slagingspercentages kelderen naar de tien procent.

De Spider 2.0 benchmarks onthullen een enorme kloof in AI-capaciteiten. Spider 2.0 is een uitgebreide text-to-SQL benchmark die de mogelijkheid van AI-modellen test om nauwkeurige SQL-query's te genereren vanuit natuurlijke taalvragen over echte databases.

Hoewel grote taalmodellen kenniswerk in wiskunde, codering en redenering hebben veroverd, blijft text-to-SQL hardnekkig moeilijk.

De drie Spider 2.0 benchmarks testen het doorzoeken van echte databases in verschillende omgevingen. Spider 2.0-Snow gebruikt Snowflake-databases met 547 testvoorbeelden, met een piek van 59,05% nauwkeurigheid.

Spider 2.0-Lite bestrijkt BigQuery, Snowflake en SQLite met nog eens 547 voorbeelden, en bereikt slechts 37,84%. Spider 2.0-DBT test codegeneratie tegen DuckDB met 68 voorbeelden, met een maximum van 39,71%.

Deze prestatiekloof is niet te wijten aan een gebrek aan inspanning. Sinds november 2024 hebben 56 inzendingen van 12 modelfamilies op deze benchmarks gestreden.

Claude, OpenAI, DeepSeek en anderen hebben allemaal hun modellen tegen deze tests getest. De vooruitgang is gestaag geweest, van ongeveer 2% naar ongeveer 60% in de afgelopen negen maanden.

De puzzel verdiept zich als je de beperkingen van SQL in overweging neemt. SQL heeft een beperkte woordenschat vergeleken met het Engels, dat 600.000 woorden heeft, of programmeertalen die veel bredere syntaxes en bibliotheken hebben om te kennen. Bovendien is er veel SQL beschikbaar om op te trainen.

Als er iets is, zou dit gemakkelijker moeten zijn dan de open-eind redeneringstaken waar modellen nu in uitblinken.

Toch zou zelfs perfecte SQL-generatie de echte zakelijke uitdaging niet oplossen. Elk bedrijf definieert "omzet" anders.

Marketing meet de kosten van klantacquisitie op basis van campagne-uitgaven, sales berekent het met de kosten van account executives, en financiën omvatten volledig geladen personeelskosten. Deze semantische verschillen creëren verwarring die technische nauwkeurigheid niet kan oplossen.

De Spider 2.0-resultaten wijzen op een fundamentele waarheid over dataverwerking. Technische bekwaamheid in SQL-syntax is slechts het toegangspunt.

De echte uitdaging ligt in de zakelijke context. Begrijpen wat de data betekent, hoe verschillende teams metrics definiëren, en wanneer randgevallen belangrijk zijn. Zoals ik schreef in Semantic Cultivators, vereist de brug tussen ruwe data en zakelijke betekenis menselijke beoordeling die de huidige AI niet kan repliceren.

3,95K

Perplexity AI heeft zojuist een ongevraagd bod van $34,5 miljard gedaan op de Chrome-browser van Google, in een poging te profiteren van de aanstaande antitrustuitspraak die Google zou kunnen dwingen zijn browserbedrijf te verkopen.

Het vergelijken van de economie van Chrome met de bestaande deal van Google met Safari onthult waarom $34,5 miljard de browser onderwaardeert.

Google betaalt Apple jaarlijks $18-20 miljard om de standaard zoekmachine van Safari te blijven¹, wat ongeveer 850 miljoen gebruikers² bedient. Dit komt neer op $21 per gebruiker per jaar.

Het bod van Perplexity waardeert Chrome op $32 miljard, wat $9 per gebruiker per jaar is voor zijn 3,5 miljard gebruikers³.

Als Chrome-gebruikers dezelfde voorwaarden zouden hebben als de Google/Apple Safari-deal, zou het jaarlijkse omzetpotentieel van de browser meer dan $73 miljard bedragen.

Deze gegevens zijn gebaseerd op openbare schattingen, maar zijn een benadering.

Dit gaat ervan uit dat Google een nieuwe eigenaar van Chrome een vergelijkbaar geschaald bedrag zou betalen voor de standaard zoekplaatsing. Gezien een marktwaarde-omzetverhouding van 5x tot 6x, is Chrome ergens tussen de $172 miljard en $630 miljard waard, een ver cry van het bod van $34,5 miljard.

Chrome domineert de markt met een marktaandeel van 65%⁴, vergeleken met de 18% van Safari. Een verkoop zou de markt voor zoekadvertenties in beroering brengen. De waarde van het behouden van adverteerdersbudgetten is moeilijk te overschatten voor de marktwaarde en positie van Google in het advertentie-ecosysteem.

Als Google gedwongen zou worden om Chrome te verkopen, zou het voor een existentiële keuze komen te staan. Betaal wat nodig is om de standaard zoekmachine te blijven, of kijk toe hoe concurrenten zijn meest waardevolle distributiekanaal tegen hem gebruiken.

Hoeveel is dat waard? Een significante premie bovenop een eenvoudige omzetverhouding.

¹ Bloomberg: Google’s betalingen aan Apple bereikten $20 miljard in 2022 (

² ZipDo: Essentiële Apple Safari-statistieken in 2024 (

³ Backlinko: Marktaandeel webbrowser in 2025 (

⁴ Statcounter: Marktaandeel browsers wereldwijd (

7,98K

In 1999 werden de dotcoms gewaardeerd op verkeer. IPO-metrics draaiden om kijkers.

Toen lanceerde Google AdWords, een advertentiemodel gebaseerd op klikken, en bouwde in 2024 een bedrijf van $273 miljard op.

Maar dat zou allemaal wel eens kunnen veranderen: een studie van Pew Research in juli 2025 onthult dat gebruikers slechts 8% van de zoekresultaten met AI-samenvattingen aanklikken, tegenover 15% zonder - een vermindering van 47%. Slechts 1% klikt door vanuit AI-samenvattingen.

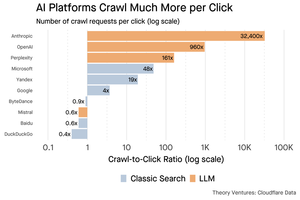

Data van Cloudflare toont aan dat AI-platforms content veel meer crawlen dan dat ze verkeer terugverwijzen: Anthropic crawlt 32.400 pagina's voor elke 1 verwijzing, terwijl traditionele zoekmachines content slechts een paar keer per verzonden bezoeker scannen.

De kosten voor het aanbieden van content aan de AI-crawlers zijn misschien niet enorm als het voornamelijk tekst is.

Het grotere punt is dat AI-systemen de relatie tussen gebruiker en uitgever ontkoppelen. Gebruikers geven de voorkeur aan geaggregeerde AI-antwoorden boven het doorklikken naar websites om hun antwoorden te vinden.

Het is logisch dat de meeste websites minder verkeer zouden moeten verwachten. Hoe zal jouw website en jouw bedrijf hiermee omgaan?

Bronnen:

- Pew Research Center - Athena Chapekis, 22 juli 2025 (

- Cloudflare: De crawl voor de val van verwijzingen (

- Cloudflare Radar: AI-inzichten - Crawl naar Verwijsverhouding (

- Podcast: De Verschuivende Waarde van Content in het AI-tijdperk (

9,69K

GPT-5 is gisteren gelanceerd. 94,6% op AIME 2025. 74,9% op SWE-bench.

Naarmate we de bovenste grenzen van deze benchmarks naderen, sterven ze.

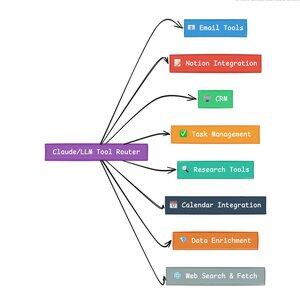

Wat GPT-5 en de volgende generatie modellen revolutionair maakt, is niet hun kennis. Het is weten hoe te handelen. Voor GPT-5 gebeurt dit op twee niveaus. Ten eerste, beslissen welk model te gebruiken. Maar ten tweede, en belangrijker, door middel van tool-aanroepen.

We leven in een tijdperk waarin LLM's kennisretrieval en hersamenstelling hebben beheerst. Consumentenzoekopdrachten en codering, de aanvankelijke killer-applicaties, zijn fundamenteel uitdagingen in kennisretrieval. Beide organiseren bestaande informatie op nieuwe manieren.

We hebben die heuvels beklommen en als gevolg daarvan is de concurrentie intenser dan ooit. De modellen van Anthropic, OpenAI en Google komen steeds dichter bij vergelijkbare capaciteiten. Chinese modellen en open-source alternatieven blijven steeds dichter bij de state-of-the-art komen. Iedereen kan informatie ophalen. Iedereen kan tekst genereren.

De nieuwe as van concurrentie? Tool-aanroepen.

Tool-aanroepen transformeren LLM's van adviseurs naar acteurs. Het compenseert voor twee kritieke modelzwaktes die pure taalmodes niet kunnen overwinnen.

Ten eerste, workflow-orchestratie. Modellen excelleren in eenmalige reacties, maar hebben moeite met multi-stap, stateful processen. Tools stellen hen in staat om lange workflows te beheren, voortgang bij te houden, fouten af te handelen en context te behouden over tientallen operaties.

Ten tweede, systeemintegratie. LLM's leven in een tekst-only wereld. Tools stellen hen in staat om voorspelbaar te interfacing met externe systemen zoals databases, API's en bedrijfssoftware, waardoor natuurlijke taal wordt omgezet in uitvoerbare acties.

In de afgelopen maand heb ik 58 verschillende AI-tools gebouwd.

E-mailverwerkers. CRM-integrators. Notion-updaters. Onderzoeksassistenten. Elke tool breidt de mogelijkheden van het model uit naar een nieuw domein.

De belangrijkste capaciteit voor AI is het snel en correct selecteren van de juiste tool. Elke verkeerd gerouteerde stap doodt de hele workflow.

Wanneer ik zeg "lees deze e-mail van Y Combinator en vind alle startups die niet in de CRM staan," voeren moderne LLM's een complexe reeks uit.

Één commando in het Engels vervangt een hele workflow. En dit is slechts een eenvoudige.

Nog beter, het model, goed ingesteld met de juiste tools, kan zijn eigen werk verifiëren dat taken op tijd zijn voltooid. Deze zelfverificatiecyclus creëert betrouwbaarheid in workflows die anders moeilijk te bereiken is.

Vermenigvuldig dit over honderden werknemers. Duizenden workflows. De productiviteitswinsten stapelen zich exponentieel op.

De winnaars in de toekomstige AI-wereld zullen degenen zijn die het meest geavanceerd zijn in het orkestreren van tools en het routeren van de juiste queries. Elke keer. Zodra die workflows voorspelbaar zijn, zullen we allemaal agentmanagers worden.

3,17K

2025 is het jaar van agenten, en de belangrijkste mogelijkheid van agenten is het aanroepen van tools.

Wanneer ik Claude Code gebruik, kan ik de AI vertellen om door een nieuwsbrief te filteren, alle links naar startups te vinden, te verifiëren of ze bestaan in onze CRM, met een enkele opdracht. Dit kan inhouden dat er twee of drie verschillende tools worden aangeroepen.

Maar hier is het probleem: het gebruik van een groot fundamentmodel hiervoor is duur, vaak beperkt in snelheid, en te krachtig voor een selectietaak.

Wat is de beste manier om een agentisch systeem met toolaanroep te bouwen?

Het antwoord ligt in kleine actiemodellen. NVIDIA heeft een overtuigend paper uitgebracht waarin wordt betoogd dat "Kleine taalmodellen (SLMs) voldoende krachtig zijn, inherent geschikter, en noodzakelijkerwijs economischer voor veel aanroepen in agentische systemen."

Ik heb verschillende lokale modellen getest om een kostenreductie-oefening te valideren. Ik begon met een Qwen3:30b parameter model, dat werkt maar behoorlijk traag kan zijn omdat het zo'n groot model is, hoewel slechts 3 miljard van die 30 miljard parameters op elk moment actief zijn.

Het NVIDIA-paper beveelt het Salesforce xLAM-model aan – een andere architectuur die een groot actiemodel wordt genoemd, specifiek ontworpen voor toolselectie.

Dus, ik heb mijn eigen test uitgevoerd, elk model dat een tool aanroept om mijn Asana-taken op te sommen.

De resultaten waren opvallend: xLAM voltooide taken in 2,61 seconden met 100% succes, terwijl Qwen 9,82 seconden nodig had met 92% succes – bijna vier keer zo lang.

Dit experiment toont de snelheidswinst aan, maar er is een afweging: hoeveel intelligentie moet in het model zitten versus in de tools zelf. Dit is beperkt.

Met grotere modellen zoals Qwen kunnen tools eenvoudiger zijn omdat het model een betere fouttolerantie heeft en kan omgaan met slecht ontworpen interfaces. Het model compenseert voor de beperkingen van de tools door brute-force redeneren.

Met kleinere modellen heeft het model minder capaciteit om van fouten te herstellen, dus de tools moeten robuuster zijn en de selectielogica preciezer. Dit lijkt misschien een beperking, maar het is eigenlijk een functie.

Deze beperking elimineert de cumulatieve foutpercentage van LLM-gekoppelde tools. Wanneer grote modellen sequentiële toolaanroepen doen, stapelen fouten zich exponentieel op.

Kleine actiemodellen dwingen tot een betere systeemsontwerp, waarbij het beste van LLM's wordt behouden en gecombineerd met gespecialiseerde modellen.

Deze architectuur is efficiënter, sneller en voorspelbaarder.

5,3K

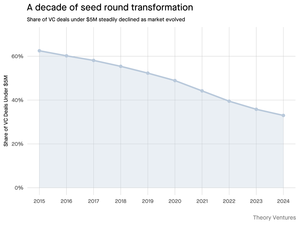

Waarom krimpt de seedronde van minder dan $5 miljoen?

Tien jaar geleden vormden deze kleinere rondes de ruggengraat van de financiering van startups, goed voor meer dan 70% van alle seeddeals. Vandaag de dag onthult PitchBook-data dat dit cijfer is gedaald tot minder dan de helft.

De cijfers vertellen een duidelijk verhaal. Deals van minder dan $5 miljoen daalden van 62,5% in 2015 naar 37,5% in 2024. Deze daling van 29,5 procentpunt heeft de manier waarop startups hun eerste institutionele kapitaal ophalen fundamenteel veranderd.

Drie krachten hebben deze transformatie aangedreven. We kunnen de daling ontleden om te begrijpen wat de kleine seedronde heeft verminderd en waarom het belangrijk is voor oprichters vandaag de dag.

4,7K

Dit was zo leuk, Mario. Bedankt dat je me in de show hebt gehad om over alles wat er in de markt gebeurt te praten!

Mario Gabriele 🦊22 jul 2025

Onze nieuwste aflevering met Tomasz Tunguz is live!

Het Decennium van Gegevens

@ttunguz heeft bijna twee decennia besteed aan het omzetten van gegevens in investeringsinzichten. Na het ondersteunen van Looker, Expensify en Monte Carlo bij Redpoint Ventures, lanceerde hij in 2022 @Theoryvc met een gedurfde visie: bouw een "investeringscorporatie" waar onderzoekers, ingenieurs en operators naast investeerders zitten, en real-time marktkaarten en interne AI-tools creëren. Zijn debuutfonds sloot op $238 miljoen, gevolgd slechts 19 maanden later door een tweede fonds van $450 miljoen. Gevestigd op gegevens, AI en crypto-infrastructuur, opereert Theory in het hart van de meest ingrijpende technologische verschuivingen van vandaag. We onderzoeken hoe gegevens de durfkapitaalwereld hervormen, waarom traditionele investeringsmodellen worden verstoord, en wat er nodig is om een bedrijf te bouwen dat niet alleen de toekomst voorspelt, maar deze actief helpt creëren.

Luister nu:

• YouTube:

• Spotify:

• Apple:

Een grote dank aan de ongelooflijke sponsors die de podcast mogelijk maken:

✨ Brex — De bankoplossing voor startups:

✨ Generalist+ — Essentiële intelligentie voor moderne investeerders en technologen:

We verkennen:

→ Hoe het model van Theory’s “investeringscorporatie” werkt

→ Waarom crypto-exchanges een levensvatbaar pad naar de publieke markten kunnen creëren voor kleine softwarebedrijven

→ De dreigende energiecrisis—waarom datacenters binnen vijf jaar 15% van de elektriciteit in de VS zouden kunnen verbruiken

→ De snelle opkomst van stablecoins terwijl grote banken 5-10% van de Amerikaanse dollars via hen routeren

→ Waarom Ethereum een existentiële uitdaging ondervindt die vergelijkbaar is met AWS die terrein verliest aan Azure in het AI-tijdperk

→ Waarom Tomasz gelooft dat de handvol agenten van vandaag tegen het einde van het jaar 100+ digitale collega's zal worden

→ Waarom Meta miljarden inzet op AR-brillen om te veranderen hoe we met machines omgaan

→ Hoe Theory Ventures AI gebruikt om marktonderzoek, dealanalyse en investeringsbeslissingen te versnellen

…En nog veel meer!

8,01K

OpenAI ontvangt gemiddeld 1 zoekopdracht per Amerikaan per dag.

Google ontvangt ongeveer 4 zoekopdrachten per Amerikaan per dag.

Aangezien 50% van de Google-zoekopdrachten AI-overzichten heeft, betekent dit dat minstens 60% van de Amerikaanse zoekopdrachten nu AI is.

Het heeft iets langer geduurd dan ik had verwacht voordat dit gebeurde. In 2024 voorspelde ik dat 50% van de consumentenzoekopdrachten AI-ondersteund zou zijn. (

Maar AI is aangekomen in de zoekresultaten.

Als de zoekpatronen van Google enige indicatie zijn, is er een machtswet in zoekgedrag. De analyse van SparkToro van het zoekgedrag op Google toont aan dat de bovenste derde van de Amerikanen die zoeken, goed voor meer dan 80% van alle zoekopdrachten is - wat betekent dat het gebruik van AI waarschijnlijk niet gelijkmatig verdeeld is - zoals de toekomst.

Websites en bedrijven beginnen de gevolgen hiervan te voelen. Het stuk van The Economist "AI doodt het web. Kan iets het redden?" vangt de geest van deze tijd in een kop. (

Een supermeerderheid van de Amerikanen zoekt nu met AI. De tweede orde effecten van veranderende zoekpatronen komen in de tweede helft van dit jaar en meer mensen zullen zich afvragen: "Wat is er met mijn verkeer gebeurd?" (

AI is een nieuw distributiekanaal en degenen die het grijpen, zullen marktaandeel winnen.

- William Gibson keek veel verder de toekomst in!

- Dit is gebaseerd op een middelpuntanalyse van de SparkToro-grafiek, is een zeer eenvoudige analyse en heeft daardoor enige foutmarge.

8,88K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste