Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 raggiunge il 94,6% di accuratezza su AIME 2025, suggerendo un ragionamento matematico quasi umano.

Tuttavia, chiedigli di interrogare il tuo database e i tassi di successo crollano negli adolescenti.

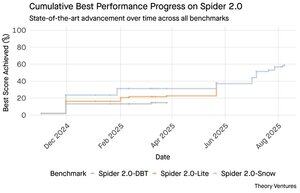

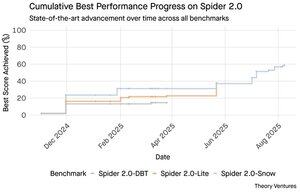

I benchmark Spider 2.0 rivelano un divario enorme nelle capacità dell'IA. Spider 2.0 è un benchmark completo text-to-SQL che testa la capacità dei modelli di IA di generare query SQL accurate da domande in linguaggio naturale su database reali.

Mentre i grandi modelli di linguaggio hanno conquistato il lavoro di conoscenza in matematica, programmazione e ragionamento, il text-to-SQL rimane ostinatamente difficile.

I tre benchmark Spider 2.0 testano l'interrogazione di database reali in diversi ambienti. Spider 2.0-Snow utilizza database Snowflake con 547 esempi di test, raggiungendo un picco del 59,05% di accuratezza.

Spider 2.0-Lite copre BigQuery, Snowflake e SQLite con altri 547 esempi, raggiungendo solo il 37,84%. Spider 2.0-DBT testa la generazione di codice contro DuckDB con 68 esempi, arrivando a un massimo del 39,71%.

Questo divario di prestazioni non è dovuto alla mancanza di tentativi. Da novembre 2024, 56 sottomissioni di 12 famiglie di modelli hanno gareggiato su questi benchmark.

Claude, OpenAI, DeepSeek e altri hanno tutti messo alla prova i loro modelli contro questi test. I progressi sono stati costanti, passando da circa il 2% a circa il 60% negli ultimi nove mesi.

Il puzzle si approfondisce quando consideri i vincoli di SQL. SQL ha un vocabolario limitato rispetto all'inglese, che ha 600.000 parole, o ai linguaggi di programmazione che hanno sintassi e librerie molto più ampie da conoscere. Inoltre, c'è molta SQL là fuori su cui addestrarsi.

Se c'è qualcosa, questo dovrebbe essere più facile rispetto ai compiti di ragionamento aperto in cui i modelli ora eccellono.

Eppure anche una generazione SQL perfetta non risolverebbe la vera sfida aziendale. Ogni azienda definisce "entrate" in modo diverso.

Il marketing misura il costo di acquisizione dei clienti in base alla spesa della campagna, le vendite lo calcolano utilizzando i costi degli account executive e la finanza include le spese per i dipendenti completamente caricati. Queste differenze semantiche creano confusione che l'accuratezza tecnica non può risolvere.

I risultati di Spider 2.0 indicano una verità fondamentale sul lavoro con i dati. La competenza tecnica nella sintassi SQL è solo il punto di partenza.

La vera sfida risiede nel contesto aziendale. Comprendere cosa significano i dati, come i diversi team definiscono le metriche e quando i casi limite sono importanti. Come ho scritto in Semantic Cultivators, il ponte tra i dati grezzi e il significato aziendale richiede un giudizio umano che l'attuale IA non può replicare.

8,79K

GPT-5 raggiunge il 94,6% di accuratezza su AIME 2025, suggerendo un ragionamento matematico quasi umano.

Tuttavia, chiedigli di interrogare il tuo database e i tassi di successo crollano negli adolescenti.

I benchmark Spider 2.0 rivelano un divario enorme nelle capacità dell'IA. Spider 2.0 è un benchmark completo text-to-SQL che testa la capacità dei modelli di IA di generare query SQL accurate da domande in linguaggio naturale su database reali.

Mentre i grandi modelli di linguaggio hanno conquistato il lavoro di conoscenza in matematica, programmazione e ragionamento, il text-to-SQL rimane ostinatamente difficile.

I tre benchmark Spider 2.0 testano l'interrogazione di database reali in diversi ambienti. Spider 2.0-Snow utilizza database Snowflake con 547 esempi di test, raggiungendo un picco del 59,05% di accuratezza.

Spider 2.0-Lite copre BigQuery, Snowflake e SQLite con altri 547 esempi, raggiungendo solo il 37,84%. Spider 2.0-DBT testa la generazione di codice contro DuckDB con 68 esempi, arrivando a un massimo del 39,71%.

Questo divario di prestazioni non è dovuto alla mancanza di tentativi. Da novembre 2024, 56 sottomissioni di 12 famiglie di modelli hanno gareggiato su questi benchmark.

Claude, OpenAI, DeepSeek e altri hanno tutti messo alla prova i loro modelli contro questi test. I progressi sono stati costanti, passando da circa il 2% a circa il 60% negli ultimi nove mesi.

Il puzzle si approfondisce quando consideri i vincoli di SQL. SQL ha un vocabolario limitato rispetto all'inglese, che ha 600.000 parole, o ai linguaggi di programmazione che hanno sintassi e librerie molto più ampie da conoscere. Inoltre, c'è molta SQL là fuori su cui addestrarsi.

Se c'è qualcosa, questo dovrebbe essere più facile rispetto ai compiti di ragionamento aperto in cui i modelli ora eccellono.

Eppure anche una generazione SQL perfetta non risolverebbe la vera sfida aziendale. Ogni azienda definisce "entrate" in modo diverso.

Il marketing misura il costo di acquisizione dei clienti in base alla spesa della campagna, le vendite lo calcolano utilizzando i costi degli account executive e la finanza include le spese per i dipendenti completamente caricati. Queste differenze semantiche creano confusione che l'accuratezza tecnica non può risolvere.

I risultati di Spider 2.0 indicano una verità fondamentale sul lavoro con i dati. La competenza tecnica nella sintassi SQL è solo il punto di partenza.

La vera sfida risiede nel contesto aziendale. Comprendere cosa significano i dati, come i diversi team definiscono le metriche e quando i casi limite sono importanti. Come ho scritto in Semantic Cultivators, il ponte tra i dati grezzi e il significato aziendale richiede un giudizio umano che l'attuale IA non può replicare.

3,94K

Perplexity AI ha appena fatto un'offerta non richiesta di 34,5 miliardi di dollari per il browser Chrome di Google, cercando di capitalizzare sulla prossima sentenza antitrust che potrebbe costringere Google a dismettere la sua attività di browser.

Confrontare l'economia di Chrome con l'attuale accordo di Google con Safari rivela perché 34,5 miliardi di dollari svalutano il browser.

Google paga ad Apple tra 18 e 20 miliardi di dollari all'anno per rimanere il motore di ricerca predefinito di Safari¹, servendo circa 850 milioni di utenti². Questo si traduce in 21 dollari per utente all'anno.

L'offerta di Perplexity valuta Chrome a 32 miliardi di dollari, che corrisponde a 9 dollari per utente all'anno per i suoi 3,5 miliardi di utenti³.

Se gli utenti di Chrome avessero le stesse condizioni dell'accordo Google/Apple con Safari, il potenziale di entrate annuali del browser supererebbe i 73 miliardi di dollari.

Questi dati si basano su stime pubbliche ma sono un'approssimazione.

Si presume che Google pagherebbe a un nuovo proprietario di Chrome una tassa simile per il posizionamento del motore di ricerca predefinito. Dato un multiplo di capitalizzazione di mercato rispetto alle entrate di 5x a 6x, Chrome vale tra 172 miliardi e 630 miliardi di dollari, ben lontano dall'offerta di 34,5 miliardi di dollari.

Chrome domina il mercato con una quota del 65%⁴, rispetto al 18% di Safari. Una dismissione gettirebbe il mercato degli annunci di ricerca nel caos. Il valore di mantenere i budget pubblicitari è difficile da sottovalutare per la capitalizzazione di mercato e la posizione di Google nell'ecosistema pubblicitario.

Se costretta a vendere Chrome, Google si troverebbe di fronte a una scelta esistenziale. Pagare qualunque cifra per rimanere il motore di ricerca predefinito, o guardare i concorrenti trasformare il suo canale di distribuzione più prezioso in un'arma contro di essa.

Quanto vale tutto ciò? Un premio significativo rispetto a un semplice multiplo di entrate.

¹ Bloomberg: I pagamenti di Google ad Apple hanno raggiunto i 20 miliardi di dollari nel 2022 (

² ZipDo: Statistiche essenziali su Apple Safari nel 2024 (

³ Backlinko: Quota di mercato dei browser web nel 2025 (

⁴ Statcounter: Quota di mercato dei browser nel mondo (

7,96K

Nel 1999, le dotcom erano valutate in base al traffico. Le metriche delle IPO ruotavano attorno agli utenti.

Poi Google ha lanciato AdWords, un modello pubblicitario basato sui clic, e ha costruito un business da 273 miliardi di dollari nel 2024.

Ma tutto questo potrebbe essere sul punto di cambiare: lo studio di Pew Research di luglio 2025 rivela che gli utenti cliccano solo l'8% dei risultati di ricerca con riassunti AI, rispetto al 15% senza - una riduzione del 47%. Solo l'1% clicca attraverso i riassunti AI.

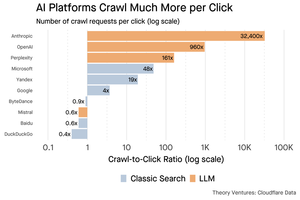

I dati di Cloudflare mostrano che le piattaforme AI eseguono la scansione dei contenuti molto più di quanto rimandino traffico: Anthropic scansiona 32.400 pagine per ogni 1 referral, mentre i motori di ricerca tradizionali esaminano i contenuti solo un paio di volte per visitatore inviato.

La spesa per servire contenuti ai crawler AI potrebbe non essere enorme se si tratta principalmente di testo.

Il punto più grande è che i sistemi AI disintermediano la relazione tra utente e editore. Gli utenti preferiscono risposte aggregate dall'AI piuttosto che cliccare sui siti web per trovare le loro risposte.

È logico che la maggior parte dei siti web dovrebbe aspettarsi meno traffico. Come gestirà il tuo sito web e la tua attività questa situazione?

Fonti:

- Pew Research Center - Athena Chapekis, 22 luglio 2025 (

- Cloudflare: La scansione prima della caduta dei referral (

- Cloudflare Radar: AI Insights - Rapporto di scansione rispetto ai referral (

- Podcast: Il valore in evoluzione dei contenuti nell'era dell'AI (

9,68K

GPT-5 è stato lanciato ieri. 94,6% su AIME 2025. 74,9% su SWE-bench.

Man mano che ci avviciniamo ai limiti superiori di questi benchmark, essi svaniscono.

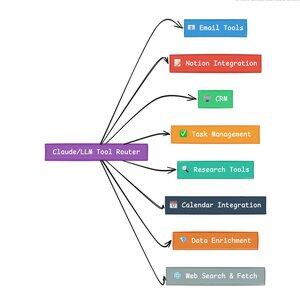

Ciò che rende GPT-5 e la prossima generazione di modelli rivoluzionari non è la loro conoscenza. È sapere come agire. Per GPT-5 questo avviene a due livelli. Prima, decidere quale modello utilizzare. Ma secondo, e più importante, attraverso la chiamata agli strumenti.

Abbiamo vissuto in un'era in cui i LLM hanno padroneggiato il recupero e la riassemblaggio delle conoscenze. La ricerca per i consumatori e la codifica, le applicazioni killer iniziali, sono fondamentalmente sfide di recupero delle conoscenze. Entrambi organizzano le informazioni esistenti in modi nuovi.

Abbiamo scalato quelle colline e, di conseguenza, la competizione è più intensa che mai. I modelli di Anthropic, OpenAI e Google stanno convergendo su capacità simili. I modelli cinesi e le alternative open source continuano a spingersi sempre più vicino allo stato dell'arte. Tutti possono recuperare informazioni. Tutti possono generare testo.

Il nuovo asse della competizione? La chiamata agli strumenti.

La chiamata agli strumenti trasforma i LLM da consulenti ad attori. Compensa due debolezze critiche dei modelli puramente linguistici che non possono essere superate.

Prima, l'orchestrazione del flusso di lavoro. I modelli eccellono nelle risposte a colpo singolo ma faticano con processi multi-step e con stato. Gli strumenti consentono loro di gestire flussi di lavoro lunghi, monitorando i progressi, gestendo gli errori, mantenendo il contesto attraverso dozzine di operazioni.

Secondo, l'integrazione del sistema. I LLM vivono in un mondo solo testuale. Gli strumenti consentono loro di interfacciarsi in modo prevedibile con sistemi esterni come database, API e software aziendale, trasformando il linguaggio naturale in azioni eseguibili.

Nell'ultimo mese ho costruito 58 strumenti AI diversi.

Processori di email. Integratori CRM. Aggiornatori di Notion. Assistenti alla ricerca. Ogni strumento estende le capacità del modello in un nuovo dominio.

La capacità più importante per l'AI è selezionare rapidamente e correttamente lo strumento giusto. Ogni passo errato uccide l'intero flusso di lavoro.

Quando dico “leggi questa email da Y Combinator e trova tutte le startup che non sono nel CRM”, i moderni LLM eseguono una sequenza complessa.

Un comando in inglese sostituisce un intero flusso di lavoro. E questo è solo un semplice esempio.

Ancora meglio, il modello, correttamente impostato con gli strumenti giusti, può verificare il proprio lavoro che i compiti sono stati completati in tempo. Questo ciclo di auto-verifica crea affidabilità nei flussi di lavoro che è difficile da raggiungere altrimenti.

Moltiplica questo per centinaia di dipendenti. Migliaia di flussi di lavoro. I guadagni di produttività si accumulano in modo esponenziale.

I vincitori nel futuro mondo dell'AI saranno quelli che sono più sofisticati nell'orchestrare strumenti e instradare le giuste query. Ogni volta. Una volta che quei flussi di lavoro sono prevedibili, è allora che tutti noi diventeremo manager di agenti.

3,16K

Il 2025 è l'anno degli agenti, e la capacità chiave degli agenti è chiamare strumenti.

Quando utilizzo Claude Code, posso dire all'IA di setacciare una newsletter, trovare tutti i link alle startup, verificare che esistano nel nostro CRM, con un solo comando. Questo potrebbe comportare l'uso di due o tre strumenti diversi.

Ma ecco il problema: utilizzare un grande modello di fondazione per questo è costoso, spesso limitato in termini di frequenza, e sovradimensionato per un compito di selezione.

Qual è il modo migliore per costruire un sistema agentico con chiamate agli strumenti?

La risposta risiede nei modelli di azione piccoli. NVIDIA ha pubblicato un documento convincente che sostiene che "I piccoli modelli di linguaggio (SLM) sono sufficientemente potenti, intrinsecamente più adatti e necessariamente più economici per molte invocazioni nei sistemi agentici."

Ho testato diversi modelli locali per convalidare un esercizio di riduzione dei costi. Ho iniziato con un modello Qwen3:30b, che funziona ma può essere piuttosto lento perché è un modello così grande, anche se solo 3 miliardi di quei 30 miliardi di parametri sono attivi in un dato momento.

Il documento NVIDIA raccomanda il modello Salesforce xLAM - un'architettura diversa chiamata modello di azione grande specificamente progettata per la selezione degli strumenti.

Quindi, ho eseguito un test personale, ogni modello chiamando uno strumento per elencare i miei compiti su Asana.

I risultati sono stati sorprendenti: xLAM ha completato i compiti in 2,61 secondi con il 100% di successo, mentre Qwen ha impiegato 9,82 secondi con il 92% di successo - quasi quattro volte di più.

Questo esperimento mostra il guadagno di velocità, ma c'è un compromesso: quanto intelletto dovrebbe risiedere nel modello rispetto agli strumenti stessi. Questo è limitato.

Con modelli più grandi come Qwen, gli strumenti possono essere più semplici perché il modello ha una migliore tolleranza agli errori e può aggirare interfacce mal progettate. Il modello compensa le limitazioni degli strumenti attraverso il ragionamento di forza bruta.

Con modelli più piccoli, il modello ha meno capacità di recuperare dagli errori, quindi gli strumenti devono essere più robusti e la logica di selezione più precisa. Questo potrebbe sembrare una limitazione, ma in realtà è una caratteristica.

Questa restrizione elimina il tasso di errore cumulativo degli strumenti a catena LLM. Quando i grandi modelli effettuano chiamate sequenziali agli strumenti, gli errori si accumulano in modo esponenziale.

I piccoli modelli di azione costringono a una migliore progettazione del sistema, mantenendo il meglio degli LLM e combinandolo con modelli specializzati.

Questa architettura è più efficiente, più veloce e più prevedibile.

5,29K

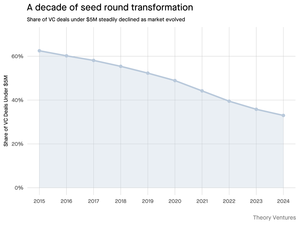

Perché il round seed sotto i 5 milioni di dollari sta diminuendo?

Dieci anni fa, questi round più piccoli costituivano la spina dorsale del finanziamento delle startup, rappresentando oltre il 70% di tutti i contratti seed. Oggi, i dati di PitchBook rivelano che quella cifra è crollata a meno della metà.

I numeri raccontano una storia netta. I contratti sotto i 5 milioni di dollari sono diminuiti dal 62,5% nel 2015 al 37,5% nel 2024. Questa diminuzione di 29,5 punti percentuali ha rimodellato fondamentalmente il modo in cui le startup raccolgono il loro primo capitale istituzionale.

Tre forze hanno guidato questa trasformazione. Possiamo scomporre il calo per capire cosa ha ridotto il piccolo round seed e perché è importante per i fondatori oggi.

4,69K

È stato così divertente, Mario. Grazie per avermi invitato nello show per parlare di tutto ciò che sta accadendo nel mercato!

Mario Gabriele 🦊22 lug 2025

Our latest episode with Tomasz Tunguz is live!

The Decade of Data

@ttunguz has spent almost two decades turning data into investment insights. After backing Looker, Expensify, and Monte Carlo at Redpoint Ventures, he launched @Theoryvc in 2022 with a bold vision: build an "investing corporation" where researchers, engineers, and operators sit alongside investors, creating real-time market maps and in-house AI tooling. His debut fund closed at $238 million, followed just 19 months later by a $450 million second fund. Centered on data, AI, and crypto infrastructure, Theory operates at the heart of today's most consequential technological shifts. We explore how data is reshaping venture capital, why traditional investment models are being disrupted, and what it takes to build a firm that doesn't just predict the future but actively helps create it.

Listen now:

• YouTube:

• Spotify:

• Apple:

A big thank you to the incredible sponsors that make the podcast possible:

✨ Brex — The banking solution for startups:

✨ Generalist+ — Essential intelligence for modern investors and technologists:

We explore:

→ How Theory’s “investing corporation” model works

→ Why crypto exchanges could create a viable path to public markets for small-cap software companies

→ The looming power crunch—why data centers could consume 15% of U.S. electricity within five years

→ Stablecoins’ rapid ascent as major banks route 5‑10% of U.S. dollars through them

→ Why Ethereum faces an existential challenge similar to AWS losing ground to Azure in the AI era

→ Why Tomasz believes today’s handful of agents will become 100+ digital co‑workers by year‑end

→ Why Meta is betting billions on AR glasses to change how we interact with machines

→ How Theory Ventures uses AI to accelerate market research, deal analysis, and investment decisions

…And much more!

8K

OpenAI riceve in media 1 query per americano al giorno.

Google riceve circa 4 query per americano al giorno.

Da allora, il 50% delle query di ricerca su Google ha panoramiche AI, il che significa che almeno il 60% delle ricerche negli Stati Uniti sono ora AI.

Ci è voluto un po' più di tempo di quanto mi aspettassi perché questo accadesse. Nel 2024, avevo previsto che il 50% delle ricerche dei consumatori sarebbe stato abilitato all'AI. (

Ma l'AI è arrivata nella ricerca.

Se i modelli di ricerca di Google sono un'indicazione, c'è una legge di potenza nel comportamento di ricerca. L'analisi di SparkToro sul comportamento di ricerca di Google mostra che il terzo superiore degli americani che cercano esegue oltre l'80% di tutte le ricerche - il che significa che l'uso dell'AI non è probabilmente distribuito in modo uniforme - come il futuro.

I siti web e le aziende stanno iniziando a sentire gli impatti di questo. L'articolo dell'Economist "L'AI sta uccidendo il web. Può qualcosa salvarlo?" cattura lo zeitgeist in un titolo. (

Una supermaggioranza di americani ora cerca con l'AI. Gli effetti di secondo ordine derivanti dai cambiamenti nei modelli di ricerca stanno arrivando nella seconda metà di quest'anno e molti si chiederanno: "Cosa è successo al mio traffico?" (

L'AI è un nuovo canale di distribuzione e coloro che lo afferrano guadagneranno quote di mercato.

- William Gibson ha visto molto più lontano nel futuro!

- Questo si basa su un'analisi intermedia del grafico di SparkToro, è un'analisi molto semplice e ha qualche errore come risultato.

8,87K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari