Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 atinge o precizie de 94,6% pe AIME 2025, sugerând un raționament matematic aproape uman.

Cu toate acestea, cereți-i să vă interogheze baza de date, iar ratele de succes scad la adolescenți.

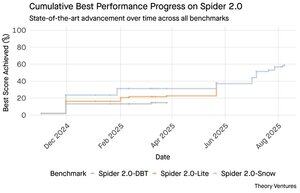

Benchmark-urile Spider 2.0 dezvăluie un decalaj uriaș în capacitățile AI. Spider 2.0 este un benchmark cuprinzător text-to-SQL care testează capacitatea modelelor AI de a genera interogări SQL precise din întrebări în limbaj natural în baze de date din lumea reală.

În timp ce modelele lingvistice mari au cucerit munca de cunoaștere în matematică, codare și raționament, text-to-SQL rămâne încăpățânat de dificil.

Cele trei benchmark-uri Spider 2.0 testează interogarea bazelor de date din lumea reală în diferite medii. Spider 2.0-Snow folosește baze de date Snowflake cu 547 de exemple de testare, cu o precizie maximă de 59,05%.

Spider 2.0-Lite se întinde pe BigQuery, Snowflake și SQLite cu alte 547 de exemple, ajungând la doar 37,84%. Spider 2.0-DBT testează generarea de cod împotriva DuckDB cu 68 de exemple, ajungând la 39,71%.

Acest decalaj de performanță nu este din lipsă de încercare. Din noiembrie 2024, 56 de propuneri de la 12 familii de modele au concurat pe aceste criterii de referință.

Claude, OpenAI, DeepSeek și alții și-au împins modelele împotriva acestor teste. Progresul a fost constant, de la aproximativ 2% la aproximativ 60%, în ultimele nouă luni.

Puzzle-ul se adâncește atunci când iei în considerare constrângerile SQL. SQL are un vocabular limitat în comparație cu engleza, care are 600.000 de cuvinte, sau limbaje de programare care au sintaxe și biblioteci mult mai largi de cunoscut. În plus, există o mulțime de SQL pe care să te antrenezi.

În orice caz, acest lucru ar trebui să fie mai ușor decât sarcinile de raționament deschise în care modelele excelează acum.

Cu toate acestea, chiar și generarea perfectă de SQL nu ar rezolva adevărata provocare de afaceri. Fiecare companie definește "veniturile" în mod diferit.

Marketingul măsoară costul de achiziție a clienților în funcție de cheltuielile de campanie, vânzările îl calculează folosind costurile directorilor de cont, iar finanțele includ cheltuielile complet încărcate ale angajaților. Aceste diferențe semantice creează o confuzie pe care acuratețea tehnică nu o poate rezolva.

Rezultatele Spider 2.0 indică un adevăr fundamental despre munca cu date. Competența tehnică în sintaxa SQL este doar punctul de intrare.

Adevărata provocare constă în contextul de afaceri. Înțelegerea semnificației datelor, a modului în care diferitele echipe definesc valorile și când contează cazurile limită. După cum am scris în Semantic Cultivators, puntea dintre datele brute și semnificația afacerii necesită o judecată umană pe care IA actuală nu o poate reproduce.

8,8K

GPT-5 atinge o precizie de 94,6% pe AIME 2025, sugerând un raționament matematic aproape uman.

Cu toate acestea, cereți-i să vă interogheze baza de date, iar ratele de succes scad la adolescenți.

Benchmark-urile Spider 2.0 dezvăluie un decalaj uriaș în capacitățile AI. Spider 2.0 este un benchmark cuprinzător text-to-SQL care testează capacitatea modelelor AI de a genera interogări SQL precise din întrebări în limbaj natural în baze de date din lumea reală.

În timp ce modelele lingvistice mari au cucerit munca de cunoaștere în matematică, codare și raționament, text-to-SQL rămâne încăpățânat de dificil.

Cele trei benchmark-uri Spider 2.0 testează interogarea bazelor de date din lumea reală în diferite medii. Spider 2.0-Snow folosește baze de date Snowflake cu 547 de exemple de testare, cu o precizie maximă de 59,05%.

Spider 2.0-Lite se întinde pe BigQuery, Snowflake și SQLite cu alte 547 de exemple, ajungând la doar 37,84%. Spider 2.0-DBT testează generarea de cod împotriva DuckDB cu 68 de exemple, ajungând la 39,71%.

Acest decalaj de performanță nu este din lipsă de încercare. Din noiembrie 2024, 56 de propuneri de la 12 familii de modele au concurat pe aceste criterii de referință.

Claude, OpenAI, DeepSeek și alții și-au împins modelele împotriva acestor teste. Progresul a fost constant, de la aproximativ 2% la aproximativ 60%, în ultimele nouă luni.

Puzzle-ul se adâncește atunci când iei în considerare constrângerile SQL. SQL are un vocabular limitat în comparație cu engleza, care are 600.000 de cuvinte, sau limbaje de programare care au sintaxe și biblioteci mult mai largi de cunoscut. În plus, există o mulțime de SQL pe care să te antrenezi.

În orice caz, acest lucru ar trebui să fie mai ușor decât sarcinile de raționament deschise în care modelele excelează acum.

Cu toate acestea, chiar și generarea perfectă de SQL nu ar rezolva adevărata provocare de afaceri. Fiecare companie definește "veniturile" în mod diferit.

Marketingul măsoară costul de achiziție a clienților în funcție de cheltuielile de campanie, vânzările îl calculează folosind costurile directorilor de cont, iar finanțele includ cheltuielile complet încărcate ale angajaților. Aceste diferențe semantice creează o confuzie pe care acuratețea tehnică nu o poate rezolva.

Rezultatele Spider 2.0 indică un adevăr fundamental despre munca cu date. Competența tehnică în sintaxa SQL este doar punctul de intrare.

Adevărata provocare constă în contextul de afaceri. Înțelegerea semnificației datelor, a modului în care diferitele echipe definesc valorile și când contează cazurile limită. După cum am scris în Semantic Cultivators, puntea dintre datele brute și semnificația afacerii necesită o judecată umană pe care IA actuală nu o poate reproduce.

3,94K

Perplexity AI tocmai a făcut o ofertă nesolicitată de 34,5 miliarde de dolari pentru browserul Chrome al Google, încercând să profite de decizia antitrust în așteptare care ar putea forța Google să renunțe la afacerea sa de browsere.

Compararea economiei Chrome cu afacerea existentă cu Safari a Google dezvăluie de ce 34,5 miliarde de dolari subevaluează browserul.

Google plătește Apple cu 18-20 de miliarde de dolari anual pentru a rămâne motorul de căutare implicit al Safari¹, deservind aproximativ 850 de milioane de utilizatori². Acest lucru se traduce prin 21 USD per utilizator pe an.

Oferta Perplexity evaluează Chrome la 32 de miliarde de dolari, ceea ce înseamnă 9 dolari per utilizator pe an pentru cei 3,5 miliarde de utilizatori.

Dacă utilizatorii Chrome ar comanda aceiași termeni ca și acordul Google/Apple Safari, potențialul de venit anual al browserului ar depăși 73 de miliarde de dolari.

Aceste date se bazează pe estimări publice, dar sunt o aproximare.

Acest lucru presupune că Google ar plăti unui nou proprietar al Chrome o taxă similară pentru plasarea implicită în căutare. Având un multiplu de 5 până la 6 ori capitalizarea de piață la venituri, Chrome valorează undeva între 172 și 630 de miliarde de dolari, departe de oferta de 34,5 miliarde de dolari.

Chrome domină piața cu o cotă de 65%, comparativ cu 18% a Safari. O dezinvestire ar arunca piața anunțurilor de căutare în agitație. Valoarea păstrării bugetelor agenților de publicitate este greu de supraestimat pentru capitalizarea de piață și poziția Google în ecosistemul publicitar.

Dacă ar fi forțat să vândă Chrome, Google s-ar confrunta cu o alegere existențială. Plătiți orice este necesar pentru a rămâne motorul de căutare implicit sau urmăriți concurenții transformând cel mai valoros canal de distribuție într-un baston împotriva lui.

Cât valorează asta? O primă semnificativă față de un simplu multiplu de venituri.

¹ Bloomberg: Plățile Google către Apple au ajuns la 20 de miliarde de dolari în 2022 (

² ZipDo: Statistici esențiale Apple Safari în 2024 (

³ Backlinko: cota de piață a browserelor web în 2025 (

⁴ Statcounter: cota de piață a browserelor la nivel mondial (

7,97K

În 1999, dotcom-urile au fost evaluate pe trafic. Valorile IPO s-au învârtit în jurul globilor oculari.

Apoi Google a lansat AdWords, un model de anunț bazat pe clicuri, și a construit o afacere de 273 de miliarde de dolari în 2024.

Dar totul ar putea fi pe cale să se schimbe: studiul Pew Research din iulie 2025 arată că utilizatorii fac clic pe doar 8% din rezultatele căutării cu rezumate AI, față de 15% fără - o reducere de 47%. Doar 1% fac clic din rezumatele AI.

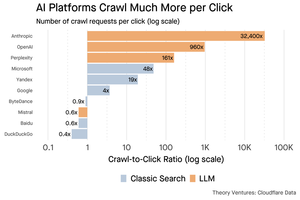

Datele Cloudflare arată că platformele AI accesează cu crawlere conținutul mult mai mult decât trimit traficul înapoi: Anthropic accesează cu crawlere 32.400 de pagini pentru fiecare recomandare, în timp ce motoarele de căutare tradiționale scanează conținutul doar de câteva ori per vizitator trimis.

Cheltuielile de servire a conținutului către crawlerele AI pot să nu fie uriașe dacă este în mare parte text.

Ideea principală este că sistemele AI dezintermediază relația dintre utilizator și editor. Utilizatorii preferă răspunsurile AI agregate decât să facă clic pe site-uri web pentru a-și găsi răspunsurile.

Este logic ca majoritatea site-urilor web să se aștepte la mai puțin trafic. Cum se vor descurca site-ul și afacerea dvs.?

Surse:

- Centrul de Cercetare Pew - Athena Chapekis, 22 iulie 2025 (

- Cloudflare: Crawl-ul înainte de căderea recomandărilor (

- Cloudflare Radar: AI Insights - Crawl to Refer Ratio (

- Podcast: Schimbarea valorii conținutului în era AI (

9,68K

GPT-5 a fost lansat ieri. 94,6% pe AIME 2025. 74,9% pe banca SWE.

Pe măsură ce ne apropiem de limitele superioare ale acestor repere, ele mor.

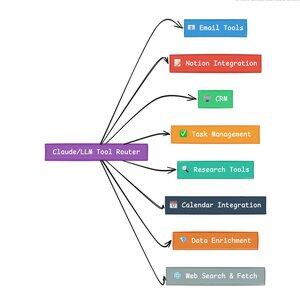

Ceea ce face ca GPT-5 și următoarea generație de modele să fie revoluționare nu sunt cunoștințele lor. Înseamnă să știi cum să acționezi. Pentru GPT-5 acest lucru se întâmplă la două niveluri. În primul rând, decideți ce model să utilizați. Dar în al doilea rând, și mai important, prin apelarea la instrumente.

Am trăit într-o eră în care LLM-urile stăpâneau recuperarea și reasamblarea cunoștințelor. Căutarea și codificarea consumatorilor, aplicațiile inițiale ucigașe, sunt în mod fundamental provocări de recuperare a cunoștințelor. Ambele organizează informațiile existente în moduri noi.

Am urcat acele dealuri și, ca urmare, concurența este mai intensă ca niciodată. Modelele Anthropic, OpenAI și Google converg către capabilități similare. Modelele chinezești și alternativele open source continuă să se apropie din ce în ce mai mult de cea mai modernă. Oricine poate prelua informații. Oricine poate genera text.

Noua axă a concurenței? Chemarea instrumentelor.

Apelarea instrumentelor transformă LLM-urile din consilieri în actori. Compensează două slăbiciuni critice ale modelului pe care modelele de limbaj pur nu le pot depăși.

În primul rând, orchestrarea fluxului de lucru. Modelele excelează la răspunsuri cu o singură lovitură, dar se luptă cu procese în mai mulți pași, cu stare. Instrumentele le permit să gestioneze fluxuri de lucru lungi, să urmărească progresul, să gestioneze erorile, să mențină contextul în zeci de operațiuni.

În al doilea rând, integrarea sistemului. LLM-urile trăiesc într-o lume doar text. Instrumentele le permit să interacționeze previzibil cu sisteme externe, cum ar fi baze de date, API-uri și software de întreprindere, transformând limbajul natural în acțiuni executabile.

În ultima lună am construit 58 de instrumente AI diferite.

Procesatori de e-mail. Integratori CRM. Actualizatori de noțiuni. Asistenți de cercetare. Fiecare instrument extinde capacitățile modelului într-un domeniu nou.

Cea mai importantă capacitate pentru AI este selectarea rapidă și corectă a instrumentului potrivit. Fiecare pas greșit ucide întregul flux de lucru.

Când spun "citiți acest e-mail de la Y Combinator și găsiți toate startup-urile care nu sunt în CRM", LLM-urile moderne execută o secvență complexă.

O comandă în limba engleză înlocuiește un întreg flux de lucru. Și aceasta este doar una simplă.

Și mai bine, modelul, configurat corespunzător cu instrumentele potrivite, își poate verifica propria muncă dacă sarcinile au fost finalizate la timp. Această buclă de autoverificare creează fiabilitate în fluxurile de lucru care este greu de obținut altfel.

Înmulțiți acest lucru la sute de angajați. Mii de fluxuri de lucru. Câștigurile de productivitate se compun exponențial.

Câștigătorii în lumea AI din viitor vor fi cei care sunt cei mai sofisticați în orchestrarea instrumentelor și direcționarea interogărilor potrivite. De fiecare dată. Odată ce aceste fluxuri de lucru sunt previzibile, atunci vom deveni cu toții manageri de agenți.

3,17K

2025 este anul agenților, iar capacitatea cheie a agenților este apelarea instrumentelor.

Când folosesc Claude Code, pot spune AI să caute un newsletter, să găsească toate link-urile către startup-uri, să verifice dacă există în CRM-ul nostru, cu o singură comandă. Acest lucru ar putea implica apelarea a două sau trei instrumente diferite.

Dar iată problema: utilizarea unui model de fundație mare pentru acest lucru este costisitoare, adesea limitată și supraputernică pentru o sarcină de selecție.

Care este cel mai bun mod de a construi un sistem agentic cu apelarea instrumentelor?

Răspunsul se află în modelele de acțiune mică. NVIDIA a lansat o lucrare convingătoare în care susține că "modelele de limbaj mic (SLM) sunt suficient de puternice, în mod inerent mai potrivite și neapărat mai economice pentru multe invocații în sistemele agentice".

Am testat diferite modele locale pentru a valida un exercițiu de reducere a costurilor. Am început cu un model de parametri Qwen3:30b, care funcționează, dar poate fi destul de lent pentru că este un model atât de mare, chiar dacă doar 3 miliarde din cei 30 de miliarde de parametri sunt activi la un moment dat.

Lucrarea NVIDIA recomandă modelul Salesforce xLAM – o arhitectură diferită numită model de acțiune mare special conceput pentru selectarea instrumentelor.

Așa că am efectuat un test propriu, fiecare model apelând la un instrument pentru a-mi lista sarcinile Asana.

Rezultatele au fost uimitoare: xLAM a finalizat sarcinile în 2,61 secunde cu 100% succes, în timp ce Qwen a avut nevoie de 9,82 secunde cu 92% succes – aproape de patru ori mai mult.

Acest experiment arată câștigul de viteză, dar există un compromis: câtă inteligență ar trebui să trăiască în model față de instrumentele în sine. Acest limitat

Cu modele mai mari, cum ar fi Qwen, instrumentele pot fi mai simple, deoarece modelul are o toleranță mai bună la erori și poate funcționa în jurul interfețelor prost proiectate. Modelul compensează limitările uneltei prin raționamentul forței brute.

Cu modele mai mici, modelul are o capacitate mai mică de a se recupera din greșeli, astfel încât instrumentele trebuie să fie mai robuste și logica de selecție mai precisă. Aceasta ar putea părea o limitare, dar este de fapt o caracteristică.

Această constrângere elimină rata de eroare compusă a instrumentelor înlănțuite LLM. Când modelele mari fac apeluri secvențiale ale instrumentelor, erorile se acumulează exponențial.

Modelele cu acțiune mică forțează un design mai bun al sistemului, păstrând cele mai bune LLM-uri și combinându-le cu modele specializate.

Această arhitectură este mai eficientă, mai rapidă și mai previzibilă.

5,3K

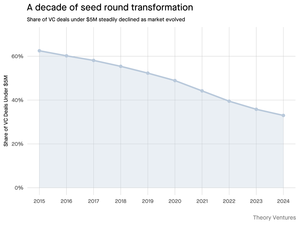

De ce se micșorează runda de semințe sub 5 milioane de dolari?

În urmă cu un deceniu, aceste runde mai mici formau coloana vertebrală a finanțării startup-urilor, cuprinzând peste 70% din toate tranzacțiile de pornire. Astăzi, datele PitchBook arată că această cifră a scăzut la mai puțin de jumătate.

Cifrele spun o poveste dură. Tranzacțiile sub 5 milioane de dolari au scăzut de la 62,5% în 2015 la 37,5% în 2024. Această scădere de 29,5 puncte procentuale a remodelat fundamental modul în care startup-urile își strâng primul capital instituțional.

Trei forțe au condus la această transformare. Putem descompune declinul pentru a înțelege ce a redus runda mică de semințe și de ce contează pentru fondatorii de astăzi.

4,7K

A fost atât de distractiv, Mario. Mulțumesc că m-ai invitat în emisiune pentru a vorbi despre tot ce se întâmplă pe piață!

Mario Gabriele 🦊22 iul. 2025

Cel mai recent episod al nostru cu Tomasz Tunguz este live!

Deceniul datelor

@ttunguz petrecut aproape două decenii transformând datele în informații despre investiții. După ce a susținut Looker, Expensify și Monte Carlo la Redpoint Ventures, a lansat @Theoryvc în 2022 cu o viziune îndrăzneață: să construiască o "corporație de investiții" în care cercetătorii, inginerii și operatorii să stea alături de investitori, creând hărți de piață în timp real și instrumente interne de inteligență artificială. Fondul său de debut s-a închis la 238 de milioane de dolari, urmat doar 19 luni mai târziu de un al doilea fond de 450 de milioane de dolari. Centrată pe date, inteligență artificială și infrastructură cripto, Theory operează în centrul celor mai importante schimbări tehnologice de astăzi. Explorăm modul în care datele remodelează capitalul de risc, de ce modelele tradiționale de investiții sunt perturbate și ce este nevoie pentru a construi o firmă care nu doar prezice viitorul, ci ajută în mod activ la crearea acestuia.

Ascultă acum:

• YouTube:

• Spotify:

•Măr:

Mulțumim sponsorilor incredibili care fac posibil podcastul:

✨ Brex — Soluția bancară pentru startup-uri:

✨ Generalist+ — Inteligență esențială pentru investitorii și tehnologii moderni:

Explorăm:

→ Cum funcționează modelul de "corporație de investiții" al Theory

→ De ce schimburile de criptomonede ar putea crea o cale viabilă către piețele publice pentru companiile de software cu capitalizare mică

→ Criza energetică iminentă – de ce centrele de date ar putea consuma 15% din energia electrică din SUA în cinci ani

→ Ascensiunea rapidă a monedelor stabile, pe măsură ce băncile majore direcționează 5-10% din dolarii americani prin ele

→ De ce Ethereum se confruntă cu o provocare existențială similară cu AWS care a pierdut teren în fața Azure în era AI

→ De ce Tomasz crede că câțiva agenți de astăzi vor deveni 100+ colegi digitali până la sfârșitul anului

→ De ce Meta pariază miliarde pe ochelari AR pentru a schimba modul în care interacționăm cu mașinile

→ Cum folosește Theory Ventures AI pentru a accelera cercetarea de piață, analiza tranzacțiilor și deciziile de investiții

… Și multe altele!

8K

OpenAI primește în medie 1 interogare per american pe zi.

Google primește aproximativ 4 interogări per american pe zi.

De atunci, 50% din interogările de căutare Google au AI Overview, ceea ce înseamnă că cel puțin 60% din căutările din SUA sunt acum AI.

A durat puțin mai mult decât mă așteptam să se întâmple asta. În 2024, am prezis că 50% din căutările consumatorilor vor fi bazate pe inteligență artificială. (

Dar AI a ajuns în căutare.

Dacă modelele de căutare Google sunt un indiciu, există o lege a puterii în comportamentul de căutare. Analiza SparkToro a comportamentului de căutare Google arată că prima treime dintre americanii care caută execută peste 80% din toate căutările - ceea ce înseamnă că utilizarea AI nu este probabil distribuită uniform - ca în viitor.

Site-urile web și companiile încep să simtă impactul acestui lucru. Articolul din The Economist "AI ucide web-ul. Poate ceva să-l salveze?", surprinde zeitgeist-ul într-un titlu. (

O mare majoritate a americanilor caută acum cu AI. Efectele de ordinul doi ale schimbării tiparelor de căutare vor veni în a doua jumătate a acestui an și mai mulți se vor întreba: "Ce s-a întâmplat cu traficul meu?" (

AI este un nou canal de distribuție și cei care îl folosesc vor câștiga cotă de piață.

- William Gibson a văzut mult mai departe în viitor!

- Aceasta se bazează pe o analiză a graficului SparkToro, este o analiză foarte simplă și are unele erori ca rezultat.

8,88K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante