Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 досягає точності 94,6% на AIME 2025, що свідчить про математичні міркування, близькі до людських.

Але попросіть його зробити запит до вашої бази даних, і показники успішності різко впадуть для підлітків.

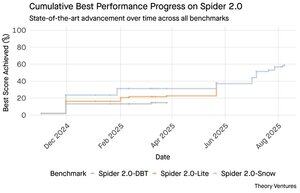

Тести Spider 2.0 показують величезну прогалину в можливостях штучного інтелекту. Spider 2.0 — це всеосяжний тест перетворення тексту в SQL, який перевіряє здатність моделей штучного інтелекту генерувати точні SQL-запити з питань природною мовою в реальних базах даних.

У той час як великі мовні моделі завоювали знання в математиці, кодуванні та міркуванні, перетворення тексту в SQL залишається вперто складним.

Три тести Spider 2.0 перевіряють реальні запити до баз даних у різних середовищах. Spider 2.0-Snow використовує бази даних Snowflake з 547 прикладами тестів, з піковою точністю 59,05%.

Spider 2.0-Lite охоплює BigQuery, Snowflake і SQLite ще 547 прикладами, досягаючи лише 37,84%. Spider 2.0-DBT тестує генерацію коду з DuckDB на 68 прикладах, досягнувши 39,71%.

Цей розрив у продуктивності не пов'язаний з відсутністю спроб. З листопада 2024 року за цими критеріями змагалися 56 заявок від 12 модельних сімейств.

Claude, OpenAI, DeepSeek та інші підштовхнули свої моделі до цих тестів. За останні дев'ять місяців прогрес був стабільним, приблизно з 2% до приблизно 60%.

Головоломка поглиблюється, коли ви розглядаєте обмеження SQL. SQL має обмежений словниковий запас у порівнянні з англійською, яка налічує 600 000 слів, або мовами програмування, які мають набагато ширші синтаксиси та бібліотеки. Крім того, є багато SQL для навчання.

У всякому разі, це має бути простіше, ніж відкриті завдання на міркування, де моделі зараз досягають успіху.

Проте навіть ідеальна генерація SQL не вирішить реальну бізнес-проблему. Кожна компанія визначає «дохід» по-різному.

Маркетинг вимірює вартість залучення клієнтів за витратами на кампанію, продажі розраховують її, використовуючи витрати на керівника бухгалтерського обліку, а фінанси включають повністю завантажені витрати співробітників. Ці семантичні відмінності створюють плутанину, яку технічна точність не може вирішити.

Результати Spider 2.0 вказують на фундаментальну істину про роботу з даними. Технічне володіння синтаксисом SQL – це лише відправна точка.

Справжня проблема полягає в бізнес-контексті. Розуміння того, що означають дані, як різні команди визначають показники та коли мають значення крайові випадки. Як я писав у книзі «Семантичні культиватори», міст між необробленими даними та бізнес-значенням вимагає людського судження, яке сучасний штучний інтелект не може відтворити.

8,8K

GPT-5 досягає точності 94,6% на AIME 2025, що свідчить про математичні міркування, близькі до людських.

Але попросіть його зробити запит до вашої бази даних, і показники успішності різко впадуть для підлітків.

Тести Spider 2.0 показують величезну прогалину в можливостях штучного інтелекту. Spider 2.0 — це всеосяжний тест перетворення тексту в SQL, який перевіряє здатність моделей штучного інтелекту генерувати точні SQL-запити з питань природною мовою в реальних базах даних.

У той час як великі мовні моделі завоювали знання в математиці, кодуванні та міркуванні, перетворення тексту в SQL залишається вперто складним.

Три тести Spider 2.0 перевіряють реальні запити до баз даних у різних середовищах. Spider 2.0-Snow використовує бази даних Snowflake з 547 прикладами тестів, з піковою точністю 59,05%.

Spider 2.0-Lite охоплює BigQuery, Snowflake і SQLite ще 547 прикладами, досягаючи лише 37,84%. Spider 2.0-DBT тестує генерацію коду з DuckDB на 68 прикладах, досягнувши 39,71%.

Цей розрив у продуктивності не пов'язаний з відсутністю спроб. З листопада 2024 року за цими критеріями змагалися 56 заявок від 12 модельних сімейств.

Claude, OpenAI, DeepSeek та інші підштовхнули свої моделі до цих тестів. За останні дев'ять місяців прогрес був стабільним, приблизно з 2% до приблизно 60%.

Головоломка поглиблюється, коли ви розглядаєте обмеження SQL. SQL має обмежений словниковий запас у порівнянні з англійською, яка налічує 600 000 слів, або мовами програмування, які мають набагато ширші синтаксиси та бібліотеки. Крім того, є багато SQL для навчання.

У всякому разі, це має бути простіше, ніж відкриті завдання на міркування, де моделі зараз досягають успіху.

Проте навіть ідеальна генерація SQL не вирішить реальну бізнес-проблему. Кожна компанія визначає «дохід» по-різному.

Маркетинг вимірює вартість залучення клієнтів за витратами на кампанію, продажі розраховують її, використовуючи витрати на керівника бухгалтерського обліку, а фінанси включають повністю завантажені витрати співробітників. Ці семантичні відмінності створюють плутанину, яку технічна точність не може вирішити.

Результати Spider 2.0 вказують на фундаментальну істину про роботу з даними. Технічне володіння синтаксисом SQL – це лише відправна точка.

Справжня проблема полягає в бізнес-контексті. Розуміння того, що означають дані, як різні команди визначають показники та коли мають значення крайові випадки. Як я писав у книзі «Семантичні культиватори», міст між необробленими даними та бізнес-значенням вимагає людського судження, яке сучасний штучний інтелект не може відтворити.

3,94K

Perplexity AI щойно зробила небажану пропозицію на суму 34,5 мільярда доларів за браузер Chrome від Google, намагаючись отримати вигоду з антимонопольного рішення, яке може змусити Google відмовитися від свого бізнесу браузерів.

Порівняння економіки Chrome з існуючою угодою Google Safari показує, чому браузер недооцінюється на 34,5 мільярда доларів.

Google платить Apple $18-20 млрд щорічно, щоб залишатися пошуковою системою Safari за замовчуванням¹, обслуговуючи приблизно 850 млн користувачів². Це означає 21 долар США за користувача на рік.

Пропозиція Perplexity оцінює Chrome у $32 млрд, що становить $9 на користувача на рік для 3,5 млрд користувачів³.

Якби користувачі Chrome дотримувалися тих самих умов, що й угода Google/Apple Safari, потенційний річний дохід браузера перевищив би 73 мільярди доларів.

Ці дані ґрунтуються на публічних оцінках, але є приблизними.

Це передбачає, що Google заплатить новому власнику Chrome аналогічну масштабовану плату за місце розташування в пошуку за замовчуванням. Враховуючи мультиплікатор ринкової капіталізації до доходу від 5x до 6x, Chrome коштує десь від $172 млрд до $630 млрд, що далеко від пропозиції в $34,5 млрд.

Chrome домінує на ринку з часткою 65%, порівняно з 18% у Safari. Продаж активів призведе до потрясіння на ринку пошукової реклами. Цінність утримання бюджетів рекламодавців важко переоцінити для ринкової капіталізації та позиції Google в екосистемі реклами.

Якщо Google буде змушений продавати Chrome, він зіткнеться з екзистенційним вибором. Платіть стільки, скільки потрібно, щоб залишатися пошуковою системою за замовчуванням, або спостерігайте, як конкуренти перетворюють її найцінніший канал збуту на кийок проти неї.

Скільки це коштує? Значна надбавка до простого мультиплікатора доходу.

¹ Bloomberg: Платежі Google на користь Apple у 2022 році досягли $20 млрд (

² ZipDo: важлива статистика Apple Safari у 2024 році (

³ Backlinko: частка ринку веб-браузерів у 2025 році (

⁴ Statcounter: частка ринку браузерів у всьому світі (

7,97K

У 1999 році доткоми почали оцінювати за трафіком. Показники IPO оберталися навколо очей.

Потім Google запустив AdWords, рекламну модель, засновану на кліках, і побудував бізнес на 273 мільярди доларів у 2024 році.

Але це може скоро змінитися: дослідження Pew Research у липні 2025 року показує, що користувачі натискають лише 8% результатів пошуку зі зведеннями штучного інтелекту, проти 15% без - скорочення на 47%. Лише 1% переходить за посиланнями у зведеннях про штучний інтелект.

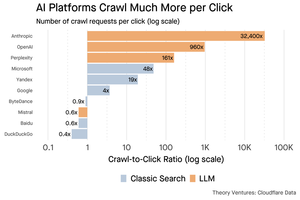

Дані Cloudflare показують, що платформи штучного інтелекту сканують контент набагато частіше, ніж повертають трафік: Anthropic сканує 32 400 сторінок на кожен 1 реферал, тоді як традиційні пошукові системи сканують контент лише кілька разів за кожного надісланого відвідувача.

Витрати на показ контенту сканерам штучного інтелекту можуть бути невеликими, якщо це переважно текст.

Важливішим моментом є те, що системи штучного інтелекту впливають на відносини між користувачем і видавцем. Користувачі віддають перевагу агрегованим відповідям штучного інтелекту, а не переходячи через веб-сайти, щоб знайти свої відповіді.

Логічно, що більшість сайтів повинні розраховувати на менший трафік. Як ваш сайт і ваш бізнес будуть з цим справлятися?

Джерел:

- Pew Research Center - Афіна Чапекіс, 22 липня 2025 р. (

- Cloudflare: Повзання перед падінням рефералів (

- Cloudflare Radar: AI Insights - співвідношення Crawl to Reference (

- Подкаст: Зміна цінності контенту в епоху штучного інтелекту (

9,68K

GPT-5 був запущений вчора. 94,6% на AIME 2025. 74,9% на SWE-bench.

У міру наближення до верхньої межі цих орієнтирів вони гинуть.

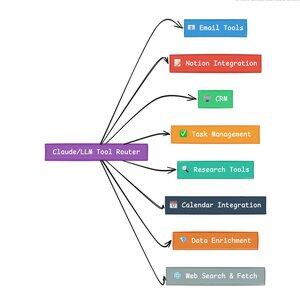

Що робить GPT-5 і наступне покоління моделей революційними, так це не їхні знання. Це знання того, як діяти. Для GPT-5 це відбувається на двох рівнях. По-перше, вирішивши, яку модель використовувати. Але по-друге, і що важливіше, через виклик інструментів.

Ми живемо в епоху, коли LLM освоїли знання, пошук і повторне складання. Пошук споживачів і кодування, початкові вбивчі програми, по суті, є проблемами отримання знань. І те, і інше систематизує наявну інформацію по-новому.

Ми піднялися на ці пагорби, і в результаті конкуренція стала сильнішою, ніж будь-коли. Моделі Anthropic, OpenAI та Google сходяться на схожих можливостях. Китайські моделі та альтернативи з відкритим вихідним кодом продовжують все більше наближатися до найсучасніших. Отримати інформацію може кожен. Згенерувати текст може кожен.

Нова вісь конкуренції? Виклик інструментів.

Виклик інструментів перетворює LLM з радників на акторів. Це компенсує дві критичні слабкості моделі, які моделі чистої мови не можуть подолати.

По-перше, оркестрування робочих процесів. Моделі чудово справляються з одномоментними реакціями, але мають проблеми з багатоступінчастими процесами зі збереженням стану. Інструменти дозволяють їм керувати тривалими робочими процесами, відстежувати прогрес, обробляти помилки, підтримувати контекст у десятках операцій.

По-друге, системна інтеграція. LLM живуть у світі лише тексту. Інструменти дозволяють їм передбачувано взаємодіяти із зовнішніми системами, такими як бази даних, API та корпоративне програмне забезпечення, перетворюючи природну мову на виконувані дії.

За останній місяць я створив 58 різних інструментів штучного інтелекту.

Обробники електронної пошти. Інтегратори CRM. Оновлювачі понять. Наукові співробітники. Кожен інструмент розширює можливості моделі в нову сферу.

Найважливішою здатністю для штучного інтелекту є швидкий і правильний вибір правильного інструменту. Кожен неправильно спрямований крок вбиває весь робочий процес.

Коли я кажу «прочитай цей лист від Y Combinator і знайди всі стартапи, яких немає в CRM», сучасні LLM виконують складну послідовність.

Одна команда англійською мовою замінює весь робочий процес. І це лише простий.

Ще краще, якщо модель, правильно налаштована за допомогою потрібних інструментів, зможе переконатися у власній роботі, що завдання були виконані вчасно. Цей цикл самоперевірки створює надійність у робочих процесах, якої важко досягти інакше.

Помножте це на сотні співробітників. Тисячі робочих процесів. Продуктивність зростає в геометричній прогресії.

Переможцями у майбутньому світі штучного інтелекту стануть ті, хто найдосвідченіший у оркеструванні інструментів та маршрутизації правильних запитів. Щоразу. Як тільки ці робочі процеси стануть передбачуваними, саме тоді ми всі станемо менеджерами агентів.

3,16K

2025 рік – це рік агентів, і ключовою здатністю агентів є виклик інструментів.

Коли я використовую Claude Code, я можу сказати штучному інтелекту, щоб він просіяв інформаційний бюлетень, знайшов усі посилання на стартапи, перевірив їх існування в нашій CRM за допомогою однієї команди. Це може включати два або три різні інструменти.

Але ось у чому проблема: використання великої моделі фундаменту для цього є дорогим, часто обмеженим за швидкістю та надмірно потужним для завдання вибору.

Який найкращий спосіб побудувати агентську систему за допомогою виклику інструментів?

Відповідь криється в моделях малої дії. NVIDIA випустила переконливу статтю, в якій стверджується, що «моделі на малій мові (SLM) є досить потужними, за своєю суттю більш придатними та обов'язково більш економічними для багатьох викликів в агентних системах».

Я тестував різні місцеві моделі, щоб підтвердити вправу зі скорочення витрат. Я почав з моделі параметрів Qwen3:30b, яка працює, але може бути досить повільною, тому що це така велика модель, хоча лише 3 мільярди з цих 30 мільярдів параметрів активні в будь-який момент часу.

У документі NVIDIA рекомендується модель Salesforce xLAM – іншу архітектуру, яку називають великою моделлю дії, спеціально розробленою для вибору інструментів.

Отже, я провів власний тест, під час якого кожна модель викликала інструмент для переліку моїх завдань в Asana.

Результати виявилися вражаючими: xLAM виконав завдання за 2,61 секунди зі 100% успіхом, тоді як Qwen зайняв 9,82 секунди з 92% успіхом – майже в чотири рази довше.

Цей експеримент показує приріст швидкості, але є компроміс: скільки інтелекту має жити в моделі порівняно з самими інструментами. Ця обмежена

З більшими моделями, такими як Qwen, інструменти можуть бути простішими, оскільки модель має кращу стійкість до помилок і може працювати в обхід погано розроблених інтерфейсів. Модель компенсує обмеженість інструменту за допомогою аргументації грубої сили.

У менших моделях модель має меншу здатність відновлюватися після помилок, тому інструменти повинні бути більш надійними, а логіка вибору більш точною. Це може здатися обмеженням, але насправді це функція.

Це обмеження усуває частоту помилок накопичення інструментів з ланцюгом LLM. Коли великі моделі здійснюють послідовні виклики інструментів, помилки накопичуються в геометричній прогресії.

Моделі малого ладу змушують вдосконалювати конструкцію системи, зберігаючи найкраще з LLM і поєднуючи його зі спеціалізованими моделями.

Ця архітектура є більш ефективною, швидкою та передбачуваною.

5,3K

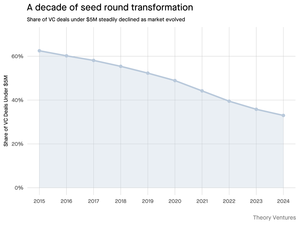

Чому початковий раунд менше $5 млн скорочується?

Десять років тому ці менші раунди сформували основу фінансування стартапів, на які припадало понад 70% усіх угод на посівному ринку. Сьогодні дані PitchBook показують, що ця цифра впала менш ніж удвічі.

Цифри говорять про сувору історію. Кількість угод на суму менше $5 млн знизилася з 62,5% у 2015 році до 37,5% у 2024 році. Це падіння на 29,5 відсоткових пунктів докорінно змінило те, як стартапи залучають свій перший інституційний капітал.

Рушійною силою цієї трансформації стали три сили. Ми можемо розкласти спад, щоб зрозуміти, що зменшило малий посівний раунд і чому це важливо для засновників сьогодні.

4,7K

Це було так весело, Маріо. Дякую, що запросили мене на шоу, щоб розповісти про все, що відбувається на ринку!

Mario Gabriele 🦊22 лип. 2025 р.

Наш останній епізод з Томашем Тунгузом у прямому ефірі!

Десятиліття даних

@ttunguz витратив майже два десятиліття на перетворення даних на інвестиційні ідеї. Після підтримки Looker, Expensify і Монте-Карло в Redpoint Ventures, він запустив @Theoryvc у 2022 році зі сміливим баченням: створити «інвестиційну корпорацію», де дослідники, інженери та оператори сидять поруч з інвесторами, створюючи ринкові карти в режимі реального часу та власні інструменти штучного інтелекту. Його дебютний фонд закрився на рівні $238 млн, а всього через 19 місяців з'явився другий фонд на $450 млн. Зосереджена на даних, штучному інтелекті та криптоінфраструктурі, Theory працює в основі найважливіших технологічних зрушень сьогодення. Ми досліджуємо, як дані змінюють венчурний капітал, чому руйнуються традиційні інвестиційні моделі та що потрібно для створення фірми, яка не просто передбачає майбутнє, а активно допомагає його створювати.

Слухайте зараз:

• Ютуб:

• Spotify:

•Яблуко:

Велика подяка неймовірним спонсорам, які роблять подкаст можливим:

✨ Brex — банківське рішення для стартапів:

✨ Generalist+ — необхідний інтелект для сучасних інвесторів і технологів:

Ми досліджуємо:

→ Як працює модель «інвестиційної корпорації» Theory

→ Чому криптобіржі можуть створити життєздатний шлях до публічних ринків для компаній, що займаються розробкою програмного забезпечення з невеликою капіталізацією

→ Криза електроенергії, що насувається: чому центри обробки даних можуть споживати 15% електроенергії в США протягом п'яти років

→ Стрімке зростання стейблкоїнів, оскільки великі банки переправляють через них 5-10% доларів США

→ Чому Ethereum стикається з екзистенційним викликом, подібним до того, як AWS поступається позиціями Azure в епоху штучного інтелекту

→ Чому Томаш вважає, що сьогоднішня жменька агентів стане 100+ цифровими співробітниками до кінця року

→ Чому Meta ставить мільярди на окуляри доповненої реальності, щоб змінити те, як ми взаємодіємо з машинами

→ Як Theory Ventures використовує штучний інтелект для прискорення дослідження ринку, аналізу угод та прийняття інвестиційних рішень

… І багато іншого!

8K

OpenAI отримує в середньому 1 запит на американця на день.

Google отримує близько 4 запитів на одного американця в день.

З тих пір 50% пошукових запитів Google мають AI Overviews, що означає, що принаймні 60% пошукових запитів у США тепер є штучним інтелектом.

Для цього знадобилося трохи більше часу, ніж я очікував. У 2024 році я прогнозував, що 50% пошукових запитів споживачів будуть на основі штучного інтелекту. (

Але ШІ прийшов у пошук.

Якщо шаблони пошуку Google є якимось показником, то в поведінці під час пошуку існує закон сили. Аналіз пошукової поведінки Google, проведений SparkToro, показує, що верхня третина американців, які займаються пошуком, виконують понад 80% усіх пошукових запитів – а це означає, що використання штучного інтелекту, швидше за все, не буде рівномірно розподілено – як і в майбутньому.

Веб-сайти та компанії починають відчувати наслідки цього. Стаття The Economist «Штучний інтелект вбиває Інтернет. Чи може щось його врятувати?» – фіксує дух часу в заголовку. (

Переважна більшість американців зараз шукають за допомогою штучного інтелекту. Ефекти другого порядку від зміни шаблонів пошуку з'являться в другій половині цього року, і більше людей будуть запитувати: «Що сталося з моїм трафіком?». (

Штучний інтелект – це новий канал збуту, і ті, хто ним скористається, отримають частку ринку.

- Вільям Гібсон бачив набагато далі в майбутнє!

- Він заснований на аналізі середньої точки діаграми SparkToro, є дуже простим аналізом, і в результаті має деяку похибку.

8,87K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги