المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

يحقق GPT-5 دقة بنسبة 94.6٪ في AIME 2025 ، مما يشير إلى تفكير رياضي شبه بشري.

ومع ذلك ، اطلب منه الاستعلام عن قاعدة البيانات الخاصة بك ، وتنخفض معدلات النجاح إلى المراهقين.

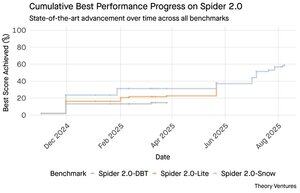

تكشف معايير Spider 2.0 عن فجوة كبيرة في قدرات الذكاء الاصطناعي. Spider 2.0 هو معيار شامل للنص إلى SQL يختبر قدرة نماذج الذكاء الاصطناعي على إنشاء استعلامات SQL دقيقة من أسئلة اللغة الطبيعية عبر قواعد بيانات العالم الحقيقي.

في حين أن نماذج اللغة الكبيرة قد غزت العمل المعرفي في الرياضيات والترميز والاستدلال ، إلا أن تحويل النص إلى SQL لا يزال صعبا بعناد.

تختبر معايير Spider 2.0 الثلاثة استعلام قاعدة البيانات في العالم الحقيقي عبر بيئات مختلفة. يستخدم Spider 2.0-Snow قواعد بيانات Snowflake مع 547 مثالا للاختبار ، وتبلغ ذروتها بدقة 59.05٪.

يمتد Spider 2.0-Lite إلى BigQuery و Snowflake و SQLite مع 547 مثالا آخر ، ليصل إلى 37.84٪ فقط. يختبر Spider 2.0-DBT إنشاء التعليمات البرمجية مقابل DuckDB مع 68 مثالا ، ويتصدر 39.71٪.

فجوة الأداء هذه ليست بسبب قلة المحاولة. منذ نوفمبر 2024 ، تنافست 56 طلبا من 12 عائلة نموذجية على هذه المعايير.

دفع كل من Claude و OpenAI و DeepSeek وآخرون نماذجهم ضد هذه الاختبارات. كان التقدم ثابتا ، من حوالي 2٪ إلى حوالي 60٪ ، في الأشهر التسعة الماضية.

يتعمق اللغز عندما تفكر في قيود SQL. تحتوي SQL على مفردات محدودة مقارنة باللغة الإنجليزية ، التي تحتوي على 600,000 كلمة ، أو لغات البرمجة التي تحتوي على تركيبات ومكتبات أوسع بكثير لتعرفها. بالإضافة إلى أن هناك الكثير من SQL للتدريب عليها.

إذا كان هناك أي شيء ، فيجب أن يكون هذا أسهل من مهام التفكير المفتوحة حيث تتفوق النماذج الآن.

ومع ذلك ، حتى جيل SQL المثالي لن يحل التحدي التجاري الحقيقي. تعرف كل شركة "الإيرادات" بشكل مختلف.

يقيس التسويق تكلفة اكتساب العملاء حسب إنفاق الحملة ، وتحسبها المبيعات باستخدام التكاليف التنفيذية للحساب ، ويشمل التمويل نفقات الموظفين المحملة بالكامل. تخلق هذه الاختلافات الدلالية ارتباكا لا تستطيع الدقة الفنية حله.

تشير نتائج Spider 2.0 إلى حقيقة أساسية حول عمل البيانات. الكفاءة الفنية في بناء جملة SQL هي مجرد نقطة دخول.

يكمن التحدي الحقيقي في سياق الأعمال. فهم ما تعنيه البيانات ، وكيف تحدد الفرق المختلفة المقاييس ، ومتى تكون حالات الحافة مهمة. كما كتبت في المزارعين الدلاليين ، يتطلب الجسر بين البيانات الأولية ومعنى العمل حكما بشريا لا يستطيع الذكاء الاصطناعي الحالي تكراره.

8.81K

يحقق GPT-5 دقة بنسبة 94.6٪ في AIME 2025 ، مما يشير إلى تفكير رياضي شبه بشري.

ومع ذلك ، اطلب منه الاستعلام عن قاعدة البيانات الخاصة بك ، وتنخفض معدلات النجاح إلى المراهقين.

تكشف معايير Spider 2.0 عن فجوة كبيرة في قدرات الذكاء الاصطناعي. Spider 2.0 هو معيار شامل للنص إلى SQL يختبر قدرة نماذج الذكاء الاصطناعي على إنشاء استعلامات SQL دقيقة من أسئلة اللغة الطبيعية عبر قواعد بيانات العالم الحقيقي.

في حين أن نماذج اللغة الكبيرة قد غزت العمل المعرفي في الرياضيات والترميز والاستدلال ، إلا أن تحويل النص إلى SQL لا يزال صعبا بعناد.

تختبر معايير Spider 2.0 الثلاثة استعلام قاعدة البيانات في العالم الحقيقي عبر بيئات مختلفة. يستخدم Spider 2.0-Snow قواعد بيانات Snowflake مع 547 مثالا للاختبار ، وتبلغ ذروتها بدقة 59.05٪.

يمتد Spider 2.0-Lite إلى BigQuery و Snowflake و SQLite مع 547 مثالا آخر ، ليصل إلى 37.84٪ فقط. يختبر Spider 2.0-DBT إنشاء التعليمات البرمجية مقابل DuckDB مع 68 مثالا ، ويتصدر 39.71٪.

فجوة الأداء هذه ليست بسبب قلة المحاولة. منذ نوفمبر 2024 ، تنافست 56 طلبا من 12 عائلة نموذجية على هذه المعايير.

دفع كل من Claude و OpenAI و DeepSeek وآخرون نماذجهم ضد هذه الاختبارات. كان التقدم ثابتا ، من حوالي 2٪ إلى حوالي 60٪ ، في الأشهر التسعة الماضية.

يتعمق اللغز عندما تفكر في قيود SQL. تحتوي SQL على مفردات محدودة مقارنة باللغة الإنجليزية ، التي تحتوي على 600,000 كلمة ، أو لغات البرمجة التي تحتوي على تركيبات ومكتبات أوسع بكثير لتعرفها. بالإضافة إلى أن هناك الكثير من SQL للتدريب عليها.

إذا كان هناك أي شيء ، فيجب أن يكون هذا أسهل من مهام التفكير المفتوحة حيث تتفوق النماذج الآن.

ومع ذلك ، حتى جيل SQL المثالي لن يحل التحدي التجاري الحقيقي. تعرف كل شركة "الإيرادات" بشكل مختلف.

يقيس التسويق تكلفة اكتساب العملاء حسب إنفاق الحملة ، وتحسبها المبيعات باستخدام التكاليف التنفيذية للحساب ، ويشمل التمويل نفقات الموظفين المحملة بالكامل. تخلق هذه الاختلافات الدلالية ارتباكا لا تستطيع الدقة الفنية حله.

تشير نتائج Spider 2.0 إلى حقيقة أساسية حول عمل البيانات. الكفاءة الفنية في بناء جملة SQL هي مجرد نقطة دخول.

يكمن التحدي الحقيقي في سياق الأعمال. فهم ما تعنيه البيانات ، وكيف تحدد الفرق المختلفة المقاييس ، ومتى تكون حالات الحافة مهمة. كما كتبت في المزارعين الدلاليين ، يتطلب الجسر بين البيانات الأولية ومعنى العمل حكما بشريا لا يستطيع الذكاء الاصطناعي الحالي تكراره.

3.95K

قدم الذكاء الاصطناعي الحيرة للتو عرضا غير مرغوب فيه بقيمة 34.5 مليار دولار لمتصفح Google Chrome ، في محاولة للاستفادة من حكم مكافحة الاحتكار المعلق الذي قد يجبر Google على تصفية أعمالها في المتصفح.

تكشف مقارنة اقتصاديات Chrome بصفقة Safari الحالية من Google عن سبب تقليل قيمة المتصفح بقيمة 34.5 مليار دولار.

تدفع Google لشركة Apple ما بين 18 إلى 20 مليار دولار سنويا لتظل محرك البحث الافتراضي ل Safari¹ ، حيث يخدم ما يقرب من 850 مليون مستخدم². هذا يترجم إلى 21 دولارا لكل مستخدم في السنة.

يقدر عرض Perplexity Chrome بمبلغ 32 مليار دولار ، أي 9 دولارات لكل مستخدم سنويا لمستخدميه البالغ عددهم 3.5 مليار دولار³.

إذا كان مستخدمو Chrome يفرضون نفس شروط صفقة Google / Apple Safari ، فإن الإيرادات السنوية المحتملة للمتصفح ستتجاوز 73 مليار دولار.

تستند هذه البيانات إلى تقديرات عامة ولكنها تقريبية.

يفترض هذا أن Google ستدفع لمالك Chrome الجديد رسوما مصغرة مماثلة لموضع البحث الافتراضي. بالنظر إلى مضاعف القيمة السوقية إلى الإيرادات من 5 إلى 6 أضعاف ، فإن قيمة Chrome تتراوح بين 172 مليار دولار و 630 مليار دولار ، وهي بعيدة كل البعد عن عرض 34.5 مليار دولار.

يهيمن Chrome على السوق بنسبة 65٪ من الحصة ، مقارنة ب 18٪ في Safari سيؤدي سحب الاستثمارات إلى اضطراب سوق الإعلانات على شبكة البحث. من الصعب المبالغة في تقدير قيمة الاحتفاظ بميزانيات المعلنين بالنسبة للقيمة السوقية لشركة Google ومكانتها في النظام البيئي للإعلانات.

إذا أجبرت على بيع Chrome ، فستواجه Google خيارا وجوديا. ادفع كل ما يلزم لتظل محرك البحث الافتراضي ، أو شاهد المنافسين وهم يحولون قناة التوزيع الأكثر قيمة إلى هراوة ضدها.

كم يستحق ذلك؟ علاوة كبيرة لمضاعفة الإيرادات البسيطة.

¹ بلومبرغ: بلغت مدفوعات Google لشركة Apple 20 مليار دولار في عام 2022 (

² ZipDo: إحصائيات Apple Safari الأساسية في عام 2024 (

³ Backlinko: حصة سوق متصفح الويب في عام 2025 (

⁴ Statcounter: حصة سوق المتصفح في جميع أنحاء العالم (

7.98K

في عام 1999 ، تم تقييم الدوت كوم على حركة المرور. تدور مقاييس الاكتتاب العام حول مقل العيون.

ثم أطلقت Google AdWords ، وهو نموذج إعلاني يعتمد على النقرات ، وأنشأت نشاطا تجاريا بقيمة 273 مليار دولار في عام 2024.

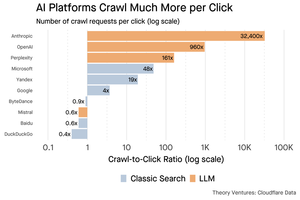

ولكن قد يكون كل هذا على وشك التغيير: كشفت دراسة Pew Research في يوليو 2025 أن المستخدمين ينقرون على 8٪ فقط من نتائج البحث مع ملخصات الذكاء الاصطناعي ، مقابل 15٪ بدون - انخفاض بنسبة 47٪. 1٪ فقط ينقرون من داخل ملخصات الذكاء الاصطناعي.

تظهر بيانات Cloudflare أن منصات الذكاء الاصطناعي تزحف إلى المحتوى أكثر بكثير مما تحيل حركة المرور مرة أخرى: يزحف Anthropic إلى 32,400 صفحة لكل إحالة واحدة ، بينما تقوم محركات البحث التقليدية بمسح المحتوى بضع مرات فقط لكل زائر يتم إرساله.

قد لا تكون تكلفة عرض المحتوى لبرامج زحف الذكاء الاصطناعي ضخمة إذا كانت نصية في الغالب.

النقطة الأكبر هي أن أنظمة الذكاء الاصطناعي تفصل عن العلاقة بين المستخدم والناشر. يفضل المستخدمون إجابات الذكاء الاصطناعي المجمعة على النقر فوق مواقع الويب للعثور على إجاباتهم.

من المنطقي أن تتوقع معظم مواقع الويب حركة مرور أقل. كيف سيتعامل معها موقع الويب الخاص بك وعملك؟

المصادر:

- مركز بيو للأبحاث - أثينا تشابيكيس ، 22 يوليو 2025 (

- Cloudflare: الزحف قبل سقوط الإحالات (

- رادار Cloudflare: رؤى الذكاء الاصطناعي - الزحف إلى نسبة الإحالة (

- بودكاست: القيمة المتغيرة للمحتوى في عصر الذكاء الاصطناعي (

9.69K

تم إطلاق GPT-5 أمس. 94.6٪ في AIME 2025. 74.9٪ على مقاعد البدلاء السويدية.

عندما نقترب من الحدود العليا لهذه المعايير ، فإنها تموت.

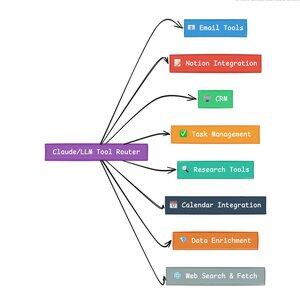

ما يجعل GPT-5 والجيل القادم من النماذج ثورية ليس معرفتهم. إنها معرفة كيفية التصرف. بالنسبة إلى GPT-5 ، يحدث هذا على مستويين. أولا ، تحديد النموذج الذي يجب استخدامه. ولكن ثانيا ، والأهم من ذلك ، من خلال استدعاء الأدوات.

لقد كنا نعيش في عصر أتقن فيه LLMs استرجاع المعرفة وإعادة تجميعها. يعد البحث والترميز للمستهلكين ، والتطبيقات القاتلة الأولية ، تحديات استرجاع المعرفة بشكل أساسي. كلاهما ينظم المعلومات الموجودة بطرق جديدة.

لقد تسلقنا تلك التلال ونتيجة لذلك أصبحت المنافسة أكثر حدة من أي وقت مضى. تتلاقى نماذج Anthrobic و OpenAI و Google على قدرات مماثلة. تستمر النماذج الصينية والبدائل مفتوحة المصدر في الاقتراب أكثر من أي وقت مضى من أحدث ما توصلت إليه التكنولوجيا يمكن للجميع استرداد المعلومات. يمكن للجميع إنشاء نص.

محور المنافسة الجديد؟ استدعاء الأدوات.

يحول استدعاء الأدوات LLMs من مستشارين إلى ممثلين. إنه يعوض عن ضعفين مهمين في النموذج لا تستطيع نماذج اللغة البحتة التغلب عليهما.

أولا ، تنسيق سير العمل. تتفوق النماذج في الاستجابات أحادية اللقطة ولكنها تكافح مع عمليات متعددة الخطوات ذات الحالة. تمكنهم الأدوات من إدارة مهام سير العمل الطويلة وتتبع التقدم ومعالجة الأخطاء والحفاظ على السياق عبر عشرات العمليات.

ثانيا ، تكامل النظام. يعيش LLMs في عالم نصي فقط. تتيح لهم الأدوات التفاعل بشكل متوقع مع الأنظمة الخارجية مثل قواعد البيانات وواجهات برمجة التطبيقات وبرامج المؤسسات ، مما يحول اللغة الطبيعية إلى إجراءات قابلة للتنفيذ.

في الشهر الماضي ، قمت ببناء 58 أداة الذكاء الاصطناعي المختلفة.

معالجات البريد الإلكتروني. تكامل CRM. محدثات الفكرة. مساعدو البحوث. تعمل كل أداة على توسيع إمكانات النموذج إلى مجال جديد.

أهم قدرة على الذكاء الاصطناعي هي اختيار الأداة المناسبة بسرعة وبشكل صحيح. كل خطوة تم توجيهها بشكل خاطئ تقتل سير العمل بأكمله.

عندما أقول "اقرأ هذا البريد الإلكتروني من Y Combinator وابحث عن جميع الشركات الناشئة غير الموجودة في CRM" ، فإن LLMs الحديثة تنفذ تسلسلا معقدا.

يحل أمر واحد باللغة الإنجليزية محل سير العمل بأكمله. وهذا مجرد واحد بسيط.

والأفضل من ذلك ، أن النموذج ، الذي تم إعداده بشكل صحيح باستخدام الأدوات المناسبة ، يمكنه التحقق من عمله الخاص بأن المهام قد اكتملت في الوقت المحدد. تخلق حلقة التحقق الذاتي هذه موثوقية في مهام سير العمل يصعب تحقيقها بطريقة أخرى.

اضرب هذا عبر مئات الموظفين. الآلاف من مهام سير العمل. تتراكم مكاسب الإنتاجية بشكل كبير.

سيكون الفائزون في عالم الذكاء الاصطناعي المستقبلي هم الأكثر تعقيدا في تنسيق الأدوات وتوجيه الاستعلامات الصحيحة. كل مرة. بمجرد أن تكون مهام سير العمل هذه قابلة للتنبؤ ، عندها سنصبح جميعا مديري وكلاء

3.17K

عام 2025 هو عام الوكلاء ، والقدرة الرئيسية للوكلاء هي أدوات الاستدعاء.

عند استخدام Claude Code ، يمكنني إخبار الذكاء الاصطناعي بالتدقيق في النشرة الإخبارية ، والعثور على جميع الروابط للشركات الناشئة ، والتحقق من وجودها في CRM الخاص بنا ، بأمر واحد. قد يتضمن ذلك استدعاء اثنين أو ثلاثة أدوات مختلفة.

ولكن هنا تكمن المشكلة: استخدام نموذج أساس كبير لهذا الغرض مكلف ، وغالبا ما يكون محدودا بمعدل ، ويتم التغلب عليه لمهمة الاختيار.

ما هي أفضل طريقة لبناء نظام وكيل باستخدام استدعاء الأداة؟

الجواب يكمن في نماذج العمل الصغيرة. أصدرت NVIDIA ورقة مقنعة تجادل بأن "نماذج اللغات الصغيرة (SLMs) قوية بما فيه الكفاية ، وأكثر ملاءمة بطبيعتها ، وبالضرورة أكثر اقتصادا للعديد من الدعاء في الأنظمة الوكيلة".

لقد كنت أختبر نماذج محلية مختلفة للتحقق من صحة تمرين خفض التكاليف. لقد بدأت بنموذج معلمة Qwen3: 30b ، والذي يعمل ولكنه يمكن أن يكون بطيئا جدا لأنه نموذج كبير ، على الرغم من أن 3 مليارات فقط من تلك المعلمات البالغ عددها 30 مليار معلمة نشطة في أي وقت.

توصي ورقة NVIDIA بنموذج Salesforce xLAM - وهي بنية مختلفة تسمى نموذج عمل كبير مصمم خصيصا لاختيار الأداة.

لذلك ، أجريت اختبارا خاصا بي ، كل نموذج يستدعي أداة لإدراج مهام Asana الخاصة بي.

كانت النتائج مذهلة: أكملت xLAM المهام في 2.61 ثانية بنجاح 100٪ ، بينما استغرق Qwen 9.82 ثانية بنجاح 92٪ - ما يقرب من أربعة أضعاف الوقت.

تظهر هذه التجربة كسب السرعة ، ولكن هناك مقايضة: مقدار الذكاء الذي يجب أن يعيش في النموذج مقابل الأدوات نفسها. هذا محدود

مع النماذج الأكبر مثل Qwen ، يمكن أن تكون الأدوات أبسط لأن النموذج يتمتع بقدرة أفضل على تحمل الأخطاء ويمكنه التغلب على واجهات سيئة التصميم. يعوض النموذج عن قيود الأداة من خلال التفكير بالقوة الغاشمة.

مع النماذج الأصغر ، يكون للنموذج قدرة أقل على التعافي من الأخطاء ، لذلك يجب أن تكون الأدوات أكثر قوة ومنطق الاختيار أكثر دقة. قد يبدو هذا قيدا ، لكنه في الواقع ميزة.

يزيل هذا القيد معدل الخطأ المركب للأدوات المتسلسلة LLM. عندما تقوم النماذج الكبيرة بإجراء استدعاءات متسلسلة للأدوات ، تتراكم الأخطاء بشكل كبير.

تفرض نماذج الحركة الصغيرة تصميما أفضل للنظام ، مع الحفاظ على أفضل ما في LLMs ودمجها مع النماذج المتخصصة.

هذه البنية أكثر كفاءة وأسرع وأكثر قابلية للتنبؤ.

5.31K

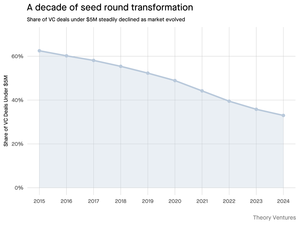

لماذا تتقلص الجولة الأولية التي تقل عن 5 ملايين دولار؟

قبل عقد من الزمان ، شكلت هذه الجولات الأصغر العمود الفقري لتمويل الشركات الناشئة ، حيث شكلت أكثر من 70٪ من جميع الصفقات الأولية. اليوم ، تكشف بيانات PitchBook أن هذا الرقم قد انخفض إلى أقل من النصف.

الأرقام تحكي قصة صارخة. انخفضت الصفقات التي تقل عن 5 ملايين دولار من 62.5٪ في عام 2015 إلى 37.5٪ في عام 2024. أعاد هذا الانخفاض البالغ 29.5 نقطة مئوية تشكيل كيفية قيام الشركات الناشئة بجمع أول رأس مال مؤسسي لها.

قادت ثلاث قوى هذا التحول. يمكننا تحليل التراجع لفهم ما الذي قلل من جولة البذور الصغيرة ولماذا يهم المؤسسين اليوم.

4.71K

كان هذا ممتعا جدا يا ماريو. شكرا لاستضافتي في العرض للحديث عن كل ما يحدث في السوق!

Mario Gabriele 🦊22 يوليو 2025

آخر حلقة لنا مع Tomasz Tunguz مباشرة!

عقد البيانات

أمضت @ttunguz ما يقرب من عقدين من الزمن في تحويل البيانات إلى رؤى استثمارية. بعد دعم Looker و Expensify و Monte Carlo في Redpoint Ventures ، أطلق @Theoryvc في عام 2022 برؤية جريئة: بناء "شركة استثمارية" حيث يجلس الباحثون والمهندسون والمشغلون جنبا إلى جنب مع المستثمرين ، وإنشاء خرائط السوق في الوقت الفعلي وأدوات الذكاء الاصطناعي داخلية. أغلق صندوقه الأول عند 238 مليون دولار ، تلاه بعد 19 شهرا فقط صندوق ثان بقيمة 450 مليون دولار. تتمحور Theory حول البيانات الذكاء الاصطناعي والبنية التحتية للعملات المشفرة ، وتعمل في قلب التحولات التكنولوجية الأكثر أهمية اليوم. نستكشف كيف تعيد البيانات تشكيل رأس المال الاستثماري ، ولماذا تتعطل نماذج الاستثمار التقليدية ، وما يتطلبه الأمر لبناء شركة لا تتنبأ بالمستقبل فحسب ، بل تساعد بنشاط في إنشائه.

استمع الآن:

• يوتيوب:

• سبوتيفي:

•تفاح:

شكرا جزيلا للرعاة الرائعين الذين يجعلون البودكاست ممكنا:

✨ Brex - الحل المصرفي للشركات الناشئة:

✨ عام + - ذكاء أساسي للمستثمرين والتقنيين الحديثين:

نحن نستكشف:

→ كيف يعمل نموذج "الشركة الاستثمارية" الخاص بالنظرية

→ لماذا يمكن لبورصات العملات المشفرة أن تخلق مسارا قابلا للتطبيق إلى الأسواق العامة لشركات البرمجيات الصغيرة

→ أزمة الطاقة التي تلوح في الأفق - لماذا يمكن لمراكز البيانات أن تستهلك 15٪ من الكهرباء الأمريكية في غضون خمس سنوات

→ الصعود السريع للعملات المستقرة حيث توجه البنوك الكبرى 5-10٪ من الدولار الأمريكي من خلالها

→ لماذا تواجه Ethereum تحديا وجوديا مشابها لخسارة AWS لصالح Azure في عصر الذكاء الاصطناعي

→ لماذا يعتقد توماس أن حفنة من الوكلاء اليوم سيصبحون 100+ زملاء عمل رقميين بحلول نهاية العام

→ لماذا تراهن Meta بالمليارات على نظارات الواقع المعزز لتغيير طريقة تفاعلنا مع الآلات

→ كيف تستخدم Theory Ventures الذكاء الاصطناعي لتسريع أبحاث السوق وتحليل الصفقات وقرارات الاستثمار

… وأكثر من ذلك بكثير!

8.01K

يتلقى OpenAI في المتوسط استعلاما واحدا لكل أمريكي في اليوم.

تتلقى Google حوالي 4 استفسارات لكل أمريكي يوميا.

منذ ذلك الحين ، تحتوي 50٪ من استعلامات بحث Google على نظرة عامة على الذكاء الاصطناعي ، وهذا يعني أن 60٪ على الأقل من عمليات البحث في الولايات المتحدة أصبحت الآن الذكاء الاصطناعي.

لقد استغرق الأمر وقتا أطول قليلا مما كنت أتوقع حتى يحدث هذا. في عام 2024 ، توقعت أن 50٪ من بحث المستهلك سيكون ممكنا الذكاء الاصطناعي. (

لكن الذكاء الاصطناعي وصل في البحث.

إذا كانت أنماط بحث Google تشير إلى أي مؤشر ، فهناك قانون قوة في سلوك البحث. يظهر تحليل SparkToro لسلوك بحث Google أن الثلث العلوي من الأمريكيين الذين يبحثون ينفذون ما يزيد عن 80٪ من جميع عمليات البحث - مما يعني أنه من غير المحتمل أن يتم توزيع استخدام الذكاء الاصطناعي بالتساوي - مثل المستقبل.

بدأت مواقع الويب والشركات تشعر بآثار ذلك. مقال الإيكونوميست "الذكاء الاصطناعي يقتل الويب. هل يمكن لأي شيء أن ينقذها؟" يلتقط روح العصر في العنوان. (

تبحث الغالبية العظمى من الأمريكيين الآن باستخدام الذكاء الاصطناعي. ستأتي تأثيرات الدرجة الثانية من أنماط البحث المتغيرة في النصف الثاني من هذا العام وسيسأل المزيد ، "ماذا حدث لحركة المرور الخاصة بي؟" (

الذكاء الاصطناعي هو قناة توزيع جديدة وأولئك الذين يستولون عليها سيحصلون على حصة في السوق.

- رأى ويليام جيبسون أبعد من ذلك بكثير في المستقبل!

- يعتمد هذا على تحليل نقطة المنتصف لمخطط SparkToro ، وهو تحليل بسيط للغاية ، وله بعض الأخطاء نتيجة لذلك.

8.88K

الأفضل

المُتصدِّرة

التطبيقات المفضلة

رائج على السلسة

رائج على منصة X

أهم عمليات التمويل الأخيرة

الأبرز