Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 erreicht eine Genauigkeit von 94,6 % bei AIME 2025, was auf nahezu menschliches mathematisches Denken hindeutet.

Fragen Sie es jedoch, Ihre Datenbank abzufragen, sinken die Erfolgsquoten auf die Teenagerjahre.

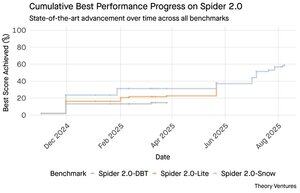

Die Spider 2.0-Benchmarks zeigen eine klaffende Lücke in den KI-Fähigkeiten. Spider 2.0 ist ein umfassender Text-zu-SQL-Benchmark, der die Fähigkeit von KI-Modellen testet, genaue SQL-Abfragen aus natürlichen Sprachfragen über reale Datenbanken zu generieren.

Während große Sprachmodelle die Wissensarbeit in Mathematik, Programmierung und Argumentation erobert haben, bleibt Text-zu-SQL hartnäckig schwierig.

Die drei Spider 2.0-Benchmarks testen die Abfrage von realen Datenbanken in verschiedenen Umgebungen. Spider 2.0-Snow verwendet Snowflake-Datenbanken mit 547 Testbeispielen und erreicht eine Höchstgenauigkeit von 59,05 %.

Spider 2.0-Lite umfasst BigQuery, Snowflake und SQLite mit weiteren 547 Beispielen und erreicht nur 37,84 %. Spider 2.0-DBT testet die Codegenerierung gegen DuckDB mit 68 Beispielen und erreicht maximal 39,71 %.

Diese Leistungsdifferenz ist nicht auf mangelnde Bemühungen zurückzuführen. Seit November 2024 haben 56 Einreichungen von 12 Modellfamilien an diesen Benchmarks teilgenommen.

Claude, OpenAI, DeepSeek und andere haben alle ihre Modelle gegen diese Tests getestet. Der Fortschritt war stetig, von etwa 2 % auf etwa 60 % in den letzten neun Monaten.

Das Rätsel vertieft sich, wenn man die Einschränkungen von SQL betrachtet. SQL hat einen begrenzten Wortschatz im Vergleich zu Englisch, das 600.000 Wörter hat, oder Programmiersprachen, die viel breitere Syntax und Bibliotheken haben, die man kennen muss. Außerdem gibt es jede Menge SQL, auf dem man trainieren kann.

Wenn überhaupt, sollte dies einfacher sein als die offenen Denkaufgaben, in denen Modelle jetzt glänzen.

Doch selbst perfekte SQL-Generierung würde die echte geschäftliche Herausforderung nicht lösen. Jedes Unternehmen definiert "Umsatz" anders.

Das Marketing misst die Kundenakquisitionskosten anhand der Kampagnenausgaben, der Vertrieb berechnet sie unter Verwendung der Kosten für Account Executives, und die Finanzen beziehen die vollbelasteten Mitarbeiterkosten ein. Diese semantischen Unterschiede schaffen Verwirrung, die technische Genauigkeit nicht lösen kann.

Die Ergebnisse von Spider 2.0 weisen auf eine grundlegende Wahrheit über Datenarbeit hin. Technische Kompetenz in SQL-Syntax ist nur der Einstieg.

Die echte Herausforderung liegt im Geschäftskontext. Zu verstehen, was die Daten bedeuten, wie verschiedene Teams Kennzahlen definieren und wann Randfälle wichtig sind. Wie ich in Semantic Cultivators geschrieben habe, erfordert die Brücke zwischen Rohdaten und geschäftlicher Bedeutung menschliches Urteilsvermögen, das die aktuelle KI nicht replizieren kann.

8,8K

GPT-5 erreicht eine Genauigkeit von 94,6 % bei AIME 2025, was auf nahezu menschliches mathematisches Denken hindeutet.

Fragen Sie es jedoch, Ihre Datenbank abzufragen, sinken die Erfolgsquoten auf die Teenagerjahre.

Die Spider 2.0-Benchmarks zeigen eine klaffende Lücke in den KI-Fähigkeiten. Spider 2.0 ist ein umfassender Text-zu-SQL-Benchmark, der die Fähigkeit von KI-Modellen testet, genaue SQL-Abfragen aus natürlichen Sprachfragen über reale Datenbanken zu generieren.

Während große Sprachmodelle die Wissensarbeit in Mathematik, Programmierung und Argumentation erobert haben, bleibt Text-zu-SQL hartnäckig schwierig.

Die drei Spider 2.0-Benchmarks testen die Abfrage von realen Datenbanken in verschiedenen Umgebungen. Spider 2.0-Snow verwendet Snowflake-Datenbanken mit 547 Testbeispielen und erreicht eine Höchstgenauigkeit von 59,05 %.

Spider 2.0-Lite umfasst BigQuery, Snowflake und SQLite mit weiteren 547 Beispielen und erreicht nur 37,84 %. Spider 2.0-DBT testet die Codegenerierung gegen DuckDB mit 68 Beispielen und erreicht maximal 39,71 %.

Diese Leistungsdifferenz ist nicht auf mangelnde Bemühungen zurückzuführen. Seit November 2024 haben 56 Einreichungen von 12 Modellfamilien an diesen Benchmarks teilgenommen.

Claude, OpenAI, DeepSeek und andere haben alle ihre Modelle gegen diese Tests getestet. Der Fortschritt war stetig, von etwa 2 % auf etwa 60 % in den letzten neun Monaten.

Das Rätsel vertieft sich, wenn man die Einschränkungen von SQL betrachtet. SQL hat einen begrenzten Wortschatz im Vergleich zu Englisch, das 600.000 Wörter hat, oder Programmiersprachen, die viel breitere Syntax und Bibliotheken haben, die man kennen muss. Außerdem gibt es jede Menge SQL, auf dem man trainieren kann.

Wenn überhaupt, sollte dies einfacher sein als die offenen Denkaufgaben, in denen Modelle jetzt glänzen.

Doch selbst perfekte SQL-Generierung würde die echte geschäftliche Herausforderung nicht lösen. Jedes Unternehmen definiert "Umsatz" anders.

Das Marketing misst die Kundenakquisitionskosten anhand der Kampagnenausgaben, der Vertrieb berechnet sie unter Verwendung der Kosten für Account Executives, und die Finanzen beziehen die vollbelasteten Mitarbeiterkosten ein. Diese semantischen Unterschiede schaffen Verwirrung, die technische Genauigkeit nicht lösen kann.

Die Ergebnisse von Spider 2.0 weisen auf eine grundlegende Wahrheit über Datenarbeit hin. Technische Kompetenz in SQL-Syntax ist nur der Einstieg.

Die echte Herausforderung liegt im Geschäftskontext. Zu verstehen, was die Daten bedeuten, wie verschiedene Teams Kennzahlen definieren und wann Randfälle wichtig sind. Wie ich in Semantic Cultivators geschrieben habe, erfordert die Brücke zwischen Rohdaten und geschäftlicher Bedeutung menschliches Urteilsvermögen, das die aktuelle KI nicht replizieren kann.

3,94K

Perplexity AI hat gerade ein unverlangtes Angebot über 34,5 Milliarden Dollar für Googles Chrome-Browser gemacht, um von dem bevorstehenden Antitrust-Urteil zu profitieren, das Google zwingen könnte, sein Browser-Geschäft abzutreten.

Ein Vergleich der Wirtschaftlichkeit von Chrome mit dem bestehenden Safari-Deal von Google zeigt, warum 34,5 Milliarden Dollar den Browser unterbewerten.

Google zahlt Apple jährlich 18-20 Milliarden Dollar, um der Standard-Suchmaschine von Safari zu bleiben¹, und bedient damit etwa 850 Millionen Nutzer². Das entspricht 21 Dollar pro Nutzer und Jahr.

Das Angebot von Perplexity bewertet Chrome mit 32 Milliarden Dollar, was 9 Dollar pro Nutzer und Jahr für seine 3,5 Milliarden Nutzer³ entspricht.

Wenn Chrome-Nutzer die gleichen Bedingungen wie der Google/Apple-Safari-Deal hätten, würde das jährliche Umsatzpotenzial des Browsers 73 Milliarden Dollar übersteigen.

Diese Daten basieren auf öffentlichen Schätzungen, sind jedoch eine Annäherung.

Es wird davon ausgegangen, dass Google einem neuen Eigentümer von Chrome eine ähnliche skalierte Gebühr für die Standard-Suchplatzierung zahlen würde. Angesichts eines Marktwert-zu-Umsatz-Verhältnisses von 5x bis 6x ist Chrome zwischen 172 Milliarden und 630 Milliarden Dollar wert, was weit entfernt ist von dem Angebot über 34,5 Milliarden Dollar.

Chrome dominiert den Markt mit einem Anteil von 65%⁴, verglichen mit 18% für Safari. Eine Abspaltung würde den Markt für Suchanzeigen in Aufruhr versetzen. Der Wert, die Budgets der Werbetreibenden zu halten, lässt sich für Googles Marktkapitalisierung und Position im Werbe-Ökosystem kaum überschätzen.

Wenn Google gezwungen wäre, Chrome zu verkaufen, stünde es vor einer existenziellen Wahl. Zahle, was nötig ist, um die Standard-Suchmaschine zu bleiben, oder sieh zu, wie Wettbewerber seinen wertvollsten Vertriebskanal gegen ihn verwenden.

Wie viel ist das wert? Ein erheblicher Aufschlag auf ein einfaches Umsatzmultiple.

¹ Bloomberg: Googles Zahlungen an Apple erreichten 20 Milliarden Dollar im Jahr 2022 (

² ZipDo: Wesentliche Apple Safari Statistiken im Jahr 2024 (

³ Backlinko: Marktanteil von Webbrowsern im Jahr 2025 (

⁴ Statcounter: Marktanteil von Browsern weltweit (

7,97K

Im Jahr 1999 wurden die Dotcoms nach ihrem Traffic bewertet. Die IPO-Metriken drehten sich um die Anzahl der Besucher.

Dann startete Google AdWords, ein Werbemodell, das auf Klicks basierte, und baute 2024 ein Geschäft im Wert von 273 Milliarden Dollar auf.

Aber das könnte sich alles bald ändern: Eine Studie des Pew Research Centers aus Juli 2025 zeigt, dass Nutzer nur 8 % der Suchergebnisse mit KI-Zusammenfassungen anklicken, im Vergleich zu 15 % ohne - ein Rückgang um 47 %. Nur 1 % klicken von innerhalb der KI-Zusammenfassungen weiter.

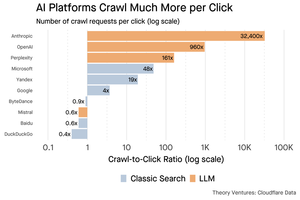

Daten von Cloudflare zeigen, dass KI-Plattformen Inhalte viel häufiger crawlen, als sie Traffic zurückverweisen: Anthropic crawlt 32.400 Seiten für jede 1 Empfehlung, während traditionelle Suchmaschinen Inhalte nur ein paar Mal pro gesendetem Besucher scannen.

Die Kosten für die Bereitstellung von Inhalten für die KI-Crawler könnten nicht hoch sein, wenn es sich hauptsächlich um Text handelt.

Der größere Punkt ist, dass KI-Systeme die Beziehung zwischen Nutzer und Publisher entintermediieren. Nutzer ziehen aggregierte KI-Antworten vor, anstatt durch Websites zu klicken, um ihre Antworten zu finden.

Es ist logisch, dass die meisten Websites mit weniger Traffic rechnen sollten. Wie wird Ihre Website und Ihr Geschäft damit umgehen?

Quellen:

- Pew Research Center - Athena Chapekis, 22. Juli 2025 (

- Cloudflare: Der Crawl vor dem Fall der Empfehlungen (

- Cloudflare Radar: KI-Einblicke - Crawl-zu-Referenz-Verhältnis (

- Podcast: Der sich verändernde Wert von Inhalten im KI-Zeitalter (

9,68K

GPT-5 wurde gestern veröffentlicht. 94,6 % bei AIME 2025. 74,9 % bei SWE-bench.

Wenn wir uns den oberen Grenzen dieser Benchmarks nähern, sterben sie.

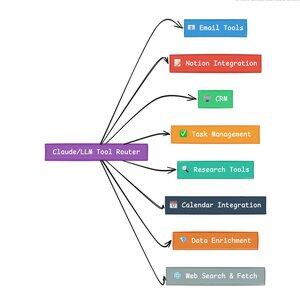

Was GPT-5 und die nächste Generation von Modellen revolutionär macht, ist nicht ihr Wissen. Es ist das Wissen, wie man handelt. Für GPT-5 geschieht dies auf zwei Ebenen. Zuerst, welches Modell zu verwenden ist. Aber zweitens, und noch wichtiger, durch das Aufrufen von Werkzeugen.

Wir leben in einer Ära, in der LLMs das Abrufen und die Wiederzusammenstellung von Wissen gemeistert haben. Die anfänglichen Killeranwendungen, die Verbrauchersuche und das Programmieren, sind im Grunde Herausforderungen des Wissensabrufs. Beide organisieren bestehende Informationen auf neue Weise.

Wir haben diese Hügel erklommen und als Ergebnis ist der Wettbewerb intensiver als je zuvor. Die Modelle von Anthropic, OpenAI und Google nähern sich ähnlichen Fähigkeiten. Chinesische Modelle und Open-Source-Alternativen drängen weiterhin immer näher an den Stand der Technik. Jeder kann Informationen abrufen. Jeder kann Text generieren.

Die neue Achse des Wettbewerbs? Werkzeugaufrufe.

Das Aufrufen von Werkzeugen verwandelt LLMs von Beratern zu Akteuren. Es kompensiert zwei kritische Schwächen von Modellen, die reine Sprachmodelle nicht überwinden können.

Erstens, Workflow-Orchestrierung. Modelle sind bei einmaligen Antworten hervorragend, haben aber Schwierigkeiten mit mehrstufigen, zustandsbehafteten Prozessen. Werkzeuge ermöglichen es ihnen, lange Workflows zu verwalten, den Fortschritt zu verfolgen, Fehler zu behandeln und den Kontext über Dutzende von Operationen hinweg aufrechtzuerhalten.

Zweitens, Systemintegration. LLMs leben in einer textbasierten Welt. Werkzeuge ermöglichen es ihnen, vorhersehbar mit externen Systemen wie Datenbanken, APIs und Unternehmenssoftware zu interagieren, indem sie natürliche Sprache in ausführbare Aktionen umwandeln.

Im letzten Monat habe ich 58 verschiedene KI-Tools entwickelt.

E-Mail-Prozessoren. CRM-Integratoren. Notion-Aktualisierer. Forschungsassistenten. Jedes Werkzeug erweitert die Fähigkeiten des Modells in einen neuen Bereich.

Die wichtigste Fähigkeit für KI ist es, das richtige Werkzeug schnell und korrekt auszuwählen. Jeder fehlgeleitete Schritt tötet den gesamten Workflow.

Wenn ich sage: „Lies diese E-Mail von Y Combinator und finde alle Startups, die nicht im CRM sind“, führen moderne LLMs eine komplexe Sequenz aus.

Ein Befehl in Englisch ersetzt einen gesamten Workflow. Und das ist nur ein einfacher.

Noch besser, das Modell, richtig eingerichtet mit den richtigen Werkzeugen, kann seine eigene Arbeit überprüfen, dass die Aufgaben rechtzeitig abgeschlossen wurden. Diese Selbstverifizierungs-Schleife schafft Zuverlässigkeit in Workflows, die sonst schwer zu erreichen ist.

Multipliziere dies über Hunderte von Mitarbeitern. Tausende von Workflows. Die Produktivitätsgewinne kumulieren exponentiell.

Die Gewinner in der zukünftigen KI-Welt werden die sein, die am raffiniertesten darin sind, Werkzeuge zu orchestrieren und die richtigen Abfragen zu leiten. Jedes Mal. Sobald diese Workflows vorhersehbar sind, werden wir alle Agentenmanager werden.

3,16K

2025 ist das Jahr der Agenten, und die Schlüsselkompetenz von Agenten ist das Aufrufen von Tools.

Wenn ich Claude Code benutze, kann ich der KI sagen, sie soll einen Newsletter durchforsten, alle Links zu Startups finden, überprüfen, ob sie in unserem CRM existieren, und das mit einem einzigen Befehl. Das könnte beinhalten, dass zwei oder drei verschiedene Tools aufgerufen werden.

Aber hier ist das Problem: Die Verwendung eines großen Basis-Modells dafür ist teuer, oft rate-limitiert und überdimensioniert für eine Auswahlaufgabe.

Was ist der beste Weg, ein agentisches System mit Tool-Aufrufen zu bauen?

Die Antwort liegt in kleinen Aktionsmodellen. NVIDIA hat ein überzeugendes Papier veröffentlicht, das argumentiert, dass "kleine Sprachmodelle (SLMs) ausreichend leistungsfähig, von Natur aus geeigneter und notwendigerweise wirtschaftlicher für viele Aufrufe in agentischen Systemen sind."

Ich habe verschiedene lokale Modelle getestet, um eine Kostenreduzierung zu validieren. Ich begann mit einem Qwen3:30b-Parameter-Modell, das funktioniert, aber ziemlich langsam sein kann, weil es ein so großes Modell ist, obwohl nur 3 Milliarden dieser 30 Milliarden Parameter zu einem bestimmten Zeitpunkt aktiv sind.

Das NVIDIA-Papier empfiehlt das Salesforce xLAM-Modell – eine andere Architektur, die als großes Aktionsmodell speziell für die Tool-Auswahl entwickelt wurde.

Also habe ich einen eigenen Test durchgeführt, bei dem jedes Modell ein Tool aufruft, um meine Asana-Aufgaben aufzulisten.

Die Ergebnisse waren auffällig: xLAM hat die Aufgaben in 2,61 Sekunden mit 100 % Erfolg abgeschlossen, während Qwen 9,82 Sekunden mit 92 % Erfolg benötigte – fast viermal so lange.

Dieses Experiment zeigt den Geschwindigkeitsgewinn, aber es gibt einen Kompromiss: Wie viel Intelligenz sollte im Modell versus in den Tools selbst leben. Dies ist begrenzt.

Bei größeren Modellen wie Qwen können die Tools einfacher sein, weil das Modell eine bessere Fehlertoleranz hat und mit schlecht gestalteten Schnittstellen umgehen kann. Das Modell kompensiert die Einschränkungen der Tools durch brutale Logik.

Bei kleineren Modellen hat das Modell weniger Kapazität, um sich von Fehlern zu erholen, sodass die Tools robuster sein müssen und die Auswahllogik präziser. Das mag wie eine Einschränkung erscheinen, ist aber tatsächlich ein Merkmal.

Diese Einschränkung beseitigt die kumulative Fehlerquote von LLM-verketteten Tools. Wenn große Modelle sequenzielle Tool-Aufrufe machen, sammeln sich Fehler exponentiell an.

Kleine Aktionsmodelle zwingen zu einem besseren Systemdesign, indem sie das Beste aus LLMs bewahren und mit spezialisierten Modellen kombinieren.

Diese Architektur ist effizienter, schneller und vorhersehbarer.

5,29K

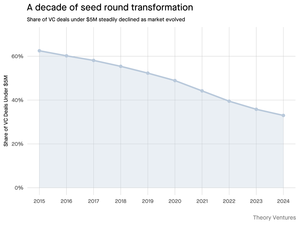

Warum schrumpft die Seed-Runde unter 5 Millionen Dollar?

Vor einem Jahrzehnt bildeten diese kleineren Runden das Rückgrat der Startup-Finanzierung und machten über 70 % aller Seed-Deals aus. Heute zeigt die PitchBook-Daten, dass diese Zahl auf weniger als die Hälfte gefallen ist.

Die Zahlen erzählen eine klare Geschichte. Deals unter 5 Millionen Dollar sind von 62,5 % im Jahr 2015 auf 37,5 % im Jahr 2024 gesunken. Dieser Rückgang um 29,5 Prozentpunkte hat die Art und Weise, wie Startups ihr erstes institutionelles Kapital beschaffen, grundlegend verändert.

Drei Kräfte trieben diese Transformation voran. Wir können den Rückgang analysieren, um zu verstehen, was die kleine Seed-Runde reduziert hat und warum das für Gründer heute von Bedeutung ist.

4,7K

Das hat so viel Spaß gemacht, Mario. Danke, dass du mich in die Show eingeladen hast, um über alles zu sprechen, was auf dem Markt passiert!

Mario Gabriele 🦊22. Juli 2025

Unsere neueste Episode mit Tomasz Tunguz ist live!

Das Jahrzehnt der Daten

@ttunguz hat fast zwei Jahrzehnte damit verbracht, Daten in Investitionsinsights umzuwandeln. Nachdem er Looker, Expensify und Monte Carlo bei Redpoint Ventures unterstützt hat, gründete er 2022 @Theoryvc mit einer mutigen Vision: eine "Investitionsgesellschaft" aufzubauen, in der Forscher, Ingenieure und Betreiber Seite an Seite mit Investoren sitzen, um Echtzeit-Marktkarten und interne KI-Tools zu erstellen. Sein Debütfonds schloss bei 238 Millionen Dollar, gefolgt nur 19 Monate später von einem zweiten Fonds über 450 Millionen Dollar. Im Mittelpunkt stehen Daten, KI und Krypto-Infrastruktur, Theory agiert im Herzen der heutigen bedeutendsten technologischen Veränderungen. Wir erkunden, wie Daten das Risikokapital umgestalten, warum traditionelle Investitionsmodelle gestört werden und was es braucht, um eine Firma aufzubauen, die nicht nur die Zukunft vorhersagt, sondern aktiv dabei hilft, sie zu gestalten.

Jetzt anhören:

• YouTube:

• Spotify:

• Apple:

Ein großes Dankeschön an die unglaublichen Sponsoren, die den Podcast möglich machen:

✨ Brex — Die Banklösung für Startups:

✨ Generalist+ — Wesentliche Informationen für moderne Investoren und Technologen:

Wir erkunden:

→ Wie das Modell der "Investitionsgesellschaft" von Theory funktioniert

→ Warum Krypto-Börsen einen gangbaren Weg zu den öffentlichen Märkten für kleine Softwareunternehmen schaffen könnten

→ Der drohende Energieengpass – warum Rechenzentren innerhalb von fünf Jahren 15 % des US-Stroms verbrauchen könnten

→ Der rasante Aufstieg der Stablecoins, während große Banken 5-10 % der US-Dollar über sie leiten

→ Warum Ethereum vor einer existenziellen Herausforderung steht, ähnlich wie AWS an Boden gegenüber Azure im KI-Zeitalter verliert

→ Warum Tomasz glaubt, dass die heutigen wenigen Akteure bis zum Jahresende 100+ digitale Mitarbeiter werden

→ Warum Meta Milliarden auf AR-Brillen setzt, um zu verändern, wie wir mit Maschinen interagieren

→ Wie Theory Ventures KI nutzt, um Marktforschung, Deal-Analyse und Investitionsentscheidungen zu beschleunigen

…Und vieles mehr!

8K

OpenAI erhält im Durchschnitt 1 Anfrage pro Amerikaner pro Tag.

Google erhält etwa 4 Anfragen pro Amerikaner pro Tag.

Da 50% der Google-Suchanfragen KI-Übersichten enthalten, bedeutet dies, dass mindestens 60% der US-Suchen jetzt KI-basiert sind.

Es hat etwas länger gedauert, als ich erwartet hatte, dass dies passiert. Für 2024 hatte ich vorhergesagt, dass 50% der Verbrauchersuchen KI-unterstützt sein würden. (

Aber KI ist in der Suche angekommen.

Wenn die Suchmuster von Google irgendeinen Hinweis geben, gibt es ein Potenzgesetz im Suchverhalten. Die Analyse von SparkToro zum Google-Suchverhalten zeigt, dass das obere Drittel der Amerikaner, die suchen, über 80% aller Suchen ausführt - was bedeutet, dass die Nutzung von KI wahrscheinlich nicht gleichmäßig verteilt ist - wie die Zukunft.

Websites und Unternehmen beginnen, die Auswirkungen davon zu spüren. Der Artikel von The Economist „KI tötet das Web. Kann irgendetwas es retten?“ fängt den Zeitgeist in einer Überschrift ein. (

Eine überwältigende Mehrheit der Amerikaner sucht jetzt mit KI. Die sekundären Auswirkungen der sich ändernden Suchmuster werden in der zweiten Hälfte dieses Jahres eintreffen, und mehr werden fragen: „Was ist mit meinem Traffic passiert?“ (

KI ist ein neuer Vertriebskanal, und diejenigen, die ihn ergreifen, werden Marktanteile gewinnen.

- William Gibson sah viel weiter in die Zukunft!

- Dies basiert auf einer Mittelwertanalyse des SparkToro-Diagramms, ist eine sehr einfache Analyse und hat daher einige Fehler.

8,87K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten