Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 uppnår en noggrannhet på 94,6 % på AIME 2025, vilket tyder på ett matematiskt resonemang som ligger nära människan.

Men be den att fråga din databas, och framgångsfrekvensen sjunker till tonåren.

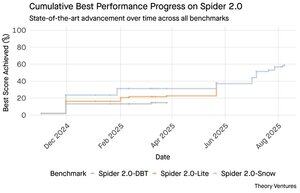

Spider 2.0-benchmarks avslöjar en gapande lucka i AI-kapaciteten. Spider 2.0 är ett omfattande text-till-SQL-benchmark som testar AI-modellers förmåga att generera korrekta SQL-frågor från frågor på naturligt språk i verkliga databaser.

Medan stora språkmodeller har erövrat kunskapsarbete inom matematik, kodning och resonemang, är text-till-SQL fortfarande envist svårt.

De tre Spider 2.0-prestandatesterna testar verkliga databasfrågor i olika miljöer. Spider 2.0-Snow använder Snowflake-databaser med 547 testexempel, med en topp på 59,05 % noggrannhet.

Spider 2.0-Lite sträcker sig över BigQuery, Snowflake och SQLite med ytterligare 547 exempel och når endast 37,84 %. Spider 2.0-DBT testar kodgenerering mot DuckDB med 68 exempel och toppar på 39,71 %.

Denna prestationsklyfta beror inte på brist på försök. Sedan november 2024 har 56 bidrag från 12 modellfamiljer tävlat på dessa riktmärken.

Claude, OpenAI, DeepSeek och andra har alla drivit sina modeller mot dessa tester. Framstegen har varit stadiga, från ungefär 2 % till cirka 60 %, under de senaste nio månaderna.

Pusslet fördjupas när man tänker på SQL:s begränsningar. SQL har ett begränsat ordförråd jämfört med engelska, som har 600 000 ord, eller programmeringsspråk som har mycket bredare syntaxer och bibliotek att känna till. Dessutom finns det gott om SQL där ute att träna på.

Om något borde detta vara enklare än de öppna resonemangsuppgifterna där modeller nu utmärker sig.

Men inte ens en perfekt SQL-generering skulle lösa den verkliga affärsutmaningen. Varje företag definierar "intäkt" på olika sätt.

Marknadsföring mäter kundanskaffningskostnader efter kampanjutgifter, försäljning beräknar det med hjälp av kontochefskostnader och ekonomi inkluderar fullt belastade personalkostnader. Dessa semantiska skillnader skapar förvirring som teknisk noggrannhet inte kan lösa.

Resultaten från Spider 2.0 pekar på en grundläggande sanning om dataarbete. Teknisk kompetens i SQL-syntax är bara startpunkten.

Den verkliga utmaningen ligger i affärssammanhanget. Förstå vad data betyder, hur olika team definierar mätvärden och när gränsfall är viktiga. Som jag skrev om i Semantic Cultivators kräver bron mellan rådata och affärsmening mänskligt omdöme som dagens AI inte kan replikera.

8,8K

GPT-5 uppnår en noggrannhet på 94,6 % på AIME 2025, vilket tyder på ett matematiskt resonemang som ligger nära människan.

Men be den att fråga din databas, och framgångsfrekvensen sjunker till tonåren.

Spider 2.0-benchmarks avslöjar en gapande lucka i AI-kapaciteten. Spider 2.0 är ett omfattande text-till-SQL-benchmark som testar AI-modellers förmåga att generera korrekta SQL-frågor från frågor på naturligt språk i verkliga databaser.

Medan stora språkmodeller har erövrat kunskapsarbete inom matematik, kodning och resonemang, är text-till-SQL fortfarande envist svårt.

De tre Spider 2.0-prestandatesterna testar verkliga databasfrågor i olika miljöer. Spider 2.0-Snow använder Snowflake-databaser med 547 testexempel, med en topp på 59,05 % noggrannhet.

Spider 2.0-Lite sträcker sig över BigQuery, Snowflake och SQLite med ytterligare 547 exempel och når endast 37,84 %. Spider 2.0-DBT testar kodgenerering mot DuckDB med 68 exempel och toppar på 39,71 %.

Denna prestationsklyfta beror inte på brist på försök. Sedan november 2024 har 56 bidrag från 12 modellfamiljer tävlat på dessa riktmärken.

Claude, OpenAI, DeepSeek och andra har alla drivit sina modeller mot dessa tester. Framstegen har varit stadiga, från ungefär 2 % till cirka 60 %, under de senaste nio månaderna.

Pusslet fördjupas när man tänker på SQL:s begränsningar. SQL har ett begränsat ordförråd jämfört med engelska, som har 600 000 ord, eller programmeringsspråk som har mycket bredare syntaxer och bibliotek att känna till. Dessutom finns det gott om SQL där ute att träna på.

Om något borde detta vara enklare än de öppna resonemangsuppgifterna där modeller nu utmärker sig.

Men inte ens en perfekt SQL-generering skulle lösa den verkliga affärsutmaningen. Varje företag definierar "intäkt" på olika sätt.

Marknadsföring mäter kundanskaffningskostnader efter kampanjutgifter, försäljning beräknar det med hjälp av kontochefskostnader och ekonomi inkluderar fullt belastade personalkostnader. Dessa semantiska skillnader skapar förvirring som teknisk noggrannhet inte kan lösa.

Resultaten från Spider 2.0 pekar på en grundläggande sanning om dataarbete. Teknisk kompetens i SQL-syntax är bara startpunkten.

Den verkliga utmaningen ligger i affärssammanhanget. Förstå vad data betyder, hur olika team definierar mätvärden och när gränsfall är viktiga. Som jag skrev om i Semantic Cultivators kräver bron mellan rådata och affärsmening mänskligt omdöme som dagens AI inte kan replikera.

3,94K

Perplexity AI har precis lagt ett oönskat bud på 34,5 miljarder dollar för Googles webbläsare Chrome i ett försök att dra nytta av den väntande antitrustdomen som kan tvinga Google att avyttra sin webbläsarverksamhet.

En jämförelse mellan Chromes ekonomi och Googles befintliga Safari-affär avslöjar varför 34,5 miljarder dollar undervärderar webbläsaren.

Google betalar Apple 18–20 miljarder dollar per år för att förbli Safaris standardsökmotor¹ och betjäna cirka 850 miljoner användare². Detta översätts till $21 per användare och år.

Perplexity-erbjudandet värderar Chrome till 32 miljarder dollar, vilket är 9 dollar per användare och år för dess 3,5 miljarder användare³.

Om Chrome-användare krävde samma villkor som Google/Apple Safari-affären skulle webbläsarens årliga intäktspotential överstiga 73 miljarder dollar.

Dessa uppgifter bygger på offentliga uppskattningar men är en approximation.

Detta förutsätter att Google skulle betala en ny ägare av Chrome en liknande avgift för standardsökplaceringen. Med tanke på ett marknadsvärde på 5x till 6x per intäktsmultipel är Chrome värt någonstans mellan 172 miljarder dollar och 630 miljarder dollar, vilket är långt ifrån erbjudandet på 34,5 miljarder dollar.

Chrome dominerar marknaden med en andel på 65 %⁴, jämfört med Safaris 18 %. En avyttring skulle sätta käppar i hjulet för sökannonser. Värdet av att hålla annonsörernas budgetar är svårt att överskatta för Googles marknadsvärde och position i annonsekosystemet.

Om Google tvingas sälja Chrome skulle de ställas inför ett existentiellt val. Betala vad som krävs för att förbli standardsökmotorn, eller se på när konkurrenterna förvandlar dess mest värdefulla distributionskanal till en påk mot den.

Hur mycket är det värt? En betydande premie till en enkel intäktsmultipel.

¹ Bloomberg: Googles betalningar till Apple uppgick till 20 miljarder dollar 2022 (

² ZipDo: Viktig statistik för Apple Safari 2024 (

³ Backlinko: Marknadsandel för webbläsare år 2025 (

⁴ Statcounter: Marknadsandel för webbläsare över hela världen (

7,97K

År 1999 värderades dotcom-företagen efter trafiken. Mätvärden för börsintroduktioner kretsade kring ögonglober.

Sedan lanserade Google AdWords, en annonsmodell som bygger på klick, och byggde upp en verksamhet på 273 miljarder dollar 2024.

Men det kan vara på väg att förändras : Pew Researchs studie från juli 2025 visar att användarna bara klickar på 8 % av sökresultaten med AI-sammanfattningar, jämfört med 15 % utan - en minskning med 47 %. Endast 1 % klickar sig vidare från AI-sammanfattningar.

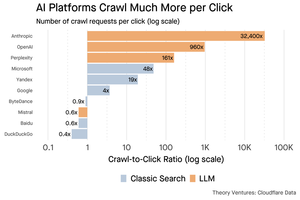

Cloudflare-data visar att AI-plattformar genomsöker innehåll mycket mer än de hänvisar trafik tillbaka: Anthropic genomsöker 32 400 sidor för varje 1 hänvisning, medan traditionella sökmotorer skannar innehåll bara ett par gånger per besökare som skickas.

Kostnaden för att visa innehåll för AI-sökrobotarna kanske inte är enorm om det mestadels är text.

Den större poängen är att AI-system skapar en mellanliggande relation mellan användare och utgivare. Användare föredrar aggregerade AI-svar framför att klicka sig igenom webbplatser för att hitta sina svar.

Det är logiskt att de flesta webbplatser bör förvänta sig mindre trafik. Hur kommer din webbplats och ditt företag att hantera det?

Källor:

- Pew Research Center - Athena Chapekis, 22 juli 2025 (

- Cloudflare: Genomsökningen före fallet av hänvisningar (

- Cloudflare Radar: AI Insights - Krypa för att hänvisa förhållande (

- Podcast: Innehållets skiftande värde i AI-åldern (

9,68K

GPT-5 lanserades igår. 94,6 % på AIME 2025. 74,9% på SWE-bänk.

När vi närmar oss de övre gränserna för dessa riktmärken dör de.

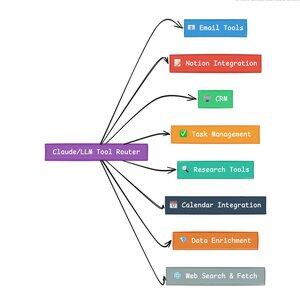

Det som gör GPT-5 och nästa generations modeller revolutionerande är inte deras kunskap. Det är att veta hur man ska agera. För GPT-5 sker detta på två nivåer. Först måste du bestämma vilken modell som ska användas. Men för det andra, och ännu viktigare, genom att ringa verktyg.

Vi har levt i en tid där LLM:er behärskade kunskapshämtning och återmontering. Konsumentsökning och kodning, de första mördarapplikationerna, är i grunden kunskapssökningsutmaningar. Båda organiserar befintlig information på nya sätt.

Vi har bestigit dessa kullar och som ett resultat av detta är konkurrensen mer intensiv än någonsin. Anthropic, OpenAI och Googles modeller konvergerar på liknande funktioner. Kinesiska modeller och alternativ med öppen källkod fortsätter att pressa sig allt närmare den senaste tekniken. Alla kan hämta information. Alla kan generera text.

Den nya konkurrensaxeln? Verktygs-anrop.

Verktygsanrop förvandlar LLM:er från rådgivare till aktörer. Det kompenserar för två kritiska svagheter i modellen som rena språkmodeller inte kan övervinna.

För det första, orkestrering av arbetsflöden. Modeller utmärker sig vid enstaka svar men kämpar med tillståndskänsliga processer i flera steg. Verktyg gör det möjligt för dem att hantera långa arbetsflöden, spåra framsteg, hantera fel och upprätthålla sammanhang i dussintals operationer.

För det andra, systemintegration. LLM:er lever i en värld med endast text. Med hjälp av verktyg kan de samverka på ett förutsägbart sätt med externa system som databaser, API:er och företagsprogramvara, och omvandla naturligt språk till körbara åtgärder.

Under den senaste månaden har jag byggt 58 olika AI-verktyg.

Processorer för e-post. CRM-integratörer. Uppdaterare av begrepp. Forskningsassistenter. Varje verktyg utökar modellens funktioner till en ny domän.

Den viktigaste förmågan för AI är att välja rätt verktyg snabbt och korrekt. Varje feldirigerat steg dödar hela arbetsflödet.

När jag säger "läs det här e-postmeddelandet från Y Combinator och hitta alla nystartade företag som inte finns i CRM", utför moderna LLM:er en komplex sekvens.

Ett kommando på engelska ersätter ett helt arbetsflöde. Och det här är bara en enkel fråga.

Ännu bättre är att modellen, korrekt inställd med rätt verktyg, kan verifiera sitt eget arbete att uppgifterna slutfördes i tid. Denna självverifieringsloop skapar tillförlitlighet i arbetsflöden som är svår att uppnå annars.

Multiplicera detta över hundratals anställda. Tusentals arbetsflöden. Produktivitetsvinsterna ökar exponentiellt.

Vinnarna i framtidens AI-värld kommer att vara de som är mest sofistikerade på att orkestrera verktyg och dirigera rätt frågor. Varje gång. När dessa arbetsflöden är förutsägbara, det är då vi alla kommer att bli agentchefer.

3,17K

2025 är agenternas år, och agenternas viktigaste förmåga är att ringa verktyg.

När jag använder Claude Code kan jag be AI:n att sålla igenom ett nyhetsbrev, hitta alla länkar till nystartade företag, verifiera att de finns i vårt CRM, med ett enda kommando. Det kan handla om att två eller tre olika verktyg anropas.

Men här är problemet: att använda en stor grundmodell för detta är dyrt, ofta hastighetsbegränsat och överdrivet för en urvalsuppgift.

Vad är det bästa sättet att bygga ett agentiskt system med verktygsanrop?

Svaret ligger i små handlingsmodeller. NVIDIA släppte en övertygande artikel där de hävdade att "Små språkmodeller (SLM) är tillräckligt kraftfulla, i sig mer lämpliga och nödvändigtvis mer ekonomiska för många anrop i agentiska system."

Jag har testat olika lokala modeller för att validera en kostnadsminskningsövning. Jag började med en Qwen3:30b parametermodell, som fungerar men kan vara ganska långsam eftersom det är en så stor modell, trots att bara 3 miljarder av dessa 30 miljarder parametrar är aktiva samtidigt.

NVIDIA-rapporten rekommenderar Salesforce xLAM-modellen – en annan arkitektur som kallas en stor åtgärdsmodell som är särskilt utformad för verktygsval.

Så jag körde ett eget test, där varje modell anropade ett verktyg för att lista mina Asana-uppgifter.

Resultaten var slående: xLAM slutförde uppgifter på 2,61 sekunder med 100 % framgång, medan Qwen tog 9,82 sekunder med 92 % framgång – nästan fyra gånger så lång tid.

Det här experimentet visar hastighetsvinsten, men det finns en kompromiss: hur mycket intelligens som ska finnas i modellen jämfört med i själva verktygen. Denna begränsade

Med större modeller som Qwen kan verktygen vara enklare eftersom modellen har bättre feltolerans och kan kringgå dåligt utformade gränssnitt. Modellen kompenserar för verktygsbegränsningar genom brute-force-resonemang.

Med mindre modeller har modellen mindre kapacitet att återhämta sig från misstag, så verktygen måste vara mer robusta och urvalslogiken mer exakt. Detta kan tyckas vara en begränsning, men det är faktiskt en funktion.

Denna begränsning eliminerar den sammansatta felfrekvensen för LLM-länkade verktyg. När stora modeller gör sekventiella verktygsanrop ackumuleras fel exponentiellt.

Små actionmodeller tvingar fram bättre systemdesign, behåller det bästa av LLM:er och kombinerar det med specialiserade modeller.

Den här arkitekturen är effektivare, snabbare och mer förutsägbar.

5,3K

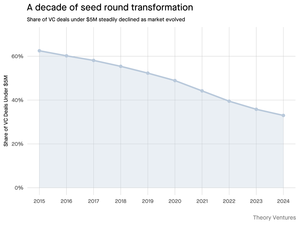

Varför krymper såddrundan på under 5 miljoner dollar?

För ett decennium sedan utgjorde dessa mindre rundor ryggraden i startup-finansieringen och utgjorde över 70 % av alla såddaffärer. Idag visar PitchBook-data att den siffran har sjunkit till mindre än hälften.

Siffrorna berättar en dyster historia. Affärer under 5 miljoner dollar minskade från 62,5 % 2015 till 37,5 % 2024. Denna minskning med 29,5 procentenheter förändrade i grunden hur nystartade företag samlar in sitt första institutionella kapital.

Tre krafter drev denna omvandling. Vi kan bryta ner nedgången för att förstå vad som minskade den lilla såddrundan och varför det är viktigt för grundare idag.

4,7K

Det här var så kul, Mario. Tack för att jag fick vara med i programmet för att prata om allt som händer på marknaden!

Mario Gabriele 🦊22 juli 2025

Our latest episode with Tomasz Tunguz is live!

The Decade of Data

@ttunguz has spent almost two decades turning data into investment insights. After backing Looker, Expensify, and Monte Carlo at Redpoint Ventures, he launched @Theoryvc in 2022 with a bold vision: build an "investing corporation" where researchers, engineers, and operators sit alongside investors, creating real-time market maps and in-house AI tooling. His debut fund closed at $238 million, followed just 19 months later by a $450 million second fund. Centered on data, AI, and crypto infrastructure, Theory operates at the heart of today's most consequential technological shifts. We explore how data is reshaping venture capital, why traditional investment models are being disrupted, and what it takes to build a firm that doesn't just predict the future but actively helps create it.

Listen now:

• YouTube:

• Spotify:

• Apple:

A big thank you to the incredible sponsors that make the podcast possible:

✨ Brex — The banking solution for startups:

✨ Generalist+ — Essential intelligence for modern investors and technologists:

We explore:

→ How Theory’s “investing corporation” model works

→ Why crypto exchanges could create a viable path to public markets for small-cap software companies

→ The looming power crunch—why data centers could consume 15% of U.S. electricity within five years

→ Stablecoins’ rapid ascent as major banks route 5‑10% of U.S. dollars through them

→ Why Ethereum faces an existential challenge similar to AWS losing ground to Azure in the AI era

→ Why Tomasz believes today’s handful of agents will become 100+ digital co‑workers by year‑end

→ Why Meta is betting billions on AR glasses to change how we interact with machines

→ How Theory Ventures uses AI to accelerate market research, deal analysis, and investment decisions

…And much more!

8K

OpenAI tar emot i genomsnitt 1 fråga per amerikan och dag.

Google får cirka 4 frågor per amerikan och dag.

Sedan dess har 50 % av Googles sökfrågor AI-översikter, vilket innebär att minst 60 % av sökningarna i USA nu är AI.

Det har tagit lite längre tid än jag förväntade mig för detta att hända. År 2024 förutspådde jag att 50 % av konsumenternas sökningar skulle vara AI-aktiverade. (

Men AI har kommit in i sökandet.

Om Googles sökmönster är någon indikation finns det en maktlag i sökbeteendet. SparkToros analys av Googles sökbeteende visar att den översta tredjedelen av amerikanerna som söker utför uppemot 80 % av alla sökningar - vilket innebär att AI-användningen sannolikt inte är jämnt fördelad - precis som i framtiden.

Webbplatser och företag börjar känna av effekterna av detta. The Economists artikel "AI dödar webben. Kan något rädda den?" fångar tidsandan i en rubrik. (

En överväldigande majoritet av amerikanerna söker nu med AI. Den andra ordningens effekter från förändrade sökmönster kommer under andra halvåret i år och fler kommer att fråga, "Vad hände med min trafik?" (

AI är en ny distributionskanal och de som tar tag i den kommer att vinna marknadsandelar.

- William Gibson såg mycket längre in i framtiden!

- Detta är baserat på en mittpunktsanalys av SparkToro-diagrammet, är en mycket enkel analys och har vissa fel som resultat.

8,87K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda