Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 osiąga 94,6% dokładności w AIME 2025, co sugeruje niemal ludzkie rozumowanie matematyczne.

Jednak gdy poprosisz go o zapytanie do twojej bazy danych, wskaźniki sukcesu spadają do nastolatków.

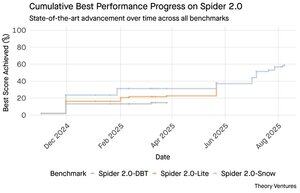

Benchmarki Spider 2.0 ujawniają ogromną lukę w możliwościach AI. Spider 2.0 to kompleksowy benchmark text-to-SQL, który testuje zdolność modeli AI do generowania dokładnych zapytań SQL z naturalnych pytań językowych w rzeczywistych bazach danych.

Podczas gdy duże modele językowe opanowały pracę związaną z wiedzą w matematyce, kodowaniu i rozumowaniu, text-to-SQL pozostaje upartym wyzwaniem.

Trzy benchmarki Spider 2.0 testują zapytania do rzeczywistych baz danych w różnych środowiskach. Spider 2.0-Snow wykorzystuje bazy danych Snowflake z 547 przykładami testowymi, osiągając szczytową dokładność na poziomie 59,05%.

Spider 2.0-Lite obejmuje BigQuery, Snowflake i SQLite z kolejnymi 547 przykładami, osiągając jedynie 37,84%. Spider 2.0-DBT testuje generację kodu w DuckDB z 68 przykładami, osiągając maksymalnie 39,71%.

Ta luka w wydajności nie wynika z braku prób. Od listopada 2024 roku 56 zgłoszeń z 12 rodzin modeli rywalizowało w tych benchmarkach.

Claude, OpenAI, DeepSeek i inni wszyscy testowali swoje modele w tych testach. Postęp był stały, od około 2% do około 60% w ciągu ostatnich dziewięciu miesięcy.

Zagadka pogłębia się, gdy weźmiesz pod uwagę ograniczenia SQL. SQL ma ograniczony słownik w porównaniu do angielskiego, który ma 600 000 słów, czy języków programowania, które mają znacznie szersze składnie i biblioteki do poznania. Poza tym jest mnóstwo SQL do trenowania.

Jeśli już, to powinno być łatwiejsze niż otwarte zadania rozumowania, w których modele teraz błyszczą.

Jednak nawet doskonała generacja SQL nie rozwiązałaby prawdziwego wyzwania biznesowego. Każda firma definiuje "przychód" inaczej.

Marketing mierzy koszt pozyskania klienta według wydatków na kampanię, sprzedaż oblicza go na podstawie kosztów menedżerów kont, a finanse uwzględniają całkowite wydatki pracowników. Te różnice semantyczne tworzą zamieszanie, którego techniczna dokładność nie może rozwiązać.

Wyniki Spider 2.0 wskazują na fundamentalną prawdę o pracy z danymi. Techniczna biegłość w składni SQL to tylko punkt wyjścia.

Prawdziwe wyzwanie leży w kontekście biznesowym. Zrozumienie, co oznaczają dane, jak różne zespoły definiują metryki i kiedy przypadki brzegowe mają znaczenie. Jak pisałem w Semantic Cultivators, most między surowymi danymi a znaczeniem biznesowym wymaga ludzkiego osądu, którego obecna AI nie potrafi zreplikować.

8,8K

GPT-5 osiąga 94,6% dokładności w AIME 2025, co sugeruje niemal ludzkie rozumowanie matematyczne.

Jednak gdy poprosisz go o zapytanie do twojej bazy danych, wskaźniki sukcesu spadają do nastolatków.

Benchmarki Spider 2.0 ujawniają ogromną lukę w możliwościach AI. Spider 2.0 to kompleksowy benchmark tekstu do SQL, który testuje zdolność modeli AI do generowania dokładnych zapytań SQL z naturalnych pytań językowych w rzeczywistych bazach danych.

Podczas gdy duże modele językowe podbiły pracę wiedzy w matematyce, kodowaniu i rozumowaniu, tekst do SQL pozostaje upartym wyzwaniem.

Trzy benchmarki Spider 2.0 testują zapytania do rzeczywistych baz danych w różnych środowiskach. Spider 2.0-Snow używa baz danych Snowflake z 547 przykładami testowymi, osiągając szczytową dokładność na poziomie 59,05%.

Spider 2.0-Lite obejmuje BigQuery, Snowflake i SQLite z kolejnymi 547 przykładami, osiągając jedynie 37,84%. Spider 2.0-DBT testuje generację kodu przeciwko DuckDB z 68 przykładami, osiągając maksymalnie 39,71%.

Ta luka w wydajności nie wynika z braku prób. Od listopada 2024 roku 56 zgłoszeń z 12 rodzin modeli rywalizowało w tych benchmarkach.

Claude, OpenAI, DeepSeek i inni wszyscy testowali swoje modele w tych testach. Postęp był stały, od około 2% do około 60% w ciągu ostatnich dziewięciu miesięcy.

Zagadka pogłębia się, gdy weźmiesz pod uwagę ograniczenia SQL. SQL ma ograniczony słownik w porównaniu do angielskiego, który ma 600 000 słów, lub języków programowania, które mają znacznie szersze składnie i biblioteki do poznania. Poza tym jest mnóstwo SQL do trenowania.

Jeśli już, to powinno być łatwiejsze niż otwarte zadania rozumowania, w których modele teraz doskonale sobie radzą.

Jednak nawet doskonała generacja SQL nie rozwiązałaby prawdziwego wyzwania biznesowego. Każda firma definiuje "przychód" inaczej.

Marketing mierzy koszt pozyskania klienta według wydatków na kampanię, sprzedaż oblicza go przy użyciu kosztów menedżerów kont, a finanse uwzględniają całkowite koszty pracowników. Te różnice semantyczne tworzą zamieszanie, którego techniczna dokładność nie może rozwiązać.

Wyniki Spider 2.0 wskazują na fundamentalną prawdę o pracy z danymi. Techniczna biegłość w składni SQL to tylko punkt wyjścia.

Prawdziwe wyzwanie leży w kontekście biznesowym. Zrozumienie, co oznaczają dane, jak różne zespoły definiują metryki i kiedy przypadki brzegowe mają znaczenie. Jak napisałem w Semantic Cultivators, most między surowymi danymi a znaczeniem biznesowym wymaga ludzkiego osądu, którego obecna AI nie potrafi zreplikować.

3,95K

Perplexity AI złożyło nieproszoną ofertę w wysokości 34,5 miliarda dolarów na przeglądarkę Chrome firmy Google, próbując wykorzystać nadchodzący wyrok antymonopolowy, który może zmusić Google do sprzedaży swojego biznesu przeglądarki.

Porównanie ekonomiki Chrome z istniejącą umową Google z Safari ujawnia, dlaczego 34,5 miliarda dolarów niedoszacowuje wartość przeglądarki.

Google płaci Apple od 18 do 20 miliardów dolarów rocznie, aby pozostać domyślną wyszukiwarką w Safari¹, obsługując około 850 milionów użytkowników². To przekłada się na 21 dolarów na użytkownika rocznie.

Oferta Perplexity wycenia Chrome na 32 miliardy dolarów, co daje 9 dolarów na użytkownika rocznie dla jego 3,5 miliarda użytkowników³.

Gdyby użytkownicy Chrome mieli takie same warunki jak umowa Google/Apple z Safari, roczny potencjał przychodów przeglądarki przekroczyłby 73 miliardy dolarów.

Te dane opierają się na publicznych szacunkach, ale są przybliżone.

Zakłada to, że Google płaciłby nowemu właścicielowi Chrome podobną skalowaną opłatę za domyślne umiejscowienie wyszukiwania. Biorąc pod uwagę mnożnik wartości rynkowej do przychodów w wysokości od 5x do 6x, Chrome jest wart gdzieś między 172 miliardami a 630 miliardami dolarów, co jest dalekie od oferty 34,5 miliarda dolarów.

Chrome dominuje na rynku z 65% udziałem⁴, w porównaniu do 18% Safari. Sprzedaż mogłaby wstrząsnąć rynkiem reklam w wyszukiwarkach. Wartość utrzymania budżetów reklamodawców jest trudna do przecenienia dla wartości rynkowej Google i jego pozycji w ekosystemie reklamowym.

Jeśli Google byłoby zmuszone do sprzedaży Chrome, stanęłoby przed egzystencjalnym wyborem. Zapłacić cokolwiek, aby pozostać domyślną wyszukiwarką, czy obserwować, jak konkurenci przekształcają jego najcenniejszy kanał dystrybucji w narzędzie przeciwko niemu.

Ile to jest warte? Znaczną premię w porównaniu do prostego mnożnika przychodów.

¹ Bloomberg: Płatności Google do Apple osiągnęły 20 miliardów dolarów w 2022 roku (

² ZipDo: Kluczowe statystyki Apple Safari w 2024 roku (

³ Backlinko: Udział w rynku przeglądarek internetowych w 2025 roku (

⁴ Statcounter: Udział w rynku przeglądarek na całym świecie (

7,98K

W 1999 roku dotcomy były wyceniane na podstawie ruchu. Metryki IPO krążyły wokół liczby wyświetleń.

Następnie Google uruchomił AdWords, model reklamowy oparty na kliknięciach, i zbudował biznes wart 273 miliardy dolarów w 2024 roku.

Jednak to wszystko może się zmienić: badanie Pew Research z lipca 2025 roku ujawnia, że użytkownicy klikają tylko 8% wyników wyszukiwania z podsumowaniami AI, w porównaniu do 15% bez nich - co stanowi spadek o 47%. Tylko 1% kliknięć pochodzi z podsumowań AI.

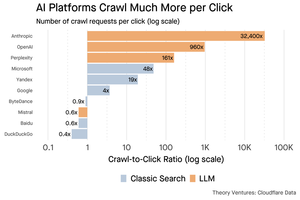

Dane Cloudflare pokazują, że platformy AI przeszukują treści znacznie częściej, niż kierują ruch do źródeł: Anthropic przeszukuje 32 400 stron na każde 1 odesłanie, podczas gdy tradycyjne wyszukiwarki skanują treści tylko kilka razy na odwiedzającego.

Koszt dostarczania treści do robotów AI może nie być ogromny, jeśli jest głównie tekstowy.

Głównym punktem jest to, że systemy AI eliminują pośrednictwo w relacji użytkownik - wydawca. Użytkownicy wolą zebrane odpowiedzi AI zamiast klikania w strony internetowe, aby znaleźć odpowiedzi.

Logiczne jest, że większość stron internetowych powinna spodziewać się mniejszego ruchu. Jak Twoja strona internetowa i Twoja firma sobie z tym poradzą?

Źródła:

- Pew Research Center - Athena Chapekis, 22 lipca 2025 (

- Cloudflare: Przeszukiwanie przed upadkiem odesłań (

- Cloudflare Radar: AI Insights - Stosunek przeszukiwania do odesłań (

- Podcast: Zmieniająca się wartość treści w erze AI (

9,69K

GPT-5 uruchomiono wczoraj. 94,6% w AIME 2025. 74,9% w SWE-bench.

W miarę zbliżania się do górnych granic tych benchmarków, one umierają.

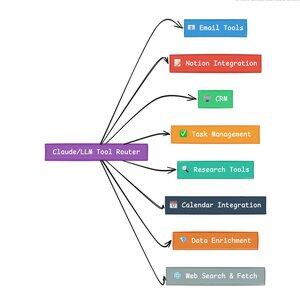

To, co czyni GPT-5 i kolejną generację modeli rewolucyjnymi, nie jest ich wiedza. To umiejętność działania. W przypadku GPT-5 dzieje się to na dwóch poziomach. Po pierwsze, decyzja, który model użyć. Ale po drugie, i co ważniejsze, poprzez wywoływanie narzędzi.

Żyjemy w erze, w której LLM-y opanowały pozyskiwanie i ponowne składanie wiedzy. Wyszukiwanie konsumenckie i kodowanie, początkowe aplikacje zabójcze, są zasadniczo wyzwaniami związanymi z pozyskiwaniem wiedzy. Oba organizują istniejące informacje w nowe sposoby.

Wspięliśmy się na te wzgórza i w rezultacie konkurencja jest bardziej intensywna niż kiedykolwiek. Modele Anthropic, OpenAI i Google'a zbliżają się do podobnych możliwości. Chińskie modele i alternatywy open source nadal zbliżają się do stanu sztuki. Każdy może pozyskiwać informacje. Każdy może generować tekst.

Nowa oś konkurencji? Wywoływanie narzędzi.

Wywoływanie narzędzi przekształca LLM-y z doradców w aktorów. Kompensuje dwie krytyczne słabości modeli, których czyste modele językowe nie mogą przezwyciężyć.

Po pierwsze, orkiestracja przepływu pracy. Modele doskonale radzą sobie z odpowiedziami jednorazowymi, ale mają trudności z procesami wieloetapowymi i stanowymi. Narzędzia umożliwiają im zarządzanie długimi przepływami pracy, śledzenie postępów, obsługę błędów, utrzymywanie kontekstu w dziesiątkach operacji.

Po drugie, integracja systemów. LLM-y żyją w świecie tylko tekstowym. Narzędzia pozwalają im przewidywalnie współdziałać z systemami zewnętrznymi, takimi jak bazy danych, API i oprogramowanie dla przedsiębiorstw, przekształcając naturalny język w działania do wykonania.

W ciągu ostatniego miesiąca zbudowałem 58 różnych narzędzi AI.

Procesory e-mailowe. Integratory CRM. Aktualizatory Notion. Asystenci badawczy. Każde narzędzie rozszerza możliwości modelu w nowej dziedzinie.

Najważniejszą zdolnością AI jest szybkie i poprawne wybieranie odpowiedniego narzędzia. Każdy błędnie skierowany krok zabija cały przepływ pracy.

Kiedy mówię „przeczytaj ten e-mail od Y Combinator i znajdź wszystkie startupy, które nie są w CRM”, nowoczesne LLM-y wykonują skomplikowaną sekwencję.

Jedno polecenie w języku angielskim zastępuje cały przepływ pracy. A to tylko proste zadanie.

Co lepsze, model, odpowiednio skonfigurowany z odpowiednimi narzędziami, może zweryfikować swoją własną pracę, że zadania zostały wykonane na czas. Ta pętla samoweryfikacji tworzy niezawodność w przepływach pracy, którą trudno osiągnąć w inny sposób.

Pomnóż to przez setki pracowników. Tysiące przepływów pracy. Zyski wydajności kumulują się wykładniczo.

Zwycięzcy w przyszłym świecie AI będą tymi, którzy będą najbardziej zaawansowani w orkiestracji narzędzi i kierowaniu odpowiednich zapytań. Za każdym razem. Gdy te przepływy pracy staną się przewidywalne, wtedy wszyscy staniemy się menedżerami agentów.

3,17K

Rok 2025 to rok agentów, a kluczową zdolnością agentów jest wywoływanie narzędzi.

Kiedy używam Claude Code, mogę powiedzieć AI, aby przeszukało newsletter, znalazło wszystkie linki do startupów, zweryfikowało, że istnieją w naszym CRM, za pomocą jednego polecenia. Może to wymagać wywołania dwóch lub trzech różnych narzędzi.

Ale oto problem: używanie dużego modelu bazowego do tego jest kosztowne, często ograniczone przez stawki i zbyt potężne do zadania selekcyjnego.

Jaki jest najlepszy sposób na zbudowanie systemu agentowego z wywoływaniem narzędzi?

Odpowiedź leży w małych modelach akcji. NVIDIA opublikowała przekonujący artykuł, w którym twierdzi, że „Małe modele językowe (SLM) są wystarczająco potężne, z natury bardziej odpowiednie i koniecznie bardziej ekonomiczne dla wielu wywołań w systemach agentowych.”

Testowałem różne lokalne modele, aby zweryfikować ćwiczenie redukcji kosztów. Zacząłem od modelu Qwen3:30b, który działa, ale może być dość wolny, ponieważ jest to tak duży model, mimo że tylko 3 miliardy z tych 30 miliardów parametrów jest aktywnych w danym momencie.

Artykuł NVIDIA zaleca model Salesforce xLAM – inną architekturę nazwaną dużym modelem akcji, specjalnie zaprojektowaną do selekcji narzędzi.

Więc przeprowadziłem własny test, każdy model wywołując narzędzie do listowania moich zadań w Asanie.

Wyniki były uderzające: xLAM ukończył zadania w 2,61 sekundy z 100% sukcesem, podczas gdy Qwen zajął 9,82 sekundy z 92% sukcesem – prawie cztery razy dłużej.

Ten eksperyment pokazuje zysk w szybkości, ale jest kompromis: ile inteligencji powinno być w modelu, a ile w samych narzędziach. To ograniczenie

W przypadku większych modeli, takich jak Qwen, narzędzia mogą być prostsze, ponieważ model ma lepszą tolerancję na błędy i może radzić sobie z źle zaprojektowanymi interfejsami. Model kompensuje ograniczenia narzędzi poprzez rozumowanie siłowe.

W przypadku mniejszych modeli model ma mniejszą zdolność do naprawy błędów, więc narzędzia muszą być bardziej solidne, a logika selekcji bardziej precyzyjna. Może to wydawać się ograniczeniem, ale w rzeczywistości jest to cecha.

To ograniczenie eliminuje kumulacyjny wskaźnik błędów narzędzi LLM. Gdy duże modele wykonują sekwencyjne wywołania narzędzi, błędy kumulują się wykładniczo.

Małe modele akcji wymuszają lepszy projekt systemu, zachowując to, co najlepsze w LLM i łącząc to z modelami specjalistycznymi.

Ta architektura jest bardziej wydajna, szybsza i bardziej przewidywalna.

5,3K

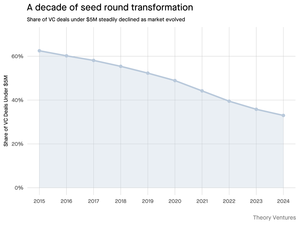

Dlaczego rundy seedowe poniżej 5 milionów dolarów maleją?

Dekadę temu te mniejsze rundy stanowiły kręgosłup finansowania startupów, obejmując ponad 70% wszystkich transakcji seedowych. Dziś dane z PitchBook pokazują, że ta liczba spadła do mniej niż połowy.

Liczby opowiadają wyraźną historię. Transakcje poniżej 5 milionów dolarów spadły z 62,5% w 2015 roku do 37,5% w 2024 roku. Ten spadek o 29,5 punktu procentowego zasadniczo zmienił sposób, w jaki startupy pozyskują swój pierwszy kapitał instytucjonalny.

Trzy siły napędzały tę transformację. Możemy rozłożyć ten spadek, aby zrozumieć, co spowodowało zmniejszenie małych rund seedowych i dlaczego ma to znaczenie dla założycieli dzisiaj.

4,7K

To było takie zabawne, Mario. Dziękuję, że zaprosiłeś mnie do programu, aby porozmawiać o wszystkim, co dzieje się na rynku!

Mario Gabriele 🦊22 lip 2025

Nasz najnowszy odcinek z Tomaszem Tunguzem jest już dostępny!

Dekada Danych

@ttunguz spędził prawie dwie dekady, przekształcając dane w spostrzeżenia inwestycyjne. Po wsparciu Looker, Expensify i Monte Carlo w Redpoint Ventures, w 2022 roku uruchomił @Theoryvc z odważną wizją: stworzyć "korporację inwestycyjną", w której badacze, inżynierowie i operatorzy pracują obok inwestorów, tworząc mapy rynkowe w czasie rzeczywistym i narzędzia AI wewnętrzne. Jego debiutancki fundusz zamknął się na kwotę 238 milionów dolarów, a zaledwie 19 miesięcy później zamknął drugi fundusz na 450 milionów dolarów. Skoncentrowany na danych, AI i infrastrukturze kryptowalut, Theory działa w sercu dzisiejszych najważniejszych zmian technologicznych. Badamy, jak dane przekształcają kapitał venture, dlaczego tradycyjne modele inwestycyjne są zakłócane i co jest potrzebne, aby zbudować firmę, która nie tylko przewiduje przyszłość, ale aktywnie pomaga ją tworzyć.

Słuchaj teraz:

• YouTube:

• Spotify:

• Apple:

Wielkie podziękowania dla niesamowitych sponsorów, którzy sprawiają, że podcast jest możliwy:

✨ Brex — Rozwiązanie bankowe dla startupów:

✨ Generalist+ — Kluczowa inteligencja dla nowoczesnych inwestorów i technologów:

Badamy:

→ Jak działa model "korporacji inwestycyjnej" Theory

→ Dlaczego giełdy kryptowalut mogą stworzyć realną ścieżkę do rynków publicznych dla małych firm programistycznych

→ Nadchodzący kryzys energetyczny — dlaczego centra danych mogą konsumować 15% energii elektrycznej w USA w ciągu pięciu lat

→ Szybki wzrost stablecoinów, gdy główne banki kierują przez nie 5-10% dolarów amerykańskich

→ Dlaczego Ethereum stoi przed egzystencjalnym wyzwaniem podobnym do AWS tracącego grunt na rzecz Azure w erze AI

→ Dlaczego Tomasz wierzy, że dzisiejsza garstka agentów stanie się 100+ cyfrowymi współpracownikami do końca roku

→ Dlaczego Meta stawia miliardy na okulary AR, aby zmienić sposób, w jaki wchodzimy w interakcje z maszynami

→ Jak Theory Ventures wykorzystuje AI do przyspieszania badań rynkowych, analizy transakcji i podejmowania decyzji inwestycyjnych

…I wiele więcej!

8,01K

OpenAI otrzymuje średnio 1 zapytanie na Amerykanina dziennie.

Google otrzymuje około 4 zapytań na Amerykanina dziennie.

Od tego czasu 50% zapytań w wyszukiwarce Google ma AI Overviews, co oznacza, że co najmniej 60% wyszukiwań w USA to teraz AI.

Zajęło to trochę więcej czasu, niż się spodziewałem, aby to się wydarzyło. W 2024 roku przewidywałem, że 50% wyszukiwań konsumenckich będzie wspieranych przez AI. (

Ale AI już dotarło do wyszukiwania.

Jeśli wzorce wyszukiwania Google są jakimkolwiek wskaźnikiem, istnieje prawo potęgowe w zachowaniu wyszukiwania. Analiza zachowań wyszukiwania Google przez SparkToro pokazuje, że górna jedna trzecia Amerykanów, którzy wyszukują, wykonuje ponad 80% wszystkich wyszukiwań - co oznacza, że użycie AI nie jest prawdopodobnie równomiernie rozłożone - jak przyszłość.

Strony internetowe i firmy zaczynają odczuwać skutki tego. Artykuł The Economist „AI zabija internet. Czy coś może go uratować?” uchwyca zeitgeist w nagłówku. (

Superwiększość Amerykanów teraz wyszukuje z AI. Drugorzędne skutki zmieniających się wzorców wyszukiwania nadchodzą w drugiej połowie tego roku i więcej osób będzie pytać: „Co się stało z moim ruchem?” (

AI to nowy kanał dystrybucji, a ci, którzy go wykorzystają, zyskają udział w rynku.

- William Gibson widział znacznie dalej w przyszłość!

- To jest oparte na analizie punktu środkowego wykresu SparkToro, jest to bardzo prosta analiza i ma pewne błędy w wyniku.

8,88K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi