Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-5 a été lancé hier. 94,6 % sur AIME 2025. 74,9 % sur SWE-bench.

À mesure que nous approchons des limites supérieures de ces benchmarks, ils s'éteignent.

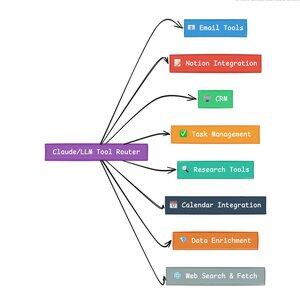

Ce qui rend GPT-5 et la prochaine génération de modèles révolutionnaires, ce n'est pas leur connaissance. C'est savoir comment agir. Pour GPT-5, cela se produit à deux niveaux. D'abord, décider quel modèle utiliser. Mais ensuite, et plus important encore, à travers l'appel d'outils.

Nous avons vécu dans une ère où les LLM ont maîtrisé la récupération et le réassemblage des connaissances. La recherche pour les consommateurs et le codage, les premières applications phares, sont fondamentalement des défis de récupération de connaissances. Les deux organisent les informations existantes de nouvelles manières.

Nous avons gravi ces collines et, en conséquence, la concurrence est plus intense que jamais. Les modèles d'Anthropic, OpenAI et Google convergent vers des capacités similaires. Les modèles chinois et les alternatives open source continuent de se rapprocher de l'état de l'art. Tout le monde peut récupérer des informations. Tout le monde peut générer du texte.

Le nouvel axe de la concurrence ? L'appel d'outils.

L'appel d'outils transforme les LLM d'advisors en acteurs. Il compense deux faiblesses critiques des modèles purs de langage que les modèles de langage ne peuvent pas surmonter.

D'abord, l'orchestration des flux de travail. Les modèles excellent dans les réponses uniques mais ont du mal avec les processus multi-étapes et à état. Les outils leur permettent de gérer de longs flux de travail, de suivre les progrès, de gérer les erreurs, de maintenir le contexte à travers des dizaines d'opérations.

Deuxièmement, l'intégration des systèmes. Les LLM vivent dans un monde uniquement textuel. Les outils leur permettent d'interfacer de manière prévisible avec des systèmes externes comme des bases de données, des API et des logiciels d'entreprise, transformant le langage naturel en actions exécutables.

Au cours du dernier mois, j'ai construit 58 outils d'IA différents.

Des processeurs d'e-mails. Des intégrateurs de CRM. Des mises à jour de Notion. Des assistants de recherche. Chaque outil étend les capacités du modèle dans un nouveau domaine.

La capacité la plus importante pour l'IA est de sélectionner l'outil approprié rapidement et correctement. Chaque étape mal orientée tue l'ensemble du flux de travail.

Quand je dis "lisez cet e-mail de Y Combinator et trouvez toutes les startups qui ne sont pas dans le CRM", les LLM modernes exécutent une séquence complexe.

Une commande en anglais remplace un flux de travail entier. Et c'est juste un simple exemple.

Encore mieux, le modèle, correctement configuré avec les bons outils, peut vérifier son propre travail pour s'assurer que les tâches ont été complétées à temps. Cette boucle de vérification automatique crée une fiabilité dans les flux de travail qui est difficile à atteindre autrement.

Multipliez cela par des centaines d'employés. Des milliers de flux de travail. Les gains de productivité se cumulent de manière exponentielle.

Les gagnants dans le futur monde de l'IA seront ceux qui seront les plus sophistiqués dans l'orchestration des outils et le routage des bonnes requêtes. Chaque fois. Une fois que ces flux de travail sont prévisibles, c'est à ce moment-là que nous deviendrons tous des gestionnaires d'agents.

3,19K

Meilleurs

Classement

Favoris