Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Se você ler uma coisa esta semana, sugeriria o relatório de IA abaixo:

"De Fundições de Dados a Modelos Mundiais"

Ele entrelaça fundições de dados, engenharia de contexto, ambientes de RL, modelos mundiais e mais em um ensaio acessível, mas abrangente sobre a atual vanguarda da IA.👇(0/12)

Artigo Completo:

🧵abaixo:

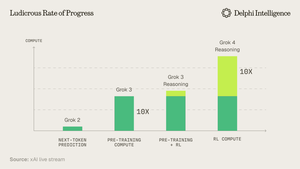

1) A partir do lançamento do Grok 4, está claro que não atingimos "uma parede" nos gastos de computação.

Fonte: @xai

2) Cada vez mais, os dados parecem ser o ponto fraco.

Fonte: @EpochAIResearch

3) A maior parte deste gasto está a ser direcionada para a geração de conjuntos de dados de alta qualidade para pós-treinamento, que está rapidamente a aproximar-se de 50% dos orçamentos de computação.

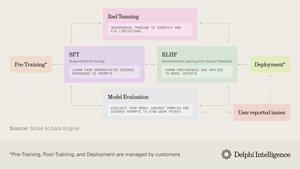

4) Isso levou a uma inflexão na demanda por "fundições de dados" como @scale_AI @HelloSurgeAI @mercor_ai e mais, que ajudam a obter a expertise necessária e a criar pipelines de dados essenciais para RL em domínios não verificáveis...

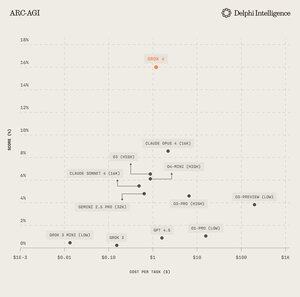

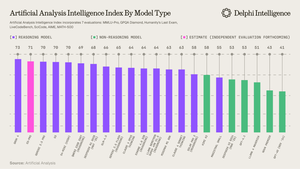

5) O que pode ajudar a alimentar modelos de raciocínio cada vez mais capazes, claramente o paradigma de escalonamento do dia segundo @ArtificialAnlys

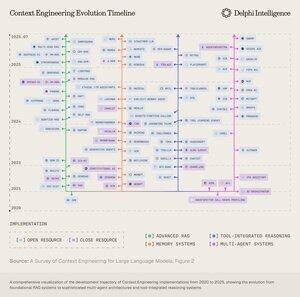

6) E ainda assim, os modelos já não estão limitados pelo QI, mas pelo contexto. A engenharia de prompts passou o bastão para a "Engenharia de Contexto" - um campo em crescimento que otimiza os pacotes de informação para os LLMs.

7) O espaço é extremamente dinâmico, mas geralmente envolve a escalabilidade do contexto em 2 vetores:

1. Comprimento do Contexto: os desafios computacionais e arquitetónicos de processar sequências ultra-longas

2. Multimodal: escalando o contexto além do texto para ambientes verdadeiramente multimodais.

8) Talvez a expressão máxima do contexto eng. seja a criação de "ambientes RL" que imitam perfeitamente tarefas nas quais o RL pode ser executado.

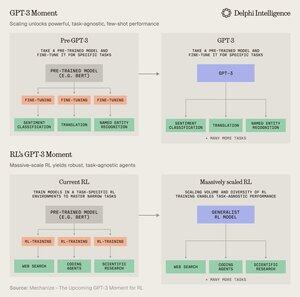

Embora hoje estejamos limitados por dados, @MechanizeWork acredita que estamos a caminho de uma inflexão "semelhante ao GPT-3" com RL em grande escala.

9) No entanto, criar esses ambientes é bastante trabalhoso e não parece muito "bitter-lesson-pilled".

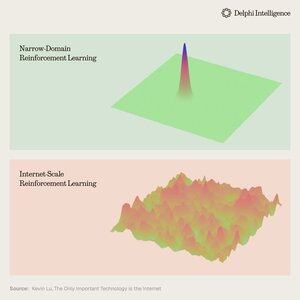

@_kevinlu está se perguntando se há uma maneira de aproveitar a internet para o pós-treinamento, como foi feito para o pré-treinamento?

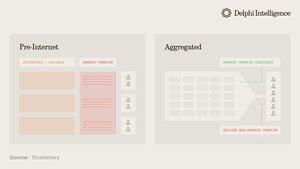

10) Embora seja um pensamento interessante, grande parte da internet foi capturada por alguns grandes ecossistemas que estão verticalmente integrados e a conduzir rapidamente RL através dos seus ingredientes para uma RL ainda mais rápida

(i.e. alpha evolve from @GoogleDeepMind )

11) Não está claro se estas grandes empresas veem ambientes RL díspares como essenciais ou apenas como uma paragem temporária a caminho de "modelos de mundo" completos, com gêmeos digitais de quase todos os fenómenos.

O Genie 3 da Google é certamente um sinal nessa direção:

5/08, 22:03

E se você pudesse não apenas assistir a um vídeo gerado, mas também explorá-lo? 🌐

Genie 3 é nosso modelo de mundo inovador que cria ambientes interativos e jogáveis a partir de um único prompt de texto.

De paisagens fotorrealistas a reinos de fantasia, as possibilidades são infinitas. 🧵

12) O que levanta a questão: as abordagens verticalmente integradas para construir inteligência sintética com ciclos de feedback de RL mais rápidos estão destinadas a avançar rapidamente e capturar o mercado ou os sistemas modulares de computação latente, dados e talento podem competir com uma orquestração eficaz?

11,86K

Top

Classificação

Favoritos