Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

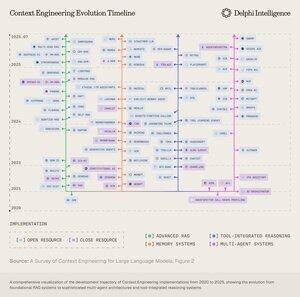

Boop.Fun leading the way with a new launchpad on Solana.

Jeśli przeczytasz jedną rzecz w tym tygodniu, polecam poniższy raport AI:

"Od fabryk danych do modeli świata"

Łączy fabryki danych, inżynierię kontekstu, środowiska RL, modele świata i więcej w przystępnym, a jednocześnie kompleksowym eseju na temat aktualnych osiągnięć AI.👇(0/12)

Pełny artykuł:

🧵poniżej:

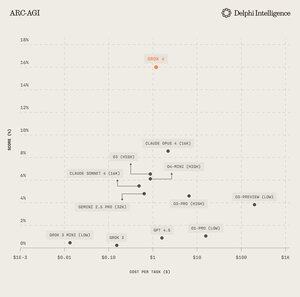

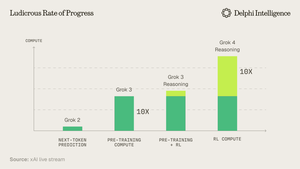

1) Z wydania Grok 4 jasno wynika, że nie osiągnęliśmy "ściany" w wydatkach na obliczenia.

Źródło: @xai

2) Coraz częściej dane wydają się być krótkim kijem w namiocie.

Źródło: @EpochAIResearch

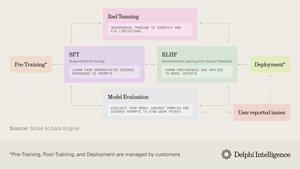

3) Większość tych wydatków jest przeznaczana na generowanie wysokiej jakości zbiorów danych do post-treningu, co szybko zbliża się do 50% budżetów obliczeniowych.

4) Doprowadziło to do zmiany w popycie na "odlewnie danych" takie jak @scale_AI @HelloSurgeAI @mercor_ai i inne, które pomagają pozyskiwać niezbędną wiedzę i tworzyć potoki danych niezbędne do RL w niezweryfikowanych dziedzinach...

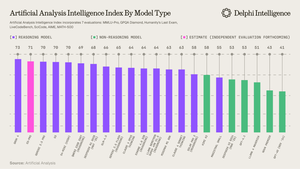

5) Co może pomóc w zasilaniu coraz bardziej zdolnych modeli rozumowania, wyraźnie obecny paradygmat skalowania według @ArtificialAnlys

6) A jednak modele nie są już ograniczone przez IQ, ale przez kontekst. Inżynieria podpowiedzi ustąpiła miejsca "Inżynierii Kontekstowej" - rozwijającej się dziedzinie optymalizującej ładunki informacyjne dla LLM.

7) Przestrzeń jest niezwykle dynamiczna, ale generalnie obejmuje skalowanie kontekstu wzdłuż 2 wektorów:

1. Długość kontekstu: wyzwania obliczeniowe i architektoniczne związane z przetwarzaniem ultra-długich sekwencji

2. Multimodalność: skalowanie kontekstu poza tekst w prawdziwie multimodalne środowiska.

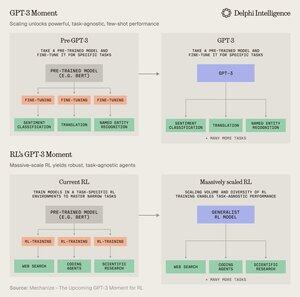

8) Być może ostatecznym wyrazem kontekstu inż. jest tworzenie "środowisk RL", które doskonale naśladują zadania, na których można uruchomić RL.

Chociaż dzisiaj jesteśmy ograniczeni danymi, @MechanizeWork wierzy, że zmierzamy w kierunku infleksji w stylu "GPT-3", z masowo skalowanym RL.

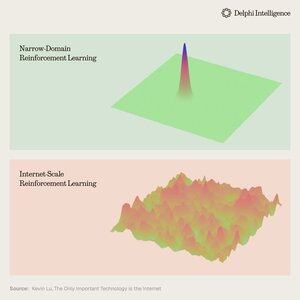

9) Jednak tworzenie tych środowisk jest dość pracochłonne i nie wydaje się zbyt "bitter-lesson-pilled".

@_kevinlu zastanawia się, czy istnieje sposób na wykorzystanie internetu do post-szkolenia, tak jak zrobiono to w przypadku pre-szkolenia?

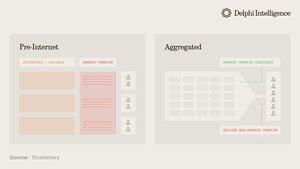

10) Choć to interesująca myśl, wiele z internetu zostało przejętych przez kilka dużych ekosystemów, które są zintegrowane wertykalnie i szybko prowadzą RL w swoich składnikach, aby uzyskać jeszcze szybsze RL

(tzn. alpha ewoluuje z @GoogleDeepMind)

11) Nie jest jasne, czy te duże firmy postrzegają różne środowiska RL jako niezbędne, czy tylko jako tymczasowy przystanek w drodze do pełnych "modeli świata", kompletnych z cyfrowymi bliźniakami niemal każdego zjawiska.

Genie 3 od Google z pewnością jest krokiem w tym kierunku:

5 sie, 22:03

Co jeśli mógłbyś nie tylko oglądać wygenerowane wideo, ale także je eksplorować? 🌐

Genie 3 to nasz przełomowy model świata, który tworzy interaktywne, grywalne środowiska z jednego tekstowego polecenia.

Od fotorealistycznych krajobrazów po fantastyczne krainy, możliwości są nieograniczone. 🧵

12) Co rodzi pytanie: czy podejścia zintegrowane pionowo do budowania sztucznej inteligencji z szybszymi pętlami sprzężenia zwrotnego RL są skazane na przyspieszenie i zdobycie rynku, czy też modułowe systemy ukrytej mocy obliczeniowej, danych i talentów mogą konkurować z efektywną orkiestracją?

11,87K

Najlepsze

Ranking

Ulubione