Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

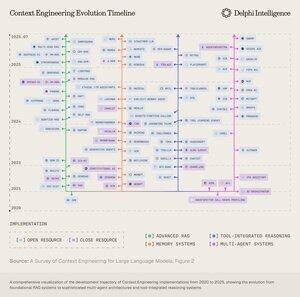

Boop.Fun leading the way with a new launchpad on Solana.

Si lees una cosa esta semana, te sugeriría el siguiente informe de IA:

"De las fundiciones de datos a los modelos del mundo"

Entreteje fundiciones de datos, ingeniería de contexto, entornos de RL, modelos del mundo y más en un ensayo accesible, pero completo sobre la vanguardia actual de la IA.👇(0/12)

Artículo completo:

🧵abajo:

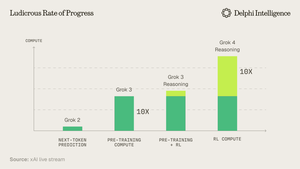

1) A partir del lanzamiento de Grok 4, está claro que no hemos alcanzado "una pared" en el gasto de computación.

Fuente: @xai

2) Cada vez más, los datos parecen ser el palo corto en la tienda.

Fuente: @EpochAIResearch

3) La mayor parte de este gasto se destina a generar conjuntos de datos de alta calidad para el post-entrenamiento, que se acerca rápidamente al 50% de los presupuestos de computación.

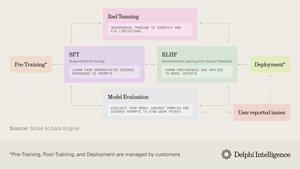

4) Esto ha llevado a una inflexión en la demanda de "fundiciones de datos" como @scale_AI @HelloSurgeAI @mercor_ai y más, que ayudan a obtener la experiencia necesaria y a crear pipelines de datos esenciales para el RL en dominios no verificables...

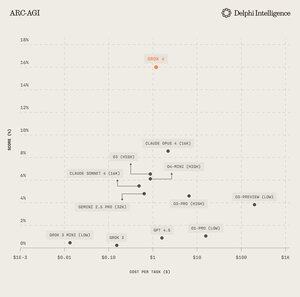

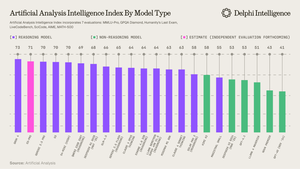

5) Lo que puede ayudar a alimentar modelos de razonamiento cada vez más capaces, claramente el paradigma de escalado del día según @ArtificialAnlys

6) Y sin embargo, los modelos ya no están limitados por el CI, sino por el contexto. La ingeniería de prompts ha pasado el testigo a la "Ingeniería de Contexto" - un campo en auge que optimiza las cargas de información para los LLMs.

7) El espacio es extremadamente dinámico, pero generalmente implica escalar el contexto a través de 2 vectores:

1. Longitud del contexto: los desafíos computacionales y arquitectónicos de procesar secuencias ultra-largas

2. Multimodal: escalar el contexto más allá del texto hacia entornos verdaderamente multimodales.

8) Quizás la máxima expresión del contexto eng. es crear "entornos RL" que imiten perfectamente las tareas sobre las que se puede ejecutar RL.

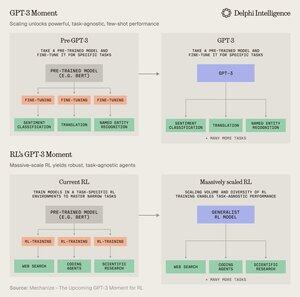

Aunque hoy en día estamos limitados por los datos, @MechanizeWork cree que nos dirigimos hacia una inflexión "similar a GPT-3" con RL a gran escala.

9) Sin embargo, crear estos entornos es bastante laborioso y no parece muy "bitter-lesson-pilled".

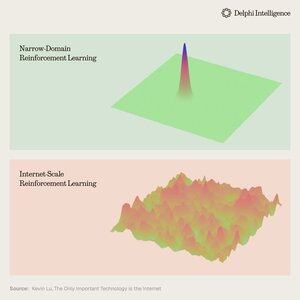

@_kevinlu se pregunta si hay alguna manera de aprovechar Internet para el post-entrenamiento como se hizo para el pre-entrenamiento?

10) Aunque es un pensamiento interesante, gran parte de internet ha sido capturada por unos pocos grandes ecosistemas que están integrados verticalmente y realizando RL rápidamente a través de sus ingredientes para una RL aún más rápida

(i.e. alpha evolve from @GoogleDeepMind)

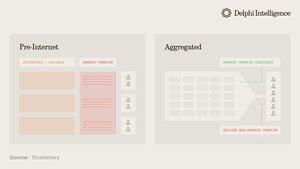

11) No está claro si estas grandes empresas ven los entornos RL dispares como esenciales o solo como una parada temporal en el camino hacia "modelos del mundo" completos, con gemelos digitales de casi todos los fenómenos.

Genie 3 de Google es sin duda un guiño en esta dirección:

5 ago, 22:03

¿Qué pasaría si no solo pudieras ver un video generado, sino también explorarlo? 🌐

Genie 3 es nuestro innovador modelo de mundo que crea entornos interactivos y jugables a partir de un solo aviso de texto.

Desde paisajes fotorrealistas hasta reinos de fantasía, las posibilidades son infinitas. 🧵

12) Lo que plantea la pregunta: ¿están los enfoques de integración vertical para construir inteligencia sintética con bucles de retroalimentación de RL más rápidos destinados a avanzar rápidamente y capturar el mercado, o pueden los sistemas modulares de computación latente, datos y talento competir con una orquestación efectiva?

11,84K

Parte superior

Clasificación

Favoritos