Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

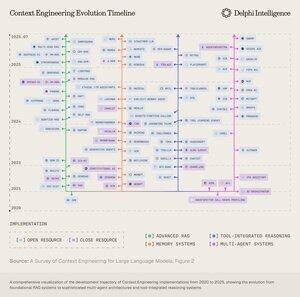

Boop.Fun leading the way with a new launchpad on Solana.

Als je deze week één ding leest, zou ik het onderstaande AI-rapport aanraden:

"Van Data Foundries naar Wereldmodellen"

Het verweeft data foundries, context engineering, RL-omgevingen, wereldmodellen en meer in een benaderbaar, maar toch uitgebreid essay over de huidige grenzen van AI.👇(0/12)

Volledig artikel:

🧵 hieronder:

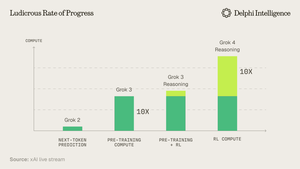

1) Uit de Grok 4-release blijkt dat we "een muur" in computerkosten niet hebben bereikt.

Bron: @xai

2) Steeds vaker lijkt data de korte paal in de tent te zijn.

Bron: @EpochAIResearch

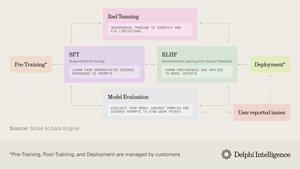

3) Het grootste deel van deze uitgaven gaat naar het genereren van hoogwaardige datasets voor post-training, wat snel bijna 50% van de rekenbudgetten benadert.

4) Dit heeft geleid tot een verandering in de vraag naar "data-fabrieken" zoals @scale_AI @HelloSurgeAI @mercor_ai & meer die helpen bij het vinden van de nodige expertise & het creëren van datastromen die essentieel zijn voor RL in niet-verifieerbare domeinen...

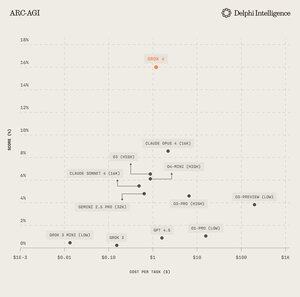

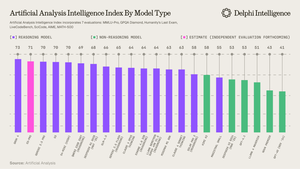

5) Welke kan helpen om steeds capabelere redeneermodellen aan te drijven, duidelijk het schaalparadigma van de dag per @ArtificialAnlys

6) En toch worden modellen niet langer beperkt door IQ, maar door context. Prompt engineering heeft het stokje overgedragen aan "Context Engineering" - een opkomend veld dat informatiepayloads voor LLM's optimaliseert.

7) De ruimte is extreem dynamisch, maar omvat over het algemeen het schalen van context over 2 vectoren:

1. Contextlengte: de computationele en architectonische uitdagingen van het verwerken van ultra-lange sequenties

2. Multimodaal: het schalen van context buiten tekst naar werkelijk multimodale omgevingen.

8) Misschien is de ultieme uitdrukking van context eng. het creëren van "RL-omgevingen" die perfect taken nabootsen waarop RL kan worden uitgevoerd.

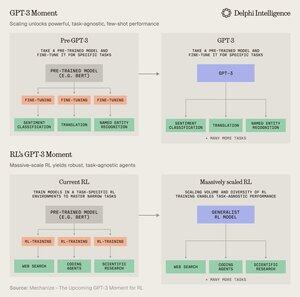

Hoewel we vandaag de dag beperkt zijn in data, gelooft @MechanizeWork dat we op weg zijn naar een "GPT-3-achtige" inflectie met massaal geschaalde RL.

9) Het creëren van deze omgevingen is echter behoorlijk arbeidsintensief en lijkt niet echt "bitter-lesson-pilled".

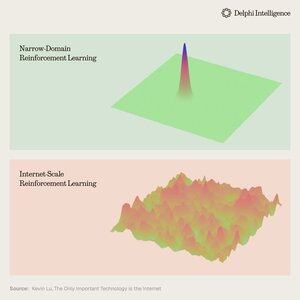

@_kevinlu vraagt zich af of er een manier is om het internet te benutten voor post-training, zoals dat gedaan werd voor pre-training?

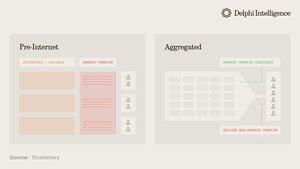

10) Hoewel het een interessante gedachte is, is een groot deel van het internet gevangen genomen door een paar grote ecosystemen die verticaal geïntegreerd zijn en snel RL uitvoeren over hun ingrediënten voor nog snellere RL

(i.e. alpha evolueert van @GoogleDeepMind)

11) Het is onduidelijk of deze grote bedrijven verschillende RL-omgevingen als essentieel beschouwen of gewoon als een tijdelijke stop op weg naar volledige "wereldmodellen," compleet met digitale tweelingen van bijna elk fenomeen.

Genie 3 van Google is zeker een aanwijzing in deze richting:

5 aug, 22:03

Wat als je niet alleen een gegenereerde video kunt bekijken, maar deze ook kunt verkennen? 🌐

Genie 3 is ons baanbrekende wereldmodel dat interactieve, speelbare omgevingen creëert vanuit een enkele tekstprompt.

Van fotorealistische landschappen tot fantasiewerelden, de mogelijkheden zijn eindeloos. 🧵

12) Dit roept de vraag op: zijn verticaal geïntegreerde benaderingen voor het bouwen van synthetische intelligentie met snellere RL-feedbackloops voorbestemd om de markt te veroveren, of kunnen modulaire systemen van latente rekencapaciteit, data en talent concurreren met effectieve orchestratie?

11,86K

Boven

Positie

Favorieten