Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Se leggi una cosa questa settimana, ti consiglio il rapporto AI qui sotto:

"Da Data Foundries a World Models"

Intreccia data foundries, ingegneria del contesto, ambienti RL, modelli del mondo e altro in un saggio accessibile, ma completo, sul confine attuale dell'AI.👇(0/12)

Articolo completo:

🧵qui sotto:

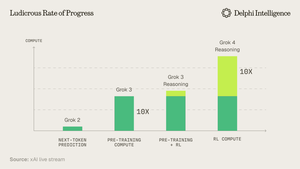

1) Dalla release di Grok 4, è chiaro che non abbiamo raggiunto "un muro" nella spesa per il calcolo.

Fonte: @xai

2) Sempre più spesso, i dati sembrano essere il palo corto nella tenda.

Fonte: @EpochAIResearch

3) La maggior parte di questa spesa è destinata a generare set di dati di alta qualità per il post-addestramento, che si avvicina rapidamente al 50% dei budget di calcolo.

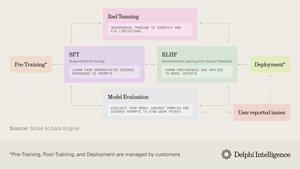

4) Questo ha portato a un'inflessione nella domanda per le "fonderie di dati" come @scale_AI @HelloSurgeAI @mercor_ai e altre che aiutano a reperire le competenze necessarie e a creare pipeline di dati essenziali per il RL in domini non verificabili...

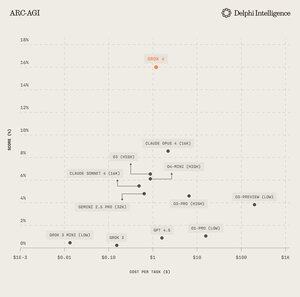

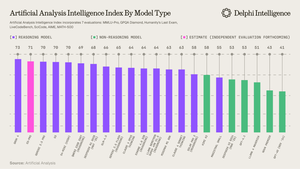

5) Quale può aiutare a alimentare modelli di ragionamento sempre più capaci, chiaramente il paradigma di scaling del giorno per @ArtificialAnlys

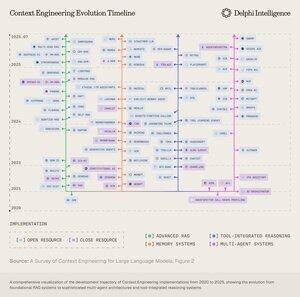

6) Eppure, i modelli non sono più vincolati dal QI ma dal contesto. L'ingegneria dei prompt ha passato il testimone all'"Ingegneria del Contesto" - un campo in espansione che ottimizza i carichi informativi per i LLM.

7) Lo spazio è estremamente dinamico ma generalmente comporta la scalabilità del contesto su 2 vettori:

1. Lunghezza del contesto: le sfide computazionali e architettoniche di elaborare sequenze ultra-lunghe

2. Multimodale: scalare il contesto oltre il testo per ambienti veramente multimodali.

8) Forse l'espressione definitiva del contesto ing. è creare "ambienti RL" che imitano perfettamente i compiti su cui può essere eseguito il RL.

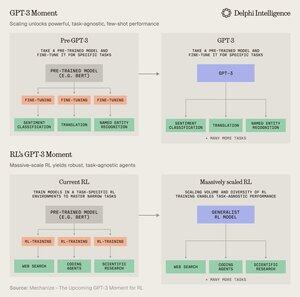

Sebbene oggi i dati siano limitati, @MechanizeWork crede che stiamo andando verso un'inflessione "simile a GPT-3" con RL su scala massiccia.

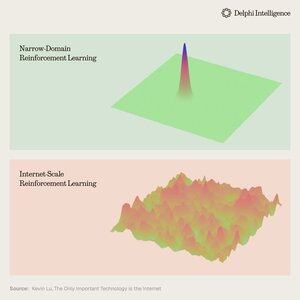

9) Tuttavia, creare questi ambienti è piuttosto laborioso e non sembra molto "bitter-lesson-pilled".

@_kevinlu si chiede se ci sia un modo per sfruttare internet per il post-addestramento come è stato fatto per il pre-addestramento?

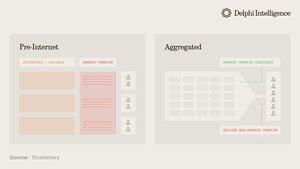

10) Sebbene sia un pensiero interessante, gran parte di Internet è stata catturata da pochi grandi ecosistemi che sono verticalmente integrati e stanno rapidamente conducendo RL attraverso i loro ingredienti per un RL ancora più veloce

(ossia alpha evolve da @GoogleDeepMind)

11) Non è chiaro se queste grandi aziende considerino gli ambienti RL disparati come essenziali o solo una tappa temporanea verso modelli "del mondo" completi, con gemelli digitali di quasi ogni fenomeno.

Genie 3 di Google è sicuramente un segnale in questa direzione:

5 ago, 22:03

E se potessi non solo guardare un video generato, ma esplorarlo anche? 🌐

Genie 3 è il nostro modello di mondo innovativo che crea ambienti interattivi e giocabili a partire da un singolo prompt testuale.

Da paesaggi fotorealistici a regni fantastici, le possibilità sono infinite. 🧵

12) Questo solleva la domanda: gli approcci verticalmente integrati per costruire intelligenza sintetica con loop di feedback RL più veloci sono destinati a progredire rapidamente e catturare il mercato o i sistemi modulari di calcolo latente, dati e talenti possono competere con un'efficace orchestrazione?

11,88K

Principali

Ranking

Preferiti