Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pokud jste si tento týden přečetli jednu věc, doporučili byste níže uvedenou zprávu o umělé inteligenci:

"Od datových sléváren ke světovým modelům"

Prolíná datové foundries, kontextové inženýrství, RL prostředí, světové modely a další do přístupné, ale komplexní eseje o současném okraji AI.👇(0/12)

Celý článek:

🧵pode:

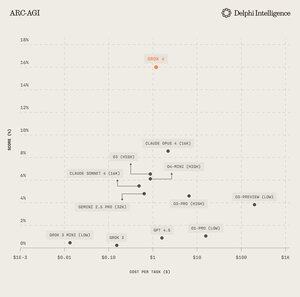

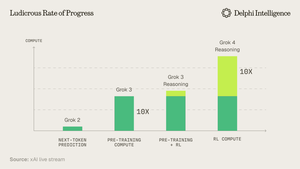

1) Z vydání Grok 4 je jasné, že jsme nenarazili na "zeď" ve výpočetních výdajích.

Zdroj: @xai

2) Stále častěji se zdá, že data jsou krátkým pólem ve stanu.

Zdroj: @EpochAIResearch

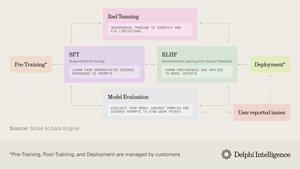

3) Většina těchto výdajů jde na generování vysoce kvalitních datových sad pro post-trénování, což se rychle blíží 50 % výpočetních rozpočtů

4) To vedlo k inflexi poptávky po "datových slévárnách" jako jsou @scale_AI @HelloSurgeAI @mercor_ai a více, kteří pomáhají získávat potřebné odborné znalosti a vytvářet datové kanály nezbytné pro RL v neověřitelných doménách...

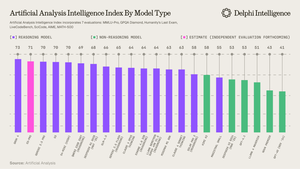

5) Což může pomoci podpořit stále schopnější modely uvažování, jasně škálovací paradigma du jour per @ArtificialAnlys

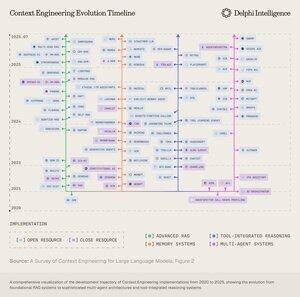

6) A přesto modely již nejsou omezeny IQ, ale kontextem. Prompt engineering předal štafetu "Context Engineering" - rozvíjejícímu se oboru optimalizujícímu užitečné zatížení informací pro LLM.

7) Prostor je extrémně dynamický, ale obecně vyžaduje škálování kontextu napříč 2 vektory:

1. Délka kontextu: výpočetní a architektonické výzvy zpracování ultra dlouhých sekvencí

2. Multimodální: škálování kontextu nad rámec textu do skutečně multimodálních prostředí.

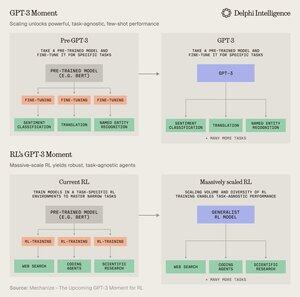

8) Snad nejvyšším vyjádřením kontextového eng. je vytváření "RL prostředí", které dokonale napodobuje úkoly, na kterých může být RL spuštěno.

I když jsou dnes data omezená, @MechanizeWork se domnívá, že směřujeme k inflexi ve stylu "GPT-3" s masivně škálovaným RL

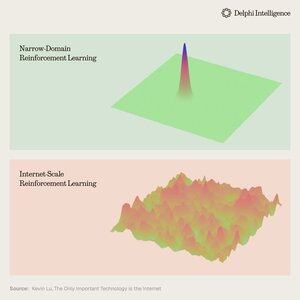

9) Vytváření těchto prostředí je však poměrně náročné na práci a nezdá se být příliš "hořké poučení".

@_kevinlu přemýšlíte, zda existuje způsob, jak využít internet pro post-trénink, jako tomu bylo u předtréninku?

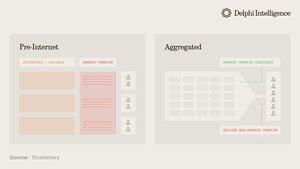

10) I když je to zajímavá myšlenka, velká část internetu byla zachycena několika velkými ekosystémy, které jsou vertikálně integrované a rychle vedou RL napříč svými složkami pro ještě rychlejší RL

(tj. alfa se vyvíjí z @GoogleDeepMind )

11) Není jasné, zda tyto velké společnosti považují různorodá prostředí RL za zásadní, nebo jen za dočasnou zastávku na cestě k úplným "modelům světa", doplněným digitálními dvojčaty téměř každého jevu

Genie 3 od Googlu je určitě kývnutím na tento směr:

5. 8. 22:03

Co kdybyste mohli vygenerované video nejen sledovat, ale také prozkoumávat? 🌐

Genie 3 je náš průkopnický model světa, který vytváří interaktivní, hratelné prostředí z jediné textové výzvy.

Od fotorealistických krajin až po fantasy říše, možnosti jsou nekonečné. 🧵

12) Což vyvolává otázku: jsou vertikálně integrované přístupy k budování syntetické inteligence s rychlejšími zpětnovazebními smyčkami RL předurčeny k tomu, aby se rychle posunuly vpřed a zachytily trh, nebo mohou modulární systémy latentních výpočtů, dat a talentů konkurovat efektivní orchestraci?

11,35K

Top

Hodnocení

Oblíbené