Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

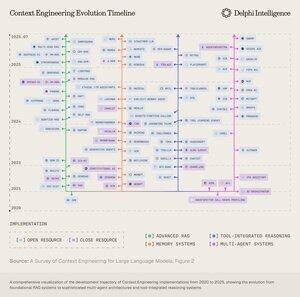

Boop.Fun leading the way with a new launchpad on Solana.

Wenn Sie diese Woche nur eine Sache lesen, empfehle ich den folgenden AI-Bericht:

"Von Datenfabriken zu Weltmodellen"

Er verwebt Datenfabriken, Kontextengineering, RL-Umgebungen, Weltmodelle und mehr zu einem zugänglichen, aber umfassenden Essay über den aktuellen Stand der KI.👇(0/12)

Vollständiger Artikel:

🧵unten:

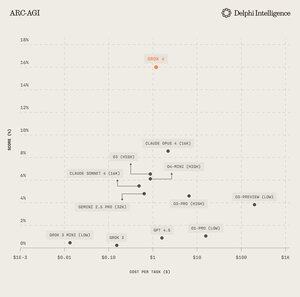

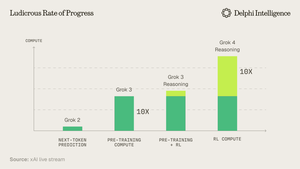

1) Aus der Grok 4 Veröffentlichung ist klar, dass wir "eine Wand" in den Computerausgaben nicht erreicht haben.

Quelle: @xai

2) Zunehmend scheint Daten der kurze Pfahl im Zelt zu sein.

Quelle: @EpochAIResearch

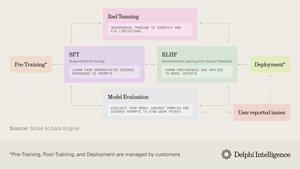

3) Der Großteil dieser Ausgaben fließt in die Erstellung hochwertiger Datensätze für das Post-Training, was schnell 50 % des Rechenbudgets erreicht.

4) Dies hat zu einer Wendung in der Nachfrage nach "Datenfabriken" wie @scale_AI @HelloSurgeAI @mercor_ai & mehr geführt, die helfen, das notwendige Fachwissen zu beschaffen und Datenpipelines zu erstellen, die für RL in nicht verifizierbaren Bereichen unerlässlich sind...

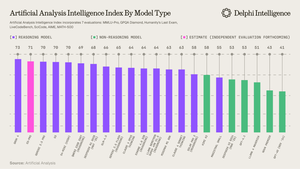

5) Was dazu beitragen kann, immer leistungsfähigere Denkmodelle zu fördern, ist offensichtlich das aktuelle Skalierungsparadigma laut @ArtificialAnlys.

6) Und doch sind Modelle nicht mehr durch IQ, sondern durch den Kontext eingeschränkt. Prompt Engineering hat den Staffelstab an "Context Engineering" übergeben - ein aufstrebendes Feld, das Informationspayloads für LLMs optimiert.

7) Der Raum ist extrem dynamisch, umfasst jedoch im Allgemeinen die Skalierung des Kontexts über 2 Vektoren:

1. Kontextlänge: die rechnerischen und architektonischen Herausforderungen bei der Verarbeitung von ultra-langen Sequenzen

2. Multimodal: den Kontext über Text hinaus auf wirklich multimodale Umgebungen skalieren.

8) Vielleicht ist der ultimative Ausdruck von Kontext-Eng. das Erstellen von "RL-Umgebungen", die Aufgaben perfekt nachahmen, auf denen RL ausgeführt werden kann.

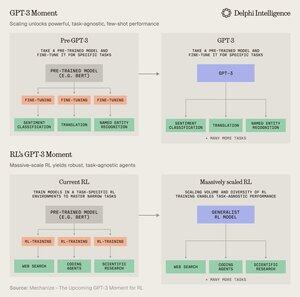

Obwohl wir heute datenbeschränkt sind, glaubt @MechanizeWork, dass wir auf einen "GPT-3-ähnlichen" Wendepunkt mit massiv skaliertem RL zusteuern.

9) Das Erstellen dieser Umgebungen ist jedoch ziemlich arbeitsintensiv und scheint nicht sehr "bitter-lesson-pilled" zu sein.

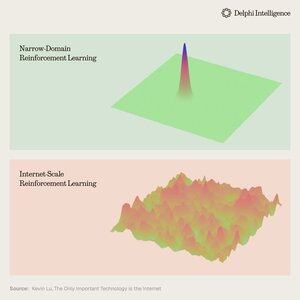

@_kevinlu fragt sich, ob es eine Möglichkeit gibt, das Internet für das Post-Training zu nutzen, wie es für das Pre-Training gemacht wurde?

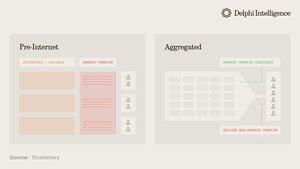

10) Während es ein interessanter Gedanke ist, wurde ein großer Teil des Internets von einigen wenigen großen Ökosystemen erfasst, die vertikal integriert sind und schnell RL über ihre Zutaten durchführen, um noch schnelleres RL zu erreichen

(d.h. Alpha entwickelt sich von @GoogleDeepMind)

11) Es ist unklar, ob diese großen Unternehmen unterschiedliche RL-Umgebungen als wesentlich oder nur als vorübergehenden Halt auf dem Weg zu vollständigen "Weltmodellen" betrachten, die mit digitalen Zwillingen nahezu jedes Phänomens ausgestattet sind.

Genie 3 von Google ist sicherlich ein Hinweis in diese Richtung:

5. Aug., 22:03

Was wäre, wenn Sie nicht nur ein generiertes Video ansehen, sondern es auch erkunden könnten? 🌐

Genie 3 ist unser bahnbrechendes Weltmodell, das interaktive, spielbare Umgebungen aus einem einzigen Textprompt erstellt.

Von fotorealistischen Landschaften bis hin zu fantastischen Reichen sind die Möglichkeiten endlos. 🧵

12) Was die Frage aufwirft: Sind vertikal integrierte Ansätze zum Aufbau synthetischer Intelligenz mit schnelleren RL-Feedback-Schleifen dazu bestimmt, schneller voranzukommen und den Markt zu erobern, oder können modulare Systeme aus latenter Rechenleistung, Daten und Talenten mit effektiver Orchestrierung konkurrieren?

11,87K

Top

Ranking

Favoriten