Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Si vous ne devez lire qu'une chose cette semaine, je vous suggérerais le rapport AI ci-dessous :

"Des fonderies de données aux modèles du monde"

Il entrelace les fonderies de données, l'ingénierie contextuelle, les environnements RL, les modèles du monde et plus encore dans un essai accessible, mais complet sur l'état actuel de l'IA.👇(0/12)

Article complet :

🧵ci-dessous :

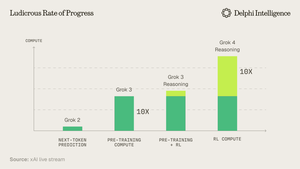

1) À partir de la version Grok 4, il est clair que nous n'avons pas atteint "un mur" en matière de dépenses informatiques.

Source : @xai

2) De plus en plus, les données semblent être le pôle court de la tente.

Source : @EpochAIResearch

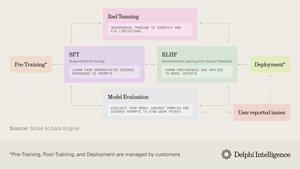

3) La plupart de ces dépenses sont consacrées à la génération de jeux de données de haute qualité pour l'après-formation, ce qui approche rapidement 50 % des budgets de calcul.

4) Cela a conduit à une inflexion de la demande pour des "fonderies de données" comme @scale_AI @HelloSurgeAI @mercor_ai et d'autres qui aident à sourcer l'expertise nécessaire et à créer des pipelines de données essentiels pour le RL dans des domaines non vérifiables...

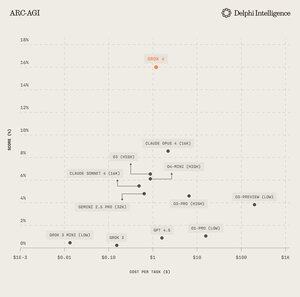

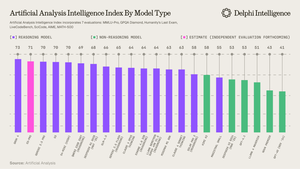

5) Ce qui peut aider à alimenter des modèles de raisonnement de plus en plus performants, clairement le paradigme de mise à l'échelle du jour selon @ArtificialAnlys

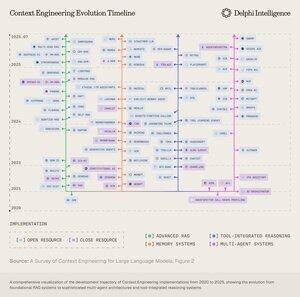

6) Et pourtant, les modèles ne sont plus contraints par le QI mais par le contexte. L'ingénierie des prompts a cédé le flambeau à "l'ingénierie du contexte" - un domaine en plein essor qui optimise les charges d'information pour les LLM.

7) L'espace est extrêmement dynamique mais implique généralement l'échelle du contexte sur 2 vecteurs :

1. Longueur du contexte : les défis computationnels et architecturaux du traitement de séquences ultra-longues

2. Multimodal : étendre le contexte au-delà du texte vers de véritables environnements multimodaux.

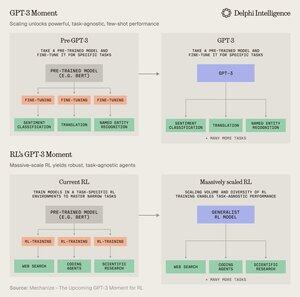

8) Peut-être l'expression ultime du contexte eng. est de créer des "environnements RL" qui imitent parfaitement les tâches sur lesquelles le RL peut être exécuté.

Bien que les données soient limitées aujourd'hui, @MechanizeWork croit que nous nous dirigeons vers une inflexion "à la GPT-3" avec un RL massivement évolué.

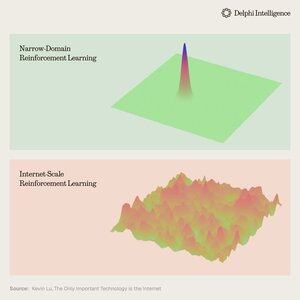

9) Cependant, créer ces environnements est assez laborieux et ne semble pas très "bitter-lesson-pilled".

@_kevinlu se demande s'il existe un moyen d'exploiter Internet pour le post-entraînement comme cela a été fait pour le pré-entraînement ?

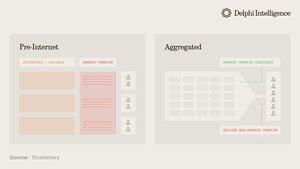

10) Bien qu'il s'agisse d'une pensée intéressante, une grande partie d'Internet a été capturée par quelques grands écosystèmes qui sont intégrés verticalement et mènent rapidement des RL à travers leurs ingrédients pour un RL encore plus rapide

(c'est-à-dire alpha évolue de @GoogleDeepMind)

11) Il n'est pas clair si ces grandes entreprises considèrent les environnements RL disparates comme essentiels ou simplement comme une étape temporaire en route vers des "modèles du monde" complets, avec des jumeaux numériques de presque tous les phénomènes.

Genie 3 de Google est certainement un clin d'œil dans cette direction :

5 août, 22:03

Que se passerait-il si vous pouviez non seulement regarder une vidéo générée, mais aussi l'explorer ? 🌐

Genie 3 est notre modèle de monde révolutionnaire qui crée des environnements interactifs et jouables à partir d'un seul texte d'invite.

Des paysages photoréalistes aux royaumes fantastiques, les possibilités sont infinies. 🧵

12) Ce qui soulève la question : les approches intégrées verticalement pour construire une intelligence synthétique avec des boucles de rétroaction RL plus rapides sont-elles destinées à prendre de l'avance et à capturer le marché ou les systèmes modulaires de calcul latent, de données et de talents peuvent-ils rivaliser avec une orchestration efficace ?

11,87K

Meilleurs

Classement

Favoris