トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

今週 1 つのことを読んだら、以下の AI レポートを提案します。

「データファウンドリからワールドモデルへ」

データファウンドリ、コンテキストエンジニアリング、RL環境、ワールドモデルなどを織り交ぜて、AIの現在のエッジに関する親しみやすく包括的なエッセイにまとめています(👇 0/12)

記事全文:

🧵以下に:

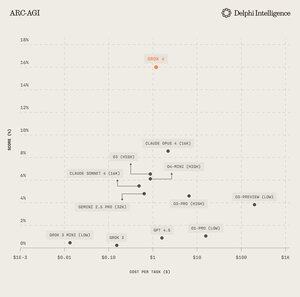

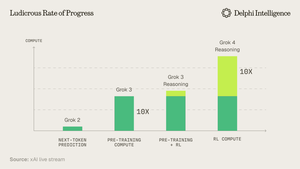

1) Grok 4 のリリースから、コンピューティング支出で「壁」にぶつかっていないことは明らかです。

出典:@xai

2) ますます、データはテントの短いポールのように見えます。

出典:@EpochAIResearch

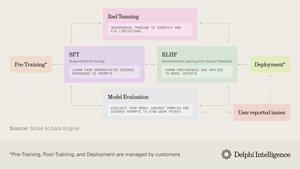

3) この支出のほとんどは、コンピューティング予算の 50% に急速に近づいているポストトレーニング用の高品質のデータセットの生成に充てられています

4) これにより、@scale_AI @HelloSurgeAI @mercor_ai & More のような「データ ファウンドリ」の需要が急増し、検証不可能な領域で RL に必要な専門知識を調達し、データ パイプラインを作成するのを支援しています。

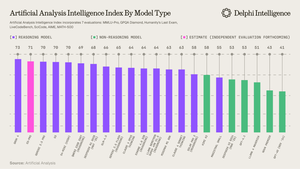

5) これは、これまで以上に有能な推論モデル、明らかに@ArtificialAnlysごとのスケーリング パラダイムを促進するのに役立ちます

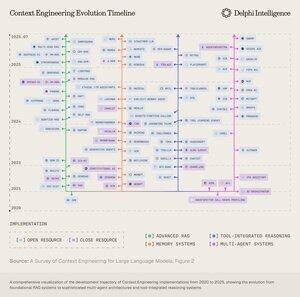

6) それでも、モデルはもはや IQ ではなくコンテキストによって制約されます。プロンプトエンジニアリングは、LLMへの情報ペイロードを最適化する急成長中の分野である「コンテキストエンジニアリング」にバトンを渡しました。

7)空間は非常に動的ですが、一般的には2つのベクトルにまたがるコンテキストのスケーリングを伴います。

1. コンテキストの長さ: 超長いシーケンスを処理する際の計算上およびアーキテクチャ上の課題

2. マルチモーダル: コンテキストをテキストを超えて真のマルチモーダル環境にスケーリングします。

8) おそらく、コンテキスト工学の究極の表現は、RL を実行できるタスクを完全に模倣する「RL 環境」を作成することです。

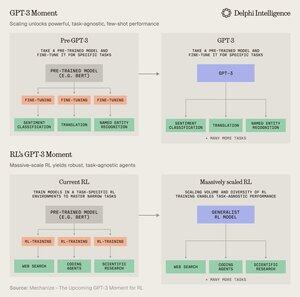

現在、データは制限されていますが、@MechanizeWork は、大規模にスケールされた RL による「GPT-3 風」の変曲に向かっていると考えています

9) ただし、これらの環境の作成は非常に労働集約的であり、それほど「苦い教訓」ではないようです。

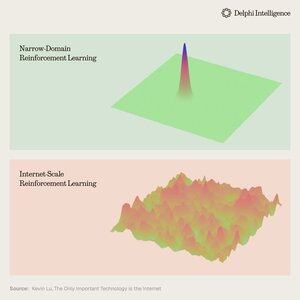

@_kevinlu、事前トレーニングで行われたように、トレーニング後にインターネットを利用する方法があるかどうか疑問に思っていますか?

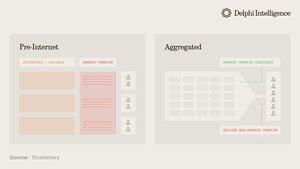

10) 興味深い考えではありますが、インターネットの大部分は、垂直統合され、さらに高速な RL のために成分全体で RL を迅速に実施しているいくつかの大規模なエコシステムによって占領されています

(つまり、アルファは@GoogleDeepMindから進化します)

11) これらの大企業が、異種のRL環境を不可欠と見なしているのか、それともほぼすべての現象のデジタルツインを備えた完全な「世界モデル」に向かう途中の一時的な停留所にすぎないのかは不明です

Google の Genie 3 は確かにこの方向へのうなずきです。

8月5日 22:03

生成されたビデオを見るだけでなく、探索もできたらどうなるでしょうか?🌐

Genie 3 は、単一のテキスト プロンプトからインタラクティブでプレイ可能な環境を作成する画期的なワールド モデルです。

フォトリアリスティックな風景からファンタジーの世界まで、可能性は無限大です。🧵

12) より高速な RL フィードバック ループを備えた合成知能を構築するための垂直統合型アプローチは、より迅速に前進し、市場を獲得する運命にあるのでしょうか、それとも潜在的なコンピューティング、データ、人材のモジュール式システムが効果的なオーケストレーションと競争できるのでしょうか?

11.86K

トップ

ランキング

お気に入り