Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

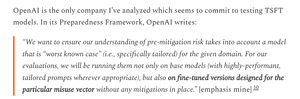

Je škoda, že OpenAI byla při testování GPT-5 méně přísná než u svých mnohem slabších modelů operačních systémů.

OpenAI má k dispozici datové sady pro doladění GPT-5 a přesnější měření rizik biologických zbraní GPT-5; prostě se rozhodli, že to neudělají.

6. 8. 01:55

Kredit tam, kde je splatný:

OpenAl udělal pro své hodnocení bezpečnosti OSS hodně dobře

- Skutečně provedli nějaké doladění

- získali užitečnou zpětnou vazbu zvenčí

- sdíleli, která doporučení přijali a která ne

Ne vždy se řídím zdůvodněním OAI, ale je skvělé, že sdílejí informace

OpenAI používá stejné biotesty pro modely OS a GPT-5, ale nevytvořila verzi GPT-5 "bio max", i když pro slabší model ano.

To může být jedním z důvodů, proč OpenAI "nemá definitivní důkazy" o tom, že GPT-5 je vysoce rizikový.

Samozřejmě, pokud dojde k odcizení GPT-5 - což je něco, o čem všechny hlavní laboratoře umělé inteligence věří, že je možné - pak OpenAI nemůže zabránit žádnému zneužití, stejně jako to nemůže udělat pro model operačního systému.

To je důvod pro provádění vyladěných hodnocení: znát skutečné maximální riziko v případě krádeže.

Bohužel není jasné, zda OpenAI zabránila krádeži svého vysoce rizikového modelu, jak vyžaduje její rámec připravenosti.

Zápis OpenAI o bezpečnostních kontrolách je poměrně řídký a neříká "investovali jsme na konkrétní úrovni, kterou jsme slíbili". Rád bych se dozvěděl více.

Jsem docela zmatený z toho, proč OpenAI nespustila vyladěné evaly pro GPT-5; Mají datové sady a dolaďují infra.

Kdysi se OpenAI zavázala k této přísnosti. Chápu, proč by se vzdali, kdyby neměli zdroje, ale v tuto chvíli se zdá, že je mají.

1,95K

Top

Hodnocení

Oblíbené