Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Det er en bummer at OpenAI var mindre streng med GPT-5-testingen enn for deres mye svakere OS-modeller.

OpenAI har datasettene tilgjengelig for å finjustere GPT-5 og måle GPT-5s biovåpenrisiko mer nøyaktig; de velger bare å ikke gjøre det.

6. aug., 01:55

Kreditt der det forfaller:

OpenAl gjorde mye riktig for OSS-sikkerhetsvurderingene sine

- de gjorde faktisk noen finjusteringer

- de fikk nyttige eksterne tilbakemeldinger

- De delte hvilke anbefalinger de tok i bruk og hvilke de ikke gjorde

Jeg følger ikke alltid OAIs begrunnelse, men det er flott at de deler informasjon

OpenAI bruker de samme biotestene for OS-modellene og GPT-5, men laget ikke en "bio max"-versjon av GPT-5, selv om de gjorde det for den svakere modellen.

Dette kan være en grunn til at OpenAI "ikke har definitive bevis" for at GPT-5 er høyrisiko.

Selvfølgelig, hvis GPT-5 blir stjålet - noe de store AI-laboratoriene alle tror er mulig - så kan ikke OpenAI stoppe misbruk, akkurat som de ikke kan for en OS-modell.

Dette er begrunnelsen for å kjøre finjusterte evalueringer: å vite den faktiske maksimale risikoen hvis den blir stjålet.

Dessverre er det ikke klart at OpenAI har forhindret tyveri av høyrisikomodellen, slik det kreves av beredskapsrammeverket.

OpenAIs oppskrivning av sikkerhetskontroller er ganske sparsom og sier ikke "vi har investert på det spesifikke nivået vi hadde lovet." Jeg vil gjerne vite mer.

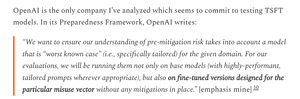

Jeg er ganske forvirret over hvorfor OpenAI ikke kjørte finjusterte evalueringer for GPT-5; de har datasettene og finjusteringen av infra.

En gang hadde OpenAI forpliktet seg til denne strengheten. Jeg skjønner hvorfor de ville gi opp hvis de ikke har ressursene, men på dette tidspunktet ser det tydeligvis ut til at de har dem.

1,8K

Topp

Rangering

Favoritter