Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

È un peccato che OpenAI sia stata meno rigorosa con i test di GPT-5 rispetto ai loro modelli OS molto più deboli.

OpenAI ha a disposizione i dataset per affinare GPT-5 e misurare i rischi biologici di GPT-5 in modo più accurato; stanno semplicemente scegliendo di non farlo.

6 ago, 01:55

Il credito dove è dovuto:

OpenAI ha fatto molte cose giuste per le loro valutazioni di sicurezza OSS

- hanno effettivamente fatto un po' di fine-tuning

- hanno ricevuto feedback esterni utili

- hanno condiviso quali raccomandazioni hanno adottato e quali no

Non seguo sempre la logica di OAI, ma è fantastico che condividano informazioni.

OpenAI utilizza gli stessi bio-test per i modelli OS e GPT-5, ma non ha creato una versione "bio max" di GPT-5, anche se lo ha fatto per il modello più debole.

Questa potrebbe essere una delle ragioni per cui OpenAI "non ha prove definitive" riguardo al fatto che GPT-5 sia ad alto rischio.

Certo, se GPT-5 viene rubato - qualcosa che tutti i principali laboratori di intelligenza artificiale credono sia possibile - allora OpenAI non può fermare alcun uso improprio, proprio come non può fare per un modello di sistema operativo.

Questa è la motivazione per eseguire valutazioni fine-tuned: per conoscere il reale rischio massimo in caso di furto.

Sfortunatamente, non è chiaro se OpenAI abbia prevenuto il furto del suo modello ad alto rischio, come richiesto dal suo Framework di Preparazione.

La descrizione dei controlli di sicurezza di OpenAI è piuttosto scarna e non afferma 'abbiamo investito al livello specifico che avevamo promesso.' Vorrei saperne di più.

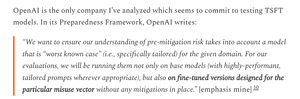

Sono piuttosto confuso sul motivo per cui OpenAI non abbia eseguito valutazioni fine-tuned per GPT-5; hanno a disposizione i dataset e l'infrastruttura per il fine-tuning.

Una volta, OpenAI si era impegnata in questa rigorosità. Capisco perché potrebbero tirarsi indietro se non hanno le risorse, ma a questo punto, sembrano chiaramente averle.

1,96K

Principali

Ranking

Preferiti