Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

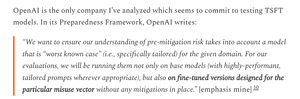

Szkoda, że OpenAI był mniej rygorystyczny w testach GPT-5 niż w przypadku swoich znacznie słabszych modeli OS.

OpenAI ma dostępne zbiory danych, aby dostosować GPT-5 i dokładniej ocenić ryzyko broni biologicznej związane z GPT-5; po prostu decydują się tego nie robić.

6 sie, 01:55

Zasługują na uznanie:

OpenAI zrobiło wiele dobrego w swoich ocenach bezpieczeństwa OSS

- faktycznie przeprowadzili pewne dostosowania

- otrzymali przydatne opinie zewnętrzne

- podzielili się informacjami, które zalecenia przyjęli, a które odrzucili

Nie zawsze rozumiem racjonalność OAI, ale świetnie, że dzielą się informacjami.

OpenAI używa tych samych testów biologicznych dla modeli OS i GPT-5, ale nie stworzyło wersji "bio max" GPT-5, chociaż zrobili to dla słabszego modelu.

To może być jeden z powodów, dla których OpenAI "nie ma definitywnych dowodów" na to, że GPT-5 jest wysokiego ryzyka.

Oczywiście, jeśli GPT-5 zostanie skradziony - coś, co wszystkie główne laboratoria AI uważają za możliwe - to OpenAI nie może powstrzymać żadnych nadużyć, tak jak nie mogą tego zrobić w przypadku modelu OS.

To jest uzasadnienie dla przeprowadzania dokładnych ocen: aby znać rzeczywiste maksymalne ryzyko w przypadku kradzieży.

Niestety, nie jest jasne, czy OpenAI zapobiegło kradzieży swojego modelu wysokiego ryzyka, co jest wymagane przez jego Ramy Przygotowawcze.

Opis zabezpieczeń OpenAI jest dość skąpy i nie mówi 'zainwestowaliśmy na poziomie, który obiecaliśmy.' Chciałbym wiedzieć więcej.

Jestem dość zdezorientowany, dlaczego OpenAI nie przeprowadziło ocen dostosowanych dla GPT-5; mają przecież zbiory danych i infrastrukturę do fine-tuningu.

Kiedyś OpenAI zobowiązało się do tej rygorystycznej procedury. Rozumiem, dlaczego mogliby się wycofać, jeśli nie mają zasobów, ale w tym momencie wyraźnie wydaje się, że je mają.

1,96K

Najlepsze

Ranking

Ulubione