トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

OpenAI が GPT-5 テストにおいて、はるかに弱い OS モデルよりも厳格でなかったのは残念です。

OpenAI は、GPT-5 を微調整し、GPT-5 の生物兵器のリスクをより正確に測定するために利用できるデータセットを持っています。彼らはただそうしないことを選択しているだけです。

8月6日 01:55

クレジットは、当然のことながらクレジットしてください。

OpenAlは、OSSの安全性評価で多くのことを正しく行いました

- 彼らは実際にいくつかの微調整を行いました

- 彼らは有益な外部フィードバックを得ました

- 彼らは、どのレクを採用し、どのレクを採用しなかったかを共有しました

私は常にOAIの理論的根拠に従うわけではありませんが、彼らが情報を共有するのは素晴らしいことです

OpenAIは、OSモデルとGPT-5に同じバイオテストを使用していますが、弱いモデルでは作成したにもかかわらず、GPT-5の「バイオマックス」バージョンを作成しませんでした。

これが、OpenAIがGPT-5が高リスクであるという「決定的な証拠を持っていない」理由の1つかもしれません。

もちろん、GPT-5 が盗まれた場合 (主要な AI 研究所はすべて可能であると信じています)、OpenAI は OS モデルの場合と同様に、悪用を止めることはできません。

これが、微調整された評価を実行する理論的根拠であり、盗難された場合の実際の最大リスクを知るためです。

残念ながら、OpenAIが準備フレームワークで要求されているように、高リスクモデルの盗難を防いだかどうかは明らかではありません。

OpenAIのセキュリティ管理に関する記事はかなりまばらで、「約束した特定のレベルで投資した」とは言っていません。もっと知りたいです。

OpenAI が GPT-5 の微調整された評価を実行しなかった理由について、私はかなり混乱しています。データセットとインフラの微調整があります。

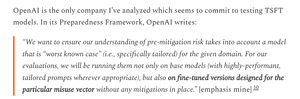

かつて、OpenAIはこの厳格さにコミットしていました。リソースがないのになぜ彼らが反逆するのかは理解できますが、現時点では明らかにリソースがあるようです。

1.95K

トップ

ランキング

お気に入り