Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Este o dezamăgire că OpenAI a fost mai puțin riguros cu testarea GPT-5 decât cu modelele lor de sistem de operare mult mai slabe.

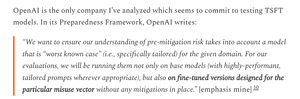

OpenAI are seturile de date disponibile pentru a regla GPT-5 și a măsura mai precis riscurile armelor biologice ale GPT-5; pur și simplu aleg să nu o facă.

6 aug., 01:55

Credit acolo unde se cuvine:

OpenAl a făcut multe lucruri corecte pentru evaluările de siguranță OSS

- De fapt, au făcut niște ajustări fine

- au primit feedback extern util

- au împărtășit ce recomandări au adoptat și care nu

Nu urmez întotdeauna raționamentul OAI, dar este grozav că împărtășesc informații

OpenAI folosește aceleași teste biologice pentru modelele de sistem de operare și GPT-5, dar nu a creat o versiune "bio max" a GPT-5, chiar dacă au făcut-o pentru modelul mai slab.

Acesta ar putea fi unul dintre motivele pentru care OpenAI "nu are dovezi definitive" despre GPT-5 ca fiind cu risc ridicat.

Desigur, dacă GPT-5 este furat - ceva ce toate marile laboratoare de inteligență artificială cred că este posibil - atunci OpenAI nu poate opri nicio utilizare abuzivă, la fel cum nu poate pentru un model de sistem de operare.

Acesta este raționamentul pentru efectuarea evaluărilor reglate: pentru a cunoaște riscul maxim real în caz de furt.

Din păcate, nu este clar dacă OpenAI a prevenit furtul modelului său cu risc ridicat, așa cum cere cadrul său de pregătire.

Scrierea OpenAI despre controalele de securitate este destul de rară și nu spune "am investit la nivelul specific pe care l-am promis". Aș vrea să știu mai multe.

Sunt destul de confuz de ce OpenAI nu a rulat evaluări reglate pentru GPT-5; au seturile de date și infrastructura de reglare fină.

Odată, OpenAI s-a angajat la această rigoare Înțeleg de ce ar renega dacă nu au resursele, dar în acest moment, se pare clar că le au.

1,8K

Limită superioară

Clasament

Favorite