熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

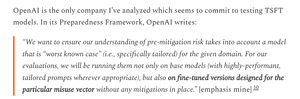

OpenAI在GPT-5的測試上不如對其較弱的OS模型那麼嚴謹,這真是令人失望。

OpenAI擁有可用於微調GPT-5的數據集,並能更準確地衡量GPT-5的生物武器風險;他們只是選擇不這樣做。

8月6日 01:55

應該給予應有的讚譽:

OpenAI 在他們的開源安全評估中做了很多正確的事情

- 他們實際上進行了一些微調

- 他們獲得了有用的外部反饋

- 他們分享了採納了哪些建議,哪些沒有

我並不總是理解 OAI 的理由,但他們分享資訊真是太好了。

OpenAI 對 OS 模型和 GPT-5 使用相同的生物測試,但並未為 GPT-5 創建 "bio max" 版本,儘管他們為較弱的模型創建了這個版本。

這可能是 OpenAI "沒有確鑿證據" 表明 GPT-5 具有高風險的原因之一。

當然,如果GPT-5被盜 - 這是所有主要AI實驗室都認為可能發生的事情 - 那麼OpenAI無法阻止任何濫用,就像他們無法對一個操作系統模型那樣。

這就是進行微調評估的理由:了解如果被盜的實際最大風險。

不幸的是,OpenAI 是否已根據其準備框架防止其高風險模型被盜竊尚不清楚。

OpenAI 對安全控制的說明相當簡略,並未提到「我們已在承諾的具體水平上進行了投資。」我想知道更多。

我對於為什麼 OpenAI 沒有為 GPT-5 進行微調評估感到相當困惑;他們確實擁有數據集和微調基礎設施。

曾經,OpenAI 承諾過這種嚴謹性。我明白如果他們沒有資源會撤回這個承諾,但在這個時候,他們顯然似乎擁有這些資源。

1.95K

熱門

排行

收藏