Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

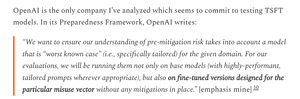

É uma pena que a OpenAI tenha sido menos rigorosa com seus testes GPT-5 do que com seus modelos de sistema operacional muito mais fracos.

A OpenAI tem os conjuntos de dados disponíveis para ajustar o GPT-5 e medir os riscos de armas biológicas do GPT-5 com mais precisão; eles estão apenas optando por não fazê-lo.

6 de ago., 01:55

Crédito onde é devido:

A OpenAl fez muito certo para suas avaliações de segurança OSS

- eles realmente fizeram alguns ajustes finos

- eles receberam feedback externo útil

- Eles compartilharam quais RECs adotaram e quais não adotaram

Nem sempre sigo o raciocínio da OAI, mas é ótimo que eles compartilhem informações

A OpenAI usa os mesmos testes biológicos para os modelos de sistema operacional e GPT-5, mas não criou uma versão "bio max" do GPT-5, embora tenha criado para o modelo mais fraco.

Essa pode ser uma das razões pelas quais a OpenAI "não tem evidências definitivas" sobre o GPT-5 ser de alto risco.

É claro que, se o GPT-5 for roubado - algo que os principais laboratórios de IA acreditam ser possível - a OpenAI não poderá impedir nenhum uso indevido, assim como não pode para um modelo de sistema operacional.

Esta é a justificativa para executar avaliações ajustadas: saber o risco máximo real em caso de roubo.

Infelizmente, não está claro se a OpenAI impediu o roubo de seu modelo de alto risco, conforme exigido por sua estrutura de preparação.

A descrição da OpenAI sobre controles de segurança é bastante esparsa e não diz 'investimos no nível específico que prometemos'. Eu gostaria de saber mais.

Estou muito confuso sobre por que a OpenAI não executou avaliações ajustadas para GPT-5; eles têm os conjuntos de dados e a infra-estrutura de ajuste fino.

Uma vez, a OpenAI se comprometeu com esse rigor. Eu entendo por que eles renegariam se não tivessem os recursos, mas neste momento, eles claramente parecem tê-los.

2,26K

Melhores

Classificação

Favoritos