Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

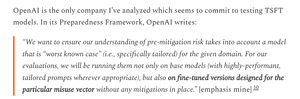

Жаль, что OpenAI была менее строгой в тестировании GPT-5, чем в случае с их гораздо более слабыми моделями OS.

У OpenAI есть доступные наборы данных для дообучения GPT-5 и более точной оценки рисков биологического оружия, но они просто выбирают этого не делать.

6 авг., 01:55

Должно быть признано:

OpenAI сделала много правильного в своих оценках безопасности OSS

- они действительно провели некоторую донастройку

- они получили полезные внешние отзывы

- они поделились тем, какие рекомендации они приняли, а какие нет

Я не всегда следую логике OAI, но здорово, что они делятся информацией

OpenAI использует одни и те же биотесты для моделей ОС и GPT-5, но не создала версию "bio max" для GPT-5, хотя сделала это для более слабой модели.

Это может быть одной из причин, по которой у OpenAI "нет окончательных доказательств" того, что GPT-5 является высокорисковым.

Конечно, если GPT-5 будет украден, - что все крупные лаборатории ИИ считают возможным, - то OpenAI не сможет остановить никакие злоупотребления, так же как они не могут сделать это для модели ОС.

Это и есть причина проведения тонко настроенных оценок: чтобы знать фактический максимальный риск в случае кражи.

К сожалению, неясно, предотвратила ли OpenAI кражу своей модели высокого риска, как того требует ее Рамочная программа готовности.

Описание мер безопасности OpenAI довольно скудное и не говорит: «мы инвестировали на том уровне, который обещали». Мне хотелось бы узнать больше.

Я довольно запутан, почему OpenAI не провела оценку с дообучением для GPT-5; у них есть наборы данных и инфраструктура для дообучения.

Когда-то OpenAI была привержена этой строгости. Я понимаю, почему они могли бы отказаться, если у них нет ресурсов, но на данный момент, похоже, у них они явно есть.

1,96K

Топ

Рейтинг

Избранное