Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

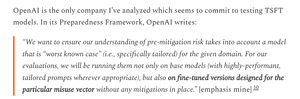

Thật đáng tiếc khi OpenAI đã không nghiêm ngặt trong việc kiểm tra GPT-5 như với các mô hình OS yếu hơn nhiều.

OpenAI có các tập dữ liệu sẵn có để tinh chỉnh GPT-5 và đo lường chính xác hơn các rủi ro vũ khí sinh học của GPT-5; họ chỉ đơn giản là không chọn làm vậy.

01:55 6 thg 8

Công nhận công lao:

OpenAI đã làm rất nhiều điều đúng cho các đánh giá an toàn OSS của họ

- họ thực sự đã thực hiện một số điều chỉnh

- họ đã nhận được phản hồi hữu ích từ bên ngoài

- họ đã chia sẻ những khuyến nghị mà họ đã áp dụng và những cái họ không áp dụng

Tôi không phải lúc nào cũng theo dõi lý do của OAI, nhưng thật tuyệt khi họ chia sẻ thông tin.

OpenAI sử dụng cùng một bài kiểm tra sinh học cho các mô hình OS và GPT-5, nhưng không tạo ra phiên bản "bio max" của GPT-5, mặc dù họ đã làm điều đó cho mô hình yếu hơn.

Điều này có thể là một lý do mà OpenAI "không có bằng chứng rõ ràng" về việc GPT-5 có rủi ro cao.

Tất nhiên, nếu GPT-5 bị đánh cắp - điều mà tất cả các phòng thí nghiệm AI lớn đều tin là có thể xảy ra - thì OpenAI không thể ngăn chặn bất kỳ sự lạm dụng nào, cũng giống như họ không thể làm với một mô hình hệ điều hành.

Đây là lý do cho việc thực hiện các đánh giá tinh chỉnh: để biết được rủi ro tối đa thực sự nếu bị đánh cắp.

Thật không may, không rõ OpenAI đã ngăn chặn việc đánh cắp mô hình rủi ro cao của mình như yêu cầu trong Khung chuẩn bị của họ hay chưa.

Bản viết của OpenAI về các biện pháp kiểm soát an ninh khá sơ sài và không nói 'chúng tôi đã đầu tư ở mức cụ thể mà chúng tôi đã hứa.' Tôi muốn biết thêm.

Tôi khá bối rối về việc tại sao OpenAI không thực hiện các đánh giá tinh chỉnh cho GPT-5; họ có các bộ dữ liệu và cơ sở hạ tầng tinh chỉnh.

Một lần, OpenAI đã cam kết với sự nghiêm ngặt này. Tôi hiểu tại sao họ lại từ bỏ nếu họ không có đủ nguồn lực, nhưng ở thời điểm này, họ rõ ràng dường như đã có đủ.

1,96K

Hàng đầu

Thứ hạng

Yêu thích