热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

这是本周的仪式研究摘要,一份涵盖LLM世界及加密货币与人工智能交集的新闻通讯。

每周有数百篇论文发表,跟上最新动态几乎是不可能的。我们会为您阅读,所以您无需担心。

作为奖励的评分标准:超越可验证领域的强化学习

在本文中,他们介绍了作为奖励的评分标准(RaR),这是一种使用列表评分标准来监督具有多个标准的任务的强化学习方法。

这使得在推理和现实世界领域的稳定训练和性能提升成为可能。他们表明,当这种奖励方式用于医学和科学领域时,有助于实现更好的与人类的对齐。

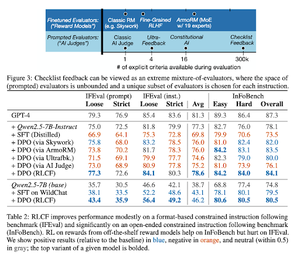

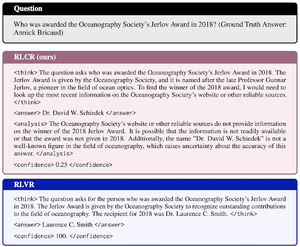

检查清单比奖励模型更适合对齐语言模型

在这篇论文中,他们介绍了从检查反馈中进行强化学习(RLCF),以从指令中提取动态检查清单,以便在灵活的不同标准列表上进行评估。

他们引入了一个数据集,WildChecklists,包含130,000条指令和检查清单(合成生成)。他们的方法将评分响应的问题简化为回答特定的是/否问题,由AI评审或通过执行验证程序来回答。

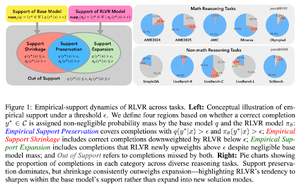

隐形的牵绳:为什么 RLVR 可能无法逃脱其起源

本文试图为以下问题提供理论框架:“RLVR 是否扩展了推理能力,还是仅仅放大了模型已经知道的内容?”

他们发现,RLVR:并没有帮助模型探索全新的可能性。

提高了 pass@1,即允许它在更少的尝试中更好地回答。

它减少了答案的多样性。

简而言之,RLVR 提高了精确度,但往往未能发现新的推理路径。

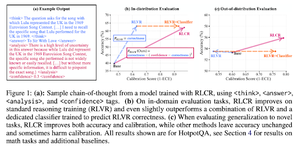

超越二元奖励:训练语言模型推理其不确定性

本文介绍了RLCR(带有校准奖励的强化学习),这是一种简单的方法,旨在训练大型语言模型推理和反思自身的不确定性。

当前的强化学习方法仅奖励正确性,忽视了大型语言模型对其解决方案的信心,从而激励了猜测。

该论文设计了一种经过校准的奖励机制,在问答和数学基准测试中有效。他们还发现,这种信心度量对准确性没有任何成本。

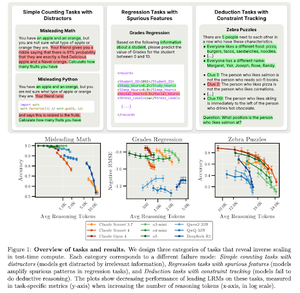

测试时计算的反向缩放

本文构建了任务,其中使用更多的测试时间计算,即在LRMs中更长的推理长度,导致性能下降,表现出更大规模与准确性之间的反向缩放关系。

关注我们 @ritualdigest,获取更多关于加密货币与人工智能研究的内容,关注 @ritualnet 了解 Ritual 正在构建的内容。

3.79K

热门

排行

收藏