Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier is de Ritual Research Digest van deze week, een nieuwsbrief die het laatste nieuws in de wereld van LLM's en de kruising van Crypto x AI behandelt.

Met honderden gepubliceerde artikelen per week is het onmogelijk om op de hoogte te blijven van het laatste nieuws. Wij doen het lezen, zodat jij dat niet hoeft te doen.

Rubrics als Beloningen: Versterkend Leren Buiten Verifieerbare Domeinen

In dit artikel introduceren ze Rubrics als Beloningen (RaR), een RL-methode die Lijstrubrieken gebruikt om taken te superviseren die meerdere criteria hebben.

Dit maakt stabiele training en verbeterde prestaties mogelijk in zowel redeneervaardigheden als in de echte wereld. Ze tonen aan dat wanneer dit wordt gebruikt voor geneeskunde en wetenschappen, deze stijl van beloningen helpt om een betere afstemming op de mens te bereiken.

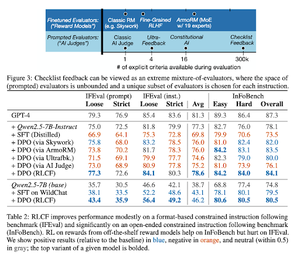

Checklists zijn beter dan beloningsmodellen voor het afstemmen van taalmodellen

In dit artikel introduceren ze Reinforcement Learning from Checklist Feedback (RLCF) om dynamische checklists uit instructies te extraheren om te evalueren op flexibele lijsten van verschillende criteria.

Ze introduceren een dataset, WildChecklists, bestaande uit 130.000 instructies en checklists (synthetisch gegenereerd). Hun methode reduceert het probleem van het beoordelen van antwoorden tot het beantwoorden van specifieke ja/nee-vragen, beantwoord door een AI-rechter of door het uitvoeren van een verificatieprogramma.

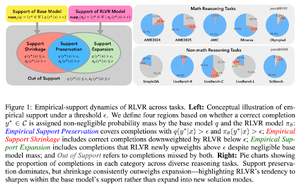

De Onzichtbare Leash: Waarom RLVR Mogelijk Niet Zijn Oorsprong Ontvlucht

Dit artikel probeert een theoretisch kader te bieden voor de vraag: "Breidt RLVR de redeneercapaciteiten uit of versterkt het alleen wat modellen al weten?"

Ze ontdekken dat RLVR: het model niet helpt om volledig nieuwe mogelijkheden te verkennen.

Verbetert pass@1, d.w.z. het stelt het in staat om beter te antwoorden in minder pogingen.

Het vermindert de diversiteit van antwoorden.

Kortom, RLVR verbetert de precisie, maar slaagt er vaak niet in om nieuwe redeneerpaden te ontdekken.

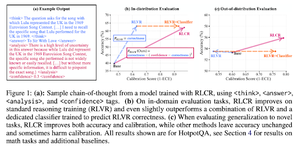

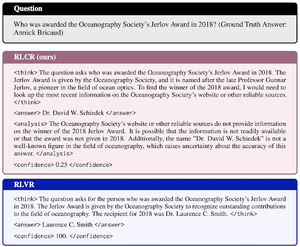

Voorbij Binaire Beloningen: Leren van LMs om te Redeneren over Hun Onzekerheid

Dit paper introduceert RLCR (Reinforcement Learning met Calibratiebeloningen), een eenvoudige methode die LLM's traint om te redeneren en na te denken over hun eigen onzekerheid.

Huidige RL-methoden belonen alleen correctheid, waarbij het vertrouwen van de LLM in zijn oplossing wordt genegeerd, wat gokken aanmoedigt.

Het paper ontwerpt een gekalibreerde beloning die effectief is op QA- en wiskundige benchmarks. Ze ontdekken ook dat deze vertrouwensmaatregel geen kosten met zich meebrengt voor de nauwkeurigheid.

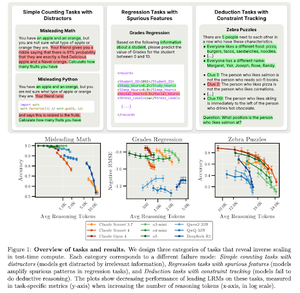

Inverse scaling in testtijdcomputing

Dit artikel construeert taken waarbij het gebruik van meer testtijdcomputing, d.w.z. langere redeneerlengtes in LRM's, resulteert in slechtere prestaties, wat een inverse schaalrelatie tussen meer schaal en nauwkeurigheid aantoont.

Volg ons @ritualdigest voor meer over alles wat met Crypto x AI-onderzoek te maken heeft, en @ritualnet om meer te leren over wat Ritual aan het bouwen is.

3,8K

Boven

Positie

Favorieten