Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Digest de Investigación Ritual de esta semana, un boletín que cubre lo último en el mundo de los LLM y la intersección de Crypto x AI.

Con cientos de artículos publicados semanalmente, mantenerse al día con lo último es imposible. Nosotros haremos la lectura, para que tú no tengas que hacerlo.

Rúbricas como Recompensas: Aprendizaje por Refuerzo Más Allá de los Dominios Verificables

En este artículo, introducen Rúbricas como Recompensas (RaR), un método de aprendizaje por refuerzo que utiliza rúbricas de lista para supervisar tareas que tienen múltiples criterios.

Esto permite un entrenamiento estable y un rendimiento mejorado tanto en dominios de razonamiento como en el mundo real. Muestran que, cuando se utiliza en los dominios de medicina y ciencia, este estilo de recompensas ayuda a lograr una mejor alineación con los humanos.

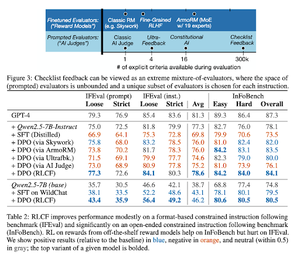

Las listas de verificación son mejores que los modelos de recompensa para alinear modelos de lenguaje

En este artículo, introducen el Aprendizaje por Refuerzo a partir de la Retroalimentación de Listas de Verificación (RLCF) para extraer listas de verificación dinámicas de instrucciones y evaluar en listas flexibles de criterios distintos.

Introducen un conjunto de datos, WildChecklists, que comprende 130,000 instrucciones y listas de verificación (generadas sintéticamente). Su método reduce el problema de calificar respuestas a responder preguntas específicas de sí/no, respondidas por un juez de IA o mediante la ejecución de un programa de verificación.

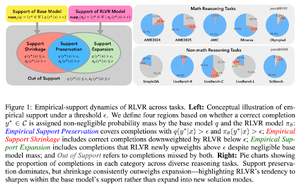

La correa invisible: ¿por qué RLVR puede no escapar de su origen?

Este artículo intenta proporcionar un marco teórico para la pregunta: "¿Amplía RLVR las capacidades de razonamiento o simplemente amplifica lo que los modelos ya saben?"

Descubren que RLVR: no ayuda al modelo a explorar posibilidades completamente nuevas.

Mejora el pass@1, es decir, le permite responder mejor en menos intentos.

Reduce la diversidad de respuestas.

En resumen, RLVR mejora la precisión, pero a menudo no logra descubrir nuevos caminos de razonamiento.

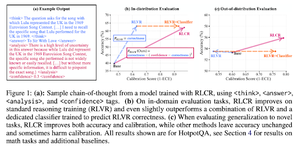

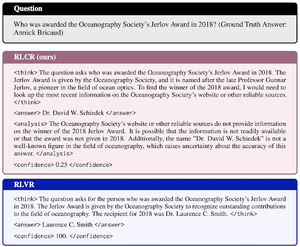

Recompensas Más Allá del Binario: Entrenando LMs para Razonar Sobre su Incertidumbre

Este artículo presenta RLCR (Aprendizaje por Refuerzo con Recompensas de Calibración), un método sencillo que entrena a los LLMs para razonar y reflexionar sobre su propia incertidumbre.

Los métodos actuales de RL solo recompensan la corrección, ignorando la confianza del LLM en su solución, lo que incentiva a adivinar.

El artículo diseña una recompensa calibrada que es efectiva en benchmarks de QA y matemáticas. También descubren que esta medida de confianza no tiene costo para la precisión.

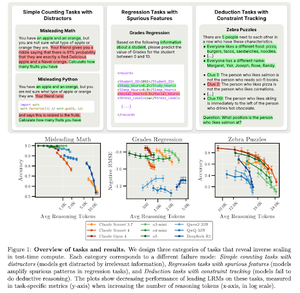

Escalado Inverso en el Cómputo de Tiempo de Prueba

Este artículo construye tareas donde el uso de más cómputo en el tiempo de prueba, es decir, longitudes de razonamiento más largas en LRM, resulta en un peor rendimiento, exhibiendo una relación de escalado inverso entre más escala y precisión.

Síguenos en @ritualdigest para más información sobre todo lo relacionado con la investigación en Crypto x AI, y en @ritualnet para aprender más sobre lo que Ritual está construyendo.

3,8K

Parte superior

Clasificación

Favoritos