Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Вот дайджест Ritual Research за эту неделю, информационный бюллетень, охватывающий последние события в мире LLM и пересечении Crypto x AI.

С сотнями статей, публикуемых еженедельно, оставаться в курсе последних новостей невозможно. Мы будем читать, чтобы вам не пришлось.

Рубрики как Награды: Обучение с Подкреплением за Пределами Проверяемых Областей

В этой статье они представляют Рубрики как Награды (RaR), метод RL, который использует списковые рубрики для контроля задач, имеющих несколько критериев.

Это обеспечивает стабильное обучение и улучшенную производительность как в области рассуждений, так и в реальных условиях. Они показывают, что при использовании в области медицины и науки этот стиль вознаграждений помогает достичь лучшего соответствия с человеком.

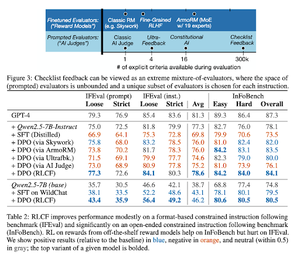

Чек-листы лучше моделей вознаграждения для согласования языковых моделей

В этой статье они представляют Обучение с подкреплением на основе обратной связи из чек-листов (RLCF), чтобы извлекать динамические чек-листы из инструкций для оценки по гибким спискам различных критериев.

Они представляют набор данных WildChecklists, состоящий из 130 000 инструкций и контрольных списков (синтетически сгенерированных). Их метод сводит проблему оценки ответов к ответам на конкретные вопросы с ответами "да/нет", на которые отвечает ИИ-судья или выполняется программа проверки.

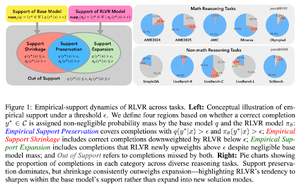

Невидимая привязь: почему RLVR может не вырваться из своего происхождения

В этой статье пытаются предоставить теоретическую основу для вопроса: "Расширяет ли RLVR возможности рассуждения или просто усиливает то, что модели уже знают?"

Они обнаруживают, что RLVR: не помогает модели исследовать совершенно новые возможности.

Улучшает pass@1, т.е. позволяет лучше отвечать за меньшее количество попыток.

Снижает разнообразие ответов.

Кратко, RLVR улучшает точность, но часто не удается открыть новые пути рассуждений.

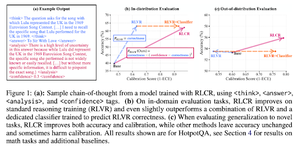

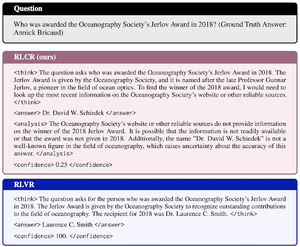

За пределами бинарных вознаграждений: обучение ЛМ рассуждать о своей неопределенности

В этой статье представлено RLCR (Обучение с подкреплением с вознаграждениями за калибровку) — простой метод, который обучает LLM рассуждать и размышлять о своей собственной неопределенности.

Текущие методы RL вознаграждают только за правильность, игнорируя уверенность LLM в своем решении, что поощряет угадывание.

В статье разрабатывается откалиброванное вознаграждение, которое эффективно на тестах QA и математических задачах. Также они обнаруживают, что эта мера уверенности не влияет на точность.

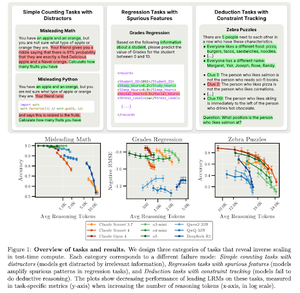

Обратное масштабирование в вычислениях во время тестирования

В этой статье рассматриваются задачи, в которых использование большего времени вычислений во время тестирования, т.е. более длительные длины рассуждений в LRM, приводит к худшей производительности, демонстрируя обратную зависимость между большим масштабом и точностью.

Подписывайтесь на нас @ritualdigest, чтобы узнать больше о всех аспектах исследований в области Crypto x AI, и @ritualnet, чтобы узнать больше о том, что строит Ritual.

3,8K

Топ

Рейтинг

Избранное