トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

今週の Ritual Research Digest は、LLM の世界の最新情報と Crypto x AI の交差点をカバーするニュースレターです。

毎週何百もの論文が発行されているため、最新の情報を入手することは不可能です。私たちが読みますので、その必要はありません。

報酬としてのルーブリック: 検証可能な領域を超えた強化学習

この論文では、リスト ルーブリックを使用して複数の基準を持つタスクを監督する RL 手法である Rubrics as Rewards (RaR) を紹介します。

これにより、推論と現実世界の両方の領域で安定したトレーニングとパフォーマンスの向上が可能になります。彼らは、医学や科学の分野でこのスタイルの報酬を使用すると、人間のより良い調整を達成するのに役立つことを示しています。

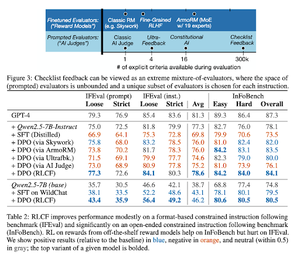

チェックリストは、言語モデルを調整するための報酬モデルよりも優れています

この論文では、チェックリストフィードバックからの強化学習(RLCF)を導入して、命令から動的チェックリストを抽出し、個別の基準の柔軟なリストで評価します。

彼らは、130,000 の命令とチェックリスト (合成的に生成) で構成されるデータセット WildChecklists を導入しています。彼らの方法は、AI 審査員によって回答される、または検証プログラムを実行することによって、特定の yes/no の質問に回答することに対する回答を採点する問題を軽減します。

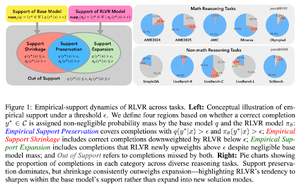

目に見えないリード: RLVR がその起源から逃れられない理由

この論文は、「RLVRは推論能力を拡張するのか、それともモデルがすでに知っていることを増幅するだけなのか?」という質問に対する理論的枠組みを提供しようとしています。

彼らは、RLVR:がモデルがまったく新しい可能性を探求するのに役立たないことを発見しました。

pass@1を向上させる、つまり、より少ない試行でより適切に回答できるようにします。

回答の多様性が減少します。

tl;dr、RLVRは精度を向上させますが、新しい推論パスを発見できないことがよくあります。

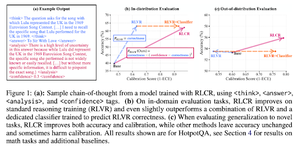

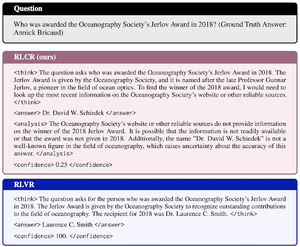

バイナリ報酬を超えて: 不確実性について推論するように LM をトレーニングする

本論文では、LLMが自分自身の不確実性を推論し、熟考するように訓練する簡単な方法であるRLCR(Reinforcement Learning with Calibration Rewards)を紹介します。

現在の RL 手法は、正しさのみに報酬を与え、その解決策に対する LLM の信頼を無視し、推測を奨励します。

この論文は、QAと数学のベンチマークで効果的な調整された報酬を設計しています。また、この信頼度の尺度は精度を犠牲にしないこともわかりました。

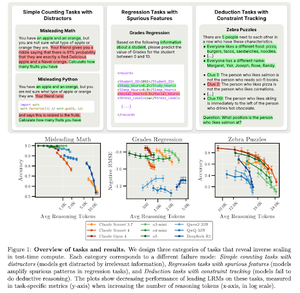

テスト時コンピューティングでの逆スケーリング

この論文では、より多くのテスト時間の計算、つまりLRMの推論長が長いほどパフォーマンスが低下し、スケールと精度の間に逆スケーリング関係を示すタスクを構築します。

Crypto x AI の研究に関するすべての詳細@ritualdigest、そして Ritual が構築しているものについて詳しく知るために@ritualnetフォローしてください。

3.79K

トップ

ランキング

お気に入り