Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Iată Ritual Research Digest din această săptămână, un buletin informativ care acoperă cele mai recente noutăți din lumea LLM-urilor și intersecția dintre Crypto x AI.

Cu sute de lucrări publicate săptămânal, este imposibil să rămânem la curent cu cele mai recente. Noi vom face cititul, astfel încât să nu trebuiască să o faceți.

Rubricile ca recompensă: învățarea prin întărire dincolo de domeniile verificabile

În această lucrare, ei introduc rubricile ca recompense (RaR), o metodă RL care folosește rubricile de listă pentru a supraveghea sarcinile care au mai multe criterii.

Acest lucru permite un antrenament stabil și performanțe îmbunătățite atât în domeniul raționamentului, cât și în cel din lumea reală. Ei arată că, atunci când este utilizat pentru domeniile medicinei și științei, acest stil de recompense ajută la obținerea unei mai bune alinieri umane.

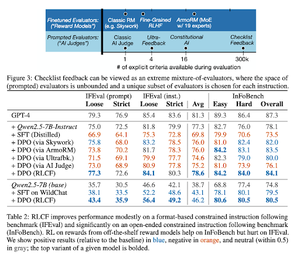

Listele de verificare sunt mai bune decât modelele de recompensă pentru alinierea modelelor lingvistice

În această lucrare, ei introduc Reinforcement Learning from Checklist Feedback (RLCF) pentru a extrage liste de verificare dinamice din instrucțiuni pentru a evalua pe liste flexibile de criterii distincte.

Ei introduc un set de date, WildChecklists, care cuprinde 130.000 de instrucțiuni și liste de verificare (generate sintetic). Metoda lor reduce problema notării răspunsurilor la răspunsul la întrebări specifice da/nu, la care răspunde un judecător AI sau prin executarea unui program de verificare.

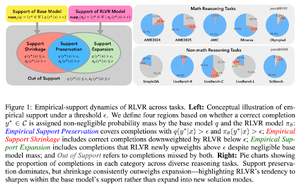

Lesa invizibilă: de ce RLVR ar putea să nu scape de originea sa

Această lucrare încearcă să ofere un cadru teoretic pentru întrebarea: "RLVR extinde capacitățile de raționament sau doar amplifică ceea ce modelele știu deja?"

Ei consideră că RLVR: nu ajută modelul să exploreze posibilități complet noi.

Îmbunătățește pass@1, adică îi permite să răspundă mai bine în mai puține încercări.

Reduce diversitatea răspunsurilor.

Tl; dr, RLVR îmbunătățește precizia, dar adesea nu reușește să descopere noi căi de raționament.

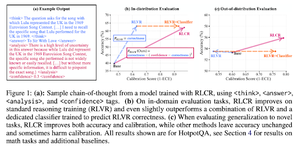

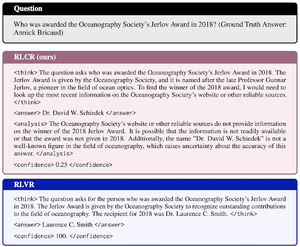

Dincolo de recompensele binare: antrenarea LM-urilor să raționeze despre incertitudinea lor

Această lucrare introduce RLCR (Reinforcement Learning with Calibration Rewards), o metodă simplă care antrenează LLM-urile să raționeze și să reflecteze asupra propriei incertitudini.

Metodele actuale RL recompensează doar corectitudinea, ignorând încrederea LLM în soluția sa, stimulând ghicirea.

Lucrarea proiectează o recompensă calibrată care este eficientă pe benchmark-urile QA și matematică. De asemenea, ei constată că această măsură de încredere nu are niciun cost pentru acuratețe.

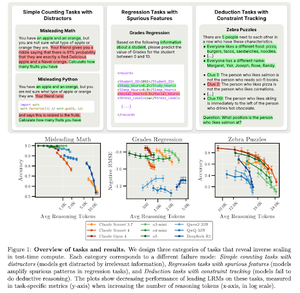

Scalarea inversă în calculul în timpul testului

Această lucrare construiește sarcini în care utilizarea mai multor timpi de testare, adică lungimi mai mari de raționament în LRM-uri, are ca rezultat performanțe mai slabe, prezentând o relație de scalare inversă între mai multă scară și precizie.

Urmăriți-ne @ritualdigest pentru mai multe despre toate lucrurile legate de cercetarea Crypto x AI și @ritualnet pentru a afla mai multe despre ceea ce construiește Ritual.

3,81K

Limită superioară

Clasament

Favorite