Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Đây là bản Tóm tắt Nghiên cứu Ritual của tuần này, một bản tin bao quát những điều mới nhất trong thế giới LLM và giao thoa giữa Crypto x AI.

Với hàng trăm tài liệu được công bố hàng tuần, việc cập nhật những điều mới nhất là điều không thể. Chúng tôi sẽ làm việc đọc, để bạn không phải.

Rubrics như Phần thưởng: Học Tăng cường Vượt ra ngoài Các miền Có thể Xác minh

Trong bài báo này, họ giới thiệu Rubrics như Phần thưởng (RaR), một phương pháp RL sử dụng rubrics danh sách để giám sát các nhiệm vụ có nhiều tiêu chí.

Điều này cho phép đào tạo ổn định và cải thiện hiệu suất trong cả lĩnh vực lý luận và thực tế. Họ chỉ ra rằng khi được sử dụng cho các lĩnh vực y học và khoa học, kiểu phần thưởng này giúp đạt được sự đồng bộ tốt hơn với con người.

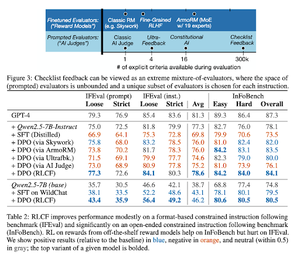

Danh sách kiểm tra tốt hơn mô hình thưởng để điều chỉnh các mô hình ngôn ngữ

Trong bài báo này, họ giới thiệu Học Tăng Cường từ Phản Hồi Danh Sách Kiểm Tra (RLCF) để trích xuất các danh sách kiểm tra động từ các hướng dẫn nhằm đánh giá trên các danh sách linh hoạt của các tiêu chí khác nhau.

Họ giới thiệu một tập dữ liệu, WildChecklists, bao gồm 130.000 hướng dẫn và danh sách kiểm tra (được tạo ra một cách tổng hợp). Phương pháp của họ giảm thiểu vấn đề chấm điểm các phản hồi thành việc trả lời các câu hỏi có/không cụ thể, được trả lời bởi một thẩm phán AI hoặc bằng cách thực hiện một chương trình xác minh.

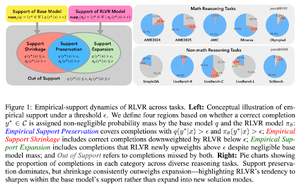

Dây Chuyền Vô Hình: Tại Sao RLVR Có Thể Không Thoát Khỏi Nguồn Gốc Của Nó

Bài báo này cố gắng cung cấp một khung lý thuyết cho câu hỏi: "Liệu RLVR có mở rộng khả năng lý luận hay chỉ khuếch đại những gì các mô hình đã biết?"

Họ nhận thấy rằng RLVR: không giúp mô hình khám phá những khả năng hoàn toàn mới.

Cải thiện pass@1, tức là cho phép nó trả lời tốt hơn trong ít lần thử hơn.

Nó giảm sự đa dạng của câu trả lời.

tóm lại, RLVR cải thiện độ chính xác, nhưng thường không phát hiện ra những con đường lý luận mới.

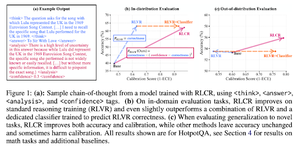

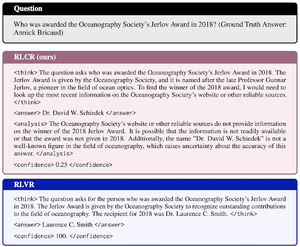

Phần thưởng vượt ra ngoài nhị phân: Đào tạo các mô hình ngôn ngữ để lý luận về sự không chắc chắn của chúng

Bài báo này giới thiệu RLCR (Học Tăng cường với Phần thưởng Hiệu chỉnh), một phương pháp đơn giản đào tạo các mô hình ngôn ngữ lớn (LLMs) để lý luận và phản ánh về sự không chắc chắn của chính chúng.

Các phương pháp RL hiện tại chỉ thưởng cho độ chính xác, bỏ qua sự tự tin của LLM trong giải pháp của nó, khuyến khích việc đoán.

Bài báo thiết kế một phần thưởng được hiệu chỉnh có hiệu quả trên các tiêu chuẩn QA và toán học. Họ cũng phát hiện rằng biện pháp tự tin này không làm giảm độ chính xác.

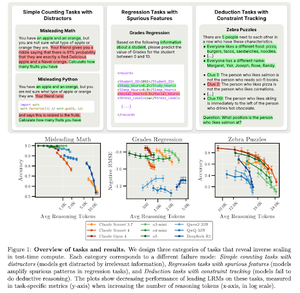

Tỉ lệ nghịch trong Tính toán Thời gian Kiểm tra

Bài báo này xây dựng các nhiệm vụ mà việc sử dụng nhiều tính toán thời gian kiểm tra, tức là độ dài lý luận dài hơn trong LRM, dẫn đến hiệu suất kém hơn, thể hiện mối quan hệ tỉ lệ nghịch giữa quy mô lớn hơn và độ chính xác.

Theo dõi chúng tôi @ritualdigest để biết thêm về tất cả các nghiên cứu liên quan đến Crypto x AI, và @ritualnet để tìm hiểu thêm về những gì Ritual đang xây dựng.

3,76K

Hàng đầu

Thứ hạng

Yêu thích