Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Digest do Ritual Research desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção entre Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com o que há de mais recente. Nós faremos a leitura, para que você não precise.

Rubricas como Recompensas: Aprendizagem por Reforço Além de Domínios Verificáveis

Neste artigo, eles introduzem Rubricas como Recompensas (RaR), um método de Aprendizagem por Reforço que utiliza rubricas de lista para supervisionar tarefas que têm múltiplos critérios.

Isto permite um treino estável e um desempenho melhorado tanto em raciocínio como em domínios do mundo real. Eles mostram que, quando utilizado nos domínios da medicina e da ciência, este estilo de recompensas ajuda a alcançar uma melhor alinhamento humano.

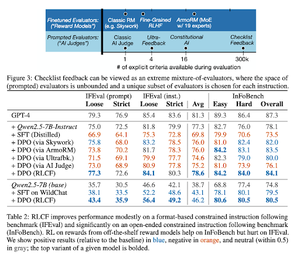

Listas de Verificação São Melhores do Que Modelos de Recompensa Para Alinhar Modelos de Linguagem

Neste artigo, eles introduzem o Aprendizado por Reforço a partir de Feedback de Listas de Verificação (RLCF) para extrair listas de verificação dinâmicas a partir de instruções para avaliar em listas flexíveis de critérios distintos.

Eles introduzem um conjunto de dados, WildChecklists, que compreende 130.000 instruções e listas de verificação (geradas sinteticamente). O método deles reduz o problema de avaliar respostas a responder a perguntas específicas de sim/não, respondidas por um juiz de IA ou pela execução de um programa de verificação.

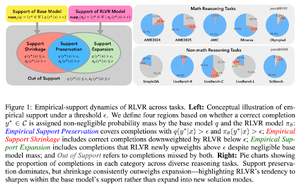

A Coleira Invisível: Por que o RLVR pode não escapar à sua origem

Este artigo tenta fornecer uma estrutura teórica para a questão: "O RLVR expande as capacidades de raciocínio ou apenas amplifica o que os modelos já sabem?"

Eles descobrem que o RLVR: não ajuda o modelo a explorar possibilidades totalmente novas.

Melhora o pass@1, ou seja, permite que ele responda melhor em menos tentativas.

Reduz a diversidade de respostas.

Resumindo, o RLVR melhora a precisão, mas muitas vezes falha em descobrir novos caminhos de raciocínio.

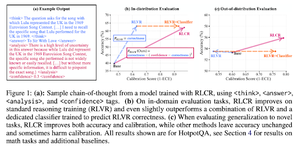

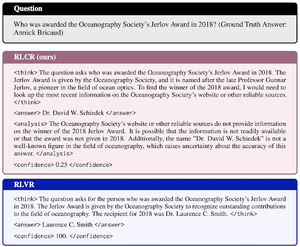

Recompensas Além do Binário: Treinando LMs para Raciocinar Sobre Sua Incerteza

Este artigo introduz o RLCR (Aprendizado por Reforço com Recompensas de Calibração), um método simples que treina LLMs para raciocinar e refletir sobre sua própria incerteza.

Os métodos RL atuais recompensam apenas a correção, ignorando a confiança do LLM na sua solução, incentivando a adivinhação.

O artigo projeta uma recompensa calibrada que é eficaz em benchmarks de QA e matemática. Eles também descobrem que essa medida de confiança não tem custo para a precisão.

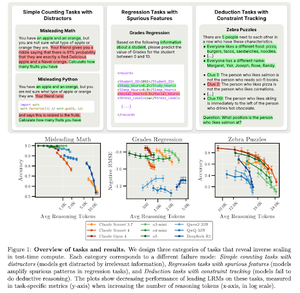

Escalonamento Inverso em Cálculo de Tempo de Teste

Este artigo constrói tarefas onde o uso de mais cálculo de tempo de teste, ou seja, comprimentos de raciocínio mais longos em LRMs, resulta em pior desempenho, exibindo uma relação de escalonamento inverso entre mais escala e precisão.

Siga-nos @ritualdigest para mais informações sobre tudo relacionado à pesquisa em Crypto x AI, e @ritualnet para saber mais sobre o que a Ritual está construindo.

3,8K

Top

Classificação

Favoritos