Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Voici le Digest de Recherche Rituel de cette semaine, une newsletter couvrant les dernières nouvelles dans le monde des LLM et l'intersection entre Crypto et IA.

Avec des centaines d'articles publiés chaque semaine, il est impossible de rester à jour avec les dernières informations. Nous ferons la lecture, pour que vous n'ayez pas à le faire.

Rubriques comme Récompenses : Apprentissage par Renforcement au-delà des Domaines Vérifiables

Dans cet article, ils introduisent les Rubriques comme Récompenses (RaR), une méthode d'apprentissage par renforcement qui utilise des rubriques de liste pour superviser des tâches ayant plusieurs critères.

Cela permet un entraînement stable et une performance améliorée tant dans les domaines du raisonnement que dans ceux du monde réel. Ils montrent que lorsqu'il est utilisé dans les domaines de la médecine et de la science, ce style de récompenses aide à atteindre une meilleure alignement humain.

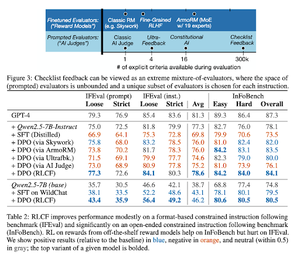

Les listes de contrôle sont meilleures que les modèles de récompense pour aligner les modèles de langage

Dans cet article, ils introduisent l'apprentissage par renforcement à partir des retours de listes de contrôle (RLCF) pour extraire des listes de contrôle dynamiques à partir d'instructions afin d'évaluer sur des listes flexibles de critères distincts.

Ils introduisent un ensemble de données, WildChecklists, comprenant 130 000 instructions et listes de contrôle (générées de manière synthétique). Leur méthode réduit le problème de l'évaluation des réponses à la réponse à des questions spécifiques par oui/non, répondues par un juge IA ou en exécutant un programme de vérification.

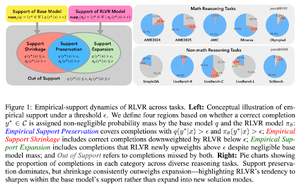

La laisse invisible : Pourquoi RLVR pourrait ne pas échapper à son origine

Cet article tente de fournir un cadre théorique pour la question : « RLVR élargit-il les capacités de raisonnement ou ne fait-il qu'amplifier ce que les modèles savent déjà ? »

Ils constatent que RLVR : n'aide pas le modèle à explorer des possibilités entièrement nouvelles.

Améliore le pass@1, c'est-à-dire lui permet de répondre mieux en moins d'essais.

Cela réduit la diversité des réponses.

En résumé, RLVR améliore la précision, mais échoue souvent à découvrir de nouveaux chemins de raisonnement.

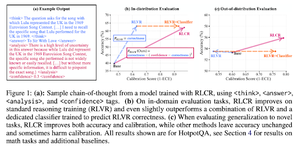

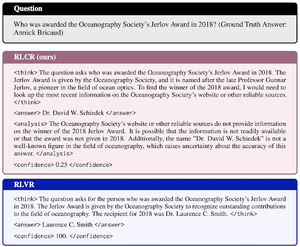

Au-delà des récompenses binaires : Former des LMs à raisonner sur leur incertitude

Cet article présente RLCR (Apprentissage par renforcement avec récompenses de calibration), une méthode simple qui forme les LLM à raisonner et à réfléchir sur leur propre incertitude.

Les méthodes RL actuelles ne récompensent que la justesse, ignorant la confiance du LLM dans sa solution, ce qui incite à deviner.

Le document conçoit une récompense calibrée qui est efficace sur les benchmarks de QA et de mathématiques. Ils constatent également que cette mesure de confiance n'entraîne aucun coût pour la précision.

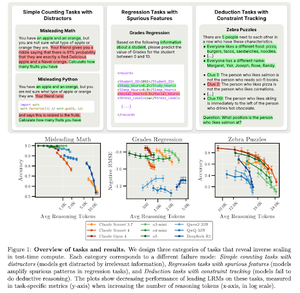

L'échelle inverse dans le calcul au moment du test

Cet article construit des tâches où l'utilisation de plus de calcul au moment du test, c'est-à-dire des longueurs de raisonnement plus longues dans les LRM, entraîne une performance pire, exhibant une relation d'échelle inverse entre plus d'échelle et la précision.

Suivez-nous @ritualdigest pour en savoir plus sur tout ce qui concerne la recherche Crypto x IA, et @ritualnet pour en apprendre davantage sur ce que Ritual est en train de construire.

3,8K

Meilleurs

Classement

Favoris