Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🔥 Lo veo claramente: el futuro será exactamente así:

Todo el software será absolutamente líquido y funcionará directamente en LLMs. El software será una mercancía, como la electricidad.

Ver esto con antelación puede darte una gran oportunidad 🤑 Estaré allí para aprovecharla.

La idea en detalle:

Hace 7 horas

"El software será una mercancía, como la electricidad, y funcionará directamente en la capa LLM."

¿Qué significa eso? Lo desglosaré en detalle (viene un post largo 🍿) y una vez que termines, no habrá término medio. O rechazarás la idea por completo (y estarás equivocado) o saldrás convertido y te daré la bienvenida a mi culto 😂

El post de ayer, donde dije que puedo ver esto venir muy claramente en un futuro cercano, generó mucho revuelo y preguntas. Así que voy a desarrollar la idea que he estado compartiendo aquí (y con cualquiera que no se aburra de mí fuera de X, estoy cansado de mí mismo en este punto) durante más de un año. Vamos a ello.

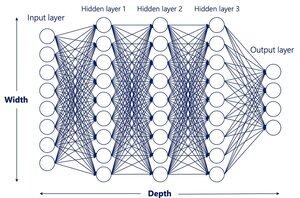

1. 'Todo el software funcionará en la capa LLM'

Primero, lo obvio.

Incluso hoy hay personas que, increíblemente, todavía niegan que nos dirigimos hacia un mundo donde todo el software (frontend, backend, infraestructura, etc.) se crea con lenguaje natural simple.

En realidad, ya estamos prácticamente allí con LLMs como Claude, Grok o ChatGPT y herramientas como Cursor, Windsurf o Lovable. Cualquier desarrollador decente que conozco ya no escribe una sola línea de código. Hablan en lenguaje natural y dirigen enjambres de agentes para construir toda la aplicación, luego solo la revisan (y discuten y suplican 🤣) para que la IA entregue su visión.

Esa parte es trivial. Si no estás allí todavía, es porque no quieres estarlo.

El siguiente salto es mucho más grande, y es donde incluso las personas profundamente inmersas en la IA me miran con escepticismo.

No necesitaremos esa capa tampoco. Sin Python, sin HTML, sin C++, sin CSS, nada.

Todo (toda la capa de software, la lógica, la persistencia o memoria (llámalo base de datos si quieres, pero será mucho más que eso), funcionará 'directamente' dentro del LLM.

Elon Musk lo resumió en una línea que pasará a la historia: "Cualquier flujo de bits de entrada a cualquier flujo de bits de salida."

Si conoces tecnología, probablemente no necesites más. Ya lo entiendes. Solo por si acaso, aquí hay un ejemplo rápido.

Hoy, si queremos construir un escalador como Magnific, necesitamos:

- Lógica de backend, el código que se ejecuta en el servidor (en nuestro caso, Python)

- Una base de datos (Firebase, Postgres, Supabase, MySQL, etc.)

- La capa frontend, lo que ve el usuario: HTML, CSS, JavaScript

- La capa de infraestructura: GPUs en la nube donde ocurre la magia y donde llamamos flujos de trabajo a través de APIs

¡Qué circo!

Y claro, puedes construir esto con Cursor + Claude ya. Pero los lenguajes de programación fueron diseñados para humanos. Las futuras IA no los necesitarán. Son redundantes. Un parámetro que deberíamos eliminar. Una ineficiencia.

¿De verdad crees que todo esto es necesario? ¿De verdad crees que seguiremos haciendo las cosas así en 20 años?

No. Un futuro LLM, uno que es difícil de imaginar hoy pero que veremos antes de lo que piensas, podría tomar una captura de pantalla del Magnific de hoy y, con solo esa imagen y un clic o arrastre del mouse, inferir lo que necesita hacer a continuación.

INFERIR LO QUE NECESITA HACER A CONTINUACIÓN.

Y no me refiero a que secretamente construya un frontend, backend y base de datos por debajo (eso es medieval). Quiero decir que literalmente generará el siguiente marco visual para mostrar al usuario. Eso podría ser la misma captura de pantalla con el control deslizante movido 1 píxel a la derecha y la imagen mostrada con un escalado ligeramente más detallado.

Así de simple.

'Pero... pero... pero... Javi... ¿dónde ocurre la lógica? ¿Dónde está el programa haciendo eso?'

¡Directamente dentro del LLM! De la misma manera que los modelos de hoy pueden tomar una imagen y generar un video completo con física decente, entenderán lo que actualmente llamamos la 'lógica de negocio' de cualquier aplicación, sin importar cuán compleja sea.

"Cualquier flujo de bits de entrada a cualquier flujo de bits de salida."

Lógica que emerge del modelo mismo, no de código hecho a mano.

Ahora probablemente lo has entendido. Si no, tómate un minuto para masticar la idea antes de pasar al siguiente punto, no dejes que se te atragante.

2. 'El software será una mercancía, como la electricidad'

Y no solo el software. Todo el entretenimiento digital también (películas, videojuegos, etc.). En tiempo real.

La mayor parte del valor tecnológico digital se concentrará en muy pocas empresas. Las que ganen la carrera de LLM multimodal y las que proporcionen la infraestructura en la que funcionan. Imagina un mundo donde decir 'Quiero un SaaS que haga esto' o 'hazme una película en este estilo con mi perro como protagonista' te dé un resultado instantáneo de un LLM con una calidad muy por encima de las mejores producciones de hoy.

Básicamente creo que toda la lógica y las capas visuales funcionarán en LLMs ultra-avanzados que apenas podemos imaginar hoy. No tendrá sentido construir aplicaciones, sitios o entretenimiento de la manera en que lo hacemos ahora. La capacidad de hacerlo se concentrará en empresas con los mejores LLMs y la computación para ejecutarlos a gran escala.

Elegiremos proveedores de IA principalmente por precio y mucho menos por características o capacidad. Piensa en las compañías eléctricas de hoy, o en PS vs Xbox si bloquean algunas IPs interesantes.

3. 'Pero Javi, no son deterministas y no tienen memoria. Nunca construirán aplicaciones decentes así'

Llamarlo imposible es tener una visión a corto plazo. Por supuesto que tendrán persistencia y memoria. Simplemente no de la manera simplista 'como una base de datos' que usamos hoy.

4. 'Ok, pero ¿cómo construirías un LLM así?'

Con cuidado 😂

Principalmente con datos sintéticos. Aquí hay una idea obvia que sigue siendo bastante revolucionaria.

Dado que los LLMs y los agentes están cerca de generar aplicaciones de extremo a extremo (backend y frontend), podemos instrumentarlos para construir en un bucle cerrado, con objetivos explícitos y funciones de recompensa, registrando estados de UI e inputs. Esas trayectorias pueden alimentar el entrenamiento para futuros modelos base.

Si puedo pensar en esto con mi conocimiento limitado (incluso si ninguna gran empresa ha dicho públicamente que lo están haciendo), puedo asumir que mentes mucho más brillantes ya están en ello.

5. 'Si esto resulta ser cierto, ¿cómo obtienes una ventaja sobre los no creyentes?'

Ya estás por delante si tienes razón sobre algo así. Por ahora, mi movimiento es posicionarme a través de inversiones, averiguando qué empresas concentrarán más poder al asegurar GPUs y la tecnología. Dejaré un enlace más adelante en el hilo, aunque puede ser a corto plazo y centrado en lo que existe hoy. Lo mejor que puedes hacer es seguir el juego día a día y mantenerte alerta.

¿Cómo va eso?

9,14K

Parte superior

Clasificación

Favoritos