Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🔥 Vejo claramente que o futuro será exatamente assim:

Todo o software será absolutamente líquido e executado diretamente em LLMs. O software será uma mercadoria, como a eletricidade.

Ver isso com antecedência pode lhe dar uma grande oportunidade 🤑, estarei lá para aproveitá-la.

A ideia em detalhes:

7 horas atrás

"O software será uma mercadoria, como a eletricidade, e será executado diretamente na camada LLM."

O que isso significa? Vou detalhar (post longo de entrada 🍿) e, quando você terminar, não haverá meio-termo. Ou você rejeitará a ideia completamente (e estará errado) ou sairá convertido e eu lhe darei as boas-vindas ao meu culto 😂

O post de ontem, onde eu disse que posso ver isso chegando muito claramente em um futuro próximo, provocou muito burburinho e perguntas. Então, vou dar corpo à ideia que tenho compartilhado aqui (e com quem não se cansa de mim fora de X, estou cansado de mim mesmo neste momento) há mais de um ano. Vamos ao que interessa.

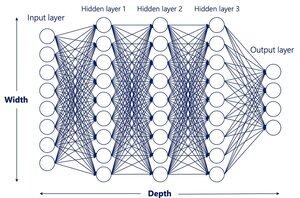

1. 'Todo o software será executado na camada LLM'

Primeiro, o óbvio.

Ainda hoje existem pessoas que, inacreditavelmente, ainda negam que estamos caminhando para um mundo onde todo software (frontend, backend, infra, etc.) é criado com linguagem natural simples.

Na realidade, basicamente já estamos lá com LLMs como Claude, Grok ou ChatGPT e ferramentas como Cursor, Windsurf ou Lovable. Qualquer desenvolvedor decente que conheço não escreve mais uma única linha de código. Eles falam em linguagem natural e direcionam enxames de agentes para construir todo o aplicativo, então eles apenas o revisam (e argumentam e imploram 🤣) para que a IA entregue sua visão.

Essa parte é trivial. Se você ainda não chegou lá, é porque não quer estar.

O próximo salto é muito maior e é onde até mesmo as pessoas profundas na IA me olham com ceticismo.

Também não precisaremos dessa camada. Sem Python, sem HTML, sem C++, sem CSS, nada.

Tudo (toda a camada de software, a lógica, a persistência ou memória (chame de banco de dados se quiser, mas será muito mais do que isso), será 'executado' diretamente dentro do LLM.

Elon Musk resumiu em uma linha que ficará na história: "Qualquer fluxo de bits de entrada para qualquer fluxo de bits de saída".

Se você conhece tecnologia, provavelmente não precisa de mais. Você já entendeu. Por precaução, aqui está um exemplo rápido.

Hoje, se quisermos construir um upscaler como o Magnific, precisamos:

- Lógica de back-end, o código em execução no servidor (no nosso caso, Python)

- Um banco de dados (Firebase, Postgres, Supabase, MySQL, etc.)

- A camada de front-end, o que o usuário vê: HTML, CSS, JavaScript

- A camada infra: GPUs em nuvem onde a mágica é executada e onde chamamos fluxos de trabalho por meio de APIs

Que circo!

E claro, você já pode construir isso com Cursor + Claude. Mas as linguagens de programação foram projetadas para humanos. As futuras IAs não precisarão deles. Eles são redundantes. Um parâmetro que devemos remover. Uma ineficiência.

Você realmente acha que tudo isso é necessário? Você realmente acha que ainda estaremos fazendo coisas assim em 20 anos?

Não. Um futuro LLM, difícil de imaginar hoje, mas que veremos mais cedo do que você pensa, poderia fazer uma captura de tela do Magnific de hoje e, com apenas essa imagem e um clique ou arrastar do mouse, inferir o que ele precisa fazer a seguir.

DEDUZIR O QUE ELE PRECISA FAZER A SEGUIR.

E não quero dizer que ele construirá secretamente um front-end, back-end e banco de dados sob o capô (isso é medieval). Quero dizer, ele literalmente gerará o próximo quadro visual para mostrar ao usuário. Essa pode ser a mesma captura de tela com o controle deslizante movido 1 pixel para a direita e a imagem exibida com um upscale um pouco mais detalhado.

Simples assim.

'Mas... mas... mas... Javi... Onde a lógica acontece? Onde o programa está fazendo isso?'

Diretamente dentro do LLM! Da mesma forma que os modelos de hoje podem tirar uma imagem e gerar um vídeo completo com física decente, eles entenderão o que atualmente chamamos de "lógica de negócios" de qualquer aplicativo, não importa o quão complexo seja.

"Qualquer fluxo de bits de entrada para qualquer fluxo de bits de saída."

Lógica emergindo do próprio modelo, não de código feito à mão.

Agora você provavelmente entendeu. Caso contrário, reserve um minuto para mastigar a ideia antes de passar para o próximo ponto, não deixe que ela fique presa na garganta.

2. 'O software será uma mercadoria, como a eletricidade'

E não apenas software. Todo o entretenimento digital também (filmes, videogames, etc.). Em tempo real.

A maior parte do valor da tecnologia digital se concentrará em muito poucas empresas. Aqueles que vencem a corrida multimodal do LLM e aqueles que fornecem a infraestrutura em que funcionam. Imagine um mundo onde dizer 'Eu quero um SaaS que faça isso' ou 'faça um filme neste estilo com meu cachorro como protagonista' obtém um resultado instantâneo de um LLM com uma qualidade muito acima das melhores produções de hoje.

Basicamente, acho que todas as camadas lógicas e visuais serão executadas em LLMs ultra-avançados que mal podemos imaginar hoje. Não fará sentido criar aplicativos, sites ou entretenimento da maneira que fazemos agora. A capacidade de fazer isso se concentrará em empresas com os melhores LLMs e na computação para executá-los em escala.

Escolheremos provedores de IA principalmente em preço e muito menos em recursos ou capacidade. Pense nas empresas de eletricidade hoje, ou PS vs Xbox, se elas bloquearem alguns IPs interessantes.

3. 'Mas Javi, eles não são deterministas e não têm memória. Eles nunca criarão aplicativos decentes como este'

Chamá-lo de impossível é míope. Claro que eles terão persistência e memória. Só não da maneira simplista 'como um banco de dados' que usamos hoje.

4. 'Ok, mas como você construiria um LLM assim?'

Cuidadosamente 😂

Principalmente com dados sintéticos. Aqui está uma ideia óbvia que ainda é bastante revolucionária.

Como os LLMs e agentes estão perto de gerar aplicativos de ponta a ponta (back-end e front-end), podemos instrumentá-los para criar um ciclo fechado, com objetivos explícitos e funções de recompensa, registrando estados e entradas da interface do usuário. Essas trajetórias podem alimentar o treinamento para futuros modelos de fundação.

Se eu puder pensar nisso com meu conhecimento limitado (mesmo que nenhuma grande empresa tenha dito publicamente que está fazendo isso), posso presumir que mentes muito mais brilhantes já estão nisso.

5. 'Se isso for verdade, como você consegue uma vantagem sobre os não-crentes?'

Você já está à frente se estiver certo sobre algo assim. Por enquanto, minha jogada é me posicionar por meio de investimentos, descobrindo quais empresas concentrarão a maior parte do poder bloqueando as GPUs e a tecnologia. Vou deixar um link mais tarde no tópico, embora possa ser míope e focado no que existe hoje. O melhor que você pode fazer é acompanhar o jogo dia a dia e ficar atento.

Como é esse pouso?

Qualquer dúvida, fico feliz em responder nos comentários.

9,14K

Melhores

Classificação

Favoritos