Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🔥 Je le vois clairement, l'avenir sera exactement comme ça :

Tous les logiciels seront absolument liquides et fonctionneront directement dans les LLMs. Le logiciel sera une marchandise, comme l'électricité.

Voir cela à l'avance peut vous donner une énorme opportunité 🤑 Je serai là pour en profiter.

L'idée en détail :

il y a 7 heures

"Le logiciel sera une marchandise, comme l'électricité, et il fonctionnera directement dans la couche LLM."

Que signifie cela ? Je vais l'expliquer en détail (long post à venir 🍿) et une fois que vous aurez terminé, il n'y aura pas de terrain d'entente. Vous rejetterez complètement l'idée (et vous aurez tort) ou vous sortirez en tant que converti et je vous accueillerai dans ma secte 😂

Le post d'hier, où j'ai dit que je peux voir cela venir très clairement dans un avenir proche, a suscité beaucoup de buzz et de questions. Donc, je vais développer l'idée que je partage ici (et avec quiconque ne s'ennuie pas de moi en dehors de X, j'en ai marre de moi-même à ce stade) depuis plus d'un an. Allons-y.

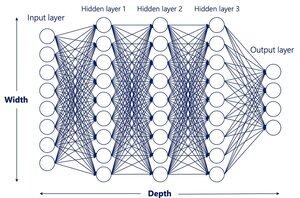

1. 'Tout le logiciel fonctionnera dans la couche LLM'

D'abord, l'évidence.

Même aujourd'hui, il y a des gens qui, incroyablement, nient encore que nous nous dirigeons vers un monde où tout le logiciel (frontend, backend, infra, etc.) est créé avec un langage naturel simple.

En réalité, nous y sommes déjà presque avec des LLM comme Claude, Grok ou ChatGPT et des outils comme Cursor, Windsurf ou Lovable. Tout bon développeur que je connais n'écrit plus une seule ligne de code. Ils parlent en langage naturel et dirigent des essaims d'agents pour construire toute l'application, puis ils la révisent juste (et argumentent et supplient 🤣) pour que l'IA livre leur vision.

Cette partie est triviale. Si vous n'y êtes pas encore, c'est parce que vous ne voulez pas l'être.

Le prochain saut est beaucoup plus grand, et c'est là que même les personnes profondément ancrées dans l'IA me regardent avec scepticisme.

Nous n'aurons pas besoin de cette couche non plus. Pas de Python, pas de HTML, pas de C++, pas de CSS, rien.

Tout (la couche logicielle entière, la logique, la persistance ou la mémoire (appelez cela une base de données si vous voulez, mais ce sera bien plus que cela), fonctionnera directement à l'intérieur du LLM.

Elon Musk l'a résumé en une phrase qui restera dans l'histoire : "Tout flux d'entrée à tout flux de sortie."

Si vous connaissez la technologie, vous n'avez probablement pas besoin de plus. Juste au cas où, voici un exemple rapide.

Aujourd'hui, si nous voulons construire un upscaler comme Magnific, nous avons besoin de :

- Logique backend, le code qui s'exécute sur le serveur (dans notre cas, Python)

- Une base de données (Firebase, Postgres, Supabase, MySQL, etc.)

- La couche frontend, ce que l'utilisateur voit : HTML, CSS, JavaScript

- La couche infra : GPU cloud où la magie opère et où nous appelons des workflows via des API

Quel cirque !

Et bien sûr, vous pouvez déjà construire cela avec Cursor + Claude. Mais les langages de programmation ont été conçus pour les humains. Les futures IA n'en auront pas besoin. Ils sont redondants. Un paramètre que nous devrions supprimer. Une inefficacité.

Pensez-vous vraiment que tout cela est nécessaire ? Pensez-vous vraiment que nous ferons encore des choses comme ça dans 20 ans ?

Non. Un futur LLM, un qui est difficile à imaginer aujourd'hui mais que nous verrons plus tôt que vous ne le pensez, pourrait prendre une capture d'écran de Magnific d'aujourd'hui et, avec juste cette image et un clic ou un glissement de souris, déduire ce qu'il doit faire ensuite.

DÉDUIRE CE QU'IL DOIT FAIRE ENSUITE.

Et je ne veux pas dire qu'il construira secrètement un frontend, un backend et une base de données en coulisses (c'est médiéval). Je veux dire qu'il générera littéralement le prochain cadre visuel à montrer à l'utilisateur. Cela pourrait être la même capture d'écran avec le curseur déplacé de 1 pixel vers la droite et l'image affichée avec un upscale légèrement plus détaillé.

Juste comme ça.

'Mais... mais... mais... Javi... où se passe la logique ? Où est le programme qui fait cela ?'

Directement à l'intérieur du LLM ! De la même manière que les modèles d'aujourd'hui peuvent prendre une image et générer une vidéo complète avec une physique décente, ils comprendront ce que nous appelons actuellement la 'logique métier' de toute application, peu importe sa complexité.

"Tout flux d'entrée à tout flux de sortie."

La logique émergeant du modèle lui-même, pas d'un code fait à la main.

Maintenant, vous l'avez probablement compris. Si ce n'est pas le cas, prenez une minute pour réfléchir à l'idée avant de passer au point suivant, ne laissez pas cela se coincer dans votre gorge.

2. 'Le logiciel sera une marchandise, comme l'électricité'

Et pas seulement le logiciel. Tout le divertissement numérique aussi (films, jeux vidéo, etc.). En temps réel.

La plupart de la valeur technologique numérique se concentrera dans très peu d'entreprises. Celles qui gagneront la course des LLM multimodaux et celles qui fourniront l'infrastructure sur laquelle ils fonctionnent. Imaginez un monde où dire 'Je veux un SaaS qui fait cela' ou 'fais-moi un film dans ce style avec mon chien comme vedette' vous donne un résultat instantané d'un LLM d'une qualité bien supérieure aux meilleures productions d'aujourd'hui.

Je pense essentiellement que toute la logique et les couches visuelles fonctionneront sur des LLM ultra-avancés que nous pouvons à peine imaginer aujourd'hui. Il n'aura pas de sens de construire des applications, des sites ou des divertissements de la manière dont nous le faisons maintenant. La capacité de le faire se concentrera dans des entreprises avec les meilleurs LLM et la puissance de calcul pour les faire fonctionner à grande échelle.

Nous choisirons les fournisseurs d'IA principalement en fonction du prix et beaucoup moins en fonction des fonctionnalités ou de la capacité. Pensez aux entreprises d'électricité aujourd'hui, ou à PS contre Xbox s'ils verrouillent des IP intéressantes.

3. 'Mais Javi, ils ne sont pas déterministes et ils n'ont pas de mémoire. Ils ne construiront jamais d'applications décentes comme ça'

Dire que c'est impossible est à courte vue. Bien sûr, ils auront de la persistance et de la mémoire. Juste pas de la manière simpliste 'comme une base de données' que nous utilisons aujourd'hui.

4. 'Ok, mais comment construiriez-vous même un LLM comme ça ?'

Avec soin 😂

Principalement avec des données synthétiques. Voici une idée évidente qui est encore assez révolutionnaire.

Puisque les LLM et les agents sont proches de la génération d'applications de bout en bout (backend et frontend), nous pouvons les instrumenter pour construire dans une boucle fermée, avec des objectifs explicites et des fonctions de récompense, en enregistrant les états et les entrées de l'interface utilisateur. Ces trajectoires peuvent alimenter l'entraînement pour de futurs modèles de base.

Si je peux penser à cela avec mes connaissances limitées (même si aucune grande entreprise n'a dit publiquement qu'elle le fait), je peux supposer que des esprits beaucoup plus brillants y travaillent déjà.

5. 'Si cela s'avère vrai, comment obtenir un avantage sur les non-croyants ?'

Vous êtes déjà en avance si vous avez raison sur quelque chose comme ça. Pour l'instant, ma stratégie est de me positionner à travers des investissements, en découvrant quelles entreprises concentreront le plus de pouvoir en verrouillant des GPU et la technologie. Je partagerai un lien plus tard dans le fil, même si cela peut être à courte vue et axé sur ce qui existe aujourd'hui. Le mieux que vous puissiez faire est de suivre le jeu jour après jour et de rester vigilant.

Comment cela se passe-t-il ?

Des questions, je suis heureux de répondre dans les commentaires.

9,14K

Meilleurs

Classement

Favoris