Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrew Ng

Medgrundare av Coursera; Stanford CS adjungerad fakultet. Tidigare chef för Baidu AI Group/Google Brain. #ai #machinelearning, #deeplearning #MOOCs

Jag är glad över att kunna presentera den definitiva kursen om Claude Code, skapad med @AnthropicAI och undervisad av Elie Schoppik @eschoppik. Om du vill använda mycket agentisk kodning - där AI arbetar autonomt i många minuter eller längre, inte bara för att slutföra kodavsnitt - är det här rätt.

Claude Code har varit en gamechanger för många utvecklare (inklusive mig!), men det finns ett verkligt djup i att använda det väl. Denna omfattande kurs täcker allt från grunder till avancerade mönster.

Efter denna korta kurs kommer du att kunna:

- Orkestrera flera Claude-subagenter för att arbeta på olika delar av din kodbas samtidigt

- Tagga Claude i GitHub-problem och låt den självständigt skapa, granska och sammanfoga pull-begäranden

- Omvandla röriga Jupyter Notebooks till rena, produktionsklara instrumentpaneler

- Använd MCP-verktyg som Playwright så att Claude kan se vad som är fel med ditt användargränssnitt och fixa det självständigt.

Oavsett om Claude Code är nytt för dig eller redan använder det kommer du att upptäcka kraftfulla funktioner som kan förändra hur du bygger programvara i grunden.

Jag är väldigt spänd på vad agentisk kodning låter alla nu göra. Gå gärna den här kursen!

679,41K

Vi presenterar en ny Coursera-kurs: Retrieval Augmented Generation (RAG)

Du kommer att lära dig att bygga högpresterande, produktionsklara RAG-system i denna praktiska, djupgående kurs skapad av och undervisad av @ZainHasan6, erfaren AI- och ML-ingenjör, forskare och utbildare.

RAG är en kritisk komponent idag i många LLM-baserade applikationer inom kundsupport, interna företagssystem för frågor och svar, till och med många av de ledande chatbotarna som använder webbsökning för att svara på dina frågor. I den här kursen lär du dig på djupet hur du får RAG att fungera bra.

LLM:er kan producera generiska eller föråldrade svar, särskilt när de ställs specialiserade frågor som inte tas upp i dess träningsdata. RAG är den mest använda tekniken för att ta itu med detta. Den tar in data från nya datakällor, såsom interna dokument eller senaste nyheter, för att ge LLM relevant sammanhang till privat, ny eller specialiserad information. Detta gör att den kan generera mer jordnära och korrekta svar.

I den här kursen lär du dig att designa och implementera varje del av ett RAG-system, från retrievers till vektordatabaser till generering till utvärderingar. Du kommer att lära dig om de grundläggande principerna bakom RAG och hur du optimerar den på både komponent- och systemnivå.

I takt med att AI utvecklas, utvecklas även RAG. Nya modeller kan hantera längre kontextfönster, resonera mer effektivt och kan vara delar av komplexa agentiska arbetsflöden. Ett spännande tillväxtområde är Agentic RAG, där en AI-agent vid körning (i stället för att den är hårdkodad vid utvecklingstillfället) autonomt bestämmer vilken data som ska hämtas och när/hur den ska gå djupare. Även med denna utveckling är det viktigt att ha tillgång till data av hög kvalitet vid körning, vilket är anledningen till att RAG är en viktig del av så många applikationer.

Du kommer att lära dig via praktiska erfarenheter att:

- Bygga ett RAG-system med hämtning och snabb förstärkning

- Jämför hämtningsmetoder som BM25, semantisk sökning och Reciprocal Rank Fusion

- Segmentera, indexera och hämta dokument med hjälp av en Weaviate-vektordatabas och en nyhetsdatauppsättning

- Utveckla en chattrobot, med hjälp av LLM:er med öppen källkod som drivs av Together AI, för en fiktiv butik som svarar på produkt- och FAQ-frågor

- Använd evals för att förbättra tillförlitligheten och införliva multimodala data

RAG är en viktig grundläggande teknik. Bli bra på det genom den här kursen!

Anmäl dig här:

107,02K

Mitt föredrag på YC Startup School om hur man bygger AI-startups. Jag delar med mig av tips från @AI_Fund om hur du kan använda AI för att bygga snabbt. Låt mig veta vad du tycker!

Y Combinator10 juli 2025

Andrew Ng (@AndrewYNg) om hur startups kan bygga snabbare med AI.

På AI Startup School i San Francisco.

00:31 - Vikten av hastighet i nystartade företag

01:13 – Möjligheter i AI-stacken

02:06 – Framväxten av Agent AI

04:52 - Konkreta idéer för snabbare genomförande

08:56 - Snabb prototypframställning och teknik

17:06 - Produktledningens roll

21:23 – Värdet av att förstå AI

22:33 – Tekniska beslut inom AI-utveckling

23:26 – Utnyttja Gen AI-verktyg för nystartade företag

24:05 – Skapa med AI-byggstenar

25:26 - Vikten av snabbhet i nystartade företag

26:41 – Ta itu med AI-hype och missuppfattningar

37:35 - AI i utbildningen: Aktuella trender och framtida riktningar

39:33 – Balansera AI-innovation med etiska överväganden

41:27 – Skydda öppen källkod och framtiden för AI

146,48K

Agentic Document Extraction har nu stöd för fältextrahering! Många användningsfall för extrahering av dokument extraherar specifika fält från formulär och andra strukturerade dokument. Du kan nu mata in en bild eller PDF av en faktura, begära leverantörens namn, artikellista och priser och få tillbaka de extraherade fälten. Eller ange ett medicinskt formulär och ange ett schema för att extrahera patientnamn, patient-ID, försäkringsnummer etc.

En cool funktion: Om du inte känner för att skriva ett schema (json-specifikation av vilka fält som ska extraheras) själv, ladda upp ett exempeldokument och skriv en uppmaning på naturligt språk som säger vad du vill ha, så genererar vi automatiskt ett schema åt dig.

Se videon för mer information!

178,27K

Ny kurs: Efterutbildning av LLM

Lär dig att efterträna och anpassa en LLM i denna korta kurs, undervisad av @BanghuaZ, biträdande professor vid University of Washington @UW, och medgrundare av @NexusflowX.

Att träna en LLM för att följa instruktioner eller svara på frågor har två nyckelsteg: förträning och efterträning. Under förträningen lär den sig att förutsäga nästa ord eller token från stora mängder omärkt text. Efter träningen lär den sig användbara beteenden som att följa instruktioner, använda verktyg och resonera.

Efter träningen omvandlas en allmän tokenprediktor – som tränats på biljoner omärkta texttoken – till en assistent som följer instruktioner och utför specifika uppgifter. Eftersom det är mycket billigare än förträning är det praktiskt för många fler team att införliva efterträningsmetoder i sina arbetsflöden än förträning.

I den här kursen får du lära dig tre vanliga metoder efter träningen – Supervised Fine-Tuning (SFT), Direct Preference Optimization (DPO) och Online Reinforcement Learning (RL) – och hur du använder var och en av dem på ett effektivt sätt. Med SFT tränar du modellen på par av indata- och ideala utdatasvar. Med DPO anger du både ett önskat (valt) och ett mindre önskat (avvisat) svar och tränar modellen att prioritera önskade utdata. Med RL genererar modellen utdata, får en belöningspoäng baserat på mänsklig eller automatiserad feedback och uppdaterar modellen för att förbättra prestandan.

Du kommer att lära dig de grundläggande begreppen, vanliga användningsfall och principer för att kurera data av hög kvalitet för effektiv träning. Genom praktiska labbövningar laddar du ner en förtränad modell från Hugging Face och eftertränar den med hjälp av SFT, DPO och RL för att se hur varje teknik formar modellens beteende.

I detalj kommer du att:

- Förstå vad efterträning är, när man ska använda det och hur det skiljer sig från förträning.

- Bygg en SFT-pipeline för att omvandla en basmodell till en instruktionsmodell.

- Utforska hur DPO omformar beteenden genom att minimera kontrastiv förlust – straffa dåliga svar och förstärka föredragna svar.

- Implementera en DPO-pipeline för att ändra identiteten för en chattassistent.

- Lär dig RL-metoder online, t.ex. Proximal Policy Optimization (PPO) och GRPO (Group Relative Policy Optimization), och hur du utformar belöningsfunktioner.

- Träna en modell med GRPO för att förbättra dess matematiska färdigheter med hjälp av en verifierbar belöning.

Efterutbildning är ett av de snabbast utvecklande områdena för LLM-utbildning. Oavsett om du bygger en kontextspecifik assistent med hög noggrannhet, finjusterar en modells ton eller förbättrar uppgiftsspecifik noggrannhet, kommer den här kursen att ge dig erfarenhet av de viktigaste teknikerna som formar hur LLM:er eftertränas idag.

Anmäl dig här:

109,52K

Jag skulle vilja dela med mig av ett tips för att få mer övning i att bygga med AI – det vill säga att antingen använda AI-byggstenar för att bygga applikationer eller använda AI-kodningshjälp för att snabbt skapa kraftfulla applikationer: Om du bara har begränsad tid att bygga, minska projektets omfattning tills du kan bygga något på den tid du har.

Om du bara har en timme på dig kan du hitta en liten del av en idé som du är entusiastisk över och som du kan bygga på en timme. Med moderna kodningsassistenter som Anthropics Claude Code (mitt favoritutvecklingsverktyg just nu) kan du bli förvånad över hur mycket du kan göra även under korta perioder! Detta får dig att komma igång, och du kan alltid fortsätta projektet senare.

För att bli bra på att bygga med AI måste de flesta människor (i) lära sig relevanta tekniker, till exempel genom att ta AI-kurser online, och (ii) öva på att bygga. Jag känner utvecklare som kippar på idéer i månader utan att faktiskt bygga något – jag har också gjort det här! — För att vi känner att vi inte har tid att komma igång. Om du befinner dig i den här situationen uppmuntrar jag dig att fortsätta skära ner på det ursprungliga projektets omfattning tills du identifierar en liten komponent som du kan bygga direkt.

Låt mig illustrera med ett exempel – ett av mina många små, roliga helgprojekt som kanske aldrig kommer att leda någonstans, men som jag är glad att jag gjorde.

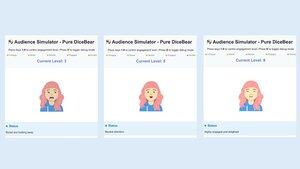

Här är idén: Många människor är rädda för att tala inför publik. Och att tala inför publik är utmanande att öva på, eftersom det är svårt att organisera en publik. Så jag tänkte att det skulle vara intressant att bygga en publiksimulator för att ge en digital publik på dussintals till hundratals virtuella personer på en datorskärm och låta en användare öva genom att prata till dem.

En lördagseftermiddag befann jag mig på ett kafé med ett par timmar till godo och bestämde mig för att ge publiksimulatorn en chans. Min förtrogenhet med grafikkodning är begränsad, så istället för att bygga en komplex simulator för en stor publik och skriva AI-programvara för att simulera lämpliga publiksvar, bestämde jag mig för att minska omfattningen avsevärt för att (a) simulera en publik på en person (som jag senare kunde replikera för att simulera N personer), (b) utelämna AI och låta en mänsklig operatör manuellt välja reaktionen hos den simulerade publiken (liknande Wizard of Oz-prototyper), och (c) implementera grafiken med hjälp av en enkel 2D-avatar.

Med hjälp av en blandning av flera kodningsassistenter byggde jag en grundläggande version på den tid jag hade till mitt förfogande. Avataren kunde röra sig subtilt och blinka, men annars använde den grundläggande grafik. Även om det inte var en sofistikerad publiksimulator är jag glad att jag byggde den här. Förutom att föra projektet framåt och låta mig utforska olika design, förbättrade det mina kunskaper om grundläggande grafik. Att ha den här grova prototypen att visa för vänner hjälpte mig dessutom att få feedback från användarna som formade mina åsikter om produktidén.

Jag har på min bärbara dator en lista med idéer på saker som jag tror skulle vara intressanta att bygga. De flesta av dem skulle ta mycket längre tid än den handfull timmar jag kanske har för att prova något en viss dag, men genom att minska deras omfattning kan jag komma igång, och de inledande framstegen i ett projekt hjälper mig att avgöra om det är värt ytterligare investeringar. Som en bonus hjälper hacking på en mängd olika applikationer mig att öva på ett brett spektrum av färdigheter. Men viktigast av allt, detta får en idé ur mitt huvud och potentiellt framför potentiella användare för feedback som gör att projektet går snabbare.

[Ursprunglig text: ]

295,51K

Ny kurs: ACP: Agent Communication Protocol

Lär dig att bygga agenter som kommunicerar och samarbetar över olika ramverk med hjälp av ACP i denna korta kurs byggd med @IBMResearch:s BeeAI och undervisad av @sandi_besen, AI Research Engineer & Ecosystem Lead på IBM, och @nicholasrenotte, Head of AI Developer Advocacy på IBM.

Det kan bli en utmaning att bygga ett system med flera agenter med agenter som byggs eller används av olika team och organisationer. Du kan behöva skriva anpassade integreringar varje gång ett team uppdaterar sin agentdesign eller ändrar sitt val av agentorkestreringsramverk.

Agent Communication Protocol (ACP) är ett öppet protokoll som tar itu med denna utmaning genom att standardisera hur agenter kommunicerar med hjälp av ett enhetligt RESTful-gränssnitt som fungerar över ramverk. I det här protokollet är du värd för en agent inuti en ACP-server, som hanterar förfrågningar från en ACP-klient och skickar dem till lämplig agent. Genom att använda ett standardiserat klient-server-gränssnitt kan flera team återanvända agenter i olika projekt. Det gör det också enklare att växla mellan ramverk, ersätta en agent med en ny version eller uppdatera ett system med flera agenter utan att omstrukturera hela systemet.

I den här kursen lär du dig att ansluta agenter via ACP. Du kommer att förstå livscykeln för en ACP-agent och hur den kan jämföras med andra protokoll, till exempel MCP (Model Context Protocol) och A2A (Agent-to-Agent). Du kommer att bygga ACP-kompatibla agenter och implementera både sekventiella och hierarkiska arbetsflöden för flera agenter som samarbetar med hjälp av ACP.

Genom praktiska övningar kommer du att bygga:

- En RAG-agent med CrewAI och slå in den i en ACP-server.

- En AVS-klient för att göra anrop till den AVS-server som du skapade.

- Ett sekventiellt arbetsflöde som länkar en ACP-server, skapad med Smolagents, till RAG-agenten.

- Ett hierarkiskt arbetsflöde med hjälp av en routeragent som omvandlar användarfrågor till uppgifter, delegerade till agenter som är tillgängliga via ACP-servrar.

- En agent som använder MCP för att komma åt verktyg och ACP för att kommunicera med andra agenter.

Du avslutar med att importera dina ACP-agenter till BeeAI-plattformen, ett register med öppen källkod för att upptäcka och dela agenter.

ACP möjliggör samarbete mellan agenter i team och organisationer. I slutet av den här kursen kommer du att kunna bygga ACP-agenter och arbetsflöden som kommunicerar och samarbetar oavsett ramverk.

Anmäl dig här:

88,22K

Vi presenterar "Bygga med lama 4". Den här korta kursen är skapad tillsammans med @Meta @AIatMeta och leds av @asangani7, Director of Partner Engineering för Metas AI-team.

Metas nya Llama 4 har lagt till tre nya modeller och introducerat MoE-arkitekturen (Mixture-of-Experts) till sin familj av modeller med öppen vikt, vilket gör dem mer effektiva att betjäna.

I den här kursen kommer du att arbeta med två av de tre nya modellerna som introducerades i Llama 4. Först ut är Maverick, en 400B parametermodell, med 128 experter och 17B aktiva parametrar. Den andra är Scout, en 109B parametermodell med 16 experter och 17B aktiva parametrar. Maverick och Scout stöder långa kontextfönster på upp till en miljon token respektive 10 miljoner token. Det senare räcker för att stödja direkt inmatning av även ganska stora GitHub-repos för analys!

I praktiska lektioner kommer du att bygga appar med hjälp av Llama 4:s nya multimodala funktioner, inklusive resonemang över flera bilder och bildjordning, där du kan identifiera element i bilder. Du kommer också att använda det officiella Llama API, arbeta med Llama 4:s långkontextförmågor och lära dig om Lamas senaste verktyg med öppen källkod: dess promptoptimeringsverktyg som automatiskt förbättrar systemuppmaningar och syntetiskt datakit som genererar högkvalitativa datauppsättningar för finjustering.

Om du behöver en öppen modell är Llama ett bra alternativ, och Llama 4-familjen är en viktig del av alla GenAI-utvecklares verktygslåda. Genom den här kursen lär du dig att anropa Llama 4 via API, använda dess optimeringsverktyg och bygga funktioner som sträcker sig över text, bilder och stort sammanhang.

Anmäl dig här:

57,42K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda