Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrew Ng

Mitbegründer von Coursera; Stanford CS Lehrbeauftragte. Ehemaliger Chef der Baidu AI Group/Google Brain. #ai #machinelearning, #deeplearning #MOOCs

Ich freue mich, den endgültigen Kurs zu Claude Code anzukündigen, der in Zusammenarbeit mit @AnthropicAI erstellt und von Elie Schoppik @eschoppik unterrichtet wird. Wenn Sie hochgradig agentisches Codieren verwenden möchten - bei dem KI autonom für viele Minuten oder länger arbeitet und nicht nur Code-Snippets vervollständigt - dann ist dies der Kurs für Sie.

Claude Code war ein Wendepunkt für viele Entwickler (mich eingeschlossen!), aber es gibt eine echte Tiefe, um es gut zu nutzen. Dieser umfassende Kurs deckt alles von den Grundlagen bis zu fortgeschrittenen Mustern ab.

Nach diesem kurzen Kurs werden Sie in der Lage sein:

- Mehrere Claude-Subagenten zu orchestrieren, die gleichzeitig an verschiedenen Teilen Ihres Codebases arbeiten

- Claude in GitHub-Issues zu taggen und es autonom Pull-Requests erstellen, überprüfen und zusammenführen zu lassen

- Unordentliche Jupyter-Notebooks in saubere, produktionsbereite Dashboards zu verwandeln

- MCP-Tools wie Playwright zu verwenden, damit Claude sieht, was mit Ihrer UI nicht stimmt, und es autonom beheben kann

Egal, ob Sie neu bei Claude Code sind oder es bereits verwenden, Sie werden leistungsstarke Fähigkeiten entdecken, die grundlegend verändern können, wie Sie Software entwickeln.

Ich bin sehr aufgeregt über das, was agentisches Codieren jetzt jedem ermöglicht. Bitte nehmen Sie an diesem Kurs teil!

679,42K

Ankündigung eines neuen Coursera-Kurses: Retrieval Augmented Generation (RAG)

Sie werden lernen, leistungsstarke, produktionsbereite RAG-Systeme in diesem praktischen, tiefgehenden Kurs zu erstellen, der von @ZainHasan6, einem erfahrenen KI- und ML-Ingenieur, Forscher und Pädagogen, erstellt und unterrichtet wird.

RAG ist heute ein kritischer Bestandteil vieler LLM-basierter Anwendungen im Kundenservice, internen Unternehmens-Q&A-Systemen und sogar vieler führender Chatbots, die Websuche nutzen, um Ihre Fragen zu beantworten. Dieser Kurs lehrt Sie im Detail, wie Sie RAG effektiv einsetzen können.

LLMs können generische oder veraltete Antworten produzieren, insbesondere wenn sie auf spezialisierte Fragen gestellt werden, die nicht in ihren Trainingsdaten abgedeckt sind. RAG ist die am weitesten verbreitete Technik zur Behebung dieses Problems. Es bezieht Daten aus neuen Datenquellen, wie internen Dokumenten oder aktuellen Nachrichten, um dem LLM den relevanten Kontext für private, aktuelle oder spezialisierte Informationen zu geben. Dadurch kann es fundiertere und genauere Antworten generieren.

In diesem Kurs lernen Sie, jeden Teil eines RAG-Systems zu entwerfen und zu implementieren, von Retrievern über Vektordatenbanken bis hin zu Generierung und Auswertungen. Sie werden die grundlegenden Prinzipien hinter RAG kennenlernen und wie man es sowohl auf Komponenten- als auch auf Systemebene optimiert.

Während sich KI weiterentwickelt, entwickelt sich auch RAG weiter. Neue Modelle können längere Kontextfenster verarbeiten, effektiver argumentieren und Teil komplexer agentischer Workflows sein. Ein spannendes Wachstumsfeld ist Agentic RAG, bei dem ein KI-Agent zur Laufzeit (anstatt dass es zur Entwicklungszeit fest codiert wird) autonom entscheidet, welche Daten abgerufen werden sollen und wann/wie tiefer eingetaucht werden soll. Selbst mit dieser Evolution ist der Zugang zu hochwertigen Daten zur Laufzeit entscheidend, weshalb RAG ein Schlüsselbestandteil so vieler Anwendungen ist.

Sie werden durch praktische Erfahrungen lernen:

- Ein RAG-System mit Retrieval- und Prompt-Augen zu erstellen

- Retrieval-Methoden wie BM25, semantische Suche und Reciprocal Rank Fusion zu vergleichen

- Dokumente mit einer Weaviate-Vektordatenbank und einem Nachrichten-Datensatz zu chunkieren, zu indizieren und abzurufen

- Einen Chatbot zu entwickeln, der open-source LLMs nutzt, die von Together AI gehostet werden, für einen fiktiven Laden, der Produkt- und FAQ-Fragen beantwortet

- Evals zu verwenden, um die Zuverlässigkeit zu verbessern und multimodale Daten zu integrieren

RAG ist eine wichtige grundlegende Technik. Werden Sie darin gut durch diesen Kurs!

Bitte melden Sie sich hier an:

107,02K

Mein Vortrag an der YC Startup School darüber, wie man KI-Startups aufbaut. Ich teile Tipps von @AI_Fund, wie man KI nutzen kann, um schnell zu bauen. Lass mich wissen, was du denkst!

Y Combinator10. Juli 2025

Andrew Ng (@AndrewYNg) darüber, wie Startups schneller mit KI arbeiten können.

Bei der AI Startup School in San Francisco.

00:31 - Die Bedeutung von Geschwindigkeit in Startups

01:13 - Chancen im KI-Stack

02:06 - Der Aufstieg von Agent KI

04:52 - Konkrete Ideen für schnellere Ausführung

08:56 - Schnelles Prototyping und Engineering

17:06 - Die Rolle des Produktmanagements

21:23 - Der Wert des Verständnisses von KI

22:33 - Technische Entscheidungen in der KI-Entwicklung

23:26 - Nutzung von Gen KI-Tools für Startups

24:05 - Bauen mit KI-Bausteinen

25:26 - Die Bedeutung von Geschwindigkeit in Startups

26:41 - Umgang mit KI-Hype und Missverständnissen

37:35 - KI in der Bildung: Aktuelle Trends und zukünftige Richtungen

39:33 - Balance zwischen KI-Innovation und ethischen Überlegungen

41:27 - Schutz von Open Source und die Zukunft der KI

146,5K

Die Agentic-Dokumentenextraktion unterstützt jetzt die Feldextraktion! Viele Anwendungsfälle der Dokumentenextraktion extrahieren spezifische Felder aus Formularen und anderen strukturierten Dokumenten. Sie können jetzt ein Bild oder PDF einer Rechnung eingeben, den Namen des Anbieters, die Artikelliste und die Preise anfordern und die extrahierten Felder zurückerhalten. Oder geben Sie ein medizinisches Formular ein und spezifizieren Sie ein Schema, um den Namen des Patienten, die Patienten-ID, die Versicherungsnummer usw. zu extrahieren.

Ein cooles Feature: Wenn Sie keine Lust haben, ein Schema (JSON-Spezifikation der zu extrahierenden Felder) selbst zu schreiben, laden Sie ein Musterdokument hoch und schreiben Sie eine natürliche Sprachaufforderung, was Sie möchten, und wir generieren automatisch ein Schema für Sie.

Sehen Sie sich das Video für weitere Details an!

178,27K

Neuer Kurs: Nachtraining von LLMs

Lernen Sie, ein LLM in diesem kurzen Kurs nachzutrainieren und anzupassen, unterrichtet von @BanghuaZ, Assistenzprofessor an der University of Washington @UW und Mitbegründer von @NexusflowX.

Das Training eines LLM, um Anweisungen zu befolgen oder Fragen zu beantworten, hat zwei wichtige Phasen: Vortraining und Nachtraining. Im Vortraining lernt es, das nächste Wort oder Token aus großen Mengen unbeschrifteten Textes vorherzusagen. Im Nachtraining lernt es nützliche Verhaltensweisen wie das Befolgen von Anweisungen, die Nutzung von Werkzeugen und das logische Denken.

Das Nachtraining verwandelt einen allgemeinen Token-Prädiktor – der auf Billionen unbeschrifteter Text-Token trainiert wurde – in einen Assistenten, der Anweisungen befolgt und spezifische Aufgaben ausführt. Da es viel günstiger ist als das Vortraining, ist es für viele Teams praktischer, Nachtraining-Methoden in ihre Arbeitsabläufe zu integrieren als Vortraining.

In diesem Kurs lernen Sie drei gängige Nachtraining-Methoden – Supervised Fine-Tuning (SFT), Direct Preference Optimization (DPO) und Online Reinforcement Learning (RL) – und wie Sie jede davon effektiv nutzen können. Mit SFT trainieren Sie das Modell mit Paaren von Eingaben und idealen Ausgaben. Mit DPO geben Sie sowohl eine bevorzugte (gewählte) als auch eine weniger bevorzugte (abgelehnte) Antwort an und trainieren das Modell, um die bevorzugte Ausgabe zu begünstigen. Mit RL generiert das Modell eine Ausgabe, erhält eine Belohnungsbewertung basierend auf menschlichem oder automatisiertem Feedback und aktualisiert das Modell, um die Leistung zu verbessern.

Sie lernen die grundlegenden Konzepte, gängige Anwendungsfälle und Prinzipien zur Kuratierung hochwertiger Daten für effektives Training. Durch praktische Labore laden Sie ein vortrainiertes Modell von Hugging Face herunter und trainieren es nach, indem Sie SFT, DPO und RL verwenden, um zu sehen, wie jede Technik das Verhalten des Modells beeinflusst.

Im Detail werden Sie:

- Verstehen, was Nachtraining ist, wann man es anwendet und wie es sich vom Vortraining unterscheidet.

- Eine SFT-Pipeline aufbauen, um ein Basis-Modell in ein Anweisungs-Modell zu verwandeln.

- Erkunden, wie DPO das Verhalten umgestaltet, indem es den kontrastiven Verlust minimiert – schlechte Antworten bestraft und bevorzugte verstärkt.

- Eine DPO-Pipeline implementieren, um die Identität eines Chat-Assistenten zu ändern.

- Online-RL-Methoden wie Proximal Policy Optimization (PPO) und Group Relative Policy Optimization (GRPO) lernen und wie man Belohnungsfunktionen entwirft.

- Ein Modell mit GRPO trainieren, um seine mathematischen Fähigkeiten mit einer überprüfbaren Belohnung zu verbessern.

Das Nachtraining ist eines der am schnellsten wachsenden Bereiche des LLM-Trainings. Egal, ob Sie einen hochgenauen kontextspezifischen Assistenten erstellen, den Ton eines Modells anpassen oder die aufgabenspezifische Genauigkeit verbessern, dieser Kurs gibt Ihnen Erfahrung mit den wichtigsten Techniken, die die Art und Weise prägen, wie LLMs heute nachtrainiert werden.

Bitte melden Sie sich hier an:

109,53K

Ich möchte einen Tipp teilen, um mehr Erfahrung im Umgang mit KI zu sammeln – das heißt, entweder KI-Bausteine zu verwenden, um Anwendungen zu erstellen, oder KI-Coding-Hilfen zu nutzen, um schnell leistungsstarke Anwendungen zu erstellen: Wenn Sie nur begrenzt Zeit zum Bauen haben, reduzieren Sie den Umfang Ihres Projekts, bis Sie etwas erstellen können, in der Zeit, die Ihnen zur Verfügung steht.

Wenn Sie nur eine Stunde haben, finden Sie einen kleinen Bestandteil einer Idee, die Sie begeistert, und die Sie in einer Stunde umsetzen können. Mit modernen Coding-Assistenten wie Anthropic’s Claude Code (mein derzeitiges Lieblings-Entwicklungstool) könnten Sie überrascht sein, wie viel Sie selbst in kurzen Zeiträumen erreichen können! Das bringt Sie in Gang, und Sie können das Projekt später immer fortsetzen.

Um gut im Umgang mit KI zu werden, müssen die meisten Menschen (i) relevante Techniken lernen, zum Beispiel durch Online-Kurse zur KI, und (ii) praktische Erfahrungen im Bauen sammeln. Ich kenne Entwickler, die monatelang über Ideen nachdenken, ohne tatsächlich etwas zu bauen – ich habe das auch getan! – weil wir das Gefühl haben, keine Zeit zu haben, um zu beginnen. Wenn Sie sich in dieser Position befinden, ermutige ich Sie, den ursprünglichen Projektumfang weiter zu reduzieren, bis Sie einen kleinen Bestandteil identifizieren, den Sie sofort umsetzen können.

Lassen Sie mich das mit einem Beispiel veranschaulichen – eines meiner vielen kleinen, lustigen Wochenendprojekte, das vielleicht nie irgendwohin führt, aber auf das ich froh bin, dass ich es gemacht habe.

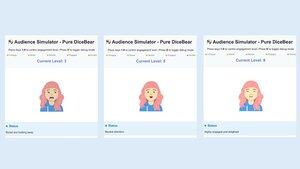

Hier ist die Idee: Viele Menschen haben Angst vor dem öffentlichen Sprechen. Und öffentliches Sprechen ist schwierig zu üben, weil es schwer ist, ein Publikum zu organisieren. Daher dachte ich, es wäre interessant, einen Publikumsimulator zu bauen, um ein digitales Publikum von Dutzenden bis Hunderten von virtuellen Personen auf einem Computerbildschirm bereitzustellen und es einem Benutzer zu ermöglichen, zu ihnen zu sprechen.

An einem Samstagnachmittag fand ich mich in einem Café mit ein paar Stunden Zeit wieder und beschloss, dem Publikumsimulator eine Chance zu geben. Meine Vertrautheit mit Grafik-Coding ist begrenzt, also entschied ich mich, den Umfang erheblich zu reduzieren, um (a) ein Publikum von einer Person zu simulieren (was ich später replizieren könnte, um N Personen zu simulieren), (b) KI wegzulassen und einen menschlichen Operator manuell die Reaktion des simulierten Publikums auswählen zu lassen (ähnlich wie beim Wizard of Oz-Prototyping) und (c) die Grafiken mit einem einfachen 2D-Avatar zu implementieren.

Mit einer Mischung aus mehreren Coding-Assistenten baute ich eine grundlegende Version in der Zeit, die ich hatte. Der Avatar konnte subtil bewegen und blinzeln, aber ansonsten verwendete er grundlegende Grafiken. Auch wenn es weit hinter einem ausgeklügelten Publikumsimulator zurückblieb, bin ich froh, dass ich das gebaut habe. Neben dem Vorantreiben des Projekts und der Erkundung verschiedener Designs hat es mein Wissen über grundlegende Grafiken erweitert. Darüber hinaus half mir dieser grobe Prototyp, den ich Freunden zeigen konnte, um Benutzerfeedback zu erhalten, das meine Ansichten zur Produktidee prägte.

Ich habe auf meinem Laptop eine Liste von Ideen, von Dingen, die ich interessant fände, zu bauen. Die meisten von ihnen würden viel länger dauern als die wenigen Stunden, die ich an einem bestimmten Tag habe, um etwas auszuprobieren, aber indem ich ihren Umfang reduziere, kann ich loslegen, und der anfängliche Fortschritt bei einem Projekt hilft mir zu entscheiden, ob es eine weitere Investition wert ist. Als Bonus hilft mir das Hacken an einer Vielzahl von Anwendungen, eine breite Palette von Fähigkeiten zu üben. Aber am wichtigsten ist, dass dies eine Idee aus meinem Kopf bringt und potenziell vor potenziellen Benutzern für Feedback präsentiert, das das Projekt schneller voranbringt.

295,52K

Neuer Kurs: ACP: Agentenkommunikationsprotokoll

Lernen Sie, Agenten zu erstellen, die über verschiedene Frameworks hinweg kommunizieren und zusammenarbeiten, indem Sie ACP in diesem kurzen Kurs erlernen, der mit @IBMResearch's BeeAI erstellt wurde und von @sandi_besen, AI Research Engineer & Ecosystem Lead bei IBM, und @nicholasrenotte, Head of AI Developer Advocacy bei IBM, unterrichtet wird.

Der Aufbau eines Multi-Agenten-Systems mit Agenten, die von verschiedenen Teams und Organisationen erstellt oder verwendet werden, kann herausfordernd sein. Möglicherweise müssen Sie jedes Mal benutzerdefinierte Integrationen schreiben, wenn ein Team sein Agentendesign aktualisiert oder seine Wahl des agentischen Orchestrierungsframeworks ändert.

Das Agentenkommunikationsprotokoll (ACP) ist ein offenes Protokoll, das diese Herausforderung angeht, indem es standardisiert, wie Agenten kommunizieren, und eine einheitliche RESTful-Schnittstelle verwendet, die über Frameworks hinweg funktioniert. In diesem Protokoll hosten Sie einen Agenten innerhalb eines ACP-Servers, der Anfragen von einem ACP-Client bearbeitet und sie an den entsprechenden Agenten weiterleitet. Die Verwendung einer standardisierten Client-Server-Schnittstelle ermöglicht es mehreren Teams, Agenten über Projekte hinweg wiederzuverwenden. Es erleichtert auch den Wechsel zwischen Frameworks, das Ersetzen eines Agenten durch eine neue Version oder das Aktualisieren eines Multi-Agenten-Systems, ohne das gesamte System umgestalten zu müssen.

In diesem Kurs lernen Sie, Agenten über ACP zu verbinden. Sie werden den Lebenszyklus eines ACP-Agenten verstehen und wie er sich mit anderen Protokollen, wie MCP (Model Context Protocol) und A2A (Agent-to-Agent), vergleicht. Sie werden ACP-konforme Agenten erstellen und sowohl sequenzielle als auch hierarchische Workflows von mehreren Agenten implementieren, die mithilfe von ACP zusammenarbeiten.

Durch praktische Übungen werden Sie:

- Einen RAG-Agenten mit CrewAI erstellen und ihn in einen ACP-Server einfügen.

- Einen ACP-Client erstellen, um Anfragen an den von Ihnen erstellten ACP-Server zu stellen.

- Einen sequenziellen Workflow erstellen, der einen ACP-Server, erstellt mit Smolagents, mit dem RAG-Agenten verknüpft.

- Einen hierarchischen Workflow mit einem Router-Agenten erstellen, der Benutzeranfragen in Aufgaben umwandelt, die an über ACP-Server verfügbare Agenten delegiert werden.

- Einen Agenten erstellen, der MCP verwendet, um auf Tools zuzugreifen, und ACP, um mit anderen Agenten zu kommunizieren.

Am Ende werden Sie Ihre ACP-Agenten in die BeeAI-Plattform importieren, ein Open-Source-Register zum Entdecken und Teilen von Agenten.

ACP ermöglicht die Zusammenarbeit zwischen Agenten über Teams und Organisationen hinweg. Am Ende dieses Kurses werden Sie in der Lage sein, ACP-Agenten und Workflows zu erstellen, die unabhängig vom Framework kommunizieren und zusammenarbeiten.

Bitte melden Sie sich hier an:

88,23K

Einführung in "Building with Llama 4." Dieser kurze Kurs wurde in Zusammenarbeit mit @Meta @AIatMeta erstellt und wird von @asangani7, dem Direktor für Partnertechnik des AI-Teams von Meta, gelehrt.

Metas neues Llama 4 hat drei neue Modelle hinzugefügt und die Mixture-of-Experts (MoE) Architektur in seine Familie von offenen Modellen eingeführt, was sie effizienter macht.

In diesem Kurs werden Sie mit zwei der drei neuen Modelle arbeiten, die in Llama 4 eingeführt wurden. Zuerst ist da Maverick, ein Modell mit 400B Parametern, 128 Experten und 17B aktiven Parametern. Zweitens ist Scout, ein Modell mit 109B Parametern, 16 Experten und 17B aktiven Parametern. Maverick und Scout unterstützen lange Kontextfenster von bis zu einer Million Tokens bzw. 10M Tokens. Letzteres reicht aus, um sogar recht große GitHub-Repos direkt zur Analyse einzugeben!

In praktischen Lektionen werden Sie Apps mit den neuen multimodalen Fähigkeiten von Llama 4 erstellen, einschließlich des Denkens über mehrere Bilder hinweg und der Bildverankerung, bei der Sie Elemente in Bildern identifizieren können. Sie werden auch die offizielle Llama-API verwenden, mit den langen Kontextfähigkeiten von Llama 4 arbeiten und mehr über Llamas neueste Open-Source-Tools erfahren: sein Tool zur Optimierung von Eingabeaufforderungen, das automatisch Systemaufforderungen verbessert, und das Kit für synthetische Daten, das hochwertige Datensätze für das Fine-Tuning generiert.

Wenn Sie ein offenes Modell benötigen, ist Llama eine großartige Option, und die Llama 4-Familie ist ein wichtiger Bestandteil des Werkzeugkastens eines jeden GenAI-Entwicklers. Durch diesen Kurs lernen Sie, Llama 4 über die API aufzurufen, seine Optimierungstools zu verwenden und Funktionen zu erstellen, die Text, Bilder und großen Kontext umfassen.

Bitte melden Sie sich hier an:

57,43K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten