Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrew Ng

Co-fondator al Coursera; Facultate adjunctă CS Stanford. Fost șef al Baidu AI Group/Google Brain. #ai #machinelearning, #deeplearning #MOOCs

Sunt încântat să anunț cursul definitiv despre Claude Code, creat cu @AnthropicAI și predat de Elie Schoppik @eschoppik. Dacă doriți să utilizați codificarea extrem de agentică - în care AI funcționează autonom timp de mai multe minute sau mai mult, nu doar completând fragmente de cod - acesta este.

Claude Code a schimbat jocul pentru mulți dezvoltatori (inclusiv pentru mine!), dar există o profunzime reală în a-l folosi bine. Acest curs cuprinzător acoperă totul, de la fundamente la modele avansate.

După acest scurt curs, veți putea:

- Orchestrați mai mulți subagenți Claude pentru a lucra simultan pe diferite părți ale bazei de cod

- Etichetați Claude în problemele GitHub și faceți-l să creeze, să revizuiască și să îmbine în mod autonom solicitările de extragere

- Transformați notebook-urile Jupyter dezordonate în tablouri de bord curate, gata de producție

- Utilizați instrumente MCP, cum ar fi Playwright, astfel încât Claude să poată vedea ce este în neregulă cu interfața de utilizare și să o remedieze în mod autonom

Indiferent dacă sunteți nou în Claude Code sau îl utilizați deja, veți descoperi capabilități puternice care pot schimba fundamental modul în care construiți software.

Sunt foarte încântat de ceea ce codul agentic permite tuturor să facă acum. Vă rugăm să urmați acest curs!

679,41K

Anunțarea unui nou curs Coursera: Retrieval Augmented Generation (RAG)

Veți învăța să construiți sisteme RAG de înaltă performanță, gata de producție, în acest curs practic și aprofundat creat și predat de @ZainHasan6 inginer, cercetător și educator cu experiență în AI și ML.

RAG este o componentă critică astăzi a multor aplicații bazate pe LLM în asistența pentru clienți, sistemele interne de întrebări și răspunsuri ale companiei, chiar și multe dintre cele mai importante chatbot-uri care folosesc căutarea web pentru a vă răspunde la întrebări. Acest curs vă învață în profunzime cum să faceți RAG să funcționeze bine.

LLM-urile pot produce răspunsuri generice sau învechite, mai ales atunci când li se pun întrebări specializate care nu sunt acoperite în datele sale de antrenament. RAG este cea mai utilizată tehnică pentru a aborda acest lucru. Aduce date din noi surse de date, cum ar fi documente interne sau știri recente, pentru a oferi LLM contextul relevant pentru informații private, recente sau specializate. Acest lucru îi permite să genereze răspunsuri mai împământate și mai precise.

În acest curs, veți învăța să proiectați și să implementați fiecare parte a unui sistem RAG, de la retrievere la baze de date vectoriale de la generare la evaluări. Veți învăța despre principiile fundamentale din spatele RAG și despre cum să-l optimizați atât la nivel de componentă, cât și la nivelul întregului sistem.

Pe măsură ce AI evoluează, RAG evoluează și el. Noile modele pot gestiona ferestre de context mai lungi, raționează mai eficient și pot face parte din fluxuri de lucru agentice complexe. Un domeniu de creștere interesant este Agentic RAG, în care un agent AI la rulare (mai degrabă decât să fie codificat în timpul dezvoltării) decide în mod autonom ce date să recupereze și când/cum să meargă mai adânc. Chiar și cu această evoluție, accesul la date de înaltă calitate în timpul rulării este esențial, motiv pentru care RAG este o parte cheie a atâtor aplicații.

Veți învăța prin experiențe practice să:

- Construiți un sistem RAG cu recuperare și augmentare promptă

- Comparați metode de recuperare precum BM25, căutare semantică și fuziune reciprocă

- Fragmentați, indexați și recuperați documente folosind o bază de date vectorială Weaviate și un set de date de știri

- Dezvoltați un chatbot, folosind LLM-uri open-source găzduite de Together AI, pentru un magazin fictiv care răspunde la întrebări despre produse și întrebări frecvente

- Utilizați evaluările pentru a îmbunătăți fiabilitatea și pentru a încorpora date multimodale

RAG este o tehnică fundamentală importantă. Deveniți buni la asta prin acest curs!

Vă rugăm să vă înscrieți aici:

107,02K

Discursul meu la YC Startup School despre cum să construiești startup-uri AI. Împărtășesc sfaturi de la @AI_Fund despre cum să folosești AI pentru a construi rapid. Spuneți-mi ce părere aveți!

Y Combinator10 iul. 2025

Andrew Ng (@AndrewYNg) on how startups can build faster with AI.

At AI Startup School in San Francisco.

00:31 - The Importance of Speed in Startups

01:13 - Opportunities in the AI Stack

02:06 - The Rise of Agent AI

04:52 - Concrete Ideas for Faster Execution

08:56 - Rapid Prototyping and Engineering

17:06 - The Role of Product Management

21:23 - The Value of Understanding AI

22:33 - Technical Decisions in AI Development

23:26 - Leveraging Gen AI Tools for Startups

24:05 - Building with AI Building Blocks

25:26 - The Importance of Speed in Startups

26:41 - Addressing AI Hype and Misconceptions

37:35 - AI in Education: Current Trends and Future Directions

39:33 - Balancing AI Innovation with Ethical Considerations

41:27 - Protecting Open Source and the Future of AI

146,48K

Extracția documentelor agentice acceptă acum extragerea câmpurilor! Multe cazuri de utilizare a extragerii documentelor extrag câmpuri specifice din formulare și alte documente structurate. Acum puteți introduce o imagine sau un PDF al unei facturi, puteți solicita numele furnizorului, lista de articole și prețurile și puteți recupera câmpurile extrase. Sau introduceți un formular medical și specificați o schemă pentru a extrage numele pacientului, ID-ul pacientului, numărul de asigurare etc.

O caracteristică interesantă: Dacă nu aveți chef să scrieți singur o schemă (specificație json a câmpurilor de extras), încărcați un document eșantion și scrieți o solicitare în limbaj natural spunând ceea ce doriți, iar noi generăm automat o schemă pentru dvs.

Vezi videoclipul pentru detalii!

178,26K

Curs nou: Post-formare a LLM-urilor

Învățați să post-instruiți și să personalizați un LLM în acest curs scurt, predat de @BanghuaZ, profesor asistent la Universitatea din Washington @UW și co-fondator al @NexusflowX.

Instruirea unui LLM pentru a urma instrucțiuni sau a răspunde la întrebări are două etape cheie: pre-instruire și post-instruire. În pre-antrenament, învață să prezică următorul cuvânt sau token din cantități mari de text neetichetat. În post-instruire, învață comportamente utile, cum ar fi respectarea instrucțiunilor, utilizarea instrumentelor și raționamentul.

Post-instruirea transformă un predictor de jetoane de uz general - antrenat pe trilioane de jetoane de text neetichetate - într-un asistent care urmează instrucțiuni și îndeplinește sarcini specifice. Deoarece este mult mai ieftin decât pre-training, este practic pentru mult mai multe echipe să încorporeze metode post-training în fluxurile lor de lucru decât pre-training.

În acest curs, veți învăța trei metode comune post-instruire - Reglarea fină supravegheată (SFT), Optimizarea preferințelor directe (DPO) și Învățarea prin întărire online (RL) - și cum să le utilizați pe fiecare în mod eficient. Cu SFT, antrenați modelul pe perechi de răspunsuri de intrare și ieșire ideale. Cu DPO, oferiți atât un răspuns preferat (ales), cât și unul mai puțin preferat (respins) și antrenați modelul pentru a favoriza rezultatul preferat. Cu RL, modelul generează un rezultat, primește un scor de recompensă bazat pe feedback uman sau automat și actualizează modelul pentru a îmbunătăți performanța.

Veți învăța conceptele de bază, cazurile de utilizare comune și principiile pentru organizarea datelor de înaltă calitate pentru o instruire eficientă. Prin laboratoare practice, veți descărca un model pre-antrenat de la Hugging Face și îl veți antrena ulterior folosind SFT, DPO și RL pentru a vedea cum fiecare tehnică modelează comportamentul modelului.

În detaliu, voi:

- Înțelegeți ce este post-training, când să îl utilizați și cum diferă de pre-training.

- Construiți o conductă SFT pentru a transforma un model de bază într-un model instruct.

- Explorați modul în care DPO remodelează comportamentul prin minimizarea pierderilor contrastive - penalizând răspunsurile slabe și consolidându-le pe cele preferate.

- Implementați o conductă DPO pentru a schimba identitatea unui asistent de chat.

- Învățați metode RL online, cum ar fi Proximal Policy Optimization (PPO) și Group Relative Policy Optimization (GRPO) și cum să proiectați funcții de recompensă.

- Antrenați un model cu GRPO pentru a-i îmbunătăți capacitățile matematice folosind o recompensă verificabilă.

Post-formarea este unul dintre domeniile cu cea mai rapidă dezvoltare a formării LLM. Fie că construiți un asistent specific contextului de înaltă precizie, reglați fin tonul unui model sau îmbunătățiți precizia specifică sarcinii, acest curs vă va oferi experiență cu cele mai importante tehnici care modelează modul în care LLM-urile sunt post-antrenate astăzi.

Vă rugăm să vă înscrieți aici:

109,52K

Aș dori să împărtășesc un sfat pentru a exersa mai mult construcția cu AI - adică fie folosind blocuri de construcție AI pentru a construi aplicații, fie folosind asistență de codare AI pentru a crea rapid aplicații puternice: Dacă vă aflați cu timp limitat pentru a construi, reduceți domeniul de aplicare al proiectului până când puteți construi ceva în orice timp aveți.

Dacă aveți doar o oră, găsiți o mică componentă a unei idei de care sunteți entuziasmat și pe care o puteți construi într-o oră. Cu asistenți moderni de codare precum Claude Code de la Anthropic (instrumentul meu preferat de dezvoltare în acest moment), s-ar putea să fii surprins de cât de mult poți face chiar și în perioade scurte de timp! Acest lucru vă pune în mișcare și puteți continua oricând proiectul mai târziu.

Pentru a deveni buni la construirea cu inteligența artificială, majoritatea oamenilor trebuie (i) să învețe tehnici relevante, de exemplu urmând cursuri online de inteligență artificială și (ii) să exerseze construcția. Cunosc dezvoltatori care caută idei luni de zile fără să construiască nimic – am făcut și eu asta! – pentru că simțim că nu avem timp să începem. Dacă vă aflați în această poziție, vă încurajez să continuați să reduceți domeniul inițial al proiectului până când identificați o mică componentă pe care o puteți construi imediat.

Permiteți-mi să ilustrez cu un exemplu – unul dintre multele mele proiecte mici și distractive de weekend care s-ar putea să nu ajungă nicăieri, dar pe care mă bucur că l-am făcut.

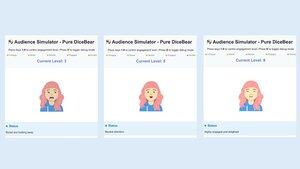

Iată ideea: mulți oameni se tem să vorbească în public. Iar vorbitul în public este dificil de exersat, pentru că este greu să organizezi o audiență. Așa că m-am gândit că ar fi interesant să construiesc un simulator de audiență pentru a oferi o audiență digitală de zeci până la sute de oameni virtuali pe un monitor de computer și să lase un utilizator să exerseze vorbind cu ei.

Într-o sâmbătă după-amiază, m-am trezit într-o cafenea cu câteva ore libere și am decis să încerc simulatorul de public. Familiaritatea mea cu codificarea grafică este limitată, așa că, în loc să construiesc un simulator complex al unei audiențe mari și să scriu software AI pentru a simula răspunsurile adecvate ale publicului, am decis să reduc semnificativ domeniul de aplicare pentru (a) simularea unei audiențe a unei persoane (pe care aș putea să o reproduc mai târziu pentru a simula N persoane), (b) omiterea AI și lăsarea unui operator uman să selecteze manual reacția publicului simulat (similar cu prototiparea Vrăjitorului din Oz), și (c) implementarea graficii folosind un simplu avatar 2D.

Folosind un amestec de mai mulți asistenți de codare, am construit o versiune de bază în timpul pe care îl aveam. Avatarul se putea mișca subtil și clipea, dar în rest folosea grafică de bază. Chiar dacă nu a fost un simulator sofisticat de audiență, mă bucur că l-am construit. Pe lângă faptul că a avansat proiectul și mi-a permis să explorez diferite modele, mi-a avansat cunoștințele de grafică de bază. Mai mult, având acest prototip rudimentar pe care să-l arăt prietenilor, m-a ajutat să obțin feedback de la utilizatori care mi-au modelat opiniile despre ideea produsului.

Am pe laptop o listă de idei despre lucruri care cred că ar fi interesant de construit. Cele mai multe dintre ele ar dura mult mai mult decât câteva ore pe care le-aș putea avea pentru a încerca ceva într-o anumită zi, dar reducând domeniul lor de aplicare, pot continua, iar progresul inițial al unui proiect mă ajută să decid dacă merită investiții suplimentare. Ca bonus, hacking-ul pe o mare varietate de aplicații mă ajută să exersez o gamă largă de abilități. Dar cel mai important, acest lucru îmi scoate o idee din cap și potențial în fața potențialilor utilizatori pentru feedback care să permită proiectului să se miște mai repede.

[Textul original: ]

295,51K

Curs nou: ACP: Protocol de comunicare a agentului

Învățați să construiți agenți care comunică și colaborează în diferite cadre folosind ACP în acest curs scurt construit cu BeeAI de la @IBMResearch și predat de @sandi_besen, AI Research Engineer și Ecosystem Lead la IBM și @nicholasrenotte, Head of AI Developer Advocacy la IBM.

Construirea unui sistem multi-agent cu agenți construiți sau utilizați de diferite echipe și organizații poate deveni o provocare. Poate fi necesar să scrieți integrări personalizate de fiecare dată când o echipă își actualizează designul agentului sau își schimbă alegerea cadrului de orchestrare agentică.

Protocolul de comunicare a agentului (ACP) este un protocol deschis care abordează această provocare prin standardizarea modului în care agenții comunică, folosind o interfață RESTful unificată care funcționează între cadre. În acest protocol, găzduiți un agent într-un server ACP, care gestionează cererile de la un client ACP și le transmite agentului corespunzător. Utilizarea unei interfețe client-server standardizate permite mai multor echipe să reutilizeze agenții în toate proiectele. De asemenea, facilitează comutarea între framework-uri, înlocuirea unui agent cu o versiune nouă sau actualizarea unui sistem multi-agent fără a refactoriza întregul sistem.

În acest curs, veți învăța să conectați agenții prin ACP. Veți înțelege ciclul de viață al unui agent ACP și cum se compară cu alte protocoale, cum ar fi MCP (Model Context Protocol) și A2A (Agent-to-Agent). Veți construi agenți compatibili cu ACP și veți implementa fluxuri de lucru secvențiale și ierarhice ale mai multor agenți care colaborează folosind ACP.

Prin exerciții practice, veți construi:

- Un agent RAG cu CrewAI și înfășurați-l într-un server ACP.

- Un client ACP pentru a efectua apeluri către serverul ACP pe care l-ați creat.

- Un flux de lucru secvențial care înlănțuie un server ACP, creat cu Smolagents, la agentul RAG.

- Un flux de lucru ierarhic care utilizează un agent de router care transformă interogările utilizatorilor în sarcini, delegate agenților disponibili prin serverele ACP.

- Un agent care utilizează MCP pentru a accesa instrumente și ACP pentru a comunica cu alți agenți.

Veți termina prin a importa agenții ACP în platforma BeeAI, un registru open-source pentru descoperirea și partajarea agenților.

ACP permite colaborarea între agenți între echipe și organizații. Până la sfârșitul acestui curs, veți putea construi agenți ACP și fluxuri de lucru care comunică și colaborează indiferent de cadru.

Vă rugăm să vă înscrieți aici:

88,22K

Vă prezentăm "Construind cu Llama 4". Acest curs scurt este creat cu @Meta @AIatMeta și predat de @asangani7, director de inginerie parteneră pentru echipa AI a Meta.

Noul Llama 4 de la Meta a adăugat trei noi modele și a introdus arhitectura Mixture-of-Experts (MoE) în familia sa de modele cu greutate deschisă, făcându-le mai eficiente de servit.

În acest curs, veți lucra cu două dintre cele trei modele noi introduse în Llama 4. Primul este Maverick, un model de parametri 400B, cu 128 de experți și 17B parametri activi. Al doilea este Scout, un model de 109B parametri cu 16 experți și 17B parametri activi. Maverick și Scout acceptă ferestre de context lungi de până la un milion de token-uri și, respectiv, 10 milioane de token-uri. Acesta din urmă este suficient pentru a accepta introducerea directă chiar și a depozitelor GitHub destul de mari pentru analiză!

În lecțiile practice, veți construi aplicații folosind noile capabilități multimodale ale Llama 4, inclusiv raționamentul pe mai multe imagini și împământarea imaginii, în care puteți identifica elemente din imagini. Veți utiliza, de asemenea, API-ul oficial Lama, veți lucra cu abilitățile de context lung ale Llama 4 și veți afla despre cele mai noi instrumente open-source ale Llama: instrumentul său de optimizare promptă care îmbunătățește automat solicitările de sistem și kitul de date sintetice care generează seturi de date de înaltă calitate pentru reglare fină.

Dacă aveți nevoie de un model deschis, Llama este o opțiune excelentă, iar familia Llama 4 este o parte importantă a setului de instrumente al oricărui dezvoltator GenAI. Prin acest curs, veți învăța să apelați Llama 4 prin API, să utilizați instrumentele sale de optimizare și să construiți funcții care acoperă text, imagini și context mare.

Vă rugăm să vă înscrieți aici:

57,42K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante